[pytorch笔记] 调整网络学习率

1. 为网络的不同部分指定不同的学习率

class LeNet(t.nn.Module):

def __init__(self):

super(LeNet, self).__init__()

self.features = t.nn.Sequential(

t.nn.Conv2d(3, 6, 5),

t.nn.ReLU(),

t.nn.MaxPool2d(2, 2),

t.nn.Conv2d(6, 16, 5),

t.nn.ReLU(),

t.nn.MaxPool2d(2, 2)

)

# 由于调整shape并不是一个class层,

# 所以在涉及这种操作(非nn.Module操作)需要拆分为多个模型

self.classifier = t.nn.Sequential(

t.nn.Linear(16*5*5, 120),

t.nn.ReLU(),

t.nn.Linear(120, 84),

t.nn.ReLU(),

t.nn.Linear(84, 10)

) def forward(self, x):

x = self.features(x)

x = x.view(-1, 16*5*5)

x = self.classifier(x)

return x

这里LeNet被拆解成features和classifier两个模型来实现。在训练时,可以为features和classifier分别指定不同的学习率。

model = LeNet()

optimizer = optim.SGD([{'params': model.features.parameters()},

{'params': model.classifier.parameters(), 'lr': 1e-2}

], lr = 1e-5)

对于{'params': model.classifier.parameters(), 'lr': 1e-2} 被指定了特殊的学习率 'lr': 1e-2,则按照该值优化。

对于{'params': model.features.parameters()} 没有特殊指定学习率,则使用 lr = 1e-5。

SGD的param_groups中保存着 'params', 'lr', 'momentum', 'dampening','weight_decay','nesterov'及对应值的字典。

在 CLASS torch.optim.Optimizer(params, defaults) 中,提供了 add_param_group(param_group) 函数,可以在optimizer中添加param group. 这在固定与训练网络模型部分,fine-tuning 训练层部分时很实用。

2. 动态调整网络模块的学习率

for p in optimizer.param_groups:

p['lr'] = rate()

如果需要动态设置学习率,可以以这种方式,将关于学习率的函数赋值给参数的['lr']属性。

还以以上定义的LeNet的optimizer为例,根据上面的定义,有两个param_groups, 一个是model.features.parameters(), 一个是{'params': model.classifier.parameters()。

那么在for的迭代中,可以分别为这两个param_group通过函数rate()实现动态赋予学习率的功能。

如果将optimizer定义为:

optimizer = optim.SGD(model.parameters(), lr = 0.001, momentum = 0.9)

那么param_groups中只有一个param group,也就是网络中各个模块共用同一个学习率。

3. 使用pytorch封装好的方法

https://pytorch.org/docs/stable/optim.html#how-to-adjust-learning-rate

torch.optim.lr_scheduler中提供了一些给予epochs的动态调整学习率的方法。

https://www.jianshu.com/p/a20d5a7ed6f3 这篇blog中绘制了一些学习率方法对应的图示。

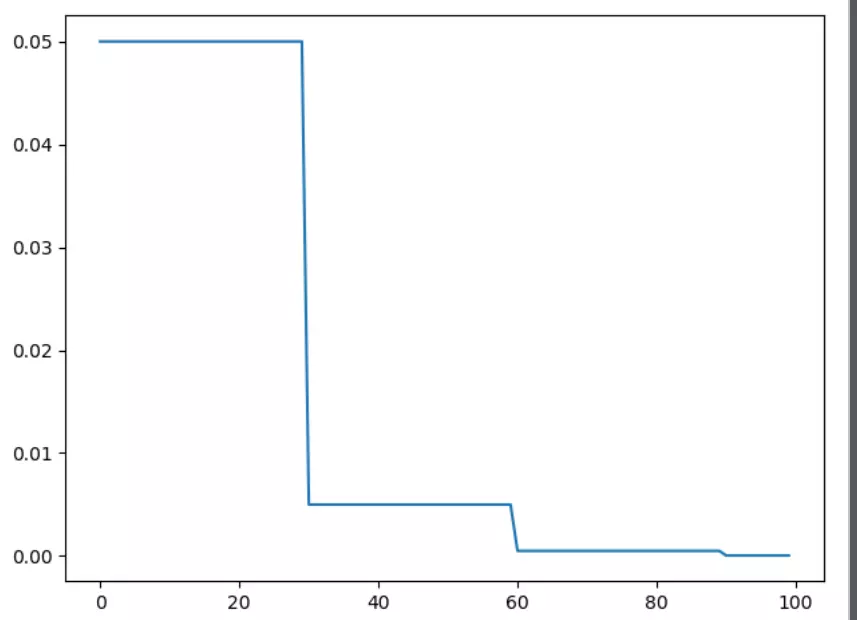

1)torch.optim.lr_scheduler.StepLR

import torch

import torch.optim as optim

from torch.optim import lr_scheduler

from torchvision.models import AlexNet

import matplotlib.pyplot as plt model = AlexNet(num_classes=2)

optimizer = optim.SGD(params=model.parameters(), lr=0.05) # lr_scheduler.StepLR()

# Assuming optimizer uses lr = 0.05 for all groups

# lr = 0.05 if epoch < 30

# lr = 0.005 if 30 <= epoch < 60

# lr = 0.0005 if 60 <= epoch < 90 scheduler = lr_scheduler.StepLR(optimizer, step_size=30, gamma=0.1)

plt.figure()

x = list(range(100))

y = []

for epoch in range(100):

scheduler.step()

lr = scheduler.get_lr()

print(epoch, scheduler.get_lr()[0])

y.append(scheduler.get_lr()[0]) plt.plot(x, y)

2)torch.optim.lr_scheduler.MultiStepLR

与StepLR相比,MultiStepLR可以设置指定的区间

# ---------------------------------------------------------------

# 可以指定区间

# lr_scheduler.MultiStepLR()

# Assuming optimizer uses lr = 0.05 for all groups

# lr = 0.05 if epoch < 30

# lr = 0.005 if 30 <= epoch < 80

# lr = 0.0005 if epoch >= 80

print()

plt.figure()

y.clear()

scheduler = lr_scheduler.MultiStepLR(optimizer, [30, 80], 0.1)

for epoch in range(100):

scheduler.step()

print(epoch, 'lr={:.6f}'.format(scheduler.get_lr()[0]))

y.append(scheduler.get_lr()[0]) plt.plot(x, y)

plt.show()

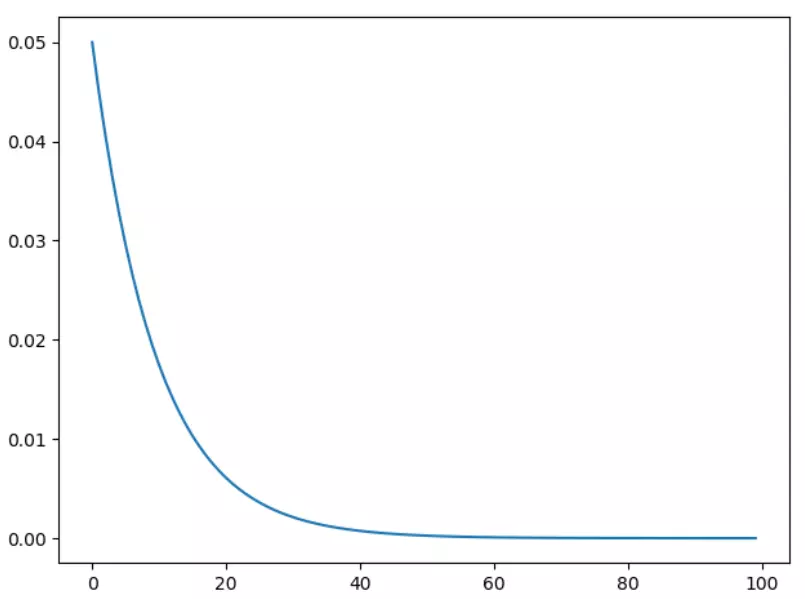

3)torch.optim.lr_scheduler.ExponentialLR

指数衰减

scheduler = lr_scheduler.ExponentialLR(optimizer, gamma=0.9)

print()

plt.figure()

y.clear()

for epoch in range(100):

scheduler.step()

print(epoch, 'lr={:.6f}'.format(scheduler.get_lr()[0]))

y.append(scheduler.get_lr()[0]) plt.plot(x, y)

plt.show()

[pytorch笔记] 调整网络学习率的更多相关文章

- [Pytorch] pytorch笔记 <三>

pytorch笔记 optimizer.zero_grad() 将梯度变为0,用于每个batch最开始,因为梯度在不同batch之间不是累加的,所以必须在每个batch开始的时候初始化累计梯度,重置为 ...

- [Pytorch] pytorch笔记 <一>

pytorch笔记 - torchvision.utils.make_grid torchvision.utils.make_grid torchvision.utils.make_grid(tens ...

- python3.4学习笔记(十七) 网络爬虫使用Beautifulsoup4抓取内容

python3.4学习笔记(十七) 网络爬虫使用Beautifulsoup4抓取内容 Beautiful Soup 是用Python写的一个HTML/XML的解析器,它可以很好的处理不规范标记并生成剖 ...

- python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息,抓取政府网新闻内容

python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息PySpider:一个国人编写的强大的网络爬虫系统并带有强大的WebUI,采用Python语言编写 ...

- MINIST深度学习识别:python全连接神经网络和pytorch LeNet CNN网络训练实现及比较(三)

版权声明:本文为博主原创文章,欢迎转载,并请注明出处.联系方式:460356155@qq.com 在前两篇文章MINIST深度学习识别:python全连接神经网络和pytorch LeNet CNN网 ...

- [Pytorch] pytorch笔记 <二>

pytorch笔记2 用到的关于plt的总结 plt.scatter scatter(x, y, s=None, c=None, marker=None, cmap=None, norm=None, ...

- 使用Iperf调整网络

使用Iperf调整网络 Iperf 是一个 TCP/IP 和 UDP/IP 的性能测量工具,通过调谐各种参数可以测试TCP的最大带宽,并报告带宽.延迟,最大段和最大传输单元大小等统计信息.Ip ...

- PyTorch对ResNet网络的实现解析

PyTorch对ResNet网络的实现解析 1.首先导入需要使用的包 import torch.nn as nn import torch.utils.model_zoo as model_zoo # ...

- pytorch空间变换网络

pytorch空间变换网络 本文将学习如何使用称为空间变换器网络的视觉注意机制来扩充网络.可以在DeepMind paper 阅读更多有关空间变换器网络的内容. 空间变换器网络是对任何空间变换的差异化 ...

随机推荐

- celery异步发送邮件

利用Django框架发送邮件的详细过程,在前两天的博客中有所记录,但是单纯的那样发邮件是有非常大的问题的,这就需要celery异步发送来解决 首先我们来看一下邮件发送的过程: Django网站先发送到 ...

- 2019中山纪念中学夏令营-Day4[JZOJ]

Begin (题目的排序方式:难易程度) 什么是对拍: 对拍是一种在写完程序后,验证自己程序是不是正解的比较方便的方法. 实现过程: 对同一道题,再打一个暴力程序,然后用一些大数据等跑暴力程序来进行验 ...

- spark教程(九)-操作数据库

数据库也是 spark 数据源创建 df 的一种方式,因为比较重要,所以单独算一节. 本文以 postgres 为例 安装 JDBC 首先需要 安装 postgres 的客户端驱动,即 JDBC 驱动 ...

- 福建工程学院第十四届ACM校赛J题题解

第六集,想不到你这个浓眉大眼的都叛变革命了 题意: 给你两个只包含01的字符串S和T,问你在允许一次错误的情况下,T是否能成为S的子串 思路: 这个问题的解法挺多,我是用fft匹配的,也比较简单,针对 ...

- oracle查看执行计划以及使用场景

文档结构: oracle执行计划使用场景 环境: Centos 6.10 Oracle 18.3.0.0.0 c 11g默认启动了自动统计信息收集的任务,默认运行时间是周一到周五晚上10点和周6,周天 ...

- Global.asax文件

转载:http://www.cnblogs.com/I-am-Betty/archive/2010/09/06/1819558.html 概述: Global.asax文件也叫做asp.net应用程序 ...

- JS图片轮播[左右轮播

直接可以用,网上摘下来的! <!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http ...

- selenium自动化测试工具模拟登陆爬取当当网top500畅销书单

selenium自动化测试工具可谓是爬虫的利器,基本动态加载的网页都能抓取,当然随着大型网站的更新,也出现针对selenium的反爬,有些网站可以识别你是否用的是selenium访问,然后对你加以限制 ...

- VS 2005 \ 2008 "当前不会命中断点。源代码与原始版本不同"解决方法

全选CPP文件内容, 选择 “编辑”-“高级”-“设置选定内容的格式”,保存,重新编译! 快捷键 ctrl + A 全选文件内容后 按 ctrl + K ,F OK!

- java实现spark常用算子之frist

import org.apache.spark.SparkConf;import org.apache.spark.api.java.JavaRDD;import org.apache.spark.a ...