[机器学习笔记]主成分分析PCA简介及其python实现

主成分分析(principal component analysis)是一种常见的数据降维方法,其目的是在“信息”损失较小的前提下,将高维的数据转换到低维,从而减小计算量。

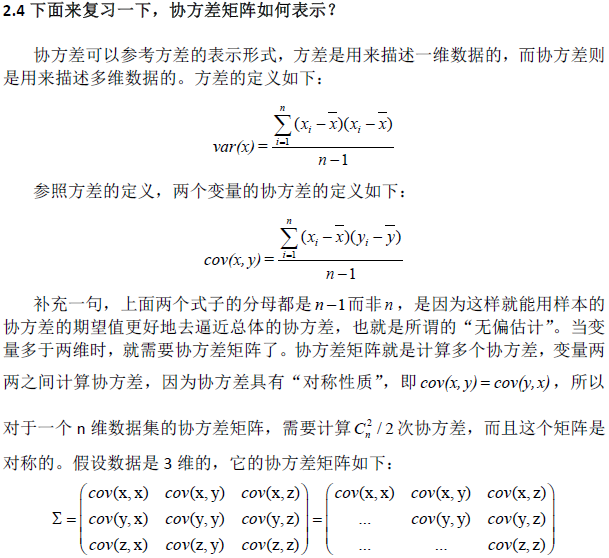

PCA的本质就是找一些投影方向,使得数据在这些投影方向上的方差最大,而且这些投影方向是相互正交的。这其实就是找新的正交基的过程,计算原始数据在这些正交基上投影的方差,方差越大,就说明在对应正交基上包含了更多的信息量。后面会证明,原始数据协方差矩阵的特征值越大,对应的方差越大,在对应的特征向量上投影的信息量就越大。反之,如果特征值较小,则说明数据在这些特征向量上投影的信息量很小,可以将小特征值对应方向的数据删除,从而达到了降维的目的。

PCA的全部工作简单点说,就是对原始的空间中顺序地找一组相互正交的坐标轴,第一个轴是使得方差最大的,第二个轴是在与第一个轴正交的平面中使得方差最大的,第三个轴是在与第1、2个轴正交的平面中方差最大的,这样假设在N维空间中,我们可以找到N个这样的坐标轴,我们取前r个去近似这个空间,这样就从一个N维的空间压缩到r维的空间了,但是我们选择的r个坐标轴能够使得空间的压缩使得数据的损失最小。

因此,关键点就在于:如何找到新的投影方向使得原始数据的“信息量”损失最少?

1.样本“信息量”的衡量

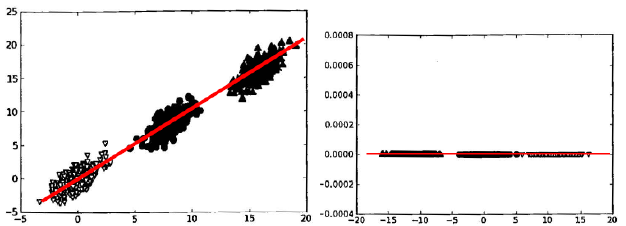

样本的“信息量”指的是样本在特征方向上投影的方差。方差越大,则样本在该特征上的差异就越大,因此该特征就越重要。以《机器学习实战》上的图说明,在分类问题里,样本的方差越大,越容易将不同类别的样本区分开。

图中共有3个类别的数据,很显然,方差越大,越容易分开不同类别的点。样本在X轴上的投影方差较大,在Y轴的投影方差较小。方差最大的方向应该是中间斜向上的方向(图中红线方向)。如果将样本按照中间斜向上的方向进行映射,则只要一维的数据就可以对其进行分类,相比二维的原数据,就相当降了一维。

在原始数据更多维的情况下,先得到一个数据变换后方差最大的方向,然后选择与第一个方向正交的方向,该方向是方差次大的方向,如此下去,直到变换出与原特征个数相同的新特征或者变换出前N个特征(在这前N个特征包含了数据的绝大部分信息),简而言之,PCA是一个降维的过程,将数据映射到新的特征,新特征是原始特征的线性组合。

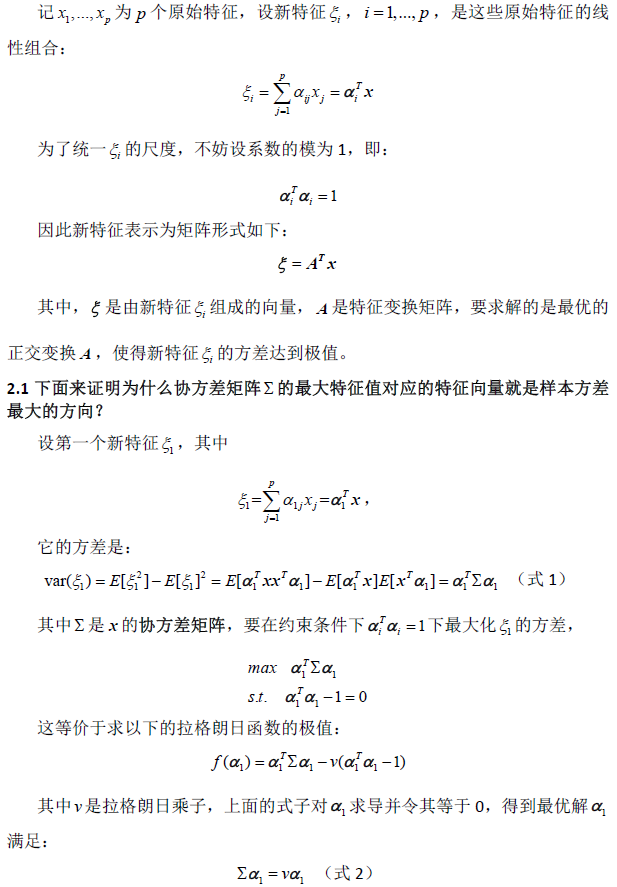

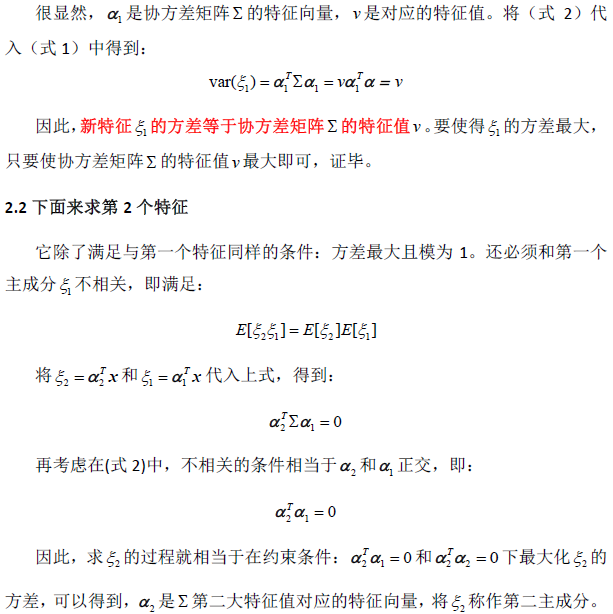

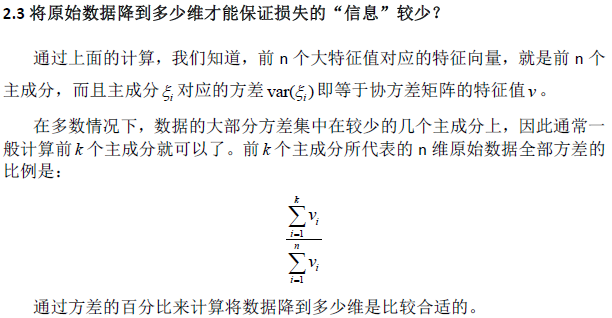

2.计算过程(因为插入公式比较麻烦,就直接采用截图的方式)

3.python实现

#coding=utf-8

from numpy import * '''通过方差的百分比来计算将数据降到多少维是比较合适的,

函数传入的参数是特征值和百分比percentage,返回需要降到的维度数num'''

def eigValPct(eigVals,percentage):

sortArray=sort(eigVals) #使用numpy中的sort()对特征值按照从小到大排序

sortArray=sortArray[-1::-1] #特征值从大到小排序

arraySum=sum(sortArray) #数据全部的方差arraySum

tempSum=0

num=0

for i in sortArray:

tempSum+=i

num+=1

if tempsum>=arraySum*percentage:

return num '''pca函数有两个参数,其中dataMat是已经转换成矩阵matrix形式的数据集,列表示特征;

其中的percentage表示取前多少个特征需要达到的方差占比,默认为0.9'''

def pca(dataMat,percentage=0.9):

meanVals=mean(dataMat,axis=0) #对每一列求平均值,因为协方差的计算中需要减去均值

meanRemoved=dataMat-meanVals

covMat=cov(meanRemoved,rowvar=0) #cov()计算方差

eigVals,eigVects=linalg.eig(mat(covMat)) #利用numpy中寻找特征值和特征向量的模块linalg中的eig()方法

k=eigValPct(eigVals,percentage) #要达到方差的百分比percentage,需要前k个向量

eigValInd=argsort(eigVals) #对特征值eigVals从小到大排序

eigValInd=eigValInd[:-(k+1):-1] #从排好序的特征值,从后往前取k个,这样就实现了特征值的从大到小排列

redEigVects=eigVects[:,eigValInd] #返回排序后特征值对应的特征向量redEigVects(主成分)

lowDDataMat=meanRemoved*redEigVects #将原始数据投影到主成分上得到新的低维数据lowDDataMat

reconMat=(lowDDataMat*redEigVects.T)+meanVals #得到重构数据reconMat

return lowDDataMat,reconMat

Reference:

1. Peter Harrington,《机器学习实战》,人民邮电出版社,2013

2. http://www.cnblogs.com/jerrylead/archive/2011/04/18/2020209.html (其中有PCA的计算实例)

3. 张学工,《模式识别》(第三版),清华大学出版社,2010

[机器学习笔记]主成分分析PCA简介及其python实现的更多相关文章

- 机器学习之主成分分析PCA原理笔记

1. 相关背景 在许多领域的研究与应用中,通常需要对含有多个变量的数据进行观测,收集大量数据后进行分析寻找规律.多变量大数据集无疑会为研究和应用提供丰富的信息,但是也在一定程度上增加了数据采集的 ...

- 【机器学习】--主成分分析PCA降维从初识到应用

一.前述 主成分分析(Principal Component Analysis,PCA), 是一种统计方法.通过正交变换将一组可能存在相关性的变量转换为一组线性不相关的变量,转换后的这组变量叫主成分. ...

- [机器学习笔记]奇异值分解SVD简介及其在推荐系统中的简单应用

本文先从几何意义上对奇异值分解SVD进行简单介绍,然后分析了特征值分解与奇异值分解的区别与联系,最后用python实现将SVD应用于推荐系统. 1.SVD详解 SVD(singular value d ...

- 【机器学习】主成分分析PCA(Principal components analysis)

1. 问题 真实的训练数据总是存在各种各样的问题: 1. 比如拿到一个汽车的样本,里面既有以“千米/每小时”度量的最大速度特征,也有“英里/小时”的最大速度特征,显然这两个特征有一个多余. 2. 拿到 ...

- 机器学习入门-主成分分析(PCA)

主成分分析: 用途:降维中最常用的一种方法 目标:提取有用的信息(基于方差的大小) 存在的问题:降维后的数据将失去原本的数据意义 向量的内积:A*B = |A|*|B|*cos(a) 如果|B| = ...

- Python机器学习笔记:不得不了解的机器学习面试知识点(1)

机器学习岗位的面试中通常会对一些常见的机器学习算法和思想进行提问,在平时的学习过程中可能对算法的理论,注意点,区别会有一定的认识,但是这些知识可能不系统,在回答的时候未必能在短时间内答出自己的认识,因 ...

- Python机器学习笔记:奇异值分解(SVD)算法

完整代码及其数据,请移步小编的GitHub 传送门:请点击我 如果点击有误:https://github.com/LeBron-Jian/MachineLearningNote 奇异值分解(Singu ...

- Python机器学习笔记:sklearn库的学习

网上有很多关于sklearn的学习教程,大部分都是简单的讲清楚某一方面,其实最好的教程就是官方文档. 官方文档地址:https://scikit-learn.org/stable/ (可是官方文档非常 ...

- 机器学习1—简介及Python机器学习环境搭建

简介 前置声明:本专栏的所有文章皆为本人学习时所做笔记而整理成篇,转载需授权且需注明文章来源,禁止商业用途,仅供学习交流.(欢迎大家提供宝贵的意见,共同进步) 正文: 机器学习,顾名思义,就是研究计算 ...

随机推荐

- Muduo学习笔记(一) 什么都不做的EventLoop

Muduo学习笔记(一) 什么都不做的EventLoop EventLoop EventLoop的基本接口包括构造.析构.loop(). One Loop Per Thread 一个线程只有一个Eve ...

- webWorker

一.webWorker之初体验 在"setTimeout那些事儿"中,说到JavaScript是单线程.也就是同一时间只能做同一事情. 也好理解,作为浏览器脚本语言,如果JavaS ...

- 作业 20181204-4 互评Final版本

此作业要求参见:[https://edu.cnblogs.com/campus/nenu/2018fall/homework/2478] 组名:可以低头,但没必要 组长:付佳 组员:张俊余 李文涛 孙 ...

- Selenium WebDriver VS Selenium RC

WebDriver到底是什么? WebDriver是一个Web的自动化测试框架,它支持你执行你的测试用例在不同的浏览器上面,并不像Selenium一样只支持Firefox. WebDriv ...

- [转帖]Application Request Route实现IIS Server Farms集群负载详解

Application Request Route实现IIS Server Farms集群负载详解 https://www.cnblogs.com/knowledgesea/p/5099893.ht ...

- k8s kubectl edit 方式修改 nodeport 的端口

0. 买了一本 每天五分钟玩转 k8s 还有 刚才转帖的blog 里面有一个 kubectl edit 的语法能够在线更改端口号 ,之前一直没弄明白. 刚才做了下实验.发现很好用 这里记录一下. 1. ...

- kafka 数据一致性-leader,follower机制与zookeeper的区别;

我写了另一篇zookeeper选举机制的,可以参考:zookeeper 负载均衡 核心机制 包含ZAB协议(滴滴,阿里面试) 一.zookeeper 与kafka保持数据一致性的不同点: (1)zoo ...

- java学习一 path与classpath

path 任意目录下执行 javac JAVA classpath找到指定目录下的.class文件 前提是进入该文件目录里面 生成.class文件; 变量 的两个特性:1.约束了类型 2.约束了范围 ...

- Day23-Model操作和Form操作-转载

参考出处: http://blog.csdn.net/fgf00/article/details/54614706 Model和Form以及ModelForm简介 Model操作: 创建数据库表结构 ...

- 企业级 SpringBoot 教程 (一)构建第一个SpringBoot工程

简介 spring boot 它的设计目的就是为例简化开发,开启了各种自动装配,你不想写各种配置文件,引入相关的依赖就能迅速搭建起一个web工程.它采用的是建立生产就绪的应用程序观点,优先于配置的惯例 ...