python爬虫2

学习任务

获取去哪儿网的出发地列表

获取旅游景点列表

获取景点产品列表

存储数据

1 获取出发地站点

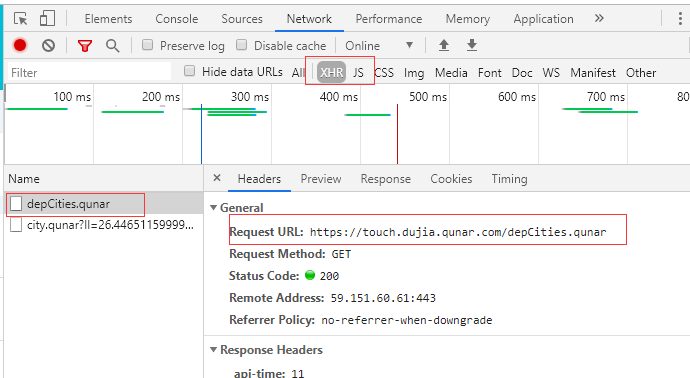

(1)访问touch.qunar.com

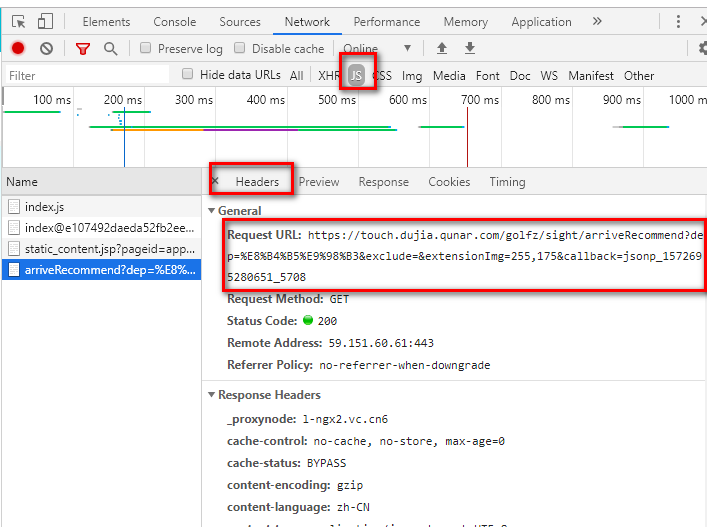

(2)按F12,单击自由行,在自由行页面点击搜索框

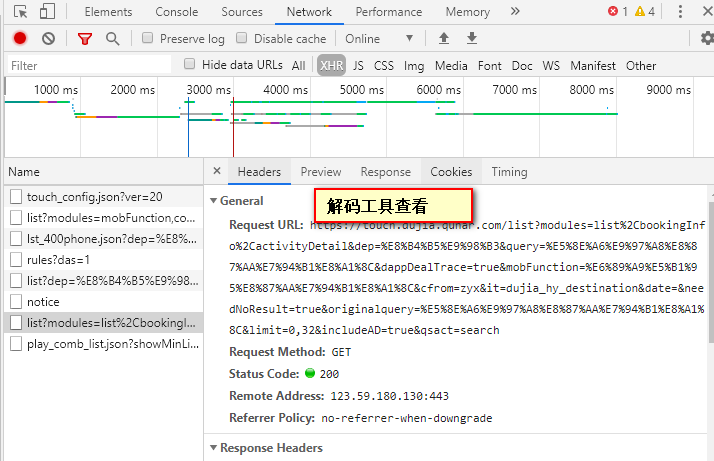

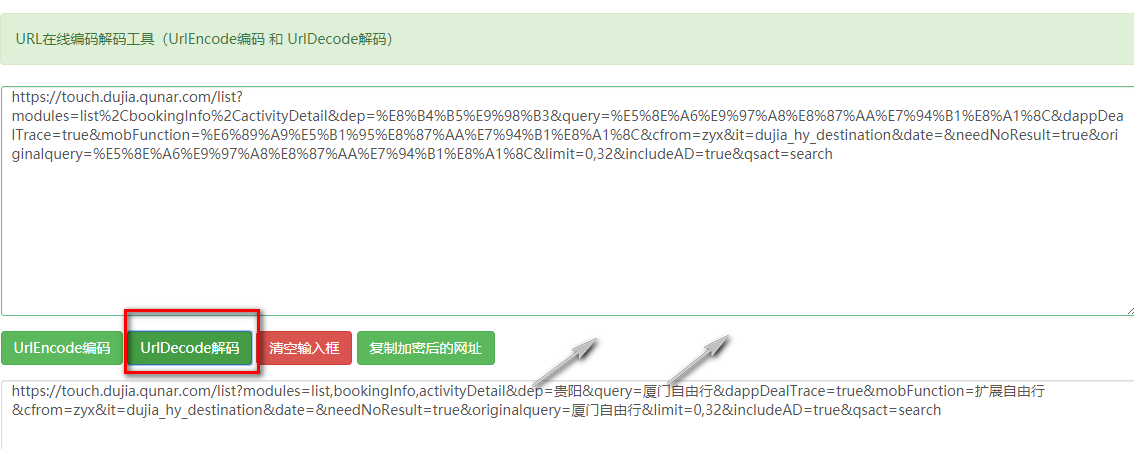

(3)单击任意一个城市,切换到headers,查看request URL如下所示。但是需要工具还原编码咋们才能知道这是啥(dep参数表示出发地,query表示目的地)。推荐网站http://www.jsons.cn/urlencode/,解码效果下面图2

3 实现

(1)首先获得出发地站点,因为最终需要获得整个自由行的产品列表。

自由行首页中点击左侧的出发点站点,然后获取目标URL如图二

import requests

url="https://touch.dujia.qunar.com/depCities.qunar" strhtml=requests.get(url)

print(strhtml)

dep_dict=strhtml.json()

print(dep_dict)

for dep_item in dep_dict['data']:

for dep in dep_dict['data'][dep_item]:

print(dep)

(2)获得目的地。根据上面的分析,json工具解码以后通过拼接可得URL。

url = 'https://m.dujia.qunar.com/golfz/sight/arriveRecommend?dep={}&exclude=&extensionImg=255,175'.format(urllib.request.quote(dep))

(3)总源码

import requests

import urllib

import time

#import pymongo # client=pymongo.MongoClient('localhost',27017)

# book_qunar=client['qunar']

# sheet_qunar_zyx=book_qunar['qunar_zyx'] #获取产品列表

def get_list(dep,item):

url = 'https://touch.dujia.qunar.com/list?modules=list,bookingInfo&dep={}&query={}&mtype=all&ddt=false&mobFunction=%E6%89%A9%E5%B1%95%E8%87%AA%E7%94%B1%E8%A1%8C&cfrom=zyx&it=FreetripTouchin&et=FreetripTouch&date=&configDepNew=&needNoResult=true&originalquery={}&limit=0,20&includeAD=true&qsact=search'.format(

urllib.request.quote(dep), urllib.request.quote(item), urllib.request.quote(item))

strhtml = get_json(url)

try:

routeCount = int(strhtml['data']['limit']['routeCount'])

except:

return

for limit in range(0, routeCount, 20):

url = 'https://touch.dujia.qunar.com/list?modules=list,bookingInfo&dep={}&query={}&mtype=all&ddt=false&mobFunction=%E6%89%A9%E5%B1%95%E8%87%AA%E7%94%B1%E8%A1%8C&cfrom=zyx&it=FreetripTouchin&et=FreetripTouch&date=&configDepNew=&needNoResult=true&originalquery={}&limit={},20&includeAD=true&qsact=search'.format(

urllib.request.quote(dep), urllib.request.quote(item),

urllib.request.quote(item), limit)

strhtml = get_json(url)

result = {

'date': time.strftime('%Y-%m-%d', time.localtime(time.time())),

'dep': dep,

'arrive': item,

'limit': limit,

'result': strhtml

}

#sheet_qunar_zyx.insert_one(result)

print(result) # def connect_mongo():

# client=pymongo.MongoClient('localhost',27017)

# book_qunar=client['qunar']

# return book_qunar['qunar_zyx'] def get_json(url):

strhtml=requests.get(url)

time.sleep(1)

return strhtml.json() if __name__ == "__main__": url='https://touch.dujia.qunar.com/depCities.qunar'

dep_dict=get_json(url)

#这里是json格式 dep_dict中内嵌勒一层

for dep_item in dep_dict['data']:

for dep in dep_dict['data'][dep_item]:

a = []#目的地去重

#经过解码工具可以得到dep表示出发地 query和originalquery表示目的地

url = 'https://m.dujia.qunar.com/golfz/sight/arriveRecommend?dep={}&exclude=&extensionImg=255,175'.format(urllib.request.quote(dep))

arrive_dict = get_json(url)

for arr_item in arrive_dict['data']:

for arr_item_1 in arr_item['subModules']:

for query in arr_item_1['items']:

if query['query'] not in a:

a.append(query['query'])

for item in a:

get_list(dep,item)

python爬虫2的更多相关文章

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- python爬虫成长之路(一):抓取证券之星的股票数据

获取数据是数据分析中必不可少的一部分,而网络爬虫是是获取数据的一个重要渠道之一.鉴于此,我拾起了Python这把利器,开启了网络爬虫之路. 本篇使用的版本为python3.5,意在抓取证券之星上当天所 ...

- python爬虫学习(7) —— 爬取你的AC代码

上一篇文章中,我们介绍了python爬虫利器--requests,并且拿HDU做了小测试. 这篇文章,我们来爬取一下自己AC的代码. 1 确定ac代码对应的页面 如下图所示,我们一般情况可以通过该顺序 ...

- python爬虫学习(6) —— 神器 Requests

Requests 是使用 Apache2 Licensed 许可证的 HTTP 库.用 Python 编写,真正的为人类着想. Python 标准库中的 urllib2 模块提供了你所需要的大多数 H ...

- 批量下载小说网站上的小说(python爬虫)

随便说点什么 因为在学python,所有自然而然的就掉进了爬虫这个坑里,好吧,主要是因为我觉得爬虫比较酷,才入坑的. 想想看,你可以批量自动的采集互联网上海量的资料数据,是多么令人激动啊! 所以我就被 ...

- python 爬虫(二)

python 爬虫 Advanced HTML Parsing 1. 通过属性查找标签:基本上在每一个网站上都有stylesheets,针对于不同的标签会有不同的css类于之向对应在我们看到的标签可能 ...

- Python 爬虫1——爬虫简述

Python除了可以用来开发Python Web之后,其实还可以用来编写一些爬虫小工具,可能还有人不知道什么是爬虫的. 一.爬虫的定义: 爬虫——网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区 ...

- Python爬虫入门一之综述

大家好哈,最近博主在学习Python,学习期间也遇到一些问题,获得了一些经验,在此将自己的学习系统地整理下来,如果大家有兴趣学习爬虫的话,可以将这些文章作为参考,也欢迎大家一共分享学习经验. Pyth ...

- [python]爬虫学习(一)

要学习Python爬虫,我们要学习的共有以下几点(python2): Python基础知识 Python中urllib和urllib2库的用法 Python正则表达式 Python爬虫框架Scrapy ...

- python爬虫学习(1) —— 从urllib说起

0. 前言 如果你从来没有接触过爬虫,刚开始的时候可能会有些许吃力 因为我不会从头到尾把所有知识点都说一遍,很多文章主要是记录我自己写的一些爬虫 所以建议先学习一下cuiqingcai大神的 Pyth ...

随机推荐

- [USACO08OCT]:打井Watering Hole(MST)

题意:有N个牧场,每个牧场修水井花费Wi,连接牧场花费Pij,问最小花费,使得每个牧场要么有水井,要么和有水井的牧场有通道. 思路:加一个格外的节点O,连接O表示修井,边权是修井的费用. 那么 ...

- ZOJ - 3157:Weapon (几何 逆序对)

pro:给定平面上N条直线,保证没有直线和Y轴平行. 求有多少交点的X坐标落在(L,R)开区间之间,注意在x=L或者R处的不算. sol:求出每条直线与L和R的交点,如果A直线和B直线在(L,R)相交 ...

- 微信小程序——音频播放器

先来个效果图韵下味: 需求: 音频的播放,暂停,中间按钮状态的变化,播放时实时更新播放进度: 前进15s,后退15s: 进度条拖动. 一开始想着这3个功能应该挺简单的.不就是播放,暂停,前进,后退么~ ...

- May Cook-Off 2019 解题报告

太气了.Atcoder unrated了. 这一场时间太不友好了.昨天下午一时兴起就去补了一发.题很好,学到好多东西. Chain Reaction 题意:给一个矩阵,这个矩阵是稳定的当且仅当每一个元 ...

- 微信浏览器中清缓存的方法---- http://debugx5.qq.com/

http://debugx5.qq.com/ 点击上面网址,然后把底部的四个选项打钩,然后点清除,即可把可恶的缓存清掉!!!!!

- Day17:web前端开发面试题

1.JavaScript 数据类型有哪些? JavaScript 变量能够保存多种数据类型:数值.字符串值.数组.对象等等: var length = 7; // 数字 var lastName = ...

- java内存dump文件导出与查看

生成dump文件的命令:jmap -dump:format=b,file=20170307.dump 16048file后面的是自定义的文件名,最后的数字是进程的pid 使用jvisualvm来分析d ...

- java.net.MalformedURLException: unknown protocol: 异常

开门见山的说,第一个参数u,赋的值是 "D://123.txt",于是乎,报错了,java.net.MalformedURLException: unknown protocol: ...

- C# System.Web.Mail.MailMessage 发邮件

C# System.Web.Mail.MailMessage 发邮件 新建控制台Console项目,然后添加 System.Web引用 代码如下: using System; using System ...

- JdkDynamicAopProxy 拦截器链的获得与递归执行

JdkDynamicAopProxy类的invoke方法 1.获得拦截器链 List<Object> chain = this.advised.getInterceptorsAndDyna ...