Python CNN卷积神经网络代码实现

一.概述

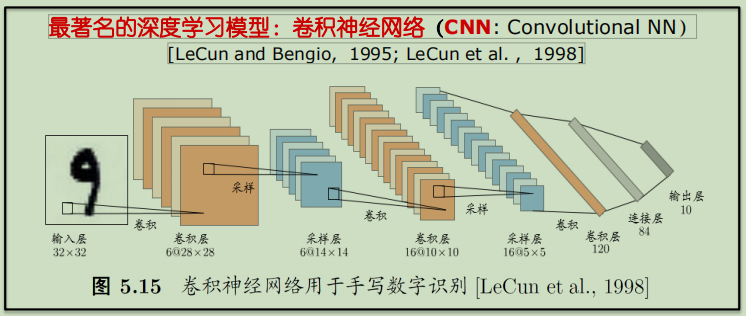

卷积神经网络【Convolutional Neural Networks,CNN】是一类包含卷积计算且具有深度结构的前馈神经网络【Feedforward Neural Networks】是深度学习的代表算法之一。卷积神经网络具有表征学习【representation learning】能力,能够按其阶层结构对输入信息进行平移不变分类。

神经网络实质上是多层函数嵌套形成的数学模型。1998年Yann LeCun等人推出了LeNet-5架构,广泛用于手写字体识别,包含全连接层和sigmoid激活函数,还有卷积层和池化层。

二.代码实现

# -*- coding: utf-8 -*-

"""

Created on Wed Nov 21 17:32:28 2018 @author: zhen

""" import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data mnist = input_data.read_data_sets('C:/Users/zhen/MNIST_data_bak/', one_hot=True)

sess = tf.InteractiveSession() def weight_variable(shape):

initial = tf.truncated_normal(shape, stddev=0.1)

return tf.Variable(initial) def bias_variable(shape):

initial = tf.constant(0.1, shape=shape)

return tf.Variable(initial) def conv2d(x, W):

return tf.nn.conv2d(x, W, strides=[1, 1, 1, 1], padding='SAME') def max_pool_2x2(x):

return tf.nn.max_pool(x, ksize=[1, 2, 2, 1], strides=[1, 2, 2, 1], padding='SAME') x = tf.placeholder(tf.float32, [None, 784])

y = tf.placeholder(tf.float32, [None, 10])

x_image = tf.reshape(x, [-1, 28, 28, 1]) # 第一层卷积核

W_conv = weight_variable([5, 5, 1, 16])

b_conv = bias_variable([16])

h_conv = tf.nn.relu(conv2d(x_image, W_conv) + b_conv)

h_pool = max_pool_2x2(h_conv) # 第二层卷积核

W_conv2 = weight_variable([5, 5, 16, 32])

b_conv2 = bias_variable([32])

h_conv2 = tf.nn.relu(conv2d(h_pool, W_conv2) + b_conv2)

h_pool2 = max_pool_2x2(h_conv2) # 全连接层

W_fc = weight_variable([7 * 7 * 32, 512])

b_fc = bias_variable([512])

h_pool_flat = tf.reshape(h_pool2, [-1, 7 * 7 * 32])

h_fc = tf.nn.relu(tf.matmul(h_pool_flat, W_fc) + b_fc) # 防止过拟合,使用Dropout层

keep_prob = tf.placeholder(tf.float32)

h_fc_drop = tf.nn.dropout(h_fc, keep_prob) # Softmax分类

W_fc2 = weight_variable([512, 10])

b_fc2 = bias_variable([10])

y_conv = tf.nn.softmax(tf.matmul(h_fc_drop, W_fc2) + b_fc2) # 定义损失函数

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y * tf.log(y_conv), reduction_indices=[1]))

train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)

correct_prediction = tf.equal(tf.argmax(y_conv, 1), tf.argmax(y, 1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32)) # 训练

tf.global_variables_initializer().run()

for i in range(20):

batch = mnist.train.next_batch(50)

train_step.run(feed_dict={x:batch[0], y:batch[1], keep_prob:0.5}) print("test accuracy %g" % accuracy.eval(feed_dict={x:mnist.test.images, y:mnist.test.labels, keep_prob:1.0}))

三.结果

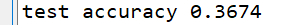

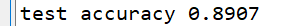

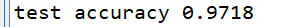

1.算法模型不变,增大训练集数据【隐藏一层16个卷积核,隐藏二层32个卷积核,全连接层512,10分类】:

数据集为1000条:

数据集为10000条:

数据集为100000条:

2.训练集数据不变,增大卷积核数【数据集为10000,全连接层512,10分类】:

隐藏一层16个卷积核,隐藏二层32个卷积核:

隐藏一层32个卷积核,隐藏二层64个卷积核:

隐藏一层64个卷积核,隐藏二层128个卷积核:

四.分析

在训练集较小时,一味增加卷积核的数量对预测性能的提升十分有限,在相同模型的情况下,适当的提升训练集的数据对模型的提升十分明显,当然为了达到更高的性能可以两者兼得!

Python CNN卷积神经网络代码实现的更多相关文章

- tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图

tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图 因为很多 demo 都比较复杂,专门抽出这两个函数,写的 demo. 更多教程:http://www.tensorflown ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

https://www.zhihu.com/question/34681168 CNN(卷积神经网络).RNN(循环神经网络).DNN(深度神经网络)的内部网络结构有什么区别?修改 CNN(卷积神经网 ...

- Deep Learning模型之:CNN卷积神经网络(一)深度解析CNN

http://m.blog.csdn.net/blog/wu010555688/24487301 本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep le ...

- [转]Theano下用CNN(卷积神经网络)做车牌中文字符OCR

Theano下用CNN(卷积神经网络)做车牌中文字符OCR 原文地址:http://m.blog.csdn.net/article/details?id=50989742 之前时间一直在看 Micha ...

- Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现(转)

Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文, ...

- 基于Python的卷积神经网络和特征提取

基于Python的卷积神经网络和特征提取 用户1737318发表于人工智能头条订阅 224 在这篇文章中: Lasagne 和 nolearn 加载MNIST数据集 ConvNet体系结构与训练 预测 ...

- cnn(卷积神经网络)比较系统的讲解

本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep learning简介 [2]Deep Learning训练过程 [3]Deep Learning模型之 ...

- TensorFlow——CNN卷积神经网络处理Mnist数据集

CNN卷积神经网络处理Mnist数据集 CNN模型结构: 输入层:Mnist数据集(28*28) 第一层卷积:感受视野5*5,步长为1,卷积核:32个 第一层池化:池化视野2*2,步长为2 第二层卷积 ...

- 3层-CNN卷积神经网络预测MNIST数字

3层-CNN卷积神经网络预测MNIST数字 本文创建一个简单的三层卷积网络来预测 MNIST 数字.这个深层网络由两个带有 ReLU 和 maxpool 的卷积层以及两个全连接层组成. MNIST 由 ...

随机推荐

- 线程安全-002-多个线程多把锁&类锁

一.多个对象多把锁 例子代码: package com.lhy.thread01; public class MultiThread { //static private int num = 0; / ...

- JAVA代理分析

JAVA的动态代理 代理模式 代理模式是常用的java设计模式,他的特征是代理类与委托类有同样的接口,代理类主要负责为委托类预处理消息.过滤消息.把消息转发给委托类,以及事后处理消息等.代理类与委托类 ...

- webpack-loader是怎样炼成的

目录 啰嗦两句 loader 是干什么的 loader 的工具箱 --context loader 实战 啰嗦两句 学习这件事从学习动机上来看,可以分成两种情况:主动学习和被动学习.主动学习就是,某天 ...

- vue axios封装以及API统一管理

在vue项目中,每次和后台交互的时候,经常用到的就是axios请求数据,它是基于promise的http库,可运行在浏览器端和node.js中.当项目越来越大的时候,接口的请求也会越来越多,怎么去管理 ...

- 深度学习论文翻译解析(三):Detecting Text in Natural Image with Connectionist Text Proposal Network

论文标题:Detecting Text in Natural Image with Connectionist Text Proposal Network 论文作者:Zhi Tian , Weilin ...

- spring-boot-2.0.3启动源码篇二 - run方法(一)之SpringApplicationRunListener

前言 Springboot启动源码系列还只写了一篇,已经过去一周,又到了每周一更的时间了(是不是很熟悉?),大家有没有很期待了?我会尽量保证启动源码系列每周一更,争取不让大家每周的期望落空.一周之中可 ...

- 初步掌握node的路由控制

1.1.2:node.js的路由控制 1.运行原理 在1.1.1节中,提到过app.js中app.get("/",routes.index)可以用以下代码取代: app.get(& ...

- DML和索引内部结构变化

1.修改数据对索引结构的影响 合适的索引对查询性能和效率的提升是巨大的,但是万事有利有弊,拥有索引的表在增.删.改记录时需要去维护索引.如何让增.删.改更快速更高效?这就需要了解数据修改时对索引结构会 ...

- .net导出excle无需任何插件,直接通过一个tablehtml实现

项目背景: 项目需要导出样式复杂的excl表格,主要是一些样式布局比较复杂 技术分析: 目前比较通用的实现方式有 1.借助微软的excle插件 2.通过NPOI插件实现 3.直接导出一个html(ta ...

- C#实现接口IHttpModule完成统一的权限验证

测试代码如下: using System; using System.Collections.Generic; using System.Text; using System.Collections; ...