TensorFlow Serving实现多模型部署以及不同版本模型的调用

前提:要实现多模型部署,首先要了解并且熟练实现单模型部署,可以借助官网文档,使用Docker实现部署。

1. 首先准备两个你需要部署的模型,统一的放在multiModel/文件夹下(文件夹名字可以任意取),其目录结构如下:

multiModel/

├── model1

│ └── 00000123

│ ├── saved_model.pb

│ └── variables

│ ├── variables.data-00000-of-00001

│ └── variables.index

├── model2

│ └── 00000123

│ ├── saved_model.pb

│ └── variables

│ ├── variables.data-00000-of-00001

│ └── variables.index

└── models.config

2. 在 multiModel/目录中创建models.config配置文件,内容如下:

model_config_list:{

config:{

name:"model1",

base_path:"/models/multiModel/model1",

model_platform:"tensorflow"

},

config:{

name:"model2",

base_path:"/models/multiModel/model2",

model_platform:"tensorflow"

},

}

# 注:

base_path路径前面的/models/是固定写法,后面写上你的目录名加上模型路径

否则报错:FileSystemStoragePathSource encountered a filesystem access error: Could not find base path /home/node1/model/multiModel/model1 for servable model1

3. 配置文件定义了模型的名称和模型在容器内的路径,现在运行tf-serving容器 :

sudo docker run -p 8501:8501 --mount type=bind,source=/home/node1/model/multiModel/,target=/models/multiModel -t tensorflow/serving:latest-gpu --model_config_file=/models/multiModel/models.config # 注:

1. taget后面写的是模型总路径,与单模型有些区别,单模型写的是具体的某一个模型路径;

2. --model_config_file 后面配置文件的路径前面是固定写法/models/,后面加上配置文件的路径,如果写绝对路径或者相对路径找models.config,会报错找不到文件或者路径;

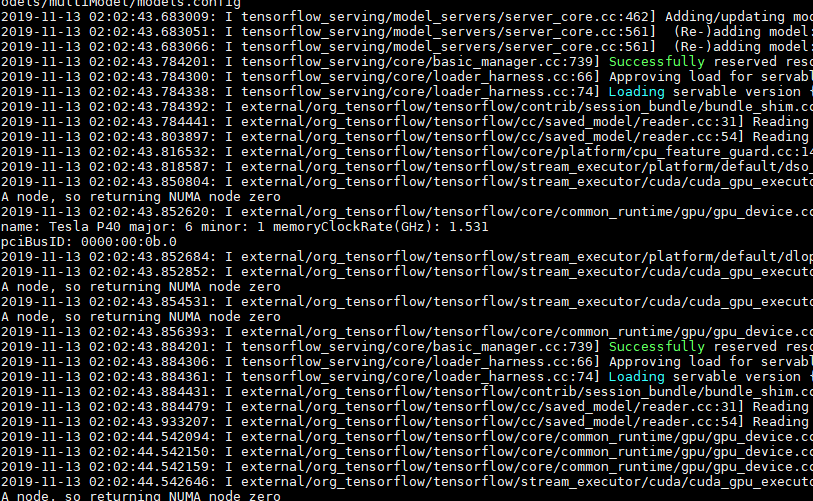

4. 最后看到这样的界面,并查看GPU已经占用,表明多模型已经部署成功:

——————————————————————————————指定模型版本————————————————————————————————————————

如果一个模型有多个版本,并在预测的时候希望指定模型的版本,可以通过以下方式实现。

修改model.config文件,增加model_version_policy参数:

model_config_list:{

config:{

name:"model1",

base_path:"/models/multiModel/model1",

model_platform:"tensorflow",

model_version_policy:{

all:{}

}

},

config:{

name:"model2",

base_path:"/models/multiModel/model2",

model_platform:"tensorflow"

},

}

请求预测的时候,如果要使用版本为00000124的模型,只要修改请求URL为:

URL = 'http://公网ip:8501/v1/models/model1/versions/00000124:predict'

上述容器运行起来之后,如果在宿主机的 /home/node1/model/multiModel/model1/ 文件夹下新增模型文件如00000124/,tfserving会自动加载新模型;同样如果移除现有模型,tfserving也会自动卸载模型。

上述文档参考:https://blog.csdn.net/JerryZhang__/article/details/86516428 感谢~

多模型部署已经复现,模型版本暂时没有这个需求,未复现~

TensorFlow Serving实现多模型部署以及不同版本模型的调用的更多相关文章

- tensorflow 模型保存与加载 和TensorFlow serving + grpc + docker项目部署

TensorFlow 模型保存与加载 TensorFlow中总共有两种保存和加载模型的方法.第一种是利用 tf.train.Saver() 来保存,第二种就是利用 SavedModel 来保存模型,接 ...

- Tensorflow Serving Docker compose 部署服务细节(Ubuntu)

[摘要] Tensorflow Serving 是tf模型持久化的重要工具,本篇介绍如何通过Docker compose搭建并调试TensorFlow Serving TensorFlow Servi ...

- 移动端目标识别(3)——使用TensorFlow Lite将tensorflow模型部署到移动端(ssd)之Running on mobile with TensorFlow Lite (写的很乱,回头更新一个简洁的版本)

承接移动端目标识别(2) 使用TensorFlow Lite在移动设备上运行 在本节中,我们将向您展示如何使用TensorFlow Lite获得更小的模型,并允许您利用针对移动设备优化 ...

- TensorFlow Serving简介

一.TensorFlow Serving简介 TensorFlow Serving是GOOGLE开源的一个服务系统,适用于部署机器学习模型,灵活.性能高.可用于生产环境. TensorFlow Ser ...

- 如何使用flask将模型部署为服务

在某些场景下,我们需要将机器学习或者深度学习模型部署为服务给其它地方调用,本文接下来就讲解使用python的flask部署服务的基本过程. 1. 加载保存好的模型 为了方便起见,这里我们就使用简单的分 ...

- PyTorch专栏(六): 混合前端的seq2seq模型部署

欢迎关注磐创博客资源汇总站: http://docs.panchuang.net/ 欢迎关注PyTorch官方中文教程站: http://pytorch.panchuang.net/ 专栏目录: 第一 ...

- Tensorflow Serving 模型部署和服务

http://blog.csdn.net/wangjian1204/article/details/68928656 本文转载自:https://zhuanlan.zhihu.com/p/233614 ...

- 139、TensorFlow Serving 实现模型的部署(二) TextCnn文本分类模型

昨晚终于实现了Tensorflow模型的部署 使用TensorFlow Serving 1.使用Docker 获取Tensorflow Serving的镜像,Docker在国内的需要将镜像的Repos ...

- 138、Tensorflow serving 实现模型的部署

将Tensorflow模型部署成Restful接口 下面是实现过程,整个操作都是在Linux上面实现的,因为Tensorflow Serving 目前还只支持Linux 这个意义真的是革命性的,因为从 ...

随机推荐

- Android recycleview item水波纹效果

item的xml 根标签下添加如下三个属性 android:clickable="true" android:focusable="true" android: ...

- 浏览器CA认证流程

转载:https://blog.csdn.net/qq_22771739/article/details/86479411 首先说说证书的签发过程: 服务方 S 向第三方机构CA提交公钥.组织信息.个 ...

- 3)小案例三,加乐前端入口index.php

之前的代码没有什么改动,唯一改动的就是我在之前的目录结构中加了 index.php作为前端的入口文件 目前,我的文件目录关系是: 然后我的index.php代码内容是: <?php /** * ...

- IE11阅读视图:带给你静心饕餮阅读大餐的片刻

编者按:又到读书日,今天你挤出时间读书了吗?如今,越来越多人在习惯电子阅读,然而总难逃眼花缭乱的干扰信息.Internet Explorer 11新增阅读视图功能,一键开启,给你带给你静心饕餮阅读大餐 ...

- 3dmax2014卸载/安装失败/如何彻底卸载清除干净3dmax2014注册表和文件的方法

3dmax2014提示安装未完成,某些产品无法安装该怎样解决呢?一些朋友在win7或者win10系统下安装3dmax2014失败提示3dmax2014安装未完成,某些产品无法安装,也有时候想重新安装3 ...

- deeplearning.ai 改善深层神经网络 week1 深度学习的实用层面

1. 应用机器学习是高度依赖迭代尝试的,不要指望一蹴而就,必须不断调参数看结果,根据结果再继续调参数. 2. 数据集分成训练集(training set).验证集(validation/develop ...

- Linux下文件 ~/.bashrc 和 ~/.bash_profile 和 /etc/bashrc 和 /etc/profile 的区别 | 用户登录后加载配置文件的顺序

转自 https://blog.csdn.net/secondjanuary/article/details/9206151 文件说明: /ect/profile 此文件为系统的每个用户设置环境信息, ...

- python3多线程爬虫(第一卷)

多进程虽然使用方便,可以充分利用CPU,但是由于个进程之间是并行且各自有自己的数据存储,所以很难进行数据间的通信,需要接入第三方模块,现在我依旧用糗事百科讲解下多线程的应用,举个例子之前用4个进程同时 ...

- JDBC之BaseDao类

package com.it.util; import java.sql.Connection; import java.sql.DriverManager; import java.sql.Prep ...

- VRRP笔记一:基本简介(注意iptables和selinux的问题)

LAN客户端判定哪个路由器应该为其到达目标主机的下一跳网关的方式有动态及静态决策两种方式,其中,觉的动态路由发现方式有如下几种: 1.Proxy ARP —— 客户端使用ARP协议获取其想要到达的目标 ...