Python快速爬取车标网图片,以后不要说这什么车你不认识了!

知识不分边界......

人,为什么要读书?举个例子:

当看到天边飞鸟,你会说:“落霞与孤鹜齐飞,秋水共长天一色。”而不是:“卧靠,好多鸟。”;

当你失恋时你低吟浅唱道:“人生若只如初见,何事秋风悲画扇。”而不是千万遍地悲喊:“蓝瘦,香菇!”

今天回家早,陪俩小爷在楼下遛弯,忽然听见一阵马达轰鸣声,嗖~~闪一辆跑车,大大问;“爸爸,这是什么车啊?” 我:“红色的车…”小小说:“爸爸肯定不认识,我也知道是红色的车。”气氛有些冷场…

别人看车关注牌子,我看车关注宽敞不,睡着舒服不?可不管怎样不能在孩子面前丢份啊,我决定学习学习车标!

车标网

在网上找了半天车标的数据,最后看到了这个网站:车标网:http://www.chebiaow.com/logo。

网站将车系按照字母从A-Z进行了排序,然后点击每个车标进入详细信息,那Audi做例子:

有用的数据是哪些?品牌名称,车标,成立时间,主要车型,官网…

那么今天的爬虫练习呼之欲出,获取车标网下所有的汽车品牌及车标,并入库保存…

数据库操作指南

针对简单的数据,我习惯用python自带的sqlite3进行数据库的存储,简单方便….那么如何管理我们的数据库呢?推荐使用DBUtils!在往期的文章

决战高考,帮你秒变成语之王中,有对DBUtils的详细介绍,这里就不再赘述了…

但本次有一个知识点,我们需要将车标图片,存储在数据库中,那么如何在数据库中存储图片,使用类型BLOB。举一个简单的数据库图片读写例子

# -*- coding: utf-8 -*-

# @Author : 王翔

# @JianShu : 清风Python

# @Date : 2019/7/22 23:00

# @Software : PyCharm

# @version :Python 3.7.3

# @File : show.py

import sqlite3

db = sqlite3.connect('Car.db')

cur = db.cursor()

cur.execute("CREATE TABLE if not exists image_save (image BLOB);")

with open('Audi.jpg', 'rb') as f:

cur.execute("insert into image_save values(?)", (sqlite3.Binary(f.read()),))

db.commit()

cur.execute('select image from image_save limit 1')

b = cur.fetchone()[0]

with open('1.jpg', 'wb') as f:

f.write(b)

我们创建一个image_save的测试表,然后将图片读取为二进制字节的方式,通过sqlite3.Binary将二进制文件存储至数据库。

那么同样的,我们将BLOB类型的图片读取出来后,进行写入,即可达到效果,来看看这个1.jpg是否正常:

图片下载小技巧

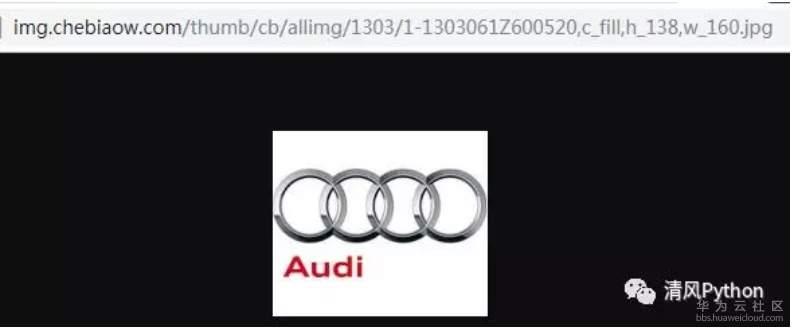

看过了二进制的存储方式,大家肯定说明白了,网站获取到图片链接然后找着上面的例子下载到本地,然后再进行二进制的读取后存储数据库即可,对吗?不对…有什么问题呢?来看一个例子:

这里Audi图片的链接地址,我们通过requests来下载看看….

import requests

r =requests.get('http://img.chebiaow.com/thumb/cb/allimg/1303/1-1303061Z600520,c_fill,h_138,w_160.jpg')

r.content

b'\xff\xd8\xff\xe0\x00\x10JFIF\x00\x01\x01...'

可以看到我们通过requests.get获取到的content就已经是二进制数据了,为何还要存储成图片,在转化呢?网页分析

适配url

针对A-Z的车标排序,网站的url匹配关系很简单:

from string import ascii_uppercase as au

# ascii_uppercase代表A-Z,当然你可以不引入模块自己生成也OK...

for uppercase in au:

"http://www.chebiaow.com/logo/{}.html".format(au)

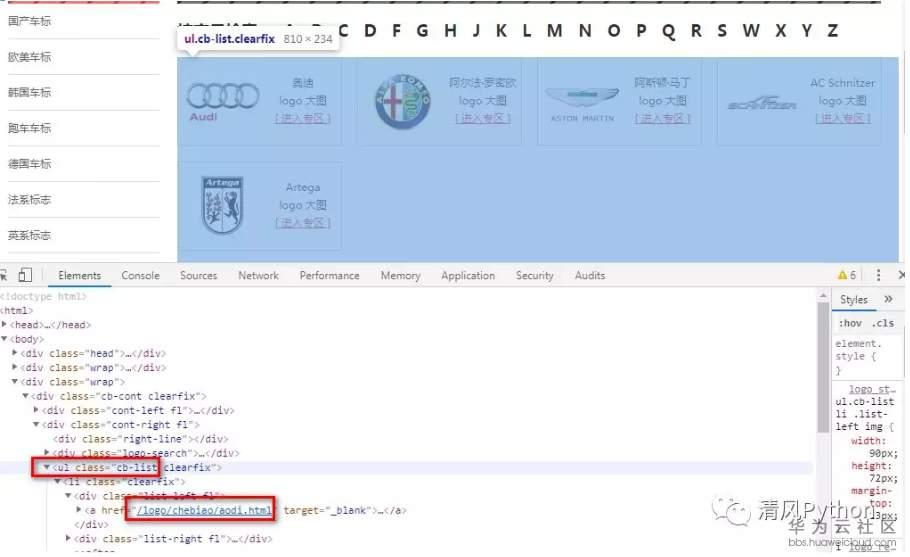

获取品牌链接

可以看到在包含cb-list方法的ul下匹配所有li中的第一个a标签,然后拼接base_url即可。

品牌详情

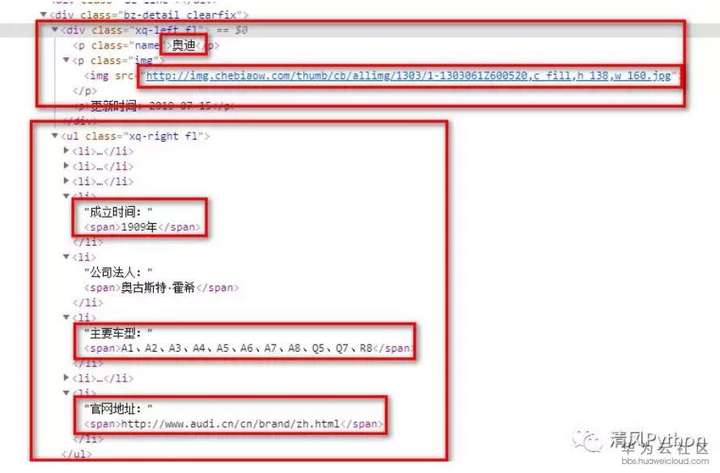

进入品牌详情界面后,我们针对左右栏目的设置,分别获取所需标红的内容

整体代码

通过上面的分析,我们开始爬虫,但这个网站真的是相应好慢,没办法添加上Threading的多线程执行吧,整体代码如下:

# -*- coding: utf-8 -*-

# @Author : 王翔

# @JianShu : 清风Python

# @Date : 2019/7/22 23:08

# @Software : PyCharm

# @version :Python 3.7.3

# @File : CarLogo.py

import os

from db_maker import DbMaker as DB

from string import ascii_uppercase as au

import requests

from bs4 import BeautifulSoup

from urllib.parse import urljoin

from sqlite3 import Binary

import threading

import time

class CarLogo:

DATABASE = 'car.db' def __init__(self):

self.db = DB()

self.path = os.path.dirname(os.path.realpath(__file__))

self.images_path = os.path.join(self.path, 'images_path')

self.host = "http://www.chebiaow.com"

self.headers = {

'Connection': 'keep-alive',

'user-agent': ('Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 '

'(KHTML, like Gecko) Chrome/70.0.3538.67 Safari/537.36')

} def check_dir(self):

if not os.path.exists(self.images_path):

os.mkdir(self.images_path) def get_response(self, url, params=None):

try:

r = requests.get(url, headers=self.headers, params=params, timeout=15)

except:

pass

soup = BeautifulSoup(r.text, "lxml")

return soup def create_url(self):

_url_format = "http://www.chebiaow.com/logo/{}.html"

for uppercase in au:

try:

soup = self.get_response(_url_format.format(uppercase))

_cars = soup.find("ul", {"class": "cb-list"}).findAll('li')

for car in _cars:

# self.car_info()

t = threading.Thread(target=self.car_info, args=(urljoin(self.host, car.div.a['href']),))

time.sleep(0.5)

t.start()

except:

pass def car_info(self, url):

soup = self.get_response(url)

left_index = soup.find("div", {"class": "xq-left"}).findAll('p')

name = left_index[0].text

image_byte = requests.get(left_index[1].img['src']).content

right_index = soup.find("ul", {"class": "xq-right"}).findAll('li')

founded = right_index[3].span.text

models = right_index[5].span.text

website = right_index[7].span.text

print("Insert Car Logo {}".format(name))

_sql = "insert into car_logo(name,image,founded,models,website) values (?,?,?,?,?)"

self.db.insert(_sql, (name, Binary(image_byte), founded, models, website))

if __name__ == '__main__':

m = CarLogo()

m.create_url()

最终存储的数据库如下:

由于图片是BLOB类型的二进制文件,所以大家看到的是星星,感觉网站的车标是不不够,怎么才140多种(虽然我能认识的不到20种…)

这个中兴看了半天还以为是搞错了,没想到是同名的…

OK,今天的内容就到这里,整理好数据库,哪天闲了做一个车标的测试题,当然大家可以按照之前我的使用爬虫+Flask获取世界国旗数据和孩子一起学习那边文章引申着自己写一个车标的练习题。

Python快速爬取车标网图片,以后不要说这什么车你不认识了!的更多相关文章

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- python爬虫——爬取NUS-WIDE数据库图片

实验室需要NUS-WIDE数据库中的原图,数据集的地址为http://lms.comp.nus.edu.sg/research/NUS-WIDE.htm 由于这个数据只给了每个图片的URL,所以需 ...

- python爬虫:爬取慕课网视频

前段时间安装了一个慕课网app,发现不用注册就可以在线看其中的视频,就有了想爬取其中的视频,用来在电脑上学习.决定花两天时间用学了一段时间的python做一做.(我的新书<Python爬虫开发与 ...

- [Python] 快速爬取当前城市所有租房网站房源及配置,一目了然

Python爬取当前城市房源信息,以徐州为例代码效果图请看下方,其他部分请查看附件,一起学习,谢谢 # -*- coding: utf-8 -*- """ @Time : ...

- Python爬虫爬取彼岸网4K Picture

深夜爬取4k图片 下载流程 定义page_text函数,对第一页地址发送get请求,因为页面数据在页面源代码都能查到,所以发送get 请求就ok!,注意:要进行编码格式设置,可以去源代码查看, 定义p ...

- python爬虫爬取赶集网数据

一.创建项目 scrapy startproject putu 二.创建spider文件 scrapy genspider patubole patubole.com 三.利用chrome浏览器 ...

- Python 爬虫: 抓取花瓣网图片

接触Python也好长时间了,一直没什么机会使用,没有机会那就自己创造机会!呐,就先从爬虫开始吧,抓点美女图片下来. 废话不多说了,讲讲我是怎么做的. 1. 分析网站 想要下载图片,只要知道图片的地址 ...

- Python爬虫 爬取百合网的女人们和男人们

学Python也有段时间了,目前学到了Python的类.个人感觉Python的类不应称之为类,而应称之为数据类型,只是数据类型而已!只是数据类型而已!只是数据类型而已!重要的事情说三篇. 据书上说一个 ...

- .Net Core爬虫爬取妹子网图片

现在网上大把的Python的爬虫教程,很少看见有用C#写的,正好新出的.Net Core可以很方便的部署到Linux上,就用妹子图做示范写个小爬虫 在C#下有个很方便的类库 HtmlAgilityPa ...

随机推荐

- Jmeter连接数据库sql语句操作,查询后取值做变量

第一步 :导入jar包 第二步 :创建JDBC Reques 第三步 :创建JDBC Connection Configuration 第四步:在request中输入数据进行操作 Query Typ ...

- 前端CSS五中元素定位类型

元素想通过底部.顶部.左侧.右侧属性定位是必须先设定position的属性值 posistion属性的五个值:static.relative.fixed.absoulte.sticky static定 ...

- 《最新出炉》系列初窥篇-Python+Playwright自动化测试-21-处理鼠标拖拽-番外篇

1.简介 前边宏哥拖拽有提到那个反爬虫机制,加了各种参数,以及加载js脚本文件还是有问题,偶尔宏哥好像发现了解决问题的办法,看到了黎明的曙光,宏哥就说试一下看看行不行,万一实现了.结果宏哥试了结果真的 ...

- mysql 代码适配 postgresql 适配改写,优化案例(行转列 + 标量子查询改写)

最近在适配个MySQL应用的项目,各种SQL改成PG兼容的语法真的是脑壳痛,今天遇到个有意思的案例. 原 MySQL SQL语句: SELECT DISTINCT l.MALL_NAME '项目', ...

- CF1592C. Bakry and Partitioning

原题链接:CF1592C. Bakry and Partitioning 题意: 给定一个\(n\)个点,\(n - 1\)条边的树,并且每个点都有权值\(w_i\),让你最少割掉一条边最多割掉\(k ...

- 关联规则挖掘:Apriori算法的深度探讨

在本文中,我们深入探讨了Apriori算法的理论基础.核心概念及其在实际问题中的应用.文章不仅全面解析了算法的工作机制,还通过Python代码段展示了具体的实战应用.此外,我们还针对算法在大数据环境下 ...

- 聊聊分布式 SQL 数据库Doris(三)

详细内容阅读: Apache Doris 分区分桶新功能 与 数据划分. 在此基础上做总结与延伸. 在 Doris 的存储引擎规则: 表的数据是以分区为单位存储的,不指定分区创建时,默认就一个分区. ...

- 一个基于ASP.NET Core完全开源的CMS 解决方案

本文简介 MixCoreCMS是一个基于.NET Core框架的开源内容管理系统(CMS),提供了丰富的的基础功能和插件,是一款面向未来的企业 Web CMS,可轻松构建任何类型的应用程序.集成了Go ...

- mySql中使用命令行建表基本操作

一:打开命令行启动mysql服务 注意事项:应该使用管理员身份打开命令行键入命令:net start mysql (鼠标右键使用管理员身份打开),否则会出现拒绝访问报错. 二:登陆数据库 登陆命令为& ...

- 在TCP四次挥手中,为什么客户端发送FIN后,还可以发送报文

在TCP四次挥手中,为什么客户端发送FIN后,还可以发送报文 首先回顾下四次挥手的过程. 第一次挥手:客户端停止发送数据,主动关闭 TCP 连接,处于FIN_WAIT1状态,等待服务端确认. 第二次挥 ...