[Spark SQL] SparkSession、DataFrame 和 DataSet 练习

本課主題

- DataSet 实战

DataSet 实战

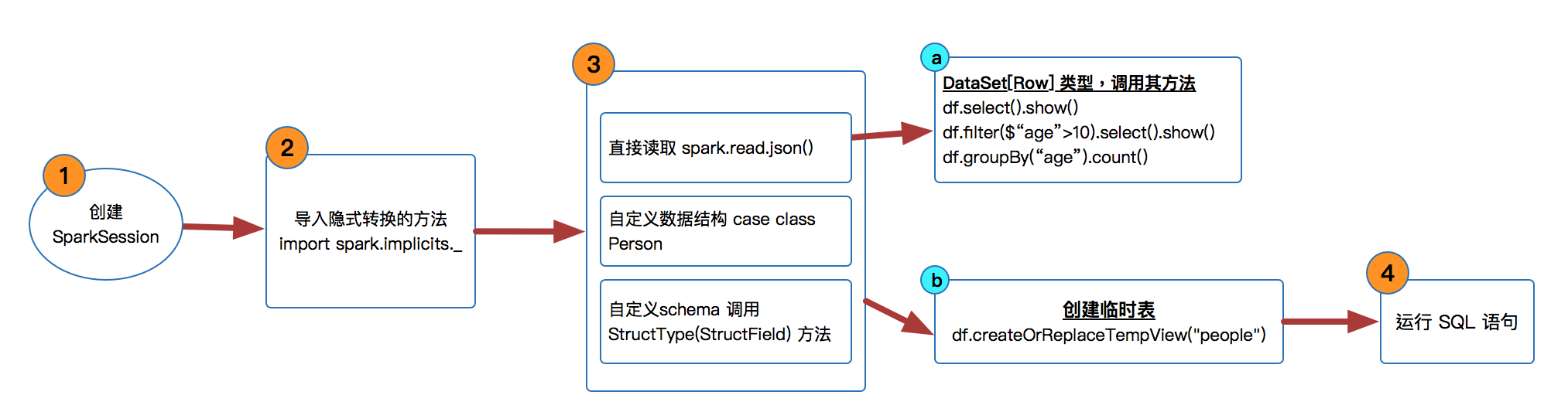

SparkSession 是 SparkSQL 的入口,然后可以基于 sparkSession 来获取或者是读取源数据来生存 DataFrameReader,在 Spark 2.x 版本中已经没有 DataFrame 的 API,它变成了 DataSet[Row] 类型的数据。

- 创建 SparkSession

val spark = SparkSession

.builder()

.master("local")

.appName("Spark SQL Basic Examples")

.getOrCreate() - 导入隐式转换的方法

import spark.implicits._

import org.apache.spark.sql.types._ // 自定义schema时导入 创建 DataFrame 即 DataSet[Row] 类型数据。

val df = spark.read.json("src/main/resources/general/people.json")- 可以直接调用 DataFrame 很多很好用的方法,比如 select( ),filter( ),groupBy( )

df.show() //打印数据,默认是前20条数据

df.printSchema()

df.select("name").show() //提取column是name的数据

df.select($"name",$"age" + 1).show() //提取column是name和age+1的数据

df.filter($"age" > 25).select("name").show()

df.groupBy($"age").count().show()

- 可以直接调用 DataFrame 很多很好用的方法,比如 select( ),filter( ),groupBy( )

- 也可以自定义 case class 来创建 DataSet[Row] 类型

val personDF = sc.textFile("src/main/resources/general/people.txt") //personRDD

.map(x => x.split(",")) //Array[String] = Array(name, age)

.map(attr => Person(attr(0),attr(1).trim().toInt))

.toDF() - 或者用自定义 schema 的方式

val schemaString = "name,age"

val fields = schemaString.split(",").map(fieldName => StructField(fieldName, StringType, nullable = true))

val schema = StructType(fields) val personRDD = sc.textFile("src/main/resources/general/people.txt") //personRDD

val rowRDD = personRDD.map(_.split(",")).map(attr => Row(attr(0),attr(1).trim()))

val personDF = spark.createDataFrame(rowRDD,schema) 或者是调用 createOrReplaceTempView 方法来创建临时表运行 SQL

personDF.createOrReplaceTempView("people")

val sqlDF = spark.sql("SELECT * FROM people")

sqlDF.map(people => "Name: " + people(0)).show()

參考資料

资料来源来至 Spark 官方网站

[Spark SQL] SparkSession、DataFrame 和 DataSet 练习的更多相关文章

- spark结构化数据处理:Spark SQL、DataFrame和Dataset

本文讲解Spark的结构化数据处理,主要包括:Spark SQL.DataFrame.Dataset以及Spark SQL服务等相关内容.本文主要讲解Spark 1.6.x的结构化数据处理相关东东,但 ...

- Spark SQL、DataFrame和Dataset——转载

转载自: Spark SQL.DataFrame和Datase

- Spark学习之路(八)—— Spark SQL 之 DataFrame和Dataset

一.Spark SQL简介 Spark SQL是Spark中的一个子模块,主要用于操作结构化数据.它具有以下特点: 能够将SQL查询与Spark程序无缝混合,允许您使用SQL或DataFrame AP ...

- Spark 系列(八)—— Spark SQL 之 DataFrame 和 Dataset

一.Spark SQL简介 Spark SQL 是 Spark 中的一个子模块,主要用于操作结构化数据.它具有以下特点: 能够将 SQL 查询与 Spark 程序无缝混合,允许您使用 SQL 或 Da ...

- spark算子之DataFrame和DataSet

前言 传统的RDD相对于mapreduce和storm提供了丰富强大的算子.在spark慢慢步入DataFrame到DataSet的今天,在算子的类型基本不变的情况下,这两个数据集提供了更为强大的的功 ...

- Spark SQL 之 DataFrame

Spark SQL 之 DataFrame 转载请注明出处:http://www.cnblogs.com/BYRans/ 概述(Overview) Spark SQL是Spark的一个组件,用于结构化 ...

- 转】Spark SQL 之 DataFrame

原博文出自于: http://www.cnblogs.com/BYRans/p/5003029.html 感谢! Spark SQL 之 DataFrame 转载请注明出处:http://www.cn ...

- Spark RDD、DataFrame和DataSet的区别

版权声明:本文为博主原创文章,未经博主允许不得转载. 目录(?)[+] 转载请标明出处:小帆的帆的专栏 RDD 优点: 编译时类型安全 编译时就能检查出类型错误 面向对象的编程风格 直接通过类 ...

- Spark官方1 ---------Spark SQL和DataFrame指南(1.5.0)

概述 Spark SQL是用于结构化数据处理的Spark模块.它提供了一个称为DataFrames的编程抽象,也可以作为分布式SQL查询引擎. Spark SQL也可用于从现有的Hive安装中读取数据 ...

随机推荐

- Python爬虫(十四)_BeautifulSoup4 解析器

CSS选择器:BeautifulSoup4 和lxml一样,Beautiful Soup也是一个HTML/XML的解析器,主要的功能也是如何解析和提取HTML/XML数据. lxml只会局部遍历,而B ...

- HDU-1828-Picture(线段树)

Problem Description A number of rectangular posters, photographs and other pictures of the same shap ...

- 谈谈单元測试之(二):測试工具 JUnit 3

前言 上一篇文章<为什么要进行烦人的单元測试?>讨论了一下现阶段软件开发中,程序猿们測试情况的现状.这篇文章中,我打算介绍一下单元測试的工具(插件).而且推荐大家以后在开发中,真正的用上单 ...

- uva--10700

题意: 输入一串仅仅含有+和*号的表达式,能够通过加入括号来改变表达式的值,求表达式的最大最小值. 思路: 表达式中的数都是不大于20的正整数,由a*b+c<=a*(b+c)能够知道.先算乘法后 ...

- this问题

this问题 弹出层是一种很常见的页面显示部件,利用require js的模块化可以使部分功能组件重用性更高.以弹出层为例,探讨关于this的问题 首先来看这样一段代码 Html部分代码 <bo ...

- websocket简介

在我们做web项目的过程中,经常需要做的一个模块是消息模块.典型的场景:一个商城系统的后台管理,我想实现如果前台有客户下单,后台就会接到消息,以便尽快发货处理. 要实现上述的功能,我们有几种备选的方案 ...

- Java之路上,让我们Stand Up Again

在开始之前,先发表一下个人想法吧. 在读书的时候每天忙的不可开交,也就没有了所谓的自由,突然参加工作,传统的朝八晚五,标准的八小时工作制,每天都是两点一线,工作中涉及商业机密,公司的东西也不能带回家, ...

- Android查缺补漏(View篇)--自定义 View 的基本流程

View是Android很重要的一部分,常用的View有Button.TextView.EditView.ListView.GridView.各种layout等等,开发者通过对这些View的各种组合以 ...

- animate.css+wow.js页面滚动即时显示动画

1.地址引入 <link href="css/animate.min.css" rel="stylesheet" type="text/css& ...

- iOS 视频开发学习

原文:浅谈iOS视频开发 这段时间对视频开发进行了一些了解,在这里和大家分享一下我自己觉得学习步骤和资料,希望对那些对视频感兴趣的朋友有些帮助. 一.iOS系统自带播放器 要了解iOS视频开发,首先我 ...