Python 2.7_爬取CSDN单页面利用正则提取博客文章及url_20170114

年前有点忙,没来的及更博,最近看爬虫正则的部分 巩固下

1.爬取的单页面:http://blog.csdn.net/column/details/why-bug.html

2.过程 解析url获得网站源代码

3.找到文章标题列表和文章url(a标签下’href'属性)组成列表

4.for循环取出

#解析用到的还是urlllib urllib2两个模块 并加了个header请求表头

代码及过程如下:

#coding:utf-8

import re

import urllib

import urllib2 rooturl='http://blog.csdn.net/column/details/why-bug.html'

#urllib2.Request()方法 请求

req=urllib2.Request(rooturl)

req.add_header('User-Agent','Chrome')

req=urllib2.urlopen(req)

#req变量的read()方法获得源代码

html=req.read()

#分析文章标题和href属性

#标题和文章url都在a标签内 url格式为'http://blog.csdn.net/pleasecallmewhy/article/details/(****)',标题在'target="_blank">(****)</a>'

#写正则表达式 利用()小括号将url和标题分组

rs=r'<a href="(http://blog.csdn.net/pleasecallmewhy/article/details/.*?)" target="_blank">(.*?)</a>'

#利用正则findall(正则表达式rs,查找的范围) 现在及findall(rs,html)找到所有符合条件的元素并返回一个列表titlelist

titlelist=re.findall(rs,html)

#因为正则表达式是有2个分组 一个是文章url('href='以后括号的内容),一个是文章标题 这两个内容在titlelist里面是以元组形式构成的

#列表的长度就是页面有多少篇博客文章

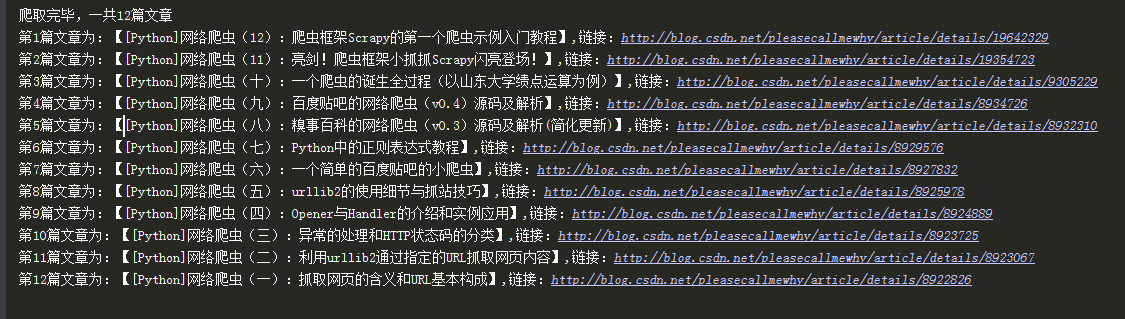

print '爬取完毕,一共%s篇文章' % len(titlelist)

#因为想实现打印出第几篇文章 文章标题 文章链接的效果 需要对titlelist进行遍历 用到的是列表list类的enumerate()方法 打印出列表索引和值

#第一个索引值为0 值为一个元组(文章url,文章标题) 这个元组又可以切片 因此取这个元组的第一个元素和第二个元素及实现效果

for i,j in enumerate(titlelist):

#i为titlelist列表的索引 j为titlelist列表的值

#取j的第一个元素j[0]即文章url 赋值给变量titurl 标题同样

titleurl=j[0]

titlename=j[1]

#打印效果 用%格式化输出 titlelist索引值从0开始因此对i+1 代表第一篇文章

print '第%s篇文章为:【%s】,链接:%s' %(i+1,titlename,titleurl)

Python 2.7_爬取CSDN单页面利用正则提取博客文章及url_20170114的更多相关文章

- Python 2.7_爬取CSDN单页面博客文章及url(二)_xpath提取_20170118

上次用的是正则匹配文章title 和文章url,因为最近在看Scrapy框架爬虫 需要了解xpath语法 学习了下拿这个例子练手 1.爬取的单页面还是这个rooturl:http://blog.csd ...

- [Python学习] 简单爬取CSDN下载资源信息

这是一篇Python爬取CSDN下载资源信息的样例,主要是通过urllib2获取CSDN某个人全部资源的资源URL.资源名称.下载次数.分数等信息.写这篇文章的原因是我想获取自己的资源全部的评论信息. ...

- python爬虫实例——爬取歌单

学习自<<从零开始学python网络爬虫>> 爬取酷狗歌单,保存入csv文件 直接上源代码:(含注释) import requests #用于请求网页获取网页数据 from b ...

- Python 2.7_爬取妹子图网站单页测试图片_20170114

1.url= http://www.mzitu.com/74100/x,2为1到23的值 2.用到模块 os 创建文件目录; re模块正则匹配目录名 图片下载地址; time模块 限制下载时间;req ...

- python使用bs4爬取boss静态页面

思路: 1.将需要查询城市列表,通过城市接口转换成相应的code码 2.遍历城市.职位生成url 3.通过url获取列表页面信息,遍历列表页面信息 4.再根据列表页面信息的job_link获取详情页面 ...

- 看我怎么扒掉CSDN首页的底裤(python selenium+phantomjs爬取CSDN首页内容)

这里只是学习一下动态加载页面内容的抓取,并不适用于所有的页面. 使用到的工具就是python selenium和phantomjs,另外调试的时候还用了firefox的geckodriver.exe. ...

- Python爬取CSDN博客文章

0 url :http://blog.csdn.net/youyou1543724847/article/details/52818339Redis一点基础的东西目录 1.基础底层数据结构 2.win ...

- 开发记录_自学Python写爬虫程序爬取csdn个人博客信息

每天刷开csdn的博客,看到一整个页面,其实对我而言,我只想看看访问量有没有上涨而已... 于是萌生了一个想法: 想写一个爬虫程序把csdn博客上边的访问量和评论数都爬下来. 打算通过网络各种搜集资料 ...

- 大神:python怎么爬取js的页面

大神:python怎么爬取js的页面 可以试试抓包看看它请求了哪些东西, 很多时候可以绕过网页直接请求后面的API 实在不行就上 selenium (selenium大法好) selenium和pha ...

随机推荐

- Hibernate学习---检索优化

Hibernate框架对检索进行了优化,前面我们将CURD的时候提到了load和get的区别,当时仅仅说了load为延迟加载,get为立即加载,当检索的记录为空的时候load报错(不是在执行load方 ...

- 【转】dmesg 时间转换

dmesg 时间转换 dmesg 输出的格式不易查看,可以通过命令进行转换. 记录如下: 时间查看: date -d "1970-01-01 UTC `echo "$(date + ...

- iOS UIScrollView 滚动到当前展示的视图居中展示

需求展示: 测试效果1 first uiscrollView 宽度 为屏幕宽度 滚动步长 为 scroll 宽度的1/3 分析: 这个是最普通版 无法使每一次滚动的结果子视图居中展示, WA ...

- Architecture Patterns

This chapter provides guidelines for using architecture patterns. Introduction Patterns for system a ...

- PMON使用手册

转:http://www.docin.com/p-1949877603.html

- P3794 签到题IV

题目 P3794 签到题IV 来切道水题放松一下吧 做法 或是单调不下降的,\(gcd\)是单调不上升的 \(a_i≤5×10^5\)分成权值不同的块数应该很小,所以随便乱搞就出来了 My compl ...

- 主攻ASP.NET.4.5 MVC4.0之重生:二维码生成和谷歌二维码

使用ThoughtWorks.QRCode.Codec 效果图 using ThoughtWorks.QRCode.Codec; 非原创代码 public void code(string id) { ...

- awk的输出格式控制:print 和printf

1.两个函数和若干个内部变量控制awk的输出格式: 两个函数:print和printf 内部变量:OFS:输出的列间隔符,默认为tab; ORS:输出的行间隔符,默认为\n printf更加自由化, ...

- MySQL之——提示"mysql deamon failed to start"错误的解决方法

网站突然连接不上数据库,于是直接重启了一下服务器.进到cli模式下,执行 service myqsld start 发现还是提示"mysql deamon failed to start&q ...

- ADO.Net连接Mysql

首先下载一个mysql.data.dll拷贝到bin下面并引用一下 using MySql.Data.MySqlClient; class Program { static void Main(str ...