Python 2.7_First_try_爬取阳光电影网_20161206

之前看过用Scrapy 框架建立项目爬取 网页解析时候用的Xpath进行解析的网页元素 这次尝试用select方法匹配元素

1、入口爬取页面 http://www.ygdy8.com/index.html

2、用到模块 requests(网页源码下载) BeautifulSoup4(网页解析)

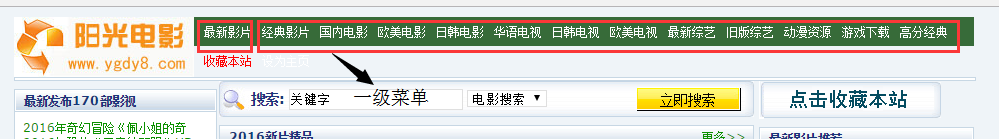

3、思路:首先由入口爬取页面进行获取网页上方栏目及对应url 如下图

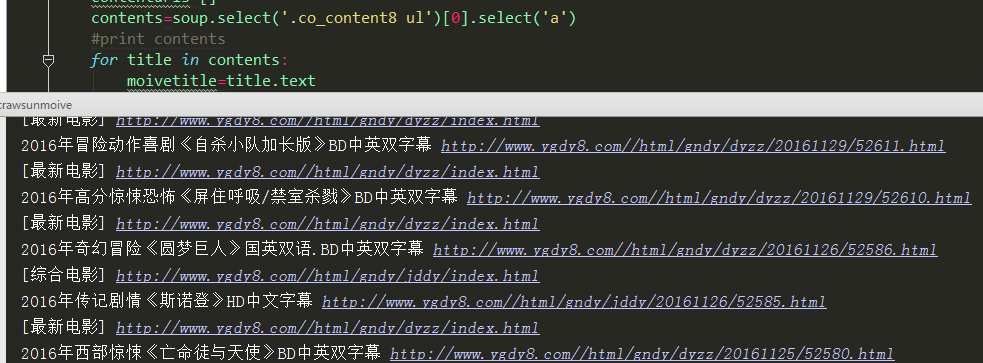

4、建立菜单url列表 for 循环再次进行解析 爬取每个一级菜单下的具体电影title 和url

5、问题:每个菜单下的url 进行再次解析后 由于网站内容不同 select 元素会出现非电影标题的连接和标题

6、python 代码

#coding:utf-8

import requests

from bs4 import BeautifulSoup as bs #爬取入口

rooturl="http://www.ygdy8.com/index.html"

#获取网页源码

res=requests.get(rooturl)

#网站编码gb2312

res.encoding='gb2312'

#网页源码

html=res.text

soup=bs(html,'html.parser')

cate_urls = []

for cateurl in soup.select('.contain ul li a'):

#网站分类标题

cate_name=cateurl.text

#分类url 进行再次爬取

cate_url="http://www.ygdy8.com/"+ cateurl['href']

cate_urls.append(cate_url)

print "网站一级菜单:",cate_name,"菜单网址:",cate_url

#每个菜单url 解析

for i in range(len(cate_urls)):

cate_listurl=cate_urls[i]

res = requests.get(cate_listurl)

res.encoding = 'gb2312'

html = res.text

soup = bs(html, 'html.parser')

print "正在解析第"+str(i+1)+"个链接",cate_urls[i]

contenturls=[]

contents=soup.select('.co_content8 ul')[0].select('a')

#print contents

for title in contents:

moivetitle=title.text

moiveurl=title['href']

contenturls.append(moiveurl)

print moivetitle,moiveurl

print contenturls

8、运行结果

Python 2.7_First_try_爬取阳光电影网_20161206的更多相关文章

- Python 2.7_Second_try_爬取阳光电影网_获取电影下载地址并写入文件 20161207

1.昨天文章http://www.cnblogs.com/Mr-Cxy/p/6139705.html 是获取电影网站主菜单 然后获取每个菜单下的电影url 2.今天是对电影url 进行再次解析获取下 ...

- scrapy爬取阳光电影网全站资源

说一下我的爬取过程吧 第一步: 当然是 scrapy startproject + 名字 新建爬虫项目 第二步: scrapy genspider -t crawl +爬虫名字+ 所爬取网站的 ...

- Python 3.6 爬取BD电影网

2018-07-10 #coding:utf-8 #coding:utf-8 from lxml import etree import requests import pandas import t ...

- 利用Python网络爬虫爬取学校官网十条标题

利用Python网络爬虫爬取学校官网十条标题 案例代码: # __author : "J" # date : 2018-03-06 # 导入需要用到的库文件 import urll ...

- 零基础Python爬虫实现(爬取最新电影排行)

提示:本学习来自Ehco前辈的文章, 经过实现得出的笔记. 目标网站 http://dianying.2345.com/top/ 网站结构 要爬的部分,在ul标签下(包括li标签), 大致来说迭代li ...

- python爬虫:爬取易迅网价格信息,并写入Mysql数据库

本程序涉及以下方面知识: 1.python链接mysql数据库:http://www.cnblogs.com/miranda-tang/p/5523431.html 2.爬取中文网站以及各种乱码处 ...

- 用python爬虫简单爬取 笔趣网:类“起点网”的小说

首先:文章用到的解析库介绍 BeautifulSoup: Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索.修改分析树等功能. 它是一个工具箱,通过解析文档为用户提供 ...

- Python爬虫项目--爬取猫眼电影Top100榜

本次抓取猫眼电影Top100榜所用到的知识点: 1. python requests库 2. 正则表达式 3. csv模块 4. 多进程 正文 目标站点分析 通过对目标站点的分析, 来确定网页结构, ...

- python实战项目 — 爬取 校花网图片

重点: 1. 指定路径创建文件夹,判断是否存在 2. 保存图片文件 # 获得校花网的地址,图片的链接 import re import requests import time import os ...

随机推荐

- Android关联源码support-v4,v7,v13源码(转)

在Android实际开发过程中往往会遇到使用v4,v7或v13兼容包中的一些类如ViewPager,Fragment等,但却无法关联源码. 在网上搜索之后,有很多办法,这里只向大家介绍一种,我用的觉得 ...

- 巧用TexturePacker命令行

游戏开发使用TexturePacker来生成图片的atlas sheet, 工具非常好用. 一般GUI的方法, 新建一个tps文件, 将要图片加载进来,调整参数和输出路径, 最后点publish. 在 ...

- 我的Java后端书架 (2016年暮春3.0版)

04月 24, 2016 | Filed under 技术 http://calvin1978.blogcn.com/articles/javabookshelf.html 书架主要针对Java后 ...

- Windows 下的 Sublime Text 2 配置汇总, Sublime Text 3 亦可借鉴

1)软件下载地址:http://www.sublimetext.com/2 2)安装 Package Control ,方便安装和管理插件,网络资源很多,这里附上一篇:http://www.imjef ...

- Python copy and deepcopy

Python中的对象之间赋值时是按引用传递的,如果需要拷贝对象,需要使用标准库中的copy模块. 1. copy.copy 浅拷贝 只拷贝父对象,不会拷贝对象的内部的子对象. 2. copy.deep ...

- urllib2.open(req).read() 报403的错误:怎么办?

http://www.douban.com/group/topic/18095751/ heads = {'Accept':'text/html,application/xhtml+xml,appli ...

- AndroidImagePicker 的使用

github地址 https://github.com/easonline/AndroidImagePicker 效果图

- SPRING + THYMELEAF 配置

1.使用的是Spring EL而不是Ognl.2.访问上下文的Bean用${@myBean.doSomething()}3.th:field,th:errors,th:errorclass用于form ...

- LeetCode "Integer Break"

A typical CS style DP based solution: class Solution(object): def __init__(self): self.hm = {} def i ...

- SVD分解的理解[转载]

http://www.bfcat.com/index.php/2012/03/svd-tutorial/ SVD分解(奇异值分解),本应是本科生就掌握的方法,然而却经常被忽视.实际上,SVD分解不但很 ...