在Centos7.6使用kubeadm部署k8s 1.14.3

K8s不是一个软件,而是一堆软件的集合,由于这堆软件各自独立,因此可能k8s安装过程很容易出现问题

K8s部署有多种方式,本文使用kubeadm部署,从易操作性和可控性来说属于中等的方式

环境:centos7.6,k8s 1.14.3

K8s安装前设置

以下操作在所有节点操作(也就是master1和node1)

关闭防火墙、selinux和swap,分别运行:

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

sed -i "s/^SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

swapoff -a

sed -i 's/.*swap.*/#&/' /etc/fstab

PS:生产环境在安装完k8s后要考虑网络安全(例如防火墙开启)的方案,本文没对此说明

配置内核参数,将桥接的IPv4流量传递到iptables的链,新建或修改文件/etc/sysctl.d/k8s.conf,文件内容如下:

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

运行sysctl --system

配置国内yum源,分别运行:

mkdir /etc/yum.repos.d/bak && mv /etc/yum.repos.d/*.repo /etc/yum.repos.d/bak

wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.cloud.tencent.com/repo/centos7_base.repo

wget -O /etc/yum.repos.d/epel.repo http://mirrors.cloud.tencent.com/repo/epel-7.repo

yum clean all && yum makecache

配置国内Kubernetes源,新建或修改文件/etc/yum.repos.d/kubernetes.repo,文件内容如下:

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

配置 docker 源,运行:

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

安装kubeadm、kubelet、kubectl

以下操作在所有节点操作(也就是master1和node1)

运行yum install -y kubelet-1.14.3 kubeadm-1.14.3 kubectl-1.14.3,安装k8s 3大组件。

其中,Kubelet负责与其他节点集群通信,并进行本节点Pod和容器生命周期的管理。Kubeadm是Kubernetes的自动化部署工具,降低了部署难度,提高效率。Kubectl是Kubernetes集群管理工具。

运行systemctl enable kubelet,设置kubelet开机运行

部署master节点

以下操作在master1做

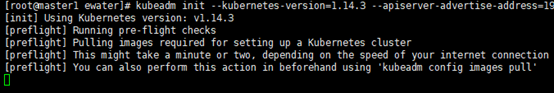

进行Kubernetes集群初始化,运行:

kubeadm init --kubernetes-version=1.14.3 --apiserver-advertise-address=192.168.31.141 --image-repository registry.aliyuncs.com/google_containers --service-cidr=10.1.0.0/16 --pod-network-cidr=10.244.0.0/16

其中kubernetes-version参数是k8s版本

apiserver-advertise-address是master节点的ip

pod-network-cidr是定义POD的网段(不用想这个网段是否存在,因为这是k8s的内部虚拟的网络)

PS:kubeadm init很容易出错,如果出错可以运行kubeadm reset重置,然后就可以重新kubeadm init

PS:这里会卡很久,请耐心等待

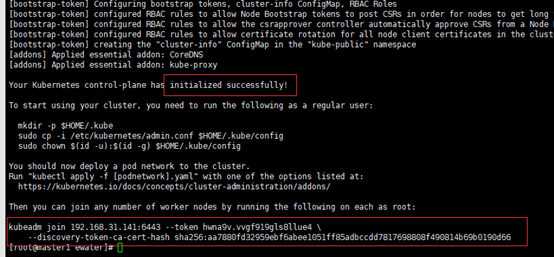

成功的样子,注意要把kubeadm join这段话拷出来,后面node加入集群会用到

配置kubectl工具,分别运行:

mkdir -p /root/.kube

cp /etc/kubernetes/admin.conf /root/.kube/config

然后运行kubectl get nodes可以查看到k8s集群的所有节点,可见有master节点

PS:在实际操作中发现,节点加入集群后,其status要等几分钟才变成ready(ready说明正常)

部署flannel网络,运行:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/a70459be0084506e4ec919aa1c114638878db11b/Documentation/kube-flannel.yml

部署node节点

以下操作在node1做

之前kubeadm init成功后有一段话要拷出来,现在可以运行他,这是让node加入集群

集群状态检测

以下操作在master1做

运行kubectl get nodes,可见node1已加到集群

PS:在实际操作中发现,节点加入集群后,其status要等几分钟才变成ready(ready说明正常)

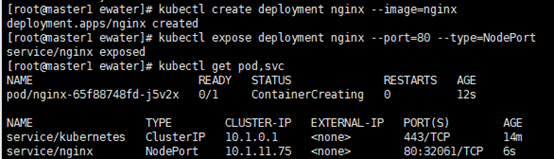

创建Pod(以nginx为例,注意这会占用80端口)以验证集群是否正常,分别运行:

PS:此操作不是必须,有信心的可以不做,避免多装东西

kubectl create deployment nginx --image=nginx

kubectl expose deployment nginx --port=80 --type=NodePort

kubectl get pod,svc

成功的样子

部署Dashboard

Dashboard是k8s自带的查看k8s集群运行信息的图形界面软件

PS:注意只可以查看而不能操作

以下操作在master1做

创建Dashboard的yaml文件,分别运行:

PS:其中的30001是Dashboard的端口

wget https://raw.githubusercontent.com/kubernetes/dashboard/v1.10.1/src/deploy/recommended/kubernetes-dashboard.yaml

sed -i 's/k8s.gcr.io/loveone/g' kubernetes-dashboard.yaml

sed -i '/targetPort:/a\ \ \ \ \ \ nodePort: 30001\n\ \ type: NodePort' kubernetes-dashboard.yaml

部署Dashboard,分别运行:

kubectl create -f kubernetes-dashboard.yaml

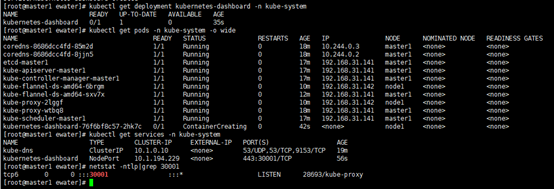

创建完成后,检查相关服务运行状态,分别运行:

kubectl get deployment kubernetes-dashboard -n kube-system

kubectl get pods -n kube-system -o wide

kubectl get services -n kube-system

netstat -ntlp|grep 30001

成功的样子

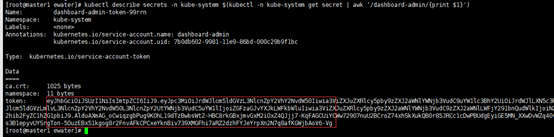

创建一个用于Dashboard的用户以及获取用户的令牌(token),分别运行:

kubectl create serviceaccount dashboard-admin -n kube-system

kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')

当运行最后一行,有输出token,注意token要保存好

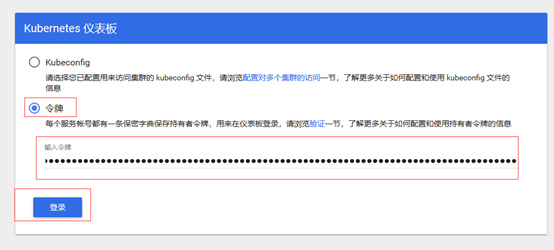

使用firefox(注意chrome和ie都不行)访问https://192.168.31.141:30001/(ip是master1的),中途有什么危险警告都点通过,直到下图

PS:令牌就是上面的token的值

看到下图说明Dashboard部署成功,也说明k8s部署成功

在Centos7.6使用kubeadm部署k8s 1.14.3的更多相关文章

- 使用kubeadm部署k8s集群[v1.18.0]

使用kubeadm部署k8s集群 环境 IP地址 主机名 节点 10.0.0.63 k8s-master1 master1 10.0.0.63 k8s-master2 master2 10.0.0.6 ...

- ubuntu18.04使用kubeadm部署k8s单节点

实验目的: 体验kubeadm部署k8s服务,全流程体验! 实验环境: ubuntu18.04 联网在线部署 kubeadm 01.系统检查 节点主机名唯一,建议写入/etc/hosts 禁止swap ...

- 使用kubeadm部署K8S v1.17.0集群

kubeadm部署K8S集群 安装前的准备 集群机器 172.22.34.34 K8S00 172.22.34.35 K8S01 172.22.34.36 K8S02 注意: 本文档中的 etcd . ...

- Kubeadm部署k8s单点master

Kubeadm部署k8s单点master 1.环境准备: 主机名 IP 说明 宿主机系统 master 10.0.0.17 Kubernetes集群的master节点 CentOS 7.9 node1 ...

- (二)Kubernetes kubeadm部署k8s集群

kubeadm介绍 kubeadm是Kubernetes项目自带的及集群构建工具,负责执行构建一个最小化的可用集群以及将其启动等的必要基本步骤,kubeadm是Kubernetes集群全生命周期的管理 ...

- kubeadm部署k8s集群

kubeadm是官方社区推出的一个用于快速部署kubernetes集群的工具. 这个工具能通过两条指令完成一个kubernetes集群的部署: # 创建一个 Master 节点 kubeadm ini ...

- kubeadm部署k8s

Kubernetes技术已经成为了原生云技术的事实标准,它是目前基础软件领域最为热门的分布式调度和管理平台.于是,Kubernetes也几乎成了时下开发工程师和运维工程师必备的技能之一. 官方文档 ...

- 【02】Kubernets:使用 kubeadm 部署 K8S 集群

写在前面的话 通过上一节,知道了 K8S 有 Master / Node 组成,但是具体怎么个组成法,就是这一节具体谈的内容.概念性的东西我们会尽量以实验的形式将其复现. 部署 K8S 集群 互联网常 ...

- 使用kubeadm部署k8s

k8s组件 master,node master中包括apiserver,scheduler,controller.etcd apiserver:负责接收用户请求,并且保存至etcd中. schedu ...

随机推荐

- 进度对话框QProgressDialog

继承于 QDialog import sys,time from PyQt5.QtWidgets import QApplication, QWidget,QPushButton,QProgress ...

- 关于Ubuntu 14.04 安装Oracle 11gR2安装步骤(从开始到放弃--最终使用docker获取)

最近在复习Oracle的相关内容,好准备在下一份工作中能够熟练一些,所以准备在自己虚拟机中安装Oracle的11gR2版本,主要参考内容为: https://blog.csdn.net/qq_4025 ...

- overload(重载) 和 override(重写)的区别

overload(重载): 重载是基于一个类中,方法名相同,参数列表不同(如果参数列表相同时,参数的类型要不同),与返回值和访问修饰符都无关 如果在面试中就直接说:"同名不同参" ...

- 支持向量机(四)----序列最小最优化算法SMO

在支持向量机(二)和(三)中,我们均遗留了一个问题未解决,即如何求解原问题的对偶问题: 在支持向量机(二)中对偶问题为: 在支持向量机(三)中的对偶问题为: 对于上述两个对偶问题,我们在支持向量机(三 ...

- CTO爆料:2019程序员最需要了解的行业前沿技术是什么?

安森,个推CTO 毕业于浙江大学,现全面负责个推技术选型.研发创新.运维管理等工作,已带领团队开发出针对移动互联网.金融风控等行业的多项前沿数据智能解决方案. 曾任MSN中国首席架构师,拥有十余年资深 ...

- CS2001 VS编译错误

Severity Code Description Project File Line Suppression State Error CS2001 Source file 'C:\Workspace ...

- win7不正常开关机,系统恢复选项

会win7不正常开关机后,会默认进入“系统回复选项”. 无人值守的机器远程会无法连接,默认会进入此界面. 解决方法: 到现场,鼠标.键盘.显示器, 开机后选择正常启动, 在命令行模式输入以下命令bcd ...

- 无法绕开的cut, awk, sed命令

linux命令的选项和选项后面的值的方式: 如果用 短选项, 选项值就放在短选项的后面, 如果用长选项, 值就用等于的方式. 最重要的是, 短选项后面的值, 跟短选项之间, 可以用空格, 也可以紧接着 ...

- thinkphp5.0学习笔记(二)API后台处理与命名空间

命名空间 先来看命名空间吧: 命名空间是学习TP的基础, <?php namespace app\lian\c1; class yi{ public $obj = "这是第一个空间里面 ...

- excel实现筛选去重操作

前情提要: 做图表时,希望更新数据后能自动化更新图表,需要各种公式之间相互配合.此时的需求是,将A表中的不同用户登录的地点做一个图表统计. 1.创建透视表 以用户id和地点当做行标签制作透视表,透视表 ...