Phoenix on HBase

- 嵌入式的JDBC驱动,实现了大部分的java.sql接口,包括元数据API

- 可以通过多部行键或是键/值单元对列进行建模

- 完善的查询支持,可以使用多个谓词以及优化的扫描键

- DDL支持:通过CREATE TABLE、DROP TABLE及ALTER TABLE来添加/删除列

- 版本化的模式仓库:当写入数据时,快照查询会使用恰当的模式

- DML支持:用于逐行插入的UPSERT VALUES、用于相同或不同表之间大量数据传输的UPSERT SELECT、用于删除行的DELETE

- 通过客户端的批处理实现的有限的事务支持

- 单表——还没有连接,同时二级索引也在开发当中

- 紧跟ANSI SQL标准,HIVE不完全支持SQL92,而Phoenix 接近ANSI SQL-2003

- Phoenix 2.x - HBase 0.94.x

- Phoenix 3.x - HBase 0.94.x

- Phoenix 4.x - HBase 0.98.1+

从Apache Phoenix 下载Phoenix二进制包安装,也可以从Apache或Github下载源码使用Maven编译,命令如下:

# mvn package -DskipTests -Dhadoop.profile=2

# mv $PHOENIX_HOME/phoenix-hadoop2-compat/target/phoenix-hadoop2-compat-4.0.0-incubating.jar /opt/cloudera/parcels/CDH/lib/hbase/lib/

hbase(main):001:0> list

create table test (mykey integer not null primary key, mycolumn varchar); upsert into test values (1,'Hello');

upsert into test values (2,'World!');

select * from test;

0: jdbc:phoenix:zk_host> !columns TEST

hbase(main):002:0> scan 'TEST'

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.sql.PreparedStatement;

import java.sql.Statement;

public class TestJava {

public static void main(String[] args) throws SQLException {

Statement stmt = null;

ResultSet rset = null;

Connection con = DriverManager.getConnection("jdbc:phoenix:[zk_host]"); // 已通过Shell建立 //stmt = con.createStatement();

//stmt.executeUpdate("create table test (mykey integer not null primary key, mycolumn varchar)");

//stmt.executeUpdate("upsert into test values (1,'Hello')");

//stmt.executeUpdate("upsert into test values (2,'World!')");

//con.commit(); PreparedStatement statement = con.prepareStatement("select * from test");

rset = statement.executeQuery(); while (rset.next()) {

System.out.println(rset.getString("mycolumn"));

} statement.close();

con.close();

}

}

# java -cp phoenix-assembly/target/phoenix-4.0.0-incubating-client.jar:. TestJava

# sudo -u hdfs hadoop fs -put examples/WEB_STAT.csv /user/phoenix/

phoenix> CREATE TABLE "t1" ( pk VARCHAR PRIMARY KEY, "cf".a VARCHAR, "cf".B VARCHAR, "cf".C VARCHAR );

phoenix> select * from "t1";

hbase> put 't1', 'row1', 'cf:B', 'value2'

hbase> put 't1', 'row1', 'cf:c', 'value3'

hbase> scan 't1'

1)在Phoenix中DDL/DML是忽略大小写的,而表名和列名是区分大小写的;

2)CREATE VIEW风险较小,但是readonly无法新增修改数据;

3)CREATE TABLE风险较大,一旦表结构与HBase原有表不一致,原表将会被新表覆盖,造成数据丢失;

4)映射表创建后,遗留数据无法查询,新增修改后的数据才可见

1.1)Mutable Index

CREATE TABLE my_table (k VARCHAR PRIMARY KEY, v1 VARCHAR, v2 BIGINT);

CREATE INDEX my_index ON my_table (v1);

CREATE INDEX my_index ON my_table (v1) INCLUDE (v2);

CREATE TABLE my_table (k VARCHAR PRIMARY KEY, v VARCHAR) IMMUTABLE_ROWS=true;

注意:只有当查询cloumns完全匹配索引时,基于索引的查询才能生效。例如:

create table usertable (id varchar primary key, firstname varchar, lastname varchar);

create index idx_name on usertable (firstname);

查询语句:

select id, firstname, lastname from usertable where firstname = 'foo';

由于索引只有firstname,而查询cloumns还包括了lastname,因此上述查询索引并未生效,可将索引调整如下:

create index idx_name on usertable (firstname) include (lastname);

3)Sequences

创建序列

CREATE SEQUENCE my_sequence START WITH -1000;

CREATE SEQUENCE my_sequence INCREMENT BY 10;

CREATE SEQUENCE my_schema.my_sequence START 0 CACHE 10;

插入数据

删除序列

DROP SEQUENCE my_sequence;

DROP SEQUENCE IF EXISTS my_schema.my_sequence;

4)Salted Tables

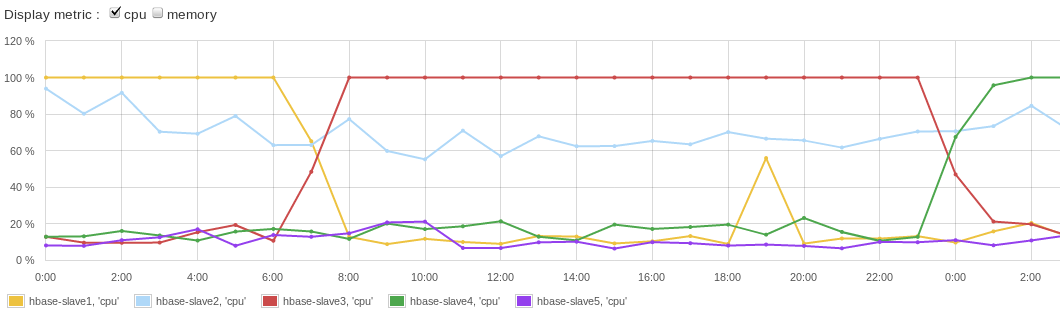

在使用连续的row key时,避免RegionServer出现Hotspotting是HBase使用过程中的通用问题。详细描述及解决方案参考http://blog.sematext.com/2012/04/09/hbasewd-avoid-regionserver-hotspotting-despite-writing-records-with-sequential-keys/。 其问题大致可描述为:HBase按照row key的字典序的形式存储记录,这可以非常快速的通过raw key定位数据,以及数据的startkey和endkey范围。在很多应用场景中,很多时候采用自增或自减的序列作为HBase的row key,比如001,002,003……或者499,498,…… 在这种情况下,下一个序列必须由当前序列和步长计算得出,那么如果Region由很多个RegionServer提供服务,这是没有问题的。但很显然在HBase的架构中,一个Region只有一个RegionServer提供服务。因此,当一个Region达到它预先设置的一个最大范围时,将分裂成为两个较小的Region,并由两个RegionServer接管,无论怎样分裂对Region的写入负载总是落在某一个RegionServer的主机上,若需要全局序列实现自增,显然就失去了集群负载均衡的作用,下图是一个负载情况:

找到了问题原因,那么解决方案就相对容易一下,例如可以salt row keys with a prefix,即为row key做一些添加剂,如增加前缀:

new_row_key = (++index % BUCKETS_NUMBER) + original_key

这里简单的根据数据的原始自增或自减的记录或者ID作为index,对需要分片的bucket去余进行划分,得到一个新的row key:

那么HBase集群相对之前的负载将会大有改善,如下图所示:

Phoenix中以Salted Table的方式支持上述接近方案,可以做如下定义,其中SALT_BUCKETS是1~256的自然数:

CREATE TABLE table (a_key VARCHAR PRIMARY KEY, a_col VARCHAR) SALT_BUCKETS = 20;

5)Configuration and Tuning

这里以bin/psql.py客户端脚本执行调优为例,修改$PHOENIX/phoenix-assembly/target目录下的phoenix-4.0.0-incubating-client.jar的hbase-default.xml文件,增加如下内容以实现将客户端默认缓存从100MB调整为1GB:

1024000000

Phoenix on HBase的更多相关文章

- [saiku] 使用 Apache Phoenix and HBase 结合 saiku 做大数据查询分析

saiku不仅可以对传统的RDBMS里面的数据做OLAP分析,还可以对Nosql数据库如Hbase做统计分析. 本文简单介绍下一个使用saiku去查询分析hbase数据的例子. 1.phoenix和h ...

- 浅谈Phoenix在HBase中的应用

一.前言 业务使用HBase已经有一段时间了,期间也反馈了很多问题,其中反馈最多的是HBase是否支持SQL查询和二级索引,由于HBase在这两块上目前暂不支持,导致业务在使用时无法更好的利用现有的经 ...

- 通过phoenix在hbase上创建二级索引,Secondary Indexing

环境描述: 操作系统版本:CentOS release 6.5 (Final) 内核版本:2.6.32-431.el6.x86_64 phoenix版本:phoenix-4.10.0 hbase版本: ...

- phoenix连接hbase数据库,创建二级索引报错:Error: org.apache.phoenix.exception.PhoenixIOException: Failed after attempts=36, exceptions: Tue Mar 06 10:32:02 CST 2018, null, java.net.SocketTimeoutException: callTimeou

v\:* {behavior:url(#default#VML);} o\:* {behavior:url(#default#VML);} w\:* {behavior:url(#default#VM ...

- Hadoop生态圈-phoenix(HBase)的索引配置

Hadoop生态圈-phoenix(HBase)的索引配置 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 创建索引是为了优化查询,我们可以在phoenix上配置索引方式. 一.修改 ...

- Phoenix 映射 HBase + Maven

声明 本文基于 Centos6.x + CDH5.x 什么是Phoenix Phoenix的团队用了一句话概括Phoenix:"We put the SQL back in NoSQL&qu ...

- phoenix到hbase的应用

一.phoenix的简介 hbase的java api或者其语法很难用,可以认为phoenix是一个中间件,提供了访问hbase的另外的语法. 二.配置phoenix和hbase 1.下载 phoen ...

- 关于phoenix构建hbase视图,更新hbase表后,视图表是否更新的验证

1:创建表 create 'MY_TABLE', 'CF1','CF2' 2:在hbase上插入一条数据 put ' ,'CF1:V1', 'uwo1' 3:在phoenix上创建视图 create ...

- 基于Phoenix对HBase建索引

参考: Phoenix与HBase集成进行数据分析 HBase查询速度慢原因排查 操作1,执行查询,如下: : jdbc:phoenix:node3::/hbase> SELECT * FROM ...

随机推荐

- 创建新的C++工程来调用Caffe对图片进行识别

前段时间一直在跑Caffe训练数据.之前用训练好的caffemodel对图片进行分类都是用的命令行指令,于是就想着自己新建一个工程来调用caffe,结合classification的代码来对图片进行分 ...

- mysql导出csv文件

SELECT * FROM (select 'id','url','大分类','分类','贴吧名称','关注用户数','帖子数量','简介','帖子名称','楼主ID','发表时间','采集时间',' ...

- 记录--前端 页面 jquery 被点击按钮修改样式 其他默认

jquery实现页面条件筛选 此功能类似淘宝的条件筛选,主要是页面样式的更改,问了大神也磨磨唧唧了很久才搞定0.0.... 先贴代码..... 代码知识有 border-radius 设置圆角边框 s ...

- x+=y与x=x+y有什么区别?

一般情况下,x+=y与x=x+y输出结果是等价的,因此两种写法是可以通用的,但是在某些临界值选用x+=y更加合适,比如: short n=3; n+=1;//编译通过 n=n+1;//编译失败 上述例 ...

- 老铁,这年头不会点git真不行

作者:武沛齐 出处:http://www.cnblogs.com/wupeiqi/ 版本控制 说到版本控制,脑海里总会浮现大学毕业是写毕业论文的场景,你电脑上的毕业论文一定出现过这番景象! 毕业论文_ ...

- python cookbook第三版学习笔记二十一:利用装饰器强制函数上的类型检查

在演示实际代码前,先说明我们的目标:能对函数参数类型进行断言,类似下面这样: @typeassert(int, int) ... def add(x, y): ... return x + y ...

- Mybatis中insert返回主键ID

记录解决的过程,这里就不搬砖了. 1.获取insert后的主键id 原文链接:http://www.cnblogs.com/fsjohnhuang/p/4078659.html 2.insert后返回 ...

- zabbix3.2.4监控MySQL5.7.16状态

一.添加监控用户mysql> grant all privileges on *.* to 'zabbix'@'localhost' identified by 'zabbix';mysql&g ...

- mysql-5.7.16-linux-glibc2.5-x86_64精简后的主从配置

1.创建复制账号,并授予复制权限CREATE USER 'fansik'@'10.%' IDENTIFIED BY 'fansik';GRANT REPLICATION SLAVE ON *.* TO ...

- Python traps and pitfalls

@1: >>> def func(a, L=[]): ... L.append(a) ... print(L) ... >>> func(10) [10] > ...