Hive实际应用小结

1.简介

Hive是数据仓库平台,构建在Hadoop之上用来处理结构化数据。Hive是一个SQL解析引擎,能够将SQL语句转化成MapReduce作业并在Hadoop上执行,从而使得查询和分析更加方便。

Hive是Facebook开发。2008年贡献给Apache,成为开源项目。

2.应用

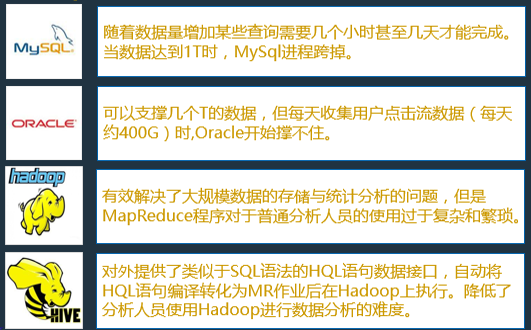

由上图可见,hive的诞生可以很降低开发人员运用mapreduce计算框架的门槛,通过熟悉的SQL语句来实现复杂的mapreduce代码的编写,从而降低开发难度提高开发效率。

Hive适用于海量结构化数据的离线分析,如果有需求是是需要统计计算大数据量而且对于时效性没有过高要求的情况下,建议采用Hive来做处理。不适用于复杂的机器学习算法,因为机器学习算法大多涉及大量的迭代计算,而hive默认情况下底层封装的计算框架是MapReduce,计算效率比较低下不适合复杂的计算,(Hive on Spark另议),因为底层的计算框架是mapreduce 所以也不适合交互式实时查询,有交互式实时查询建议使用Impala。

3.使用方法及技巧

1)使用hive -e 将SQL写入shell脚本进行调用,如进行一些数据的定时汇总。使用定时器进行shell脚本的调用,可以使用oozie或者crontab调用hive脚本

2)当多个SQL并发执行占用资源过多时,可以通过设置HiveQL语句的优先级来告诉yarn优先给那个MapReduce分配资源(HiveQL底层转化成MapReduce执行),使用语句 SET mapreduce.job.priority=HIGH;设定任务的优先级是高,总共有四个级别,此处不再赘述。

3)HiveQL书写时遇到Join语句,当尽量遵循先过滤后Join

4)避免使用in ,not in语句

5)当多表join时。应当选择合适的表作为主表。

4.建议使用方式

在项目做技术选型时,如果有大量结构化数据进行离线计算,可以采用Hive来做计算,原因如下:

1)既然是离线分析,就不会太在乎时效性,所以不必使用SparkSQL,impala这种消耗内存来更快计算的技术,当有需求是需要短时间内返回计算结果的,hive不适用。

2)对于结构化数据处理使用SQL代替繁琐的mapreduce代码省时省力。

3)支持udf,udaf,udtf。对于复杂逻辑可以写Java代码实现作为自定义函数去调用

个人在使用hive仍存在问题希望各位能够给予解答将不胜感激:

在使用hive与hbase表建立映射关系时,可以实现hive分区吗?如何实现?

Hive实际应用小结的更多相关文章

- 【Hive六】Hive调优小结

Hive调优 Hive调优 Fetch抓取 本地模式 表的优化 小表.大表Join 大表Join大表 MapJoin Group By Count(Distinct) 去重统计 行列过滤 动态分区调整 ...

- Hadoop Hive概念学习系列之hive的正则表达式初步(六)

说在前面的话 hive的正则表达式,是非常重要!作为大数据开发人员,用好hive,正则表达式,是必须品! Hive中的正则表达式还是很强大的.数据工作者平时也离不开正则表达式.对此,特意做了个hive ...

- 【Hadoop】HIVE 小结概览

一.HIVE概览小结 二.HIVE安装 Hive只在一个节点上安装即可 .上传tar包 .解压 tar -zxvf hive-.tar.gz -C /cloud/ .配置mysql metastore ...

- Hive - 建表和加载数据指令小结 以及使用Load data指令的注意事项

类似Mysql的数据库概念: hive> CREATE DATABASE cui; hive> USE cui; 创建表: CREATE TABLE test( first STRING, ...

- hive 内部表和外部表的区别和理解

1. 内部表 create table test (name string , age string) location '/input/table_data'; 注:hive默认创建的是内部表 此时 ...

- 【转】Hive的insert操作

insert 语法格式为: 1. 基本的插入语法: insert overwrite table tablename [partition(partcol1=val1,partclo2=val2)] ...

- hive中rcfile格式(收藏文)

首先声明,此文是属于纯粹收藏文,感觉讲的很不错. 本文介绍了Facebook公司数据分析系统中的RCFile存储结构,该结构集行存储和列存储的优点于一身,在MapReduce环境下的大规模数据分析中扮 ...

- Hive与HBase区别

对于刚接触大数据的用户来说,要想区分Hive与HBase是有一定难度的.本文将尝试从其各自的定义.特点.限制.应用场景等角度来进行分析,以作抛砖引玉之用. ====Hive是什么?Apache Hiv ...

- Hadoop、Pig、Hive、Storm、NOSQL 学习资源收集

(一)hadoop 相关安装部署 1.hadoop在windows cygwin下的部署: http://lib.open-open.com/view/1333428291655 http://blo ...

随机推荐

- Python 日志处理(一) 按Nginx log_format 分割日志记录

要求:不使用正则 根据nginx 默认的日志记录格式,分割日志记录. log_format main '$remote_addr - $remote_user [$time_local] " ...

- 泛型里的super和extend

<? extends T>和<? super T>应该怎么用? 网上看到一些比较难懂的回答,但是在EffectiveJava(2th Edition)遇到简单明了的解释: If ...

- SurfaceView 及相关概念

============================================================= SurfaceView=========================== ...

- Bootstrap-datepicker3官方文档中文翻译---概述(原版翻译 http://bootstrap-datepicker.readthedocs.io/en/latest/index.html)

bootstrap-datepicker Bootstrap-datepicker 提供了一个拥有Bootstrap样式的弹性Datepicker控件 Requirements/使用要求 Bootst ...

- WebVR认识

什么是WebVR WebVR是一种开放标准,可以在浏览器中体验VR,目标是让每个人都能轻松进入虚拟现实体验.

- Numpy入门 - 生成数组

今天是Numpy入门系列教程第一讲,首先是安装Numpy: $ pip install numpy numpy是高性能科学计算和数据分析的基础包,本节主要介绍生成连续二维数组.随机二维数组和自定义二维 ...

- AngularJS ng-repeat使用及注意事项

用法:ng-repeat="extension"; extension(表达式) 定义了如何循环集合. 表达式实例规则: 1. x in records 2. (key,value ...

- 洛谷教主花园dp

洛谷-教主的花园-动态规划 题目描述 教主有着一个环形的花园,他想在花园周围均匀地种上n棵树,但是教主花园的土壤很特别,每个位置适合种的树都不一样,一些树可能会因为不适合这个位置的土壤而损失观赏价 ...

- mysql 存储过程 小实例

咱们先建个表吧 [SQL] 纯文本查看 复制代码 ? 1 2 3 4 5 6 CREATE TABLE `test1` ( `id` int(10) unsigned NOT NULL A ...

- NavMesh--导航网格寻路

一.概述: NavMesh是3D游戏世界中用于实现动态物体自动寻路的一种技术,他将游戏场景中复杂的结构组织关系简化为带有一定信息的网格, 进而在这些网格的基础上通过一些列的计算来实现自动寻路. 二.简 ...