ShardingSphere-proxy-5.0.0分布式哈希取模分片实现(四)

一、说明

主要是对字符串的字段进行hash取模

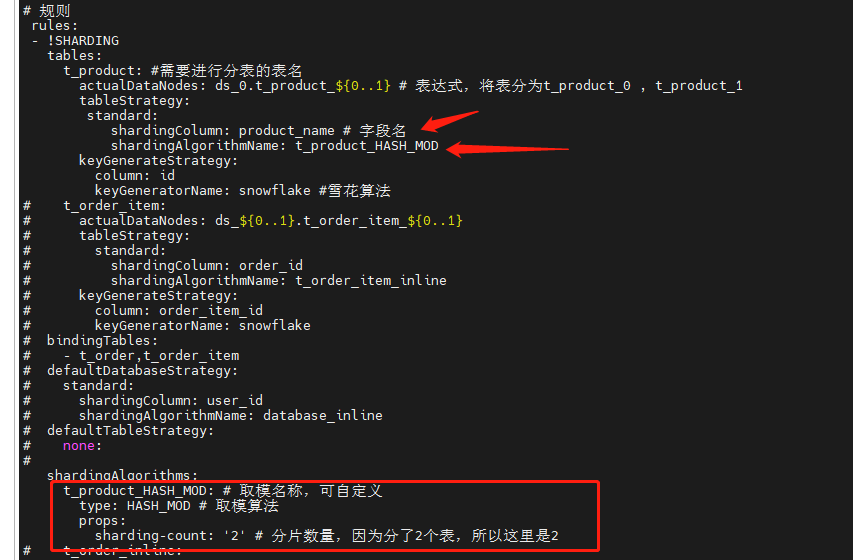

二、修改配置文件config-sharding.yaml,并重启服务

#

# Licensed to the Apache Software Foundation (ASF) under one or more

# contributor license agreements. See the NOTICE file distributed with

# this work for additional information regarding copyright ownership.

# The ASF licenses this file to You under the Apache License, Version 2.0

# (the "License"); you may not use this file except in compliance with

# the License. You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

# ######################################################################################################

#

# Here you can configure the rules for the proxy.

# This example is configuration of sharding rule.

#

######################################################################################################

#

#schemaName: sharding_db

#

#dataSources:

# ds_0:

# url: jdbc:postgresql://127.0.0.1:5432/demo_ds_0

# username: postgres

# password: postgres

# connectionTimeoutMilliseconds: 30000

# idleTimeoutMilliseconds: 60000

# maxLifetimeMilliseconds: 1800000

# maxPoolSize: 50

# minPoolSize: 1

# ds_1:

# url: jdbc:postgresql://127.0.0.1:5432/demo_ds_1

# username: postgres

# password: postgres

# connectionTimeoutMilliseconds: 30000

# idleTimeoutMilliseconds: 60000

# maxLifetimeMilliseconds: 1800000

# maxPoolSize: 50

# minPoolSize: 1

#

#rules:

#- !SHARDING

# tables:

# t_order:

# actualDataNodes: ds_${0..1}.t_order_${0..1}

# tableStrategy:

# standard:

# shardingColumn: order_id

# shardingAlgorithmName: t_order_inline

# keyGenerateStrategy:

# column: order_id

# keyGeneratorName: snowflake

# t_order_item:

# actualDataNodes: ds_${0..1}.t_order_item_${0..1}

# tableStrategy:

# standard:

# shardingColumn: order_id

# shardingAlgorithmName: t_order_item_inline

# keyGenerateStrategy:

# column: order_item_id

# keyGeneratorName: snowflake

# bindingTables:

# - t_order,t_order_item

# defaultDatabaseStrategy:

# standard:

# shardingColumn: user_id

# shardingAlgorithmName: database_inline

# defaultTableStrategy:

# none:

#

# shardingAlgorithms:

# database_inline:

# type: INLINE

# props:

# algorithm-expression: ds_${user_id % 2}

# t_order_inline:

# type: INLINE

# props:

# algorithm-expression: t_order_${order_id % 2}

# t_order_item_inline:

# type: INLINE

# props:

# algorithm-expression: t_order_item_${order_id % 2}

#

# keyGenerators:

# snowflake:

# type: SNOWFLAKE

# props:

# worker-id: 123 ######################################################################################################

#

# If you want to connect to MySQL, you should manually copy MySQL driver to lib directory.

#

###################################################################################################### # 连接mysql所使用的数据库名

schemaName: MyDb dataSources:

ds_0:

url: jdbc:mysql://127.0.0.1:3306/MyDb?serverTimezone=UTC&useSSL=false

username: root # 数据库用户名

password: mysql123 # 登录密码

connectionTimeoutMilliseconds: 30000

idleTimeoutMilliseconds: 60000

maxLifetimeMilliseconds: 1800000

maxPoolSize: 50

minPoolSize: 1

# ds_1:

# url: jdbc:mysql://127.0.0.1:3306/demo_ds_1?serverTimezone=UTC&useSSL=false

# username: root

# password:

# connectionTimeoutMilliseconds: 30000

# idleTimeoutMilliseconds: 60000

# maxLifetimeMilliseconds: 1800000

# maxPoolSize: 50

# minPoolSize: 1

#

# 规则

rules:

- !SHARDING

tables:

t_product: #需要进行分表的表名

actualDataNodes: ds_0.t_product_${0..1} # 表达式,将表分为t_product_0 , t_product_1

tableStrategy:

standard:

shardingColumn: product_name # 字段名

shardingAlgorithmName: t_product_HASH_MOD

keyGenerateStrategy:

column: id

keyGeneratorName: snowflake #雪花算法

# t_order_item:

# actualDataNodes: ds_${0..1}.t_order_item_${0..1}

# tableStrategy:

# standard:

# shardingColumn: order_id

# shardingAlgorithmName: t_order_item_inline

# keyGenerateStrategy:

# column: order_item_id

# keyGeneratorName: snowflake

# bindingTables:

# - t_order,t_order_item

# defaultDatabaseStrategy:

# standard:

# shardingColumn: user_id

# shardingAlgorithmName: database_inline

# defaultTableStrategy:

# none:

#

shardingAlgorithms:

t_product_HASH_MOD: # 取模名称,可自定义

type: HASH_MOD # 取模算法

props:

sharding-count: '2' # 分片数量,因为分了2个表,所以这里是2

# t_order_inline:

# type: INLINE

# props:

# algorithm-expression: t_order_${order_id % 2}

# t_order_item_inline:

# type: INLINE

# props:

# algorithm-expression: t_order_item_${order_id % 2}

#

keyGenerators:

snowflake: # 雪花算法名称,自定义名称

type: SNOWFLAKE

props:

worker-id: 123

三、数据准备

-- 创建表

SET NAMES utf8mb4;

SET FOREIGN_KEY_CHECKS = 0; -- ----------------------------

-- Table structure for t_product_0

-- ----------------------------

DROP TABLE IF EXISTS `t_product`;

CREATE TABLE `t_product_0` (

`id` varchar(225) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL,

`product_id` int(11) NOT NULL,

`product_name` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL,

PRIMARY KEY (`id`, `product_id`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8mb4 COLLATE = utf8mb4_general_ci ROW_FORMAT = Dynamic; SET FOREIGN_KEY_CHECKS = 1; -- 插入表数据

INSERT INTO t_product(product_id,product_name) VALUES(3,'apple');

INSERT INTO t_product(product_id,product_name) VALUES(2,'iphone');

四、查看数据

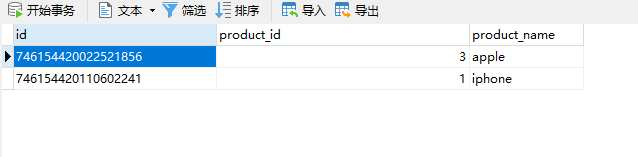

1、查看shardingsphere中间件t_product表数据

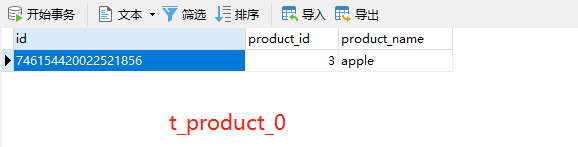

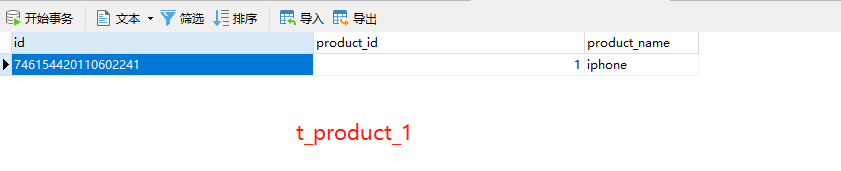

2、查看t_product_0、t_product_1表数据,同时对数据进行了分表存储(因为配置文件中有做分表配置)

ShardingSphere-proxy-5.0.0分布式哈希取模分片实现(四)的更多相关文章

- Memcached 之取模与哈希算法命中率实验

当5台memcache服务器中有一台宕机时的命中率实验. 一.php实现代码 1. config.php $server = array( "A" => array(&quo ...

- 重磅|Apache ShardingSphere 5.0.0 即将正式发布

Apache ShardingSphere 5.0.0 GA 版在经历 5.0.0-alpha 及 5.0.0-beta 接近两年时间的研发和打磨,终于将在 11 月份与大家正式见面! 11 月 10 ...

- Apache ShardingSphere 5.0.0 内核优化及升级指南

经过近两年时间的优化和打磨,Apache ShardingSphere 5.0.0 GA 版终于在本月正式发布,相比于 4.1.1 GA 版,5.0.0 GA 版在内核层面进行了大量的优化.首先,基于 ...

- ElasticJob 3.0.0:打造面向互联网生态和海量任务的分布式调度解决方案

ElasticJob 于 2020 年 5 月 28 日重启并成为 Apache ShardingSphere 子项目.新版本借鉴了 ShardingSphere 可拔插架构的设计理念,对内核进行了大 ...

- ShardingSphere-proxy-5.0.0分布式雪花ID生成(三)

一.目的 保证在分库分表中每条数据具有唯一性 二.修改配置文件config-sharding.yaml,并重启服务 # # Licensed to the Apache Software Founda ...

- Spark-1.0.0 standalone分布式安装教程

Spark目前支持多种分布式部署方式:一.Standalone Deploy Mode:二Amazon EC2.:三.Apache Mesos:四.Hadoop YARN.第一种方式是单独部署,不需要 ...

- Hadoop2.6.0完全分布式安装

本文地址:http://www.cnblogs.com/myresearch/p/hadoop-full-distributed-operation.html,转载请注明源地址. 我这边是使用了两台主 ...

- Hadoop上路-01_Hadoop2.3.0的分布式集群搭建

一.配置虚拟机软件 下载地址:https://www.virtualbox.org/wiki/downloads 1.虚拟机软件设定 1)进入全集设定 2)常规设定 2.Linux安装配置 1)名称类 ...

- 琐碎-hadoop2.2.0伪分布式和完全分布式安装(centos6.4)

环境是centos6.4-32,hadoop2.2.0 伪分布式文档:http://pan.baidu.com/s/1kTrAcWB 完全分布式文档:http://pan.baidu.com/s/1s ...

随机推荐

- 阿里云-部署-服务-Docker

目录 ♫ MusicPlayer Naiveboom - 比较安全 个人阿里云部署的小服务,欢迎使用,服务器资源有限,如果遇到卡顿还请谅解~ 索引: 在线音乐播放器 阅后即焚 ♫ MusicPlaye ...

- java数组算法——数组元素的赋值2

java数组算法--数组元素的赋值2--java经典面试题:创建一个长度为6的int型数组,要求数组元素的值都在1-30之间,且是随机赋值.同时要求元素时的值各不相同

- 解决帝国CMS搜索页面模板不支持灵动标签和万能标签的方法

1,打开 /e/search/result/index.php 文件 查找 require("../../class/connect.php"); require(".. ...

- 【Example】C++ STL 常用容器概述

前排提醒: 由于 Microsoft Docs 全是机翻.所以本文表格是我人脑补翻+审校. 如果有纰漏.模糊及时评论反馈. 序列式容器 序列容器是指在逻辑上以线性排列方式存储给定类型元素的容器. 这些 ...

- SpringMVC踩坑3——前后端传值问题

在前端页面点击修改,同时把需要修改的ID传到后端,后端根据ID去修改具体数据 这是前端代码 <a href="${pageContext.request.contextPath}/bo ...

- CF #781 (Div. 2), (C) Tree Infection

Problem - C - Codeforces Example input 5 7 1 1 1 2 2 4 5 5 5 1 4 2 1 3 3 1 6 1 1 1 1 1 output 4 4 2 ...

- Java语言学习day23--7月29日

今日内容介绍1.构造方法2.this关键字3.super关键字4.综合案例 ###01构造方法引入 * A:构造方法的引入 在开发中经常需要在创建对象的同时明确对象的属性值,比如员工入职公司就要明确他 ...

- K8S+Jenkins自动化构建微服务项目(后续)

因为之前写过基于K8S部署jenkins master/slave平台,在这个的基础上构建微服务到K8S集群中 Jenkins-slave构建微服务项目到K8S集群 1.微服务项目上传到git仓库 这 ...

- Docker极简入门:使用Docker-Compose 搭建redis集群

为了构建一个集群,我们首先要让 redis 启用集群模式 一个简单的配置文件如下redis.conf # redis.conf file port 6379 cluster-enabled yes c ...

- C#关于在返回值为Task方法中使用Thread.Sleep引发的思考

起因 最近有个小伙伴提出了一个问题,就是在使用.net core的BackgroundService的时候,对应的ExecuteAsync方法里面写如下代码,会使程序一直卡在当前方法,不会继续执行,代 ...