BeautifulSoup图片爬取

------------恢复内容开始------------

BeautifulSoup介绍:

简单来说,Beautiful Soup 是 python 的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup 提供一些简单的、python 式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。 Beautiful Soup 自动将输入文档转换为 Unicode 编码,输出文档转换为 utf-8 编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup 就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。 Beautiful Soup 已成为和 lxml、html6lib 一样出色的 python 解释器,为用户灵活地提供不同的解析策略或强劲的速度。

以下为爬取网页图片的例子:

爬取图片的网页地址:https://pic.netbian.com/4kdongman/

先创建一个requests的请求,然后使用BeautifulSoup的lxml HTML解析器去解析网页

url = 'https://pic.netbian.com/4kdongman/'

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36'

}

r = requests.get(url,headers=headers)

#设置编码为gbk,要不然会乱码

r.encoding='gbk'

#使用lxml解析器解析

soup = BeautifulSoup(r.text,'lxml')

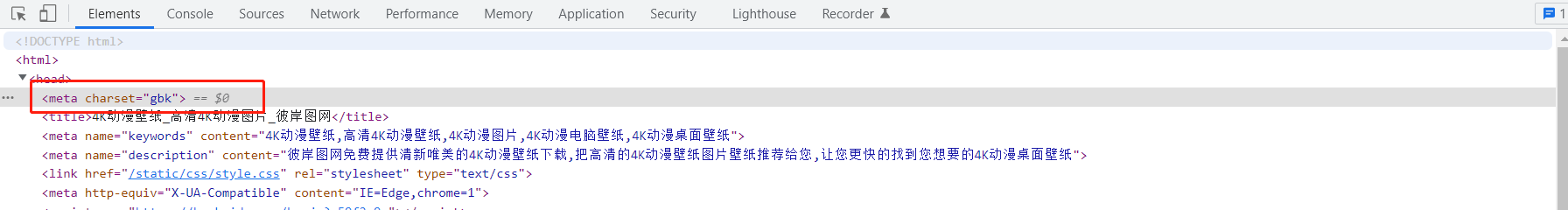

编码格式可以从网页html中看到

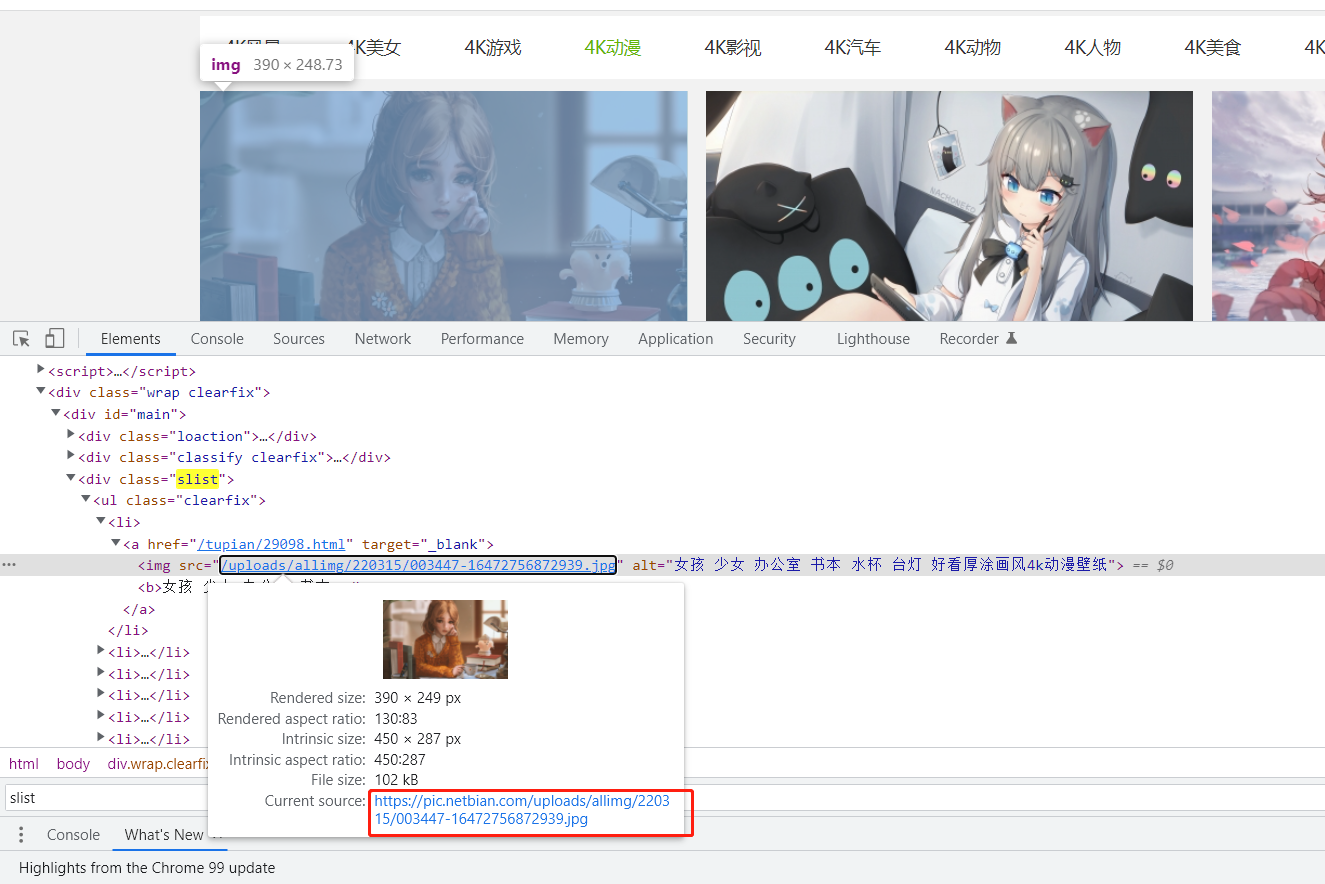

接下来可以先定位到所有图片的整体div,例如class=’slist‘这个div,然后再定位每张图片的img标签,提取相关数据,得到每张图片的url地址

#定位所有图片的整体div

all_list = soup.find_all(attrs={'class': 'slist'})

#定位所有的img标签

img_list = all_list[0].find_all('img')

#遍历每个img标签

for img in img_list:

img_url = img['src']

name = img['alt']

#拼接图片url地址

img_url = 'https://pic.netbian.com' + img_url

#图片名称

print(name)

#图片url

print(img_url)

获取到每张图片的url地址后,就可以直接将其下载下来

方法一:with open直接将图片用字节流写入保存

r_img = requests.get(img_url)

with open('./img/'+name+'.jpg','wb+') as f:

#content返回的是二进制数据,如果你是取文本,你可以使用r.txt,如果取图片和文件,则是r.content

f.write(r_img.content)

方法二:直接使用urllib.request.urlretrieve下载

#第一个参数为要下载文件的url,第二个参数为本地保存路径以及文件名的路径

urllib.request.urlretrieve(img_url,'./img/'+name+'.jpg')

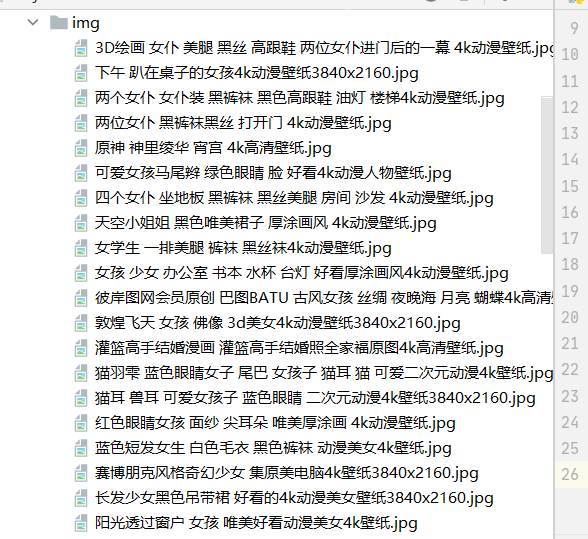

两种都可以实现,图片的下载,我保存的图片的地址为当前目录的img,从下面图片可以看到已经全部下载了

完整代码如下:

import urllib.request import requests

from bs4 import BeautifulSoup url = 'https://pic.netbian.com/4kdongman/'

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36'

}

r = requests.get(url,headers=headers)

#设置编码为gbk,要不然会乱码

r.encoding='gbk'

#使用lxml解析器解析

soup = BeautifulSoup(r.text,'lxml')

all_list = soup.find_all(attrs={'class': 'slist'})

img_list = all_list[0].find_all('img')

for img in img_list:

img_url = img['src']

name = img['alt']

img_url = 'https://pic.netbian.com' + img_url

print(name)

# r_img = requests.get(img_url)

# with open('./img/'+name+'.jpg','wb+') as f:

# f.write(r_img.content)

urllib.request.urlretrieve(img_url,'./img/'+name+'.jpg')

print('已经保存完成:'+img_url)

------------恢复内容结束------------

BeautifulSoup图片爬取的更多相关文章

- Python爬虫入门教程 26-100 知乎文章图片爬取器之二

1. 知乎文章图片爬取器之二博客背景 昨天写了知乎文章图片爬取器的一部分代码,针对知乎问题的答案json进行了数据抓取,博客中出现了部分写死的内容,今天把那部分信息调整完毕,并且将图片下载完善到代码中 ...

- 用BeautifulSoup简单爬取BOSS直聘网岗位

用BeautifulSoup简单爬取BOSS直聘网岗位 爬取python招聘 import requests from bs4 import BeautifulSoup def fun(path): ...

- 4k图片爬取+中文乱码

4k图片爬取+中文乱码 此案例有三种乱码解决方法,推荐第一种 4k图片爬取其实和普通图片爬取的过程是没有本质区别的 import requests import os from lxml import ...

- scrapy之360图片爬取

#今日目标 **scrapy之360图片爬取** 今天要爬取的是360美女图片,首先分析页面得知网页是动态加载,故需要先找到网页链接规律, 然后调用ImagesPipeline类实现图片爬取 *代码实 ...

- [Python_scrapy图片爬取下载]

welcome to myblog Dome地址 爬取某个车站的图片 item.py 中 1.申明item 的fields class PhotoItem(scrapy.Item): # define ...

- 爬虫07 /scrapy图片爬取、中间件、selenium在scrapy中的应用、CrawlSpider、分布式、增量式

爬虫07 /scrapy图片爬取.中间件.selenium在scrapy中的应用.CrawlSpider.分布式.增量式 目录 爬虫07 /scrapy图片爬取.中间件.selenium在scrapy ...

- python+BeautifulSoup+多进程爬取糗事百科图片

用到的库: import requests import os from bs4 import BeautifulSoup import time from multiprocessing impor ...

- 使用BeautifulSoup自动爬取微信公众号图片

爬取微信分享的图片,根据不同的页面自行修改,使用BeautifulSoup爬取,自行格局HTML修改要爬取图片的位置 import re import time import requests imp ...

- 网络爬虫之网站图片爬取-python实现

版本1.5 本次简单添加了四路多线程(由于我电脑CPU是四核的),速度飙升.本想试试xPath,但发现反倒是多此一举,故暂不使用 #-*- coding:utf-8 -*- import re,url ...

随机推荐

- File 类的 getPath()、getAbsolutePath()、getCanonicalPath() 的区别【转】

File 类的 getPath().getAbsolutePath().getCanonicalPath() 的区别 感谢大佬:https://blog.csdn.net/zsensei/articl ...

- sms短信网关对接

因为工作的需求,需要对接短信网关,业务上就是一个注册用户时,需要发送手机验证码;可能别的公司都是使用第三方接口,但是大点的公司,为了安全,他们都有自己的短信消息中心(SMSC) 1.业务需求 - 1. ...

- IOS开发之----常用函数和常数--秀清

介绍一下Objective-c常用的函数,常数变量 算术函数 [算术函数] 函数名 说明 int rand() 随机数生成.(例)srand(time(nil)); //随机数初期化int val = ...

- 关于synchronized(this)中this指的是什么意思

public class SynchronizedDEmo { public static void main(String[] args) { TestThread tt = new TestThr ...

- 【web安全】Nodejs原型链污染分析

Nodejs原型链污染分析 什么是js原型? 可以将js原型理解为其他OOP语言中的类,但还是有细微区别. 1. function F(){...} 2. var f = new F(); 分析: 1 ...

- 针对某p社游戏某整合包的研究

软件分析 垃圾re手 最近在玩群星 创意工坊里面下载了整合包 进群下载排序文件后竟然发现要付费() 28R够吃一顿好的 马上来分析一下这个软件 这是一个四版整合包的mod安装器 其中樱花远征和新星纪元 ...

- VC709E 基于FMC接口的FPGA XC7VX690T PCIeX8 接口卡

一.板卡概述 本板卡基于Xilinx公司的FPGA XC7VX690T-FFG1761 芯片,支持PCIeX8.两组 64bit DDR3容量8GByte,HPC的FMC连接器,板卡支持各种FMC子卡 ...

- Solution -「NOI 2018」「洛谷 P4768」归程

\(\mathcal{Description}\) Link. 给定一个 \(n\) 个点 \(m\) 条边的无向连通图,边形如 \((u,v,l,a)\).每次询问给出 \(u,p\),回答 ...

- 我来教你如何用Docker部署最近火爆的人生重开模拟器

文章目录 获取项目源码包 Dockerfile 构建docker镜像 启动docerk容器 访问liferestart 如果人生可以重来... <可惜没如果> github项目地址:htt ...

- MLHPC 2016 | Communication Quantization for Data-parallel Training of Deep Neural Networks

本文主要研究HPC上进行数据并行训练的可行性.作者首先在HPC上实现了两种通信量化算法(1 Bit SGD以及阈值量化),然后提出了自适应量化算法以解决它们的缺点.此外,发挥出量化算法的性能,作者还自 ...