在模仿中精进数据分析与可视化01——颗粒物浓度时空变化趋势(Mann–Kendall Test)

本文是在模仿中精进数据分析与可视化系列的第一期——颗粒物浓度时空变化趋势(Mann–Kendall Test),主要目的是参考其他作品模仿学习进而提高数据分析与可视化的能力,如果有问题和建议,欢迎在评论区指出。若有其他想要看的作品,也欢迎在评论区留言并给出相关信息。

所用数据和代码的下载地址如下:

链接:https://pan.baidu.com/s/1IixHE9aPf1u9qFkdAdHQaA

提取码:hmq2

复制这段内容后打开百度网盘手机App,操作更方便哦

简介

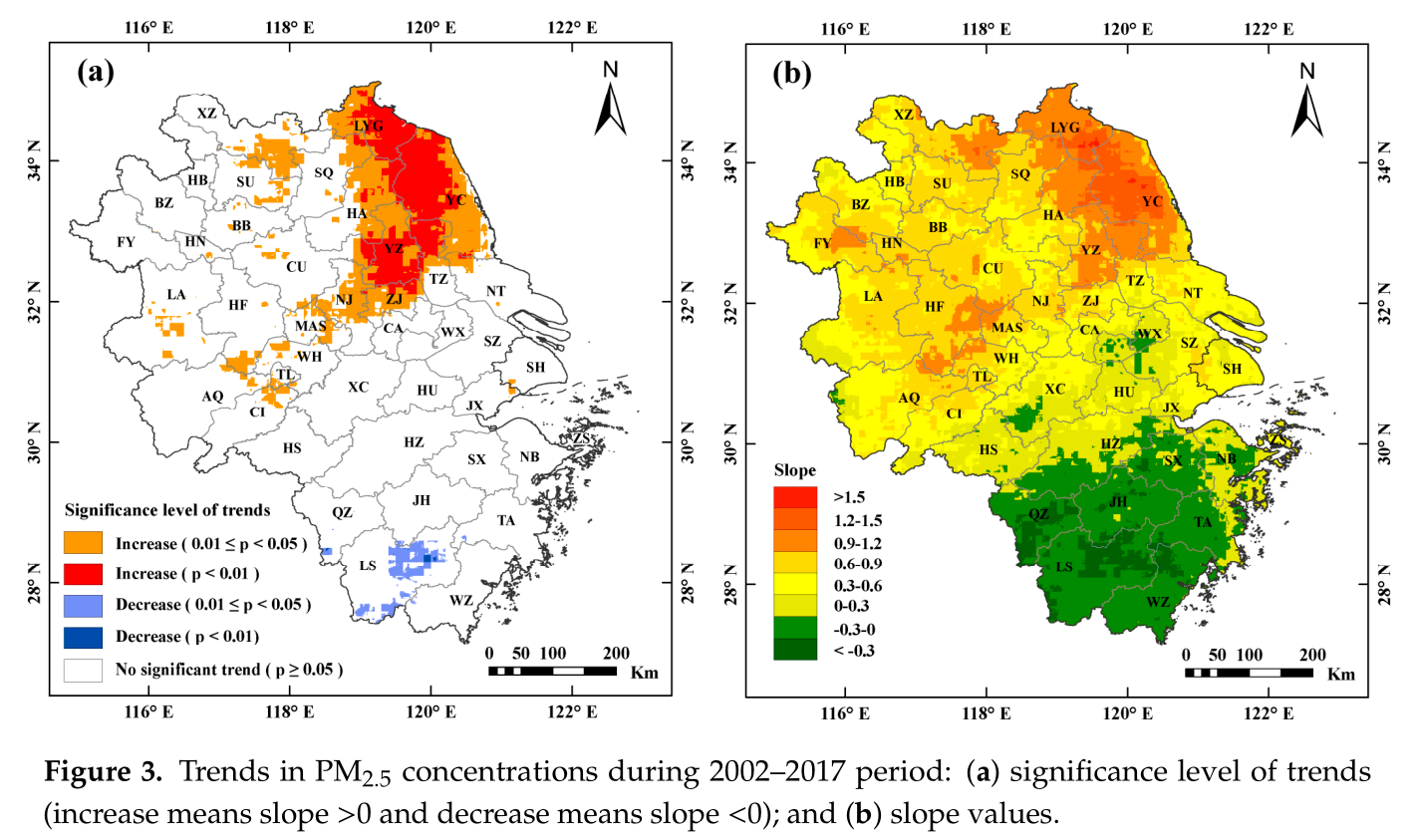

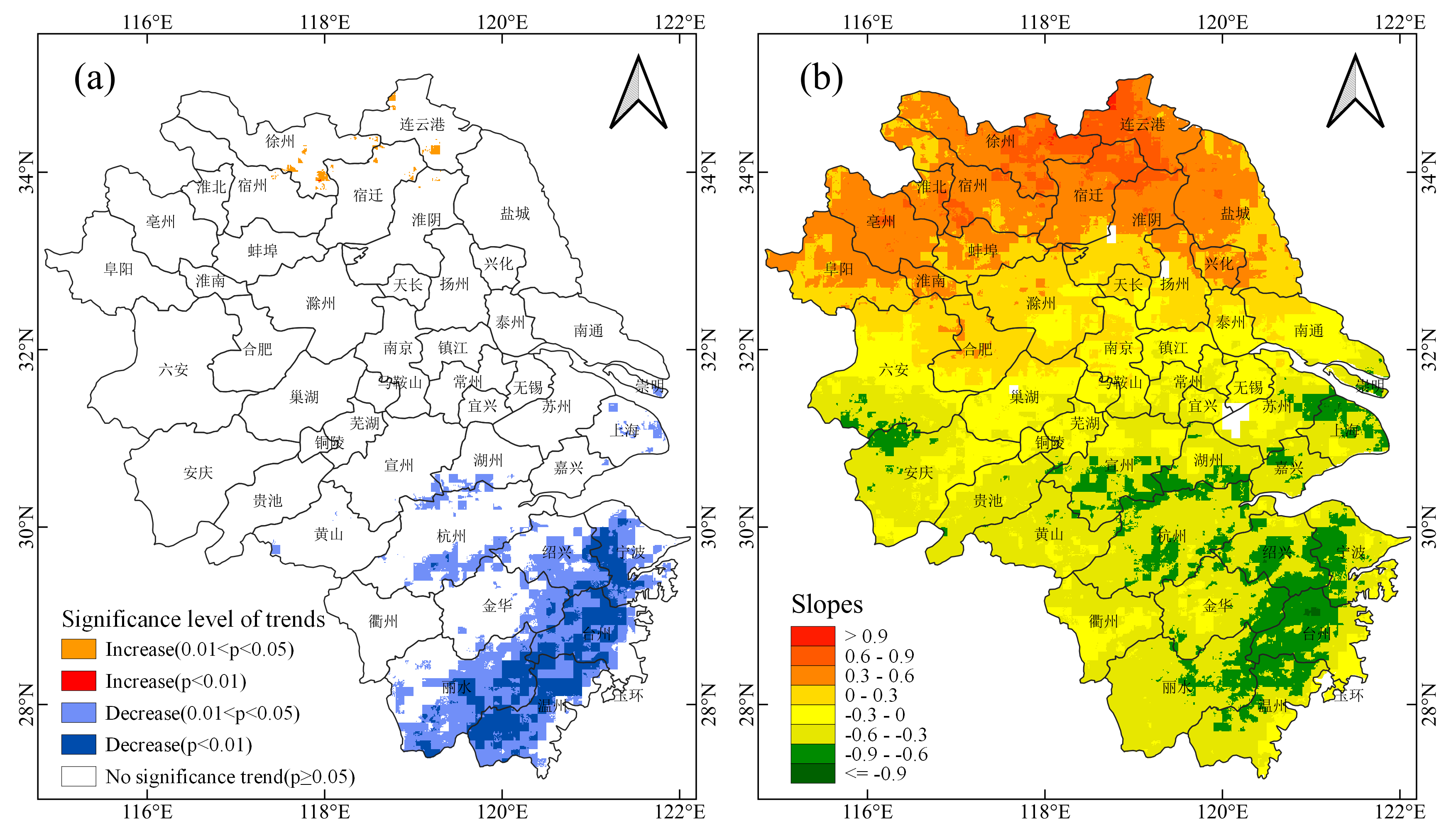

本次要模仿的作品来自论文Investigating the Impacts of Urbanization on PM2.5 Pollution in the Yangtze River Delta of China: A Spatial Panel Data Approach,研究区域为上海、安徽、浙江和江苏,所用数据为 2002–2017该区域PM2.5浓度栅格数据,数据来源于 Dalhousie University Atmospheric Composition Analysis Group开发的年均PM2.5数据集V4.CH.03,空间分辨率为0.01°×0.1°(原论文采用数据的空间分辨率为1km×1km,但我在该网站上找不到,可能是不提供下载了)。

数据下载和处理

数据下载格式为.asc,使用arcpy将其转为.tif格式,所用代码如下。

# -*- coding: utf-8 -*-

import arcpy

import os

inpath = "./ASCII" #待转换的栅格的存储路径,会转换该路径下的所有栅格

outpath = "./TIF" #输出栅格的路径,最好是空路径

filetype = "FLOAT"

print "Starting Convert!"

for filename in os.listdir(inpath):

if filename.endswith(".asc"):

filepath = os.path.join(inpath, filename)

outfilepath = os.path.join(outpath, filename.replace(".asc", ".tif"))

arcpy.ASCIIToRaster_conversion(filepath, outfilepath, filetype)

print "Convert Over!"

Mann–Kendall趋势分析

Mann–Kendall趋势分析的具体计算方法这里不再赘述,原文作者采用R语言的trend package计算的,本文采用python的pymannkendall计算,github项目地址为https://github.com/mmhs013/pyMannKendall。

原文的趋势分析包括两部分,一部分是计算slope值,slope值为正,则表明具有上升的趋势,反之亦然;另一部分是计算p值,p值越小趋势越显著,0.01<p<0.05说明趋势显著,p<0.01说明趋势非常显著。二者分别采用pymannkendall的sens_slope和original_test函数计算,pymannkendall的简单用法介绍如下。

A quick example of pyMannKendall usage is given below. Several more examples are provided here.

import numpy as np

import pymannkendall as mk

# Data generation for analysis

data = np.random.rand(360,1)

result = mk.original_test(data)

print(result)

Output are like this:

Mann_Kendall_Test(trend='no trend', h=False, p=0.9507221701045581, z=0.06179991635055463, Tau=0.0021974620860414733, s=142.0, var_s=5205500.0, slope=1.0353584906597959e-05, intercept=0.5232692553379981)

Whereas, the output is a named tuple, so you can call by name for specific result:

print(result.slope)

or, you can directly unpack your results like this:

trend, h, p, z, Tau, s, var_s, slope, intercept = mk.original_test(data)

计算并保存结果

这里依然使用arcpy作为分析计算的工具,所用代码如下。

pymannkendall较为臃肿,计算速度很慢(全部计算用了十几分钟),并且暂不支持numba加速,有需要大量计算的可根据其源码重新编写函数,实现numba加速,如本文的get_slope函数,在使用numba加速后计算pvalues仅需4秒,使用pymannkendall的sens_test则需要几分钟的时间。

# -*- coding: utf-8 -*-

import arcpy

import os

from glob import glob

import numpy as np

import pymannkendall as mk

inpath = r"./TIF" #.tif文件的保存路径

p_path = r"./pvalues.tif" #p-values的输出路径

slope_path = r"./slopes.tif" #slopes的输出路径

trend_path = r"./trends.tif" #原图左图中不同的趋势

border_path = r"./Shapefiles/border.shp" #研究区域

# 获取2002-2017年的栅格数据的路径

def get_raster_paths(inpath):

paths = []

for year in range(2002, 2018):

year_path = glob(os.path.join(inpath, "*"+str(year)+"*.tif"))

if year_path:

paths.append(year_path[0])

else:

print "can't find raster of {} year!".format(year)

return paths

# 裁剪栅格,并将结果转为numpy数组

def clip_raster_to_array(paths, border):

out_image = arcpy.sa.ExtractByMask(paths[0], border)

# 掩膜提取

x_cell_size, y_cell_size = out_image.meanCellWidth, out_image.meanCellHeight #x,y方向的像元大小

ExtentXmin, ExtentYmin = out_image.extent.XMin, out_image.extent.YMin #取x,y坐标最小值

lowerLeft = arcpy.Point(ExtentXmin, ExtentYmin) #取得数据起始点范围

noDataValue = out_image.noDataValue #取得数据的noData值

out_image = arcpy.RasterToNumPyArray(out_image) #将栅格转为numpy数组

out_image[out_image==noDataValue] = np.NAN #将数组中的noData值设为nan

arrays = np.full(shape=(len(paths), out_image.shape[0], out_image.shape[1]),

fill_value=np.NAN, dtype=out_image.dtype)

arrays[0] = out_image

for i in range(1, len(paths)):

out_image = arcpy.sa.ExtractByMask(paths[i], border)

out_image = arcpy.RasterToNumPyArray(out_image)

out_image[out_image==noDataValue] = np.NAN

arrays[i] = out_image

return arrays, (lowerLeft, x_cell_size, y_cell_size, noDataValue)

def array_to_raster(path, data, rasterInfo):

new_raster = arcpy.NumPyArrayToRaster(data, *rasterInfo) #数组转栅格

new_raster.save(path) #保存栅格

# 计算slope值

def get_slope(x):

if np.isnan(x).any():

return np.NAN

idx = 0

n = len(x)

d = np.ones(int(n*(n-1)/2))

for i in range(n-1):

j = np.arange(i+1,n)

d[idx : idx + len(j)] = (x[j] - x[i]) / (j - i)

idx = idx + len(j)

return np.median(d)

# 计算p值

def get_pvalue(x):

if np.isnan(x).any():

return np.NAN

result = mk.original_test(x)

return result.p

paths = get_raster_paths(inpath)

arrays, rasterinfo = clip_raster_to_array(paths, border_path)

print "clip raster to array over!"

slopes = np.apply_along_axis(get_slope, 0, arrays)

print "calculate p-value over!"

pvalues = np.apply_along_axis(get_pvalue, 0, arrays)

print "calculate slope over!"

#计算有显著和非常显著趋势的区域

trends = np.full(shape=slopes.shape, fill_value=np.NaN)

trends[~np.isnan(slopes)] = 0 #不显著的区域设为0

trends[(slopes>0) & ((0.01<pvalues) & (pvalues<0.05))] = 1 #比较显著增加的区域设为1

trends[(slopes>0) & (pvalues<0.01)] = 2 #显著增加的区域设为2

trends[(slopes<0) & ((0.01<pvalues) & (pvalues<0.05))] = 3 #比较显著减少的区域设为3

trends[(slopes<0) & (pvalues<0.01)] = 4 #显著减少的区域设为4

# 保存栅格

array_to_raster(p_path, pvalues, rasterinfo)

array_to_raster(slope_path, slopes, rasterinfo)

array_to_raster(trend_path, trends, rasterinfo)

print "save rasters over!"

结果绘图

由于QGIS软件打开和一些相关操作的速度都要比ArcGIS快的多,而且QGIS内置的取色器的功能也方便绘图时设置颜色,因此本文使用QGIS绘制结果图,如下图所示。

在模仿中精进数据分析与可视化01——颗粒物浓度时空变化趋势(Mann–Kendall Test)的更多相关文章

- (在模仿中精进数据可视化05)疫情期间市值增长top25公司

本文完整代码及数据已上传至我的Github仓库https://github.com/CNFeffery/FefferyViz 1 简介 新冠疫情对很多实体经济带来冲击的同时,也给很多公司带来了新的增长 ...

- (在模仿中精进数据可视化03)OD数据的特殊可视化方式

本文完整代码已上传至我的Github仓库https://github.com/CNFeffery/FefferyViz 1 简介 OD数据是交通.城市规划以及GIS等领域常见的一类数据,特点是每一条数 ...

- (数据科学学习手札78)基于geopandas的空间数据分析——基础可视化

本文对应代码和数据已上传至我的Github仓库https://github.com/CNFeffery/DataScienceStudyNotes 1 简介 通过前面的文章,我们已经对geopanda ...

- 数据分析 | 数据可视化图表,BI工具构建逻辑

本文源码:GitHub·点这里 || GitEE·点这里 一.数据可视化 1.基础概念 数据可视化,是关于数据视觉表现形式的科学技术研究.其中,这种数据的视觉表现形式被定义为,一种以某种概要形式抽取出 ...

- Cytoscape.js – 用于数据分析和可视化的交互图形库

Cytoscape.js 是一个开源的 JavaScript 图形库,您可以使用 Cytoscape.js 进行数据分析和可视化.Cytoscape.js 可以轻松的继承到你的网站或者 Web 应用 ...

- 2017 年 机器学习之数据挖据、数据分析,可视化,ML,DL,NLP等知识记录和总结

今天是2017年12月30日,2017年的年尾,2018年马上就要到了,回顾2017过的确实很快,不知不觉就到年末了,再次开篇对2016.2017年的学习数据挖掘,机器学习方面的知识做一个总结,对自己 ...

- python中利用matplotlib绘图可视化知识归纳

python中利用matplotlib绘图可视化知识归纳: (1)matplotlib图标正常显示中文 import matplotlib.pyplot as plt plt.rcParams['fo ...

- Simulink--MATLAB中的一种可视化仿真工具

Simulink是MATLAB中的一种可视化仿真工具, 是一种基于MATLAB的框图设计环境,是实现动态系统建模.仿真和分析的一个软件包,被广泛应用于线性系统.非线性系统.数字控制及数字信号处理的建 ...

- Pytorch在colab和kaggle中使用TensorBoard/TensorboardX可视化

在colab和kaggle内核的Jupyter notebook中如何可视化深度学习模型的参数对于我们分析模型具有很大的意义,相比tensorflow, pytorch缺乏一些的可视化生态包,但是幸好 ...

随机推荐

- HTTPS协议工作原理(SSL数字证书)

目录 HTTPS SSL协议的工作过程 SSL数字证书的查看 HTTPS 我们都知道HTTP协议是明文传输的,并且不能验证对方的身份,而且不能保证数据的完整性.而当我们在网络上进行购物电子交易时,电子 ...

- 【python】Leetcode每日一题-打家劫舍2

[python]Leetcode每日一题-打家劫舍2 [题目描述] 你是一个专业的小偷,计划偷窃沿街的房屋,每间房内都藏有一定的现金.这个地方所有的房屋都 围成一圈 ,这意味着第一个房屋和最后一个房屋 ...

- Mac FTP 安装与使用

安装ftp brew install telnet brew install inetutils brew link --overwrite inetutils 使用ftp 1. 登录 #方式一 $ ...

- Sublime 快捷生成HTML 插件安装

更多精彩关注公众号 1 安装 Package Control1.1 ctrl + ` 呼出控制台1.2 复制(不要带最外层的双引号,该代码仅适用于sublime text 3)"import ...

- TortoiseGit生成.PPK拓展名的密钥

在TortoiseGit 运行目录下找到puttygen.exe 工具 运行puttygen.exe genertate :代表动态生成新的内容 load :导入旧的密钥 save private k ...

- 『政善治』Postman工具 — 8、Postman中Pre-request Script的使用

目录 1.Pre-request Script介绍 2.常用SNIPPETS(片段)说明 (1)获取变量脚本: (2)设置变量脚本: (3)清空变量脚本: (4)Send a request代码片段 ...

- Java集合详解(一):全面理解Java集合

概述 Java所有集合类都在java.util包下,支持并发的集合在java.util.concurrent(juc)包下. 集合与数组区别: 数组大小是固定的,集合大小可以根据使用情况进行动态扩容. ...

- MongoDB·Windows下管理员密码重置解决方案

阅文时长 | 1.07分钟 字数统计 | 1730.4字符 主要内容 | 1.问题切入 2.详细步骤 3.声明与参考资料 『MongoDB·Windows下管理员密码重置解决方案』 编写人 | SCs ...

- JSX语法详解

一.基础1.JSX是什么JSX是一种像下面这样的语法: const element = <h1>Hello, world!</h1>;1它是一种JavaScript语法扩展,在 ...

- HUGO 创建属于自己的博客

Hugo 拥有超快的速度,强大的内容管理和强大的模板语言,使其非常适合各种静态网站.可以轻松安装在macOS,Linux,Windows等平台上,在开发过程中使用LiveReload可即时渲染更改 一 ...