Hadoop伪分布式模式安装

一.Hadoop介绍

Hadoop实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS。HDFS有高容错性的特点,并且设计用来部署在低廉的硬件上;而且它提供高吞吐量来访问应用程序的数据,适合那些有着超大数据集的应用程序。Hadoop的框架最核心的设计就是:HDFS和MapReduce,HDFS为海量的数据提供了存储,MapReduce为海量的数据提供了计算。

二.安装Hadoop

环境:Docker(17.04.0-ce)、镜像Ubuntu(16.04.3)、Hadoop(3.1.1)、JDK(1.8.0_144)

1.运行dockeer容器,指定IP

faramita2016@linux-l9e6:~> docker run -id --hostname lab-bd --net br0 --ip 10.0.0.3 ubuntu:ssh

2.在容器中执行,安装ssh、vim

root@lab-bd:~# apt-get update

root@lab-bd:~# apt-get install -y ssh vim

3.新建bigdata用户(作为hadoop用户)

root@lab-bd:~# useradd bigdata -m -g root -c /bin/bash

root@lab-bd:~# passwd bigdata

root@lab-bd:~# su - bigdata

4.解压Jdk和Hadoop

bigdata@lab-bd:~$ tar -xf jdk-8u144-linux-x64.tar.gz

bigdata@lab-bd:~$ tar -xf hadoop-3.1..tar.gz

5.编辑.bashrc文件,配置Java环境

export JAVA_HOME=/home/bigdata/jdk1..0_144

export PATH=$JAVA_HOME/bin:$PATH

6.激活Java环境变量

bigdata@lab-bd:~$ source .bashrc

7.编辑etc/hadoop/hadoop-env.sh文件,配置Java环境

export JAVA_HOME=/home/bigdata/jdk1..0_144

8.配置ssh免密登录

bigdata@lab-bd:~$ ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

bigdata@lab-bd:~$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

bigdata@lab-bd:~$ ssh localhost

9.编辑etc/hadoop/core-site.xml文件,添加如下配置

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

10.编辑etc/hadoop/hdfs-site.xml文件,添加如下配置

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

11.格式化文件系统

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs namenode -format

12.启动hdfs服务

bigdata@lab-bd:~$ hadoop-3.1./sbin/start-dfs.sh

13.浏览器访问http://10.0.0.3:9870

三.配置Yarn

1.创建bigdata用户默认文件夹

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -mkdir -p /user/bigdata

2.编辑etc/hadoop/mapred-site.xml文件,添加如下配置

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

</configuration>

3.编辑etc/hadoop/yarn-site.xml文件,添加如下配置

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

</configuration>

4.启动Yarn服务

bigdata@lab-bd:~$ hadoop-3.1./sbin/start-yarn.sh

5.浏览器访问http://10.0.0.3:8088

四.运行任务

1.创建hadoop任务输入文件夹

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -mkdir /user/bigdata/input

2.添加xml文件做为输入文本

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -put hadoop-3.1./etc/hadoop/*.xml /user/bigdata/input

3.执行单词统计示例任务,input输入文件夹,output输出文件夹(自动创建)

bigdata@lab-bd:~$ hadoop-3.1./bin/hadoop jar hadoop-3.1./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1..jar grep input output 'had[a-z.]+'

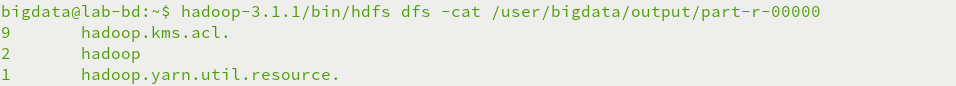

4.查看单词统计输出结果

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -cat /user/bigdata/output/part-r-

五.HDFS命令

1) ls 显示目录下的所有文件或者文件夹

示例: hdfs dfs –ls /

显示目录下的所有文件可以加 -R 选项

示例: hdfs dfs -ls -R /

2) cat 查看文件内容

示例: hdfs dfs -cat /user/bigdata/test.txt

3) mkdir 创建目录

示例: hdfs dfs –mkdir /user/bigdata/a

创建多级目录 加上 –p

示例: hdfs dfs –mkdir -p /user/bigdata/a/b/c

4) rm 删除目录或者文件

示例: hdfs dfs -rm /user/bigdata/test.txt

删除文件夹加上 -r

示例: hdfs dfs -rm -r /user/bigdata/a/b/c

5) put 将文件复制到hdfs系统中,

示例:hdfs dfs -put /tmp/test.txt /user/bigdata

6) cp 复制系统内文件

示例:hdfs dfs -cp /user/bigdata/test.txt /user/bigdata/a/

7) get 复制文件到本地系统

示例:hdfs dfs -get /user/bigdata/test.txt /tmp

8) mv 将文件从源路径移动到目标路径。

示例:hdfs dfs -mv /user/bigdata/a/test.txt /user/bigdata/b/test.txt

9) du 显示目录中所有文件的大小

示例: hdfs dfs -du /

显示当前目录或者文件夹的大小可加选项 -s

示例: hdfs dfs -du -s /user/bigdata

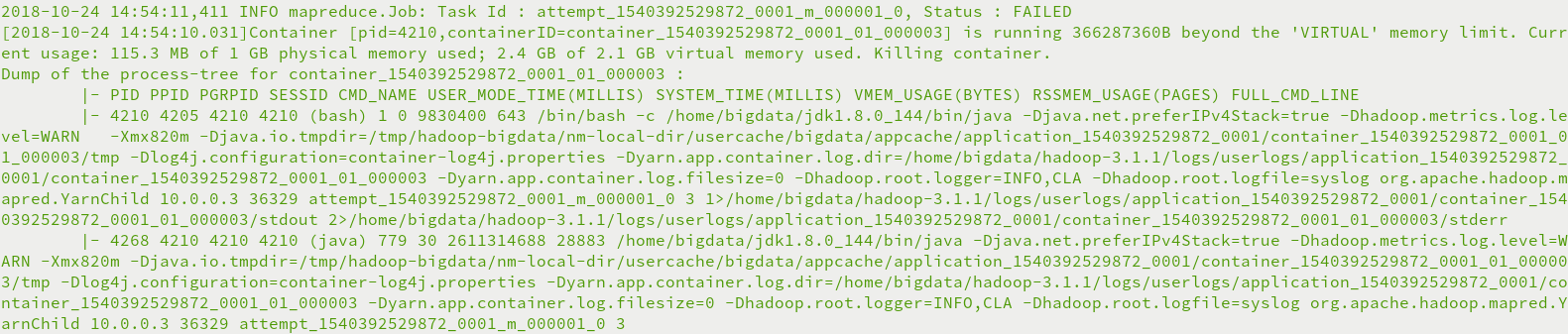

六.运行异常

running …… beyond the 'VIRTUAL' memory limit异常

虚拟内存分配不够,Yarn直接杀死进程,需要禁止内存检查

编辑etc/hadoop/yarn-site.xml文件,添加如下配置

<configuration>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

</configuration>

Hadoop伪分布式模式安装的更多相关文章

- 初学者值得拥有【Hadoop伪分布式模式安装部署】

目录 1.了解单机模式与伪分布模式有何区别 2.安装好单机模式的Hadoop 3.修改Hadoop配置文件---五个核心配置文件 (1)hadoop-env.sh 1.到hadoop目录中 2.修 ...

- VMware workstation 下Hadoop伪分布式模式安装

详细过程: 1.VMware安装: 2.centos 6 安装 3.jdk下载安装配置 4.Hadoop 安装配置 1.VMware Workstation 安装: https://www.vmwar ...

- Hadoop伪分布式模式部署

Hadoop的安装有三种执行模式: 单机模式(Local (Standalone) Mode):Hadoop的默认模式,0配置.Hadoop执行在一个Java进程中.使用本地文件系统.不使用HDFS, ...

- HBase入门基础教程之单机模式与伪分布式模式安装(转)

原文链接:HBase入门基础教程 在本篇文章中,我们将介绍Hbase的单机模式安装与伪分布式的安装方式,以及通过浏览器查看Hbase的用户界面.搭建HBase伪分布式环境的前提是我们已经搭建好了Had ...

- Hadoop伪分布式模式搭建

title: Hadoop伪分布式模式搭建 Quitters never win and winners never quit. 运行环境: Ubuntu18.10-server版镜像:ubuntu- ...

- Hadoop完全分布式模式安装部署

在Linux上搭建Hadoop系列:1.Hadoop环境搭建流程图2.搭建Hadoop单机模式3.搭建Hadoop伪分布式模式4.搭建Hadoop完全分布式模式 注:此教程皆是以范例讲述的,当然你可以 ...

- Hadoop Single Node Setup(hadoop本地模式和伪分布式模式安装-官方文档翻译 2.7.3)

Purpose(目标) This document describes how to set up and configure a single-node Hadoop installation so ...

- HBase入门基础教程 HBase之单机模式与伪分布式模式安装

在本篇文章中,我们将介绍Hbase的单机模式安装与伪分布式的安装方式,以及通过浏览器查看Hbase的用户界面.搭建HBase伪分布式环境的前提是我们已经搭建好了Hadoop完全分布式环境,搭建Hado ...

- 【HBase基础教程】1、HBase之单机模式与伪分布式模式安装(转)

在这篇blog中,我们将介绍Hbase的单机模式安装与伪分布式的安装方式,以及通过浏览器查看Hbase的用户界面.搭建hbase伪分布式环境的前提是我们已经搭建好了hadoop完全分布式环境,搭建ha ...

随机推荐

- mybatis_ The content of element type association must match (constructor,id,result,ass ociation,collection,discriminator)

一般遇到这种问题肯定要看一看association中元素编写顺序, <resultMap id="orderRslMap" type="orders"&g ...

- SpringMVC 的运行原理

0. 灵魂的拷问 问:SpringMVC 是什么?它有什么作用? 答:SpringMVC 的全称是 Spring Web Model-View-Controller,它是 Spring Fram ...

- Java编程思想__异常

1.使用异常链,需要采用如下方式包装捕获到的异常: public void two() { System.out.println("two()"); try { one(); } ...

- hihoCoder编程练习赛69

题目1 : 偶数长度回文子串 时间限制:5000ms 单点时限:1000ms 内存限制:256MB 描述 给定一个小写字母字符串,请判断它是否有长度为偶数的非空连续回文子串 输入 输入包含多组数据. ...

- 查询文章的上下篇Sql语句

直接开入正题 文章内容页一般都会有上一篇和下一篇的功能: 那么查询上下篇的sql语句应该怎么写呢:示例数据表:zmd_article自增主键:id当前文章id:10 肯定有人说,这简单啊id+1和id ...

- sass安装和语法

1.简介 sass 它的基本思想是,用一种专门的编程语言,进行网页样式设计,然后再编译成正常的CSS文件.这被叫做“css预处理器”(css preprocessor).它提供了很便利的语法,节省了我 ...

- K8S 部署 ingress-nginx (一) 原理及搭建

Kubernetes 暴露服务的有三种方式,分别为 LoadBlancer Service.NodePort Service.Ingress.官网对 Ingress 的定义为管理对外服务到集群内服务之 ...

- @RequestMapping 详解

RequestMapping是一个用来处理请求地址映射的注解,可用于类或方法上.用于类上,表示类中的所有响应请求的方法都是以该地址作为父路径.RequestMapping注解有六个属性,下面我们把她分 ...

- cordov vue项目中调用手机原生api

cordova不仅可以把vue项目打包成app,还可以让vue借助cordova调用手机原生的api 比如拍照 比如图片上传 比如定位 比如扫描二维码 比如支付等等 Vue Cordova教程-Vue ...

- 测者的测试技术笔记:Screenplay 模式(Journey 模式)

Screenplay模式 Junit的Screenplay 举例 Actor theReceptionist =newActor().with(WebBrowsing.ability()) theRe ...