idea配置pyspark

默认python已经配好,并已经导入idea,只剩下pyspark的安装

1、解压spark-2.1.0-bin-hadoop2.7放入磁盘目录

D:\spark-2.1.0-bin-hadoop2.7

2、将D:\spark-2.1.0-bin-hadoop2.7\python\pyspark拷贝到目录Python的Lib\site-packages

3、在idea中配置spark环境变量

(1)

(2)

(3)

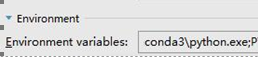

其中,需要配置的是SPARK_HOME。

如果系统中有多个版本的python,或者系统找不到python的位置,则需要配置PYSPARK_PYTHON ,我这里使用的是conda的python, E:\Program Files\Anaconda3\python.exe

(4) 安装py4j

pip install py4j

4、创建session需要注意的地方

from pyspark.sql import SparkSession

# appName中的内容不能有空格,否则报错

spark = SparkSession.builder.master("local[*]").appName("WordCount").getOrCreate() #获取上下文

sc = spark.sparkContext

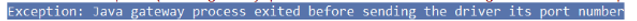

带有空格报错情况如下:

5、创建上下文,两种方式

#第一种

conf = SparkConf().setAppName('test').setMaster('local')

sc = SparkContext(conf=conf)

#第二种

sc=SparkContext('local','test')

6、实例(读取文件并打印)

from pyspark import SparkContext, SparkConf

conf = SparkConf().setAppName('test').setMaster('local')

sc = SparkContext(conf=conf)

rdd = sc.textFile('d:/scala/log.txt')

print(rdd.collect())

结果:

注意:还有一种错误如下所示

Java.util.NoSuchElementException: key not found: _PYSPARK_DRIVER_CALLBACK_HOST

这是因为版本的问题,可能pyspark的版本与spark不匹配

例如:

spark是2.1.0

所以当使用pip安装pyspark时需要带上版本号:

pip install pyspark==2.1.;

皆为2.1版本

idea配置pyspark的更多相关文章

- win10下Anaconda3在虚拟环境python_version=3.5.3 中配置pyspark

1. 序经过了一天的修炼,深深被恶心了,在虚拟环境中配置pyspark花式报错,由于本人实在是不想卸载3.6版的python,所以硬刚了一天,终于摸清了配置方法,并且配置成功,不抱怨了,开讲: 2. ...

- Anaconda中配置Pyspark的Spark开发环境

1.windows下载并安装Anaconda集成环境 URL:https://www.continuum.io/downloads 2.在控制台中测试ipython是否启动正常 3.安装JDK 3.1 ...

- 如何在windows下安装配置pyspark notebook

第一步:安装anaconda anaconda自带一系列科学计算包 下载链接:http://pan.baidu.com/s/1b4jWlg 密码:fqq3 接着配置环境变量:如我安装在D盘下 试一 ...

- (1)安装----anaconda3下配置pyspark【单机】

1.确保已经安装jdk和anaconda3.[我安装的jdk为1.8,anaconda的python为3.6] 2.安装spark,到官网 http://spark.apache.org/downlo ...

- pycharm中配置pyspark

1 下载官网spark-2.1.1-bin-hadoop2.7.tgz(版本自己选择),解压将文件放在了指定路径下,这个文件夹里面有python文件,python文件下还有两个压缩包py4j-some ...

- Ubuntu下导入PySpark到Shell和Pycharm中(未整理)

实习后面需要用到spark,虽然之前跟了edX的spark的课程以及用spark进行machine learning,但那个环境是官方已经搭建好的,但要在自己的系统里将PySpark导入shell(或 ...

- 大数据高可用集群环境安装与配置(09)——安装Spark高可用集群

1. 获取spark下载链接 登录官网:http://spark.apache.org/downloads.html 选择要下载的版本 2. 执行命令下载并安装 cd /usr/local/src/ ...

- Spark 的 python 编程环境

Spark 可以独立安装使用,也可以和 Hadoop 一起安装使用.在安装 Spark 之前,首先确保你的电脑上已经安装了 Java 8 或者更高的版本. Spark 安装 访问Spark 下载页面, ...

- windows下安装spark-python

首先需要安装Java 下载安装并配置Spark 从官方网站Download Apache Spark™下载相应版本的spark,因为spark是基于hadoop的,需要下载对应版本的hadoop才行, ...

随机推荐

- 安装社区版git仓库

1.打开http访问和ssh访问 sudo yum install -y curl policycoreutils-python openssh-server cronie sudo lokkit - ...

- 并发编程~~~多线程~~~线程queue, 事件event,

一 线程queue 多线程抢占资源,只能让其串行. 互斥锁 队列 import queue q = queue.Queue() # 先进先出 q = queue.LifoQueue() # 先进后出 ...

- linux系统的特殊符号

符号 作用 示例 # 注释符号,井号后的内容不会执行 echo #WORD ~ 当前用户的家目录 cd ~ ; 命令顺序执行,前面执行成功与否对后面没影响 COMMAND1 ; COMMAND2 &a ...

- MongoDB学习笔记(六、MongoDB复制集与分片)

目录: MongoDB部署模型 MongoDB可复制集 MongoDB读写分离 分片架构部署 最佳实践 MongoDB部署模型: 单机 -> 可复制集 -> 分片集群 MongoDB可复制 ...

- selenium-server-standalone下载网站

http://selenium-release.storage.googleapis.com/index.html

- Leetcode题解 - BFS部分题目代码+思路(896、690、111、559、993、102、103、127、433)

和树有关的题目求深度 -> 可以利用层序遍历 -> 用到层序遍历就想到使用BFS 896. 单调数列 - 水题 class Solution: def isMonotonic(self, ...

- ASP.NET Core 3.0 使用 gRPC无法编译问题

一.问题 创建了gRPC项目后,编译发现报错: 二.解决 1.检查项目路径是否存在中文 2.检查当前Windows用户目录是否为非英文字符,如果是则必须改为英文 修改方法: https://jingy ...

- Kubernetes的Job对象

Deployment.StatefulSet及DaemonSet三个主要用来进行长时间业务,不会退出. 而有一些离线业务,或者叫Batch Job(计算业务),计算完成后就直接退出 了,如果用Depl ...

- 松软科技web课堂:SQLServer之UCASE() 函数

UCASE() 函数 UCASE 函数把字段的值转换为大写. SQL UCASE() 语法 SELECT UCASE(column_name) FROM table_name SQL UCASE() ...

- 关于async function(){ let res = await } 详解

本文引自: https://www.jianshu.com/p/435a8b8cc7d3 async function fn(){ //表示异步,这个函数里面有异步任务 let result = aw ...