爬虫之scrapy框架应用selenium

一、利用selenium 爬取 网易军事新闻

使用流程:

'''

在scrapy中使用selenium的编码流程:

1.在spider的构造方法中创建一个浏览器对象(作为当前spider的一个属性)

2.重写spider的一个方法closed(self,spider),在该方法中执行浏览器关闭的操作

3.在下载中间件的process_response方法中,通过spider参数获取浏览器对象

4.在中间件的process_response中定制基于浏览器自动化的操作代码(获取动态加载出来的页面源码数据)

5.实例化一个响应对象,且将page_source返回的页面源码封装到该对象中

6.返回该新的响应对象

'''

首先需要在中间件导入

from scrapy.html import HtmlResponse

DownloadMiddleware函数

def process_response(self, request, response, spider):

# Called with the response returned from the downloader. # Must either;

# - return a Response object

# - return a Request object

# - or raise IgnoreRequest # 获取动态加载出来的数据

print("即将返回一个新的响应对象")

bw = spider.bw

bw.get(url = request.url)

import time

# 防止数据加载过慢

time.sleep(3)

# 包含了动态加载的数据

page_text = bw.page_source

time.sleep(3)

return HtmlResponse(url=spider.bw.current_url,body=page_text,

encoding="utf8",request=request)

spider.py

# -*- coding: utf-8 -*-

import scrapy

from selenium import webdriver class ScrapySeleniumSpider(scrapy.Spider):

name = 'scrapy_selenium'

# allowed_domains = ['www.xxx.com']

start_urls = ['http://war.163.com/']

def __init__(self):

self.bw = webdriver.Chrome(executable_path="F:\爬虫+数据\chromedriver.exe") def parse(self, response):

div_list = response.xpath('//div[@class="data_row news_article clearfix "]')

for div in div_list:

title = div.xpath('.//div[@class="news_title"]/h3/a/text()').extract_first()

print(title) def closed(self, spider):

print('关闭浏览器对象!')

self.bw.quit()

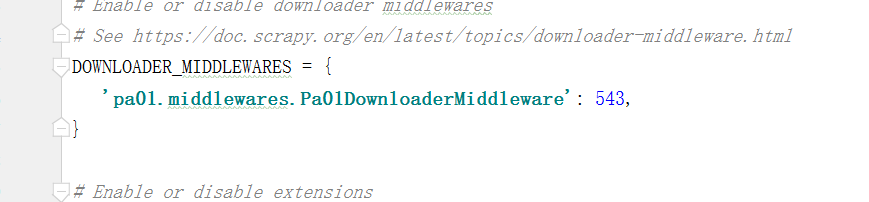

还需要注意的是使用中间件的同时需要在settings中解释一下Downloadmiddleware

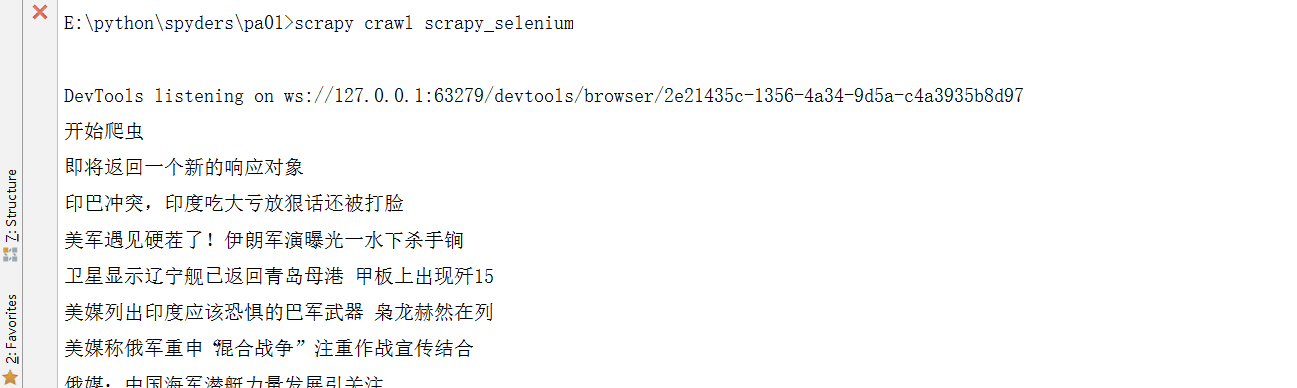

结果是这样就成功喽

爬虫之scrapy框架应用selenium的更多相关文章

- Python网络爬虫之Scrapy框架(CrawlSpider)

目录 Python网络爬虫之Scrapy框架(CrawlSpider) CrawlSpider使用 爬取糗事百科糗图板块的所有页码数据 Python网络爬虫之Scrapy框架(CrawlSpider) ...

- 爬虫06 /scrapy框架

爬虫06 /scrapy框架 目录 爬虫06 /scrapy框架 1. scrapy概述/安装 2. 基本使用 1. 创建工程 2. 数据分析 3. 持久化存储 3. 全栈数据的爬取 4. 五大核心组 ...

- Python逆向爬虫之scrapy框架,非常详细

爬虫系列目录 目录 Python逆向爬虫之scrapy框架,非常详细 一.爬虫入门 1.1 定义需求 1.2 需求分析 1.2.1 下载某个页面上所有的图片 1.2.2 分页 1.2.3 进行下载图片 ...

- 爬虫之scrapy框架

解析 Scrapy解释 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中.其最初是为了页面抓取 (更确切来说, 网络抓 ...

- Python爬虫进阶(Scrapy框架爬虫)

准备工作: 配置环境问题什么的我昨天已经写了,那么今天直接安装三个库 首先第一步: ...

- 爬虫之Scrapy框架介绍

Scrapy介绍 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内 ...

- 16.Python网络爬虫之Scrapy框架(CrawlSpider)

引入 提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法). 方法 ...

- python爬虫随笔-scrapy框架(1)——scrapy框架的安装和结构介绍

scrapy框架简介 Scrapy,Python开发的一个快速.高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据.Scrapy用途广泛,可以用于数据挖掘.监测和自动化测试 ...

- 5、爬虫之scrapy框架

一 scrapy框架简介 1 介绍 Scrapy一个开源和协作的框架,其最初是为了页面抓取 (更确切来说, 网络抓取 )所设计的,使用它可以以快速.简单.可扩展的方式从网站中提取所需的数据.但目前Sc ...

随机推荐

- node excel export包导致find函数被覆盖

这个包确实是巨坑:https://github.com/functionscope/Node-Excel-Export 本来是想用来导出Excel的,没想到把Array的find函数能乱了.这种基础函 ...

- iOS——学习网址收集

1 一个比系统自带的终端好用的软件:http://www.iterm2.com 2 学习和遇到技术问题可以去的网站: CocoaChina http://developer.cocoachi ...

- 递归下降和LL(1)语法分析

什么是自顶向下分析法 在语法分析过程中一般有两种语法分析方法,自顶向下和自底向上,递归下降分析和LL(1)都属于是自顶向下的语法分析 自顶向下分析法的过程就像从第一个非终结符作为根节点开始根据产生式进 ...

- c# socket 心跳 重连

/// <summary> /// 检查一个Socket是否可连接 /// </summary> /// <param name="socket"&g ...

- 【Python】解决使用pyinstaller打包Tkinker程序报错问题

问题描述 使用pyinstaller打包使用Tkinter编写的控制台程序,出现报错 15793 INFO: Adding Microsoft.Windows.Common-Controls to d ...

- 【idea】全局搜索、替换只显示100条的问题

没有修改之前 修改之后 如果用的是idea默认的快捷键,按Ctrl+Shift+A,然后输入Registry 如果是eclipse的快捷键

- SQL Server MERGE(合并)语句

如何使用SQL Server MERGE语句基于与另一个表匹配的值来更新表中的数据. SQL Server MERGE语句 假设有两个表,分别称为源表和目标表,并且需要根据与源表匹配的值来更新目标表 ...

- Ng-Alain-mock 运用

Ng-Alain Ng-Alian 是基于 Antd 实现的一个前端框架.它基于 Angular 和 NG-ZORRO,在此基础上进行进一步封装,是中后台的前端解决方案,为我们提供更多通用性业务模块, ...

- 更改ubuntu桌面环境

1.修改桌面环境 update-alternatives --config x-session-manager 2.卸载某一种ppa源下面的软件 sudo apt-get install ppa-pu ...

- MyBatis参数条件查询传入的值为0时的判断

MyBatis条件查询对字段判断是否为空一般为: <if test="testValue!=null and testValue != ''"> and test_va ...