spark rdd Transformation和Action 剖析

1.看到 这篇总结的这么好, 就悄悄的转过来,供学习

wordcount.toDebugString查看RDD的继承链条

所以广义的讲,对任何函数进行某一项操作都可以认为是一个算子,甚至包括求幂次,开方都可以认为是一个算子,只是有的算子我们用了一个符号来代替他所要进行的运算罢了,所以大家看到算子就不要纠结,他和f(x)的f没区别,它甚至和加减乘除的基本运算符号都没有区别,只是他可以对单对象操作罢了(有的符号比如大于、小于号要对多对象操作)。又比如取概率P{X<x},概率是集合{X<x}(他是属于实数集的子集)对[0,1]区间的一个映射,我们知道实数域和[0,1]区间是可以一一映射的(这个后面再说),所以取概率符号P,我们认为也是一个算子,和微分,积分算子算子没区别。

总而言之,算子就是映射,就是关系,就是**变换**!

**mapPartitions(f)**

f函数的输入输出都是每个分区集合的迭代器Iterator

def mapPartitions[U](f: (Iterator[T]) => Iterator[U], preservesPartitioning: Boolean = false)(implicit arg0: ClassTag[U]): RDD[U]

该函数和map函数类似,只不过映射函数的参数由RDD中的每一个元素变成了RDD中每一个分区的迭代器。如果在映射的过程中需要频繁创建额外的对象,使用mapPartitions要比map高效的过。

比如,将RDD中的所有数据通过JDBC连接写入数据库,如果使用map函数,可能要为每一个元素都创建一个connection,这样开销很大,如果使用mapPartitions,那么只需要针对每一个分区建立一个connection。

参数preservesPartitioning表示是否保留父RDD的partitioner分区信息。

参考文章:

http://lxw1234.com/archives/2015/07/348.htm

union(other: RDD[T])操作不去重,去重需要distinct()

subtract取两个RDD中非公共的元素

sample返回RDD,takeSample直接返回数组(数组里面的元素为RDD中元素,类似于collect)

keyvalue之类的操作都在**PairRDDFunctions.scala**中

mapValues只对value进行运算

groupBy相同key的元素的value组成集合

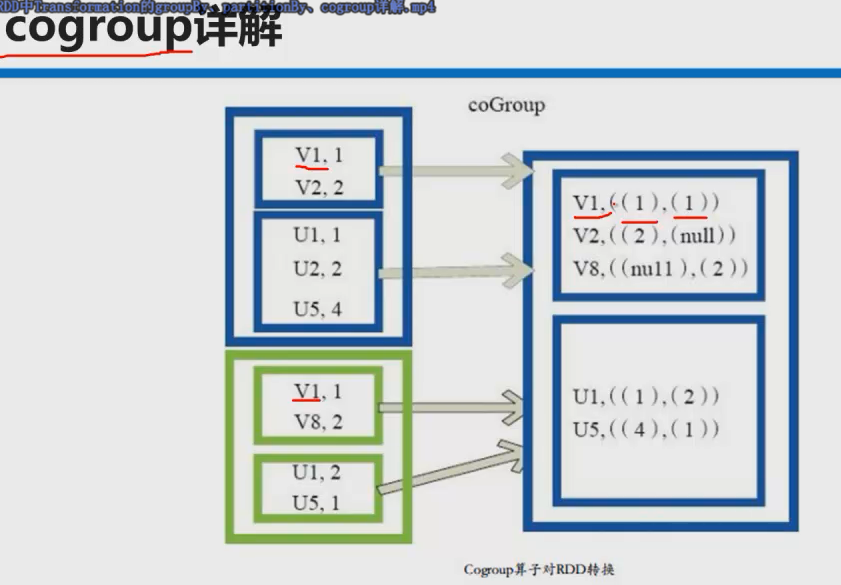

coGroup是在groupBy的基础上

coGroup操作多个RDD,是两个RDD里相同key的两个value集合组成的元组

参考文章:

http://www.iteblog.com/archives/1280

**combineByKey和reduceByKey,groupByKey(内部都是通过combineByKey)**

源码分析:

reduceByKey mapSideCombine: Boolean = true

groupByKey mapSideCombine=false

所以优先使用reduceByKey,参考文章:http://www.iteblog.com/archives/1357

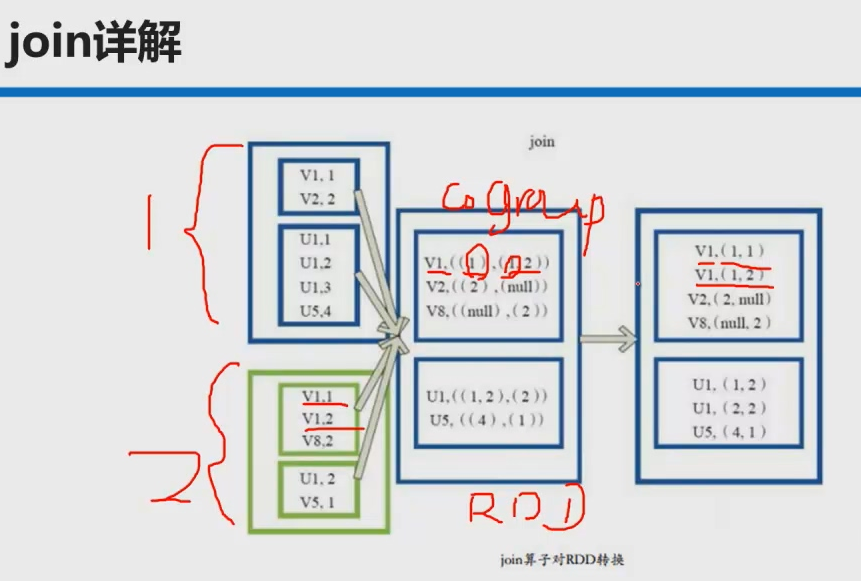

**join操作**

本质是先coGroup再笛卡尔积

def join[W](other: RDD[(K, W)], partitioner: Partitioner): RDD[(K, (V, W))] = {

this.cogroup(other, partitioner).flatMapValues( pair =>

for (v <- pair._1.iterator; w <- pair._2.iterator) yield (v, w)

)

}

**yield** 关键字的简短总结:

针对每一次 for 循环的迭代, yield 会产生一个值,被循环记录下来 (内部实现上,像是一个缓冲区).

当循环结束后, 会返回所有 yield 的值组成的集合.

返回集合的类型与被遍历的集合类型是一致的.

参考文章:

http://unmi.cc/scala-yield-samples-for-loop/

cache persist也是lazy级别的

Action本质sc.runJob

foreach

collect()相当于toArray返回一个数组

collectAsMap()对keyvalue类型的RDD操作返回一个HashMap,key重复后面的元素会覆盖前面的元素reduce

源码解析:先调用collect()再放到HashMap[K, V]中

def collectAsMap(): Map[K, V] = {

val data = self.collect()

val map = new mutable.HashMap[K, V]

map.sizeHint(data.length)

data.foreach { pair => map.put(pair._1, pair._2) }

map

}

**reduceByKeyLocally**相当于reduceByKey+collectAsMap()

该函数将RDD[K,V]中每个K对应的V值根据映射函数来运算,运算结果映射到一个Map[K,V]中,而不是RDD[K,V]。

参考文章:

http://lxw1234.com/archives/2015/07/360.htm

**lookup**也是针对keyvalue返回指定key对应的value形成的seq

def lookup(key: K): Seq[V]

**reduce fold(每个分区是串行,有个初始值) aggregate(并行,与fold类似)**

前两个元素作用的结果与第三元素作用依次类推

**SequenceFile**文件是Hadoop用来存储二进制形式的key-value对而设计的一种平面文件(Flat File)。目前,也有不少人在该文件的基础之上提出了一些HDFS中小文件存储的解决方案,他们的基本思路就是将小文件进行合并成一个大文件,同时对这些小文件的位置信息构建索引。不过,这类解决方案还涉及到Hadoop的另一种文件格式——**MapFile**文件。SequenceFile文件并不保证其存储的key-value数据是按照key的某个顺序存储的,同时不支持append操作。

参考文章:http://blog.csdn.net/xhh198781/article/details/7693358

**saveAsTextFile**->TextOutputFormat (key为null,value为元素toString)

**saveAsObjectFile**(二进制)->saveAsSequenceFile->SequenceFileOutputFormat(key为null,value为BytesWritable)

cache\persist

**checkpoint()**机制避免缓存丢失(内存不足)要重新计算带来的性能开销,会导致另外一个作业,比缓存更可靠

SparkContex.setCheckpointDir设置目录位置

spark rdd Transformation和Action 剖析的更多相关文章

- spark RDD transformation与action函数整理

1.创建RDD val lines = sc.parallelize(List("pandas","i like pandas")) 2.加载本地文件到RDD ...

- Spark RDD Transformation 简单用例(三)

cache和persist 将RDD数据进行存储,persist(newLevel: StorageLevel)设置了存储级别,cache()和persist()是相同的,存储级别为MEMORY_ON ...

- Spark(四)Spark之Transformation和Action

Transformation算子 基本的初始化 java static SparkConf conf = null; static JavaSparkContext sc = null; static ...

- Spark RDD Transformation 简单用例(二)

aggregateByKey(zeroValue)(seqOp, combOp, [numTasks]) aggregateByKey(zeroValue)(seqOp, combOp, [numTa ...

- Spark RDD Transformation 简单用例(一)

map(func) /** * Return a new RDD by applying a function to all elements of this RDD. */ def map[U: C ...

- Spark RDD/Core 编程 API入门系列 之rdd实战(rdd基本操作实战及transformation和action流程图)(源码)(三)

本博文的主要内容是: 1.rdd基本操作实战 2.transformation和action流程图 3.典型的transformation和action RDD有3种操作: 1. Trandform ...

- Spark学习笔记之RDD中的Transformation和Action函数

总算可以开始写第一篇技术博客了,就从学习Spark开始吧.之前阅读了很多关于Spark的文章,对Spark的工作机制及编程模型有了一定了解,下面把Spark中对RDD的常用操作函数做一下总结,以pys ...

- (七)Transformation和action详解-Java&Python版Spark

Transformation和action详解 视频教程: 1.优酷 2.YouTube 什么是算子 算子是RDD中定义的函数,可以对RDD中的数据进行转换和操作. 算子分类: 具体: 1.Value ...

- Spark Streaming揭秘 Day24 Transformation和action图解

Spark Streaming揭秘 Day24 Transformation和action图解 今天我们进入SparkStreaming的数据处理,谈一下两个重要的操作Transfromation和a ...

随机推荐

- 输入两个很大的正数(用C字符串表示),输出他们的乘积,将设不考虑非法输入。

#include<iostream> #include<cassert> void multiply(const char *a,const char *b) { assert ...

- sublime3 安装 Package Control 报错 “There Are No Packages Available For Installation”

编辑Preferences > Package Settings > Package Control > Settings - User文件 码上 { "channels& ...

- ping命令流程详解

现在有以下需求,PC1的IP地址为192.168.0.10/24,PC2的IP地址为192.168.0.20/24,SW交换机的IP地址为192.168.0.30/24,问PC1能否ping通PC2? ...

- [leetcode]Interleaving String @ Python

原题地址:https://oj.leetcode.com/problems/interleaving-string/ 题意: Given s1, s2, s3, find whether s3 is ...

- 服务器主机上RAID Controller的Read Ahead Policy

RAID控制器(卡)会根据Read Ahead Policy 来决定是否只读取应用程序所请求的一块数据, 还是从硬盘上读取整个stripe. 这个policy会对读的性能产生影响. No Read A ...

- [PowerShell Utils] Create a list of virtual machines based on configuration read from a CSV file in Hyper-V

Hello everyone, this is the third post of the series. . Background =============== In my solution, ...

- CSS-background-position百分比

关于背景图片的位置其background-position设置背景图片的位置有两种方式,一种是是根据像素设置,第二种根据百分比设置,第一种根据像素的位置是很简单的,只是关于百分比这个设置理解特别容易出 ...

- Android开发Tips(5)

欢迎Follow我的GitHub, 关注我的CSDN. 介绍关于Android的一些有趣的小知识点. 本文是第五篇了, 差点儿一周一篇, 欢迎阅读. 其余第一篇, 第二篇, 第三篇, 第四篇. 1. ...

- MySQL 常用函数之——substr()

substr()函数是用来截取数据库某一列字段中的一部分 常用的方式是: SBUSTR(str,pos); 就是从pos开始的位置,一直截取到最后. SUBSTR(str,pos,len); 这种表示 ...

- scikit-learn工具学习 - random,mgrid,np.r_ ,np.c_, scatter, axis, pcolormesh, contour, decision_function

yuanwen: http://blog.csdn.net/crossky_jing/article/details/49466127 scikit-learn 练习题 题目:Try classify ...