使用Python3爬虫抓取网页来下载小说

很多时候想看小说但是在网页上找不到资源,即使找到了资源也没有提供下载,小说当然是下载下来用手机看才爽快啦!

于是程序员的思维出来了,不能下载我就直接用爬虫把各个章节爬下来,存入一个txt文件中,这样,一部小说就爬下来啦。

这一次我爬的书为《黑客》,一本网络小说,相信很多人都看过吧,看看他的代码吧。

代码见如下:

import re

import urllib.request

import time #

root = 'http://www.biquge.com.tw/3_3542/'

# 伪造浏览器

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) ' \

'AppleWebKit/537.36 (KHTML, like Gecko)'

' Chrome/62.0.3202.62 Safari/537.36'} req = urllib.request.Request(url=root, headers=headers) with urllib.request.urlopen(req, timeout=1) as response:

# 大部分的涉及小说的网页都有charset='gbk',所以使用gbk编码

htmls = response.read().decode('gbk') # 匹配所有目录<a href="/3_3542/2020025.html">HK002 上天给了一个做好人的机会</a>

dir_req = re.compile(r'<a href="/3_3542/(\d+?.html)">')

dirs = dir_req.findall(htmls) # 创建文件流,将各个章节读入内存

with open('黑客.txt', 'w') as f:

for dir in dirs:

# 组合链接地址,即各个章节的地址

url = root + dir

# 有的时候访问某个网页会一直得不到响应,程序就会卡到那里,我让他0.6秒后自动超时而抛出异常

while True:

try:

request = urllib.request.Request(url=url, headers=headers)

with urllib.request.urlopen(request, timeout=0.6) as response:

html = response.read().decode('gbk')

break

except:

# 对于抓取到的异常,我让程序停止1.1秒,再循环重新访问这个链接,一旦访问成功,退出循环

time.sleep(1.1) # 匹配文章标题

title_req = re.compile(r'<h1>(.+?)</h1>')

# 匹配文章内容,内容中有换行,所以使flags=re.S

content_req = re.compile(r'<div id="content">(.+?)</div>',re.S,)

# 拿到标题

title = title_req.findall(html)[0]

# 拿到内容

content_test = content_req.findall(html)[0]

# 对内容中的html元素杂质进行替换

strc = content_test.replace(' ', ' ')

content = strc.replace('<br />', '\n')

print('抓取章节>' + title)

f.write(title + '\n')

f.write(content + '\n\n')

就这样,一本小说就下载下来啦!!!

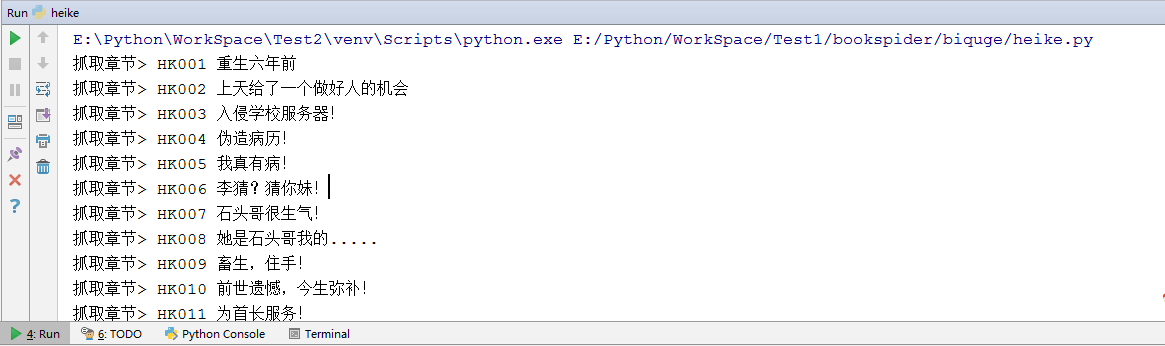

运行情况见图:

有的时候服务器会因为大量访问而认为你是个机器人就封了你的IP,可以加个随机数,让程序随机停止不同的时间。

如果下载太慢,可以使用多线程,一起下载多个章节

使用Python3爬虫抓取网页来下载小说的更多相关文章

- 关于Python3爬虫抓取网页Unicode

import urllib.requestresponse = urllib.request.urlopen('http://www.baidu.com')html = response.read() ...

- Python3简单爬虫抓取网页图片

现在网上有很多python2写的爬虫抓取网页图片的实例,但不适用新手(新手都使用python3环境,不兼容python2), 所以我用Python3的语法写了一个简单抓取网页图片的实例,希望能够帮助到 ...

- PHP利用Curl实现多线程抓取网页和下载文件

PHP 利用 Curl 可以完成各种传送文件操作,比如模拟浏览器发送GET,POST请求等等,然而因为php语言本身不支持多线程,所以开发爬虫程序效率并不高,一般采集 数据可以利用 PHPquery ...

- 笔趣看小说Python3爬虫抓取

笔趣看小说Python3爬虫抓取 获取HTML信息 解析HTML信息 整合代码 获取HTML信息 # -*- coding:UTF-8 -*- import requests if __name__ ...

- python3爬虫爬取网页思路及常见问题(原创)

学习爬虫有一段时间了,对遇到的一些问题进行一下总结. 爬虫流程可大致分为:请求网页(request),获取响应(response),解析(parse),保存(save). 下面分别说下这几个过程中可以 ...

- 怎么用Python写爬虫抓取网页数据

机器学习首先面临的一个问题就是准备数据,数据的来源大概有这么几种:公司积累数据,购买,交换,政府机构及企业公开的数据,通过爬虫从网上抓取.本篇介绍怎么写一个爬虫从网上抓取公开的数据. 很多语言都可以写 ...

- linux中使用wget模拟爬虫抓取网页

如何在linux上或者是mac上简单使用爬虫或者是网页下载工具呢,常规的我们肯定是要去下载一个软件下来使用啦,可怜的这两个系统总是找不到相应的工具,这时wget出来帮助你啦!!!wget本身是拿来下载 ...

- C# 使用 Abot 实现 爬虫 抓取网页信息 源码下载

下载地址 ** dome **

- win7下用python3.3抓取网上图片并下载到本地

这篇文章是看了网上有人写了之后,才去试试看的,但是因为我用的是python3.3,与python2.x有些不同,所以就写了下来,以供参考. get_webJpg.py #coding=utf-8 im ...

随机推荐

- sdk安装

转自:https://www.cnblogs.com/smyhvae/p/4390905.html 安装sdk:(包解压到哪里就是sdk的安装目录 P.S.安装目录不能有空格,要是之前有空格换了目 ...

- Several ports (8005, 8080, 8009)被占用

启动Tomcat服务器报错: Several ports (8005, 8080, 8009) required by Tomcat v5.5 Server at localhost are alre ...

- android studio运行的时候出现Unable to obtain debug bridge错误的解决办法

先贴上我百度的: 首先利用win+R,输入cmd,并且输入命令好来到:cd D:\Android\sdk\platform-tools\(这个是我的adb.exe目录,你的可以自行搜索)然后输入:ad ...

- Mysql设置字段自动获取时间

问题:现在在用户表中有一个字段表示用户创建的时间 第一个想法是写一段程序获得系统当前时间,想想就太麻烦了,果断放弃,之后想到了存储过程和函数,再想想还要编写存储过程或者函数的代码,有点放弃的想法,但是 ...

- Object的方法

1.Object.assign() 方法用于将所有可枚举属性的值从一个或多个源对象复制到目标对象.它将返回目标对象. ES2015引入的 ,且可用polyfilled.要支持旧浏览器的话,可用使用jQ ...

- 研华ADAM 6000系列型号枚举值

public enum Adam6000Type { Non = 0, Adam6015 = 6015, Adam6017 = 6017, ...

- python装饰器使用

看了不少python关于装饰器文章,觉得还挺实用,发贴来mark一下(以前做笔记总会长时间不看就忘记,放这里应该不会忘了吧 - -) 先来看一个简单的知识点: def a(): print(" ...

- 分布式事务的典型处理方式:2PC、TCC、异步确保和最大努力型

1. 柔性事务和刚性事务 柔性事务满足BASE理论(基本可用,最终一致)刚性事务满足ACID理论 本文主要围绕分布式事务当中的柔性事务的处理方式进行讨论. 柔性事务分为 两阶段型 补偿型 异步确保型 ...

- 【Python】 获取MP3信息replica

replica 初衷是想要整理iphone中的音乐.IOS(我自己的手机还是IOS8.3,新版本的系统可能有变化了)自带的音乐软件中所有音乐文件都存放在/var/mobile/Media/iTunes ...

- SpringMvc环境搭建(配置文件)

在上面的随笔里已经把搭建springmvc环境的基本需要的包都下下来了,拉下来就是写配置文件了. 下面左图是总的结构,右图是增加包 一.最开始当然是web.xml文件了,这是一个总的宏观配置 < ...