python网络爬虫之使用scrapy自动登录网站

前面曾经介绍过requests实现自动登录的方法。这里介绍下使用scrapy如何实现自动登录。还是以csdn网站为例。

Scrapy使用FormRequest来登录并递交数据给服务器。只是带有额外的formdata参数用来传送登录的表单信息(用户名和密码),为了使用这个类,需要使用以下语句导入:from scrapy.http import FormRequest

那么关于登录过程中使用cookie值,scrapy会自动为我们处理cookie,只要我们登录成功了,它就会像一个浏览器一样自动传送cookie

首先爬虫中定义start_requests

def start_requests(self):

return [Request("http://passport.csdn.net/account/login",meta={'cookiejar':1},callback=self.post_login,method="POST")]

其中采用Requests的方法首先访问登录网站。meta属性是字典,字典格式即{‘key’:'value'},字典是一种可变容器模型,可存储任意类型对象。

request中meta参数的作用是传递信息给下一个函数,这些信息可以是任意类型的,比如值、字符串、列表、字典......方法是把要传递的信息赋值给meta字典的键. 上面start_requests中键‘cookiejar’是一个特殊的键,scrapy在meta中见到此键后,会自动将cookie传递到要callback的函数中。既然是键(key),就需要有值(value)与之对应,例子中给了数字1,也可以是其他值,比如任意一个字符串。

Callback就是连接到了登录网站后下一步需要调的函数。下面来看下post_login如何实现

def post_login(self,response):

html=BeautifulSoup(response.text,"html.parser")

for input in html.find_all('input'):

if 'name' in input.attrs and input.attrs['name'] == 'lt':

lt=input.attrs['value']

if 'name' in input.attrs and input.attrs['name'] == 'execution':

e1=input.attrs['value']

data={'username':'xxxx','password':'xxxxx','lt':lt,'execution':e1,'_eventId':'submit'}

return [FormRequest.from_response(response,

meta={'cookiejar':response.meta['cookiejar']},

headers=self.header,

formdata=data,

callback=self.after_login,)]

首先是获取lt,execution字段的值,具体在之前介绍requests的帖子中有解释。

然后调用FormRequest.from_response。 这个方法的作用是从response中返回的网页中构造表单数据,因此第一个参数是response。这里response返回的网页也就是前面Requests中调用的http://passport.csdn.net/account/login

接下来的参数是meta。Heasers,formadata以及callback。这里的callback有就是指向登录后的函数。

after_login的实现如下。

def after_login(self,response):

print 'after login'

print response.status

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.80 Safari/537.36'}

return [Request("http://my.csdn.net/my/mycsdn",meta={'cookiejar':response.meta['cookiejar']},headers=header,callback=self.parse)]

def parse(self, response):

print response.text.decode('utf-8').encode(self.type)

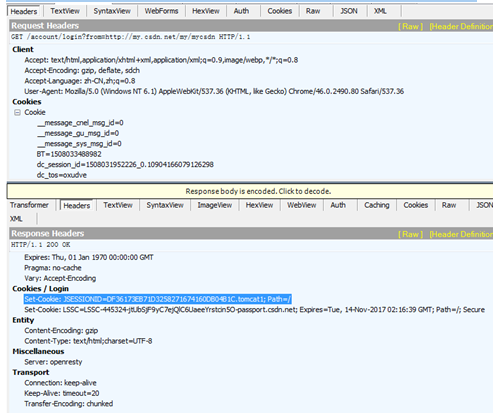

运行后我们来看下记录的log。从下面的红色标红部分可以看到。在向http://passport.csdn.net/account/login发起登录请求后,scrapy紧接着

向http://passport.csdn.net/account/login;jsessionid=8B4A62EA09BBB5F1FBF4D921B64FECE6.tomcat2 发起建立请求。这也就是调用FormRequest.from_response触发的。在这里后面连接的jsessionid值也就是之前在访问登录网站的时候获取的会话ID,在这里scrapy自动给添加上了

2017-10-16 22:17:34 [scrapy] INFO: Spider opened

2017-10-16 22:17:34 [scrapy] INFO: Crawled 0 pages (at 0 pages/min), scraped 0 items (at 0 items/min)

2017-10-16 22:17:34 [scrapy] DEBUG: Telnet console listening on 127.0.0.1:6023

2017-10-16 22:17:34 [scrapy] DEBUG: Crawled (404) <GET http://passport.csdn.net/robots.txt> (referer: None)

2017-10-16 22:17:34 [scrapy] DEBUG: Crawled (200) <POST http://passport.csdn.net/account/login> (referer: None)

2017-10-16 22:17:34 [scrapy] DEBUG: Crawled (200) <POST http://passport.csdn.net/account/login;jsessionid=8B4A62EA09BBB5F1FBF4D921B64FECE6.tomcat2> (referer: http://www.csdn.net/)

2017-10-16 22:17:35 [scrapy] DEBUG: Crawled (200) <GET http://my.csdn.net/robots.txt> (referer: None)

2017-10-16 22:17:35 [scrapy] DEBUG: Crawled (200) <GET http://my.csdn.net/my/mycsdn> (referer: http://passport.csdn.net/account/login;jsessionid=8B4A62EA09BBB5F1FBF4D921B64FECE6.tomcat2)

2017-10-16 22:17:35 [scrapy] INFO: Closing spider (finished)

2017-10-16 22:17:35 [scrapy] INFO: Dumping Scrapy stats:

{'downloader/request_bytes': 2022,

从fiddler中抓取的数据可以看到jsessionid是在访问登录网站后,网站返回的response 消息的header消息中。也就是网站设置的cookie值

完整的代码:

# -*- coding:UTF-8 -*- #

from scrapy.spiders import Spider,CrawlSpider,Rule

from scrapy.selector import Selector

from scrapy.http import Request

from scrapy import FormRequest from test2.items import Test2Item

from scrapy.utils.response import open_in_browser

from scrapy.linkextractors import LinkExtractor

from bs4 import BeautifulSoup

import sys class testSpider(Spider):

name="test2"

allowd_domains=['http://www.csdn.net/']

header={'host':'passport.csdn.net','User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.80 Safari/537.36','Referer':'http://www.csdn.net/'}

start_urls=["http://www.csdn.net/"]

reload(sys)

sys.setdefaultencoding('utf-8')

type = sys.getfilesystemencoding()

def start_requests(self): return [Request("http://passport.csdn.net/account/login",meta={'cookiejar':1},callback=self.post_login,method="POST")] def post_login(self,response):

html=BeautifulSoup(response.text,"html.parser")

for input in html.find_all('input'):

if 'name' in input.attrs and input.attrs['name'] == 'lt':

lt=input.attrs['value']

if 'name' in input.attrs and input.attrs['name'] == 'execution':

e1=input.attrs['value']

data={'username':'xxxx','password':'xxxxx','lt':lt,'execution':e1,'_eventId':'submit'}

return [FormRequest.from_response(response,

meta={'cookiejar':response.meta['cookiejar']},

headers=self.header,

formdata=data,

callback=self.after_login,)]

def after_login(self,response):

print 'after login'

print response.status

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.80 Safari/537.36'}

return [Request("http://my.csdn.net/my/mycsdn",meta={'cookiejar':response.meta['cookiejar']},headers=header,callback=self.parse)]

def parse(self, response):

print response.text.decode('utf-8').encode(self.type)

python网络爬虫之使用scrapy自动登录网站的更多相关文章

- python网络爬虫之使用scrapy自动爬取多个网页

前面介绍的scrapy爬虫只能爬取单个网页.如果我们想爬取多个网页.比如网上的小说该如何如何操作呢.比如下面的这样的结构.是小说的第一篇.可以点击返回目录还是下一页 对应的网页代码: 我们再看进入后面 ...

- 【python 网络爬虫】之scrapy系列

网络爬虫之scripy系列 [scrapy网络爬虫]之0 爬虫与反扒 [scrapy网络爬虫]之一 scrapy框架简介和基础应用 [scrapy网络爬虫]之二 持久化操作 [scrapy网络爬虫]之 ...

- Python 网络爬虫 002 (入门) 爬取一个网站之前,要了解的知识

网站站点的背景调研 1. 检查 robots.txt 网站都会定义robots.txt 文件,这个文件就是给 网络爬虫 来了解爬取该网站时存在哪些限制.当然了,这个限制仅仅只是一个建议,你可以遵守,也 ...

- python网络爬虫之使用scrapy下载文件

前面介绍了ImagesPipeline用于下载图片,Scrapy还提供了FilesPipeline用与文件下载.和之前的ImagesPipeline一样,FilesPipeline使用时只需要通过it ...

- python网络爬虫之使用scrapy爬取图片

在前面的章节中都介绍了scrapy如何爬取网页数据,今天介绍下如何爬取图片. 下载图片需要用到ImagesPipeline这个类,首先介绍下工作流程: 1 首先需要在一个爬虫中,获取到图片的url并存 ...

- PYTHON网络爬虫与信息提取[scrapy框架应用](单元十、十一)

scrapy 常用命令 startproject 创建一个新的工程 scrapy startproject <name>[dir] genspider 创建一个爬虫 ...

- 【python网络爬虫】之requests相关模块

python网络爬虫的学习第一步 [python网络爬虫]之0 爬虫与反扒 [python网络爬虫]之一 简单介绍 [python网络爬虫]之二 python uillib库 [python网络爬虫] ...

- 《实战Python网络爬虫》- 感想

端午节假期过了,之前一直在做出行准备,后面旅游完又休息了一下,最近才恢复状态. 端午假期最后一天收到一个快递,回去打开,发现是微信抽奖中的一本书,黄永祥的<实战Python网络爬虫>. 去 ...

- 第三百四十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—cookie禁用、自动限速、自定义spider的settings,对抗反爬机制

第三百四十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—cookie禁用.自动限速.自定义spider的settings,对抗反爬机制 cookie禁用 就是在Scrapy的配置文件set ...

随机推荐

- shell脚本 linux脚本

linux:shell 脚本 如果判断当前时间 是不是12点之前 用date命令先取得当前的时间(仅取小时数) : date '+%H' #按24小时制取hour (00..23) 然后与12 ...

- 一款不错的编程字体Source Code Pro

我以前一直是用的MS自家的是Consolas的字体,这个字体基本上具有编程字体所需的所有要素:等宽.支持ClearType.中文字体大小合适,l和1,o和0很容易区分.非要挑刺的话就是字体比较小,9号 ...

- Linux下创建和删除用户

在Linux下创建用户和删除用户,必须在root用户下,如果你当前不是用根用户登录,你可以打开终端,输入"su root"命令,再输入根口令,就可以进入root用户模式下,如下所示 ...

- 【ActiveMQ】管理界面查看消息详情,报错/WEB-INF/tags/form/forEachMapEntry.tag PWC6199: Generated servlet error: The type java.util.Map$Entry cannot be resolved. It is indirectly referenced from required .class files

ActiveMQ版本:5.12 JDK版本:1.8 ===================== 使用ActiveMQ过程中,在管理界面查看消息详情,发现报错: 查看日志信息,报错如下: 2017-11 ...

- eclipse运行时弹出Fail to create the Java Virtual Machine

找到eclipse程序所在目录,在目录下找到eclipse.ini文件,打开文件将com.android.ide.eclipse.adt.package.product下的值改成128m,org.ec ...

- 状态压缩DP常遇到的位运算

位操作一共有6种形式:<<,>>,&,|,^,~; 1.左移操作符<<:左移操作符将整数的二进制向左移若干位,将最高若干位挤掉,并在低位补0 如: ; // ...

- 利用Acunetix WVS进行批量网站漏洞评估

我们知道Acunetix WVS可以对网站进行安全性评估,那么怎么能批量扫描呢?游侠(www.youxia.org)在测试WVS 8 BETA2的时候发现WVS居然支持WEB管理,还是很方便的. 打开 ...

- Git相关命令教程

一.在GitHub上创建新项目 (1)在GitHub首页 “New repository”,创建新版本库“test” (2)在本地使用GitBash,将repository clone到本地 git ...

- pythonkeywordis与 ==的差别

pythonkeywordis与 ==的差别 近期在学习Python.总结一下小知识点. Python中的对象包括三要素:id.type.value 当中id用来唯一标识一个对象.type标识对象的类 ...

- C++中一些个函数的使用

函数:sprintf的使用 函数功能:把格式化的数据写入某个字符串 函数原型:int sprintf( char *buffer, const char *format [, argument] … ...