HDFS02 HDFS的Shell操作

HDFS的Shell操作(开发重点)

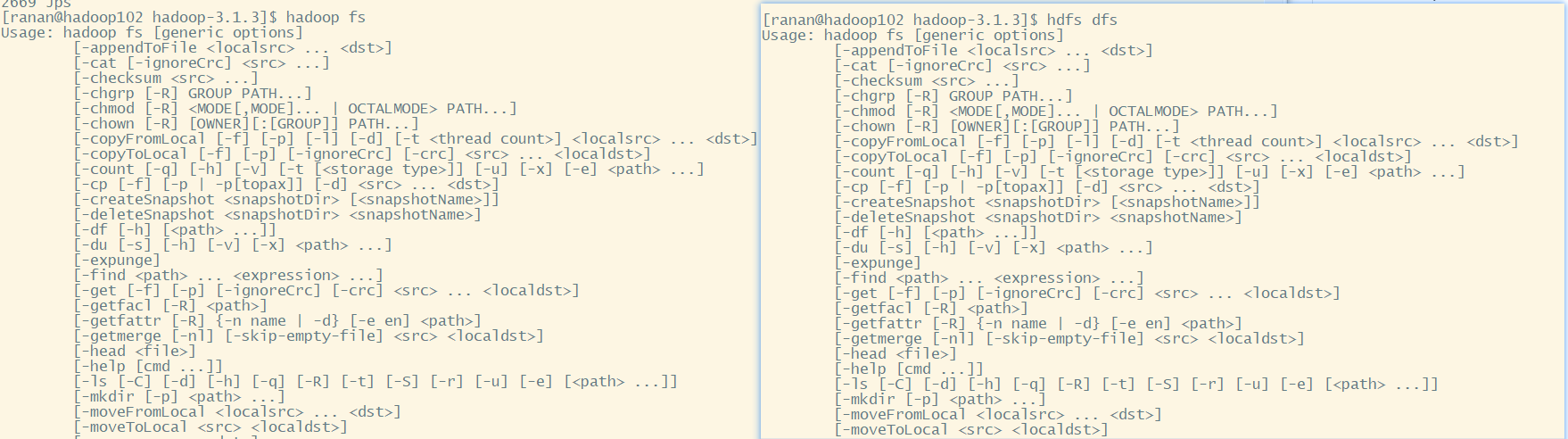

基本语法

方式1: hadoop fs 具体命令

方式2: hdfs dfs 具体命令

常用命令

一共分三大类命令:上传、下载、HDFS直接操作

准备工作

1.启动Hadoop集群

[ranan@hadoop102 hadoop-3.1.3]$ myhadoop.sh start

# 或者也可以像之前一样分别在102,103上使用以下两个命令:

[ranan@hadoop102 hadoop-3.1.3]$ sbin/start-dfs.sh

[ranana@hadoop103 hadoop-3.1.3]$ sbin/start-yarn.sh

2.查看命令帮助,如果对某个命令的用法不清楚

[ranan@hadoop102 ~]$ hadoop fs -help rm

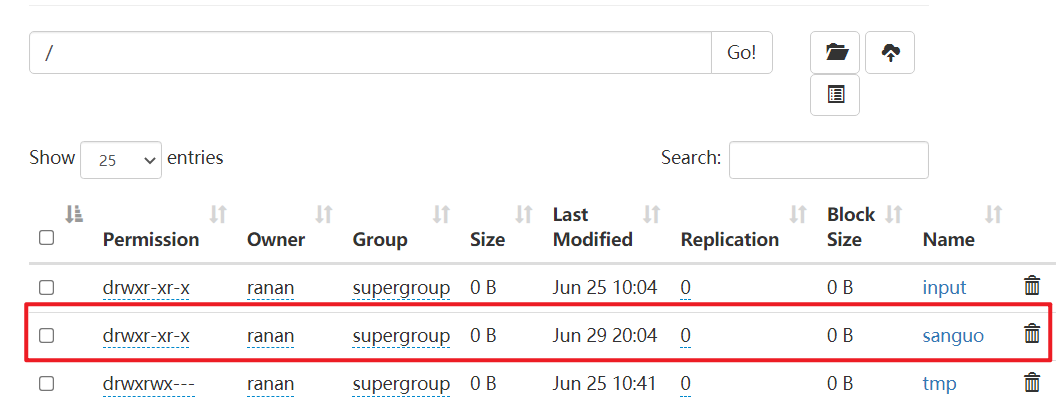

3.创建/sanguo文件

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -mkdir /sanguo

后续的命令在该文件夹下操作

上传

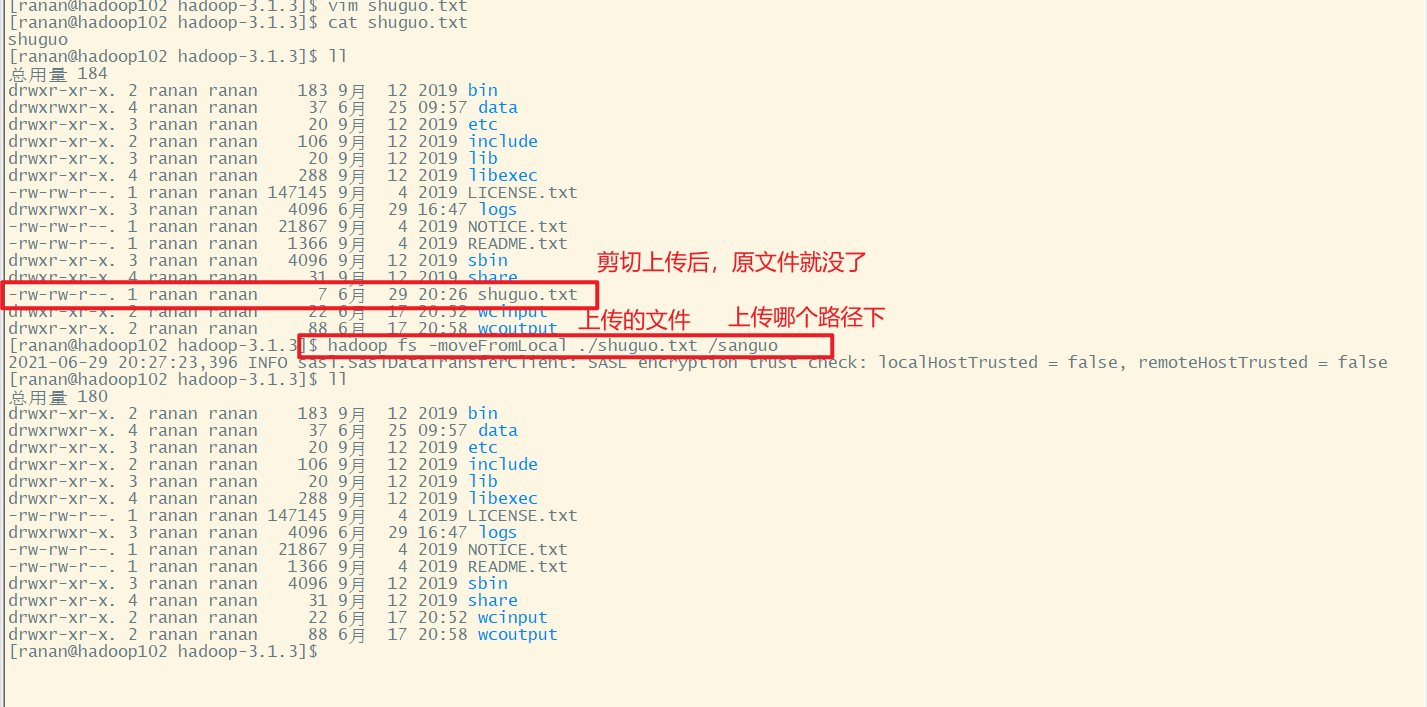

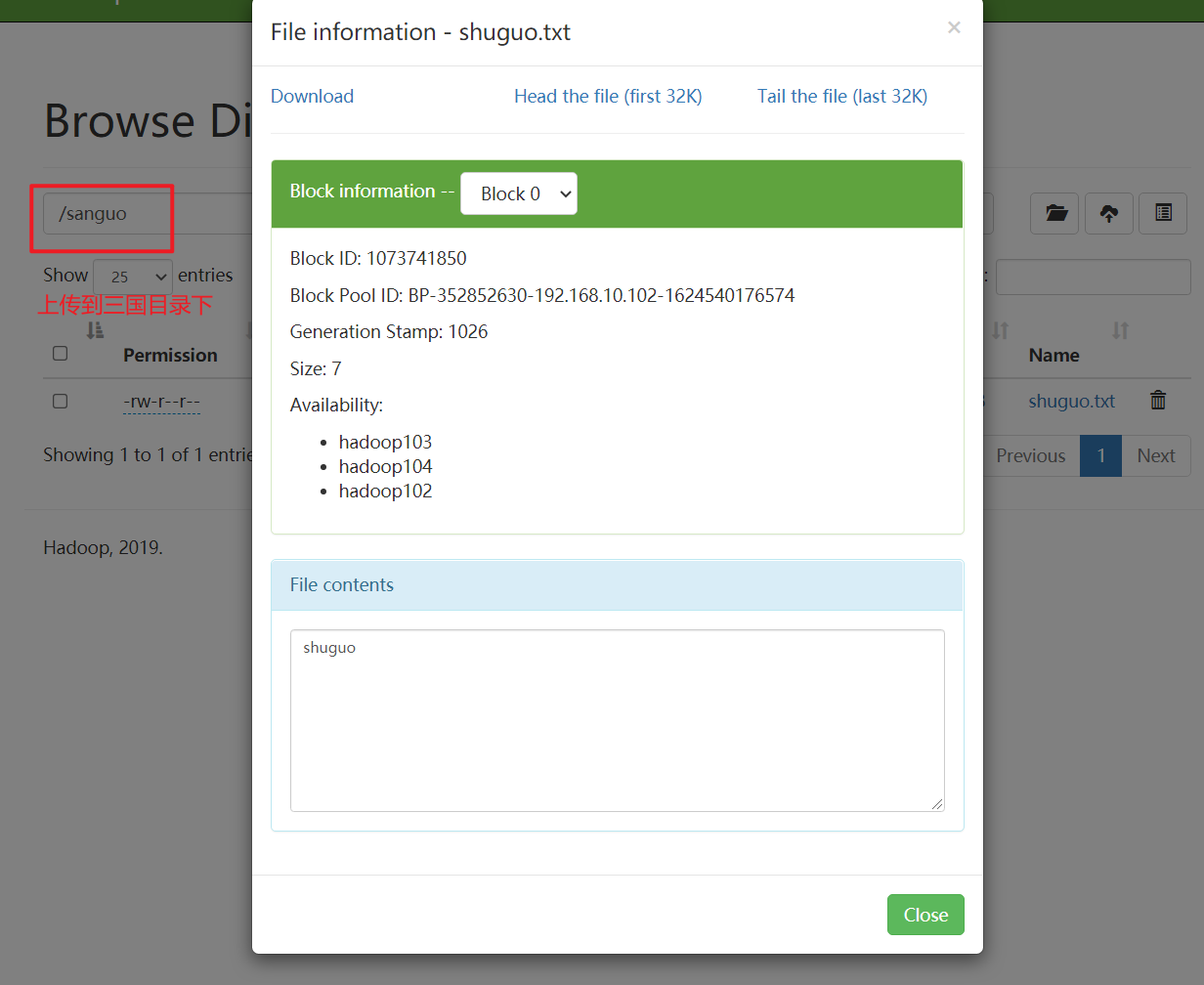

-moveFromLocal 剪切

从本地剪切粘贴到HDFS

基本语法:hadoop fs -moveFromLocal 原文件 上传路径

[ranan@hadoop102 hadoop-3.1.3]$ vim shuguo.txt

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -moveFromLocal ./shuguo.txt /sanguo

-copyFromLocal 拷贝

从本地文件系统中拷贝文件到HDFS路径

基本语法:hadoop fs -copyFromLocal 原文件 上传路径

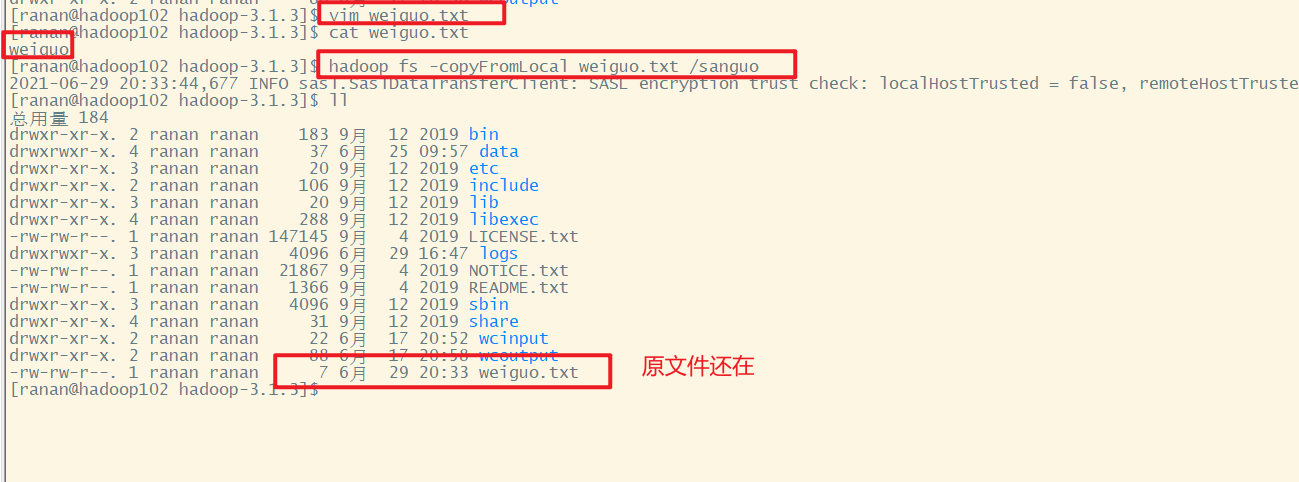

[ranan@hadoop102 hadoop-3.1.3]$ vim weiguo.txt

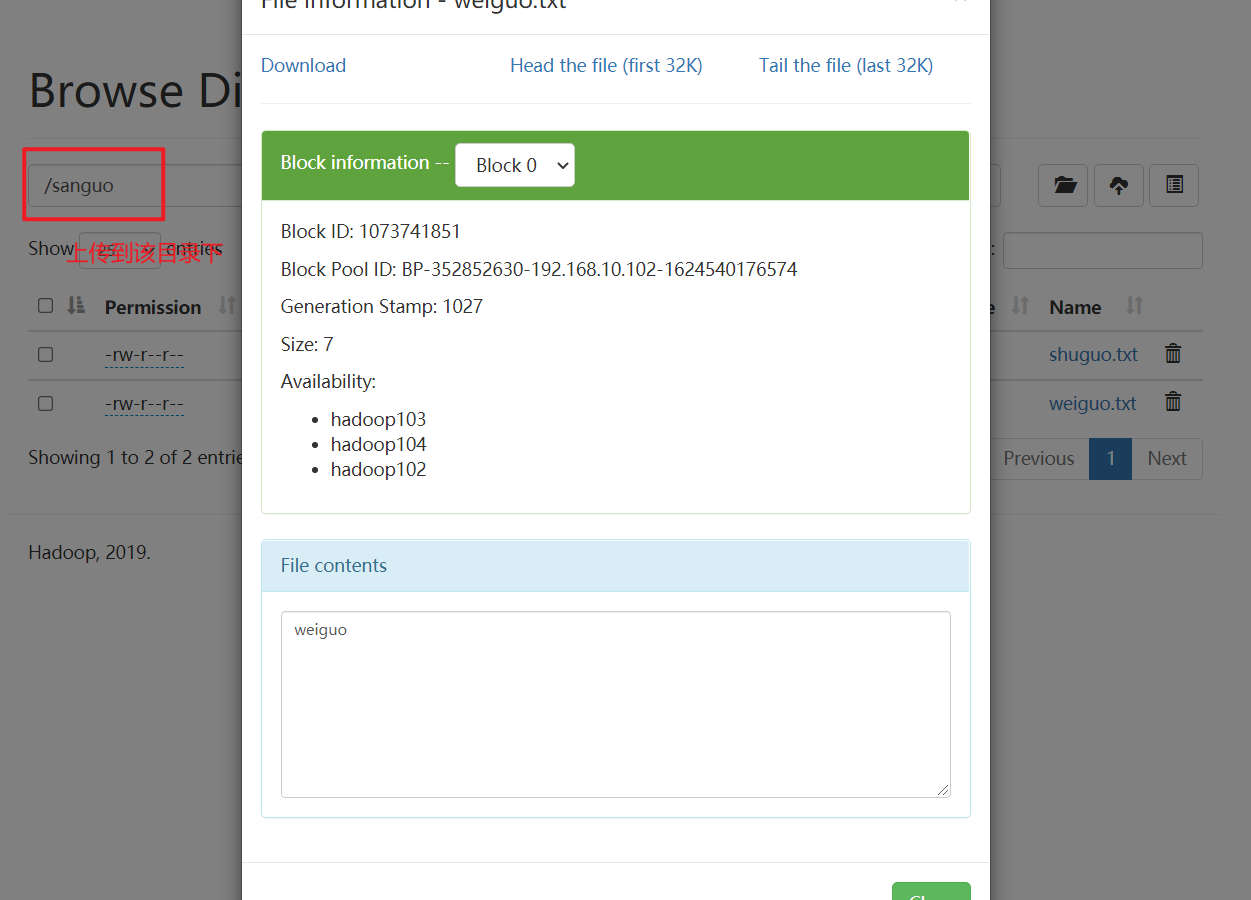

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -copyFromLocal weiguo.txt /sanguo

-put 拷贝 (常用)

等同于copyFromLocal,生产环境更习惯用put

基本语法:hadoop fs -put 原文件 上传路径

[ranan@hadoop102 hadoop-3.1.3]$ vim wuguo.txt

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -put wuguo.txt /sanguo

-appendToFile 追加

追加一个文件到已经存在的文件末尾

文件只能追加,不能修改

基本语法:hadoop fs -appendToFile 追加的文件 被追加的文件

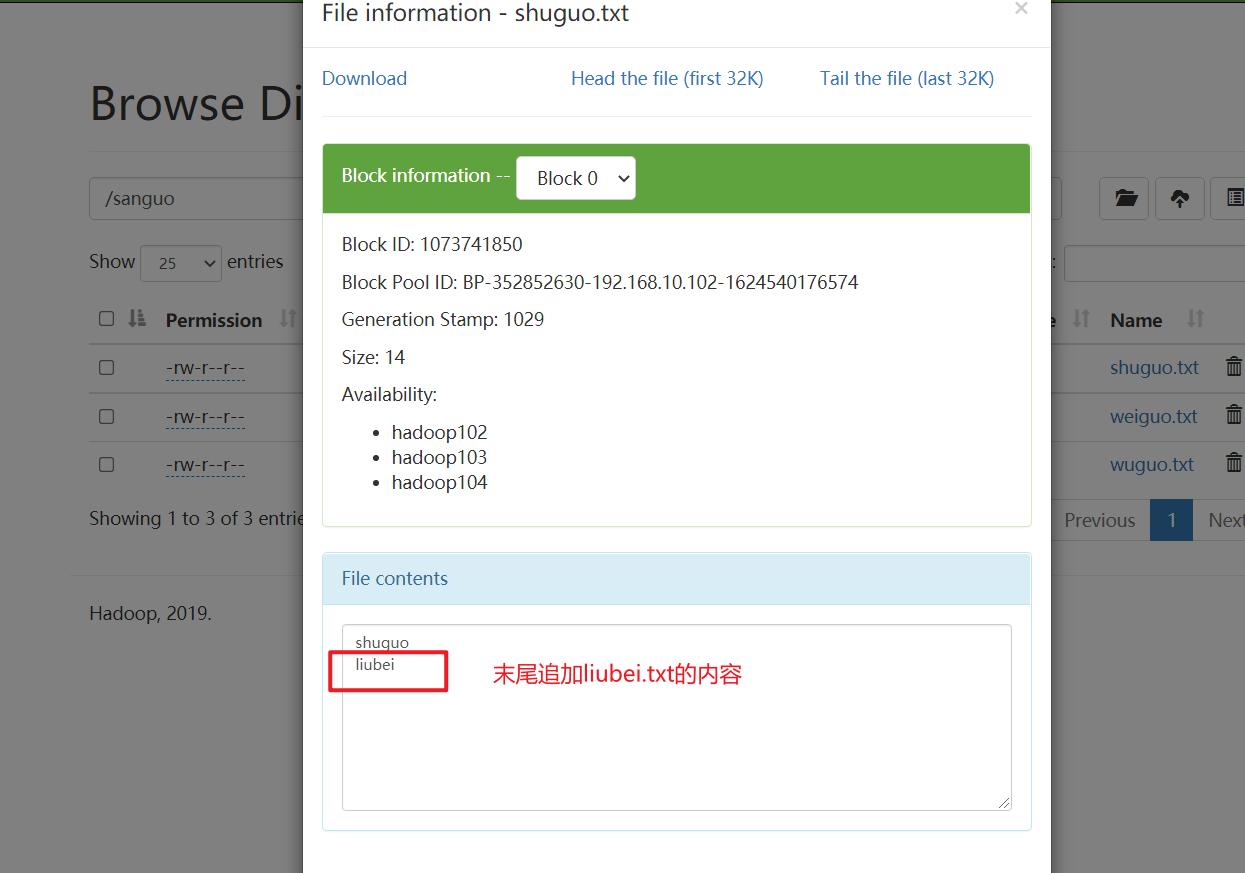

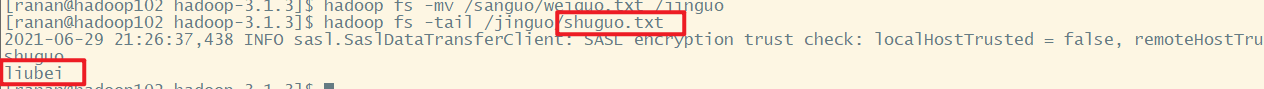

[ranan@hadoop102 hadoop-3.1.3]$ vim liubei.txt

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -appendToFile liubei.txt /sanguo/shuguo.txt

下载

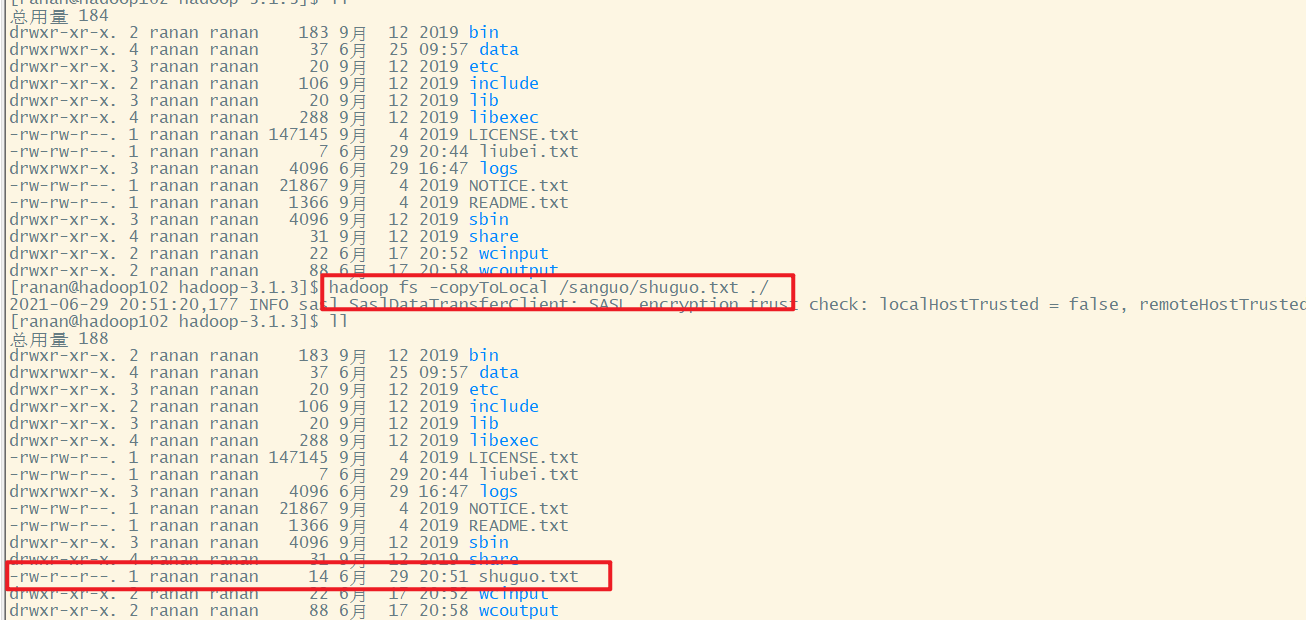

-copyToLocal 下载

从HDFS拷贝到本地

基本语法:hadoop fs -copyToLocal HDFS的路径 拷贝到本地的路径

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -copyToLocal /sanguo/shuguo.txt ./

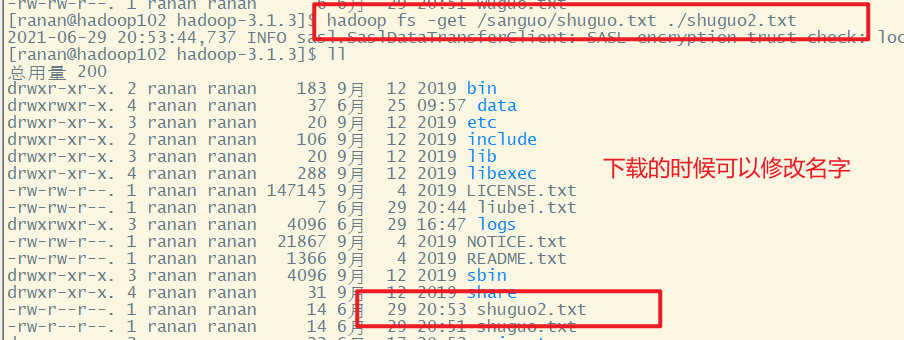

-get 下载

等同于copyToLocal,生产环境更习惯用get

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -get /sanguo/shuguo.txt ./shuguo2.txt

下载的时候可以改文件名

HDFS直接操作

基本使用于linux相同

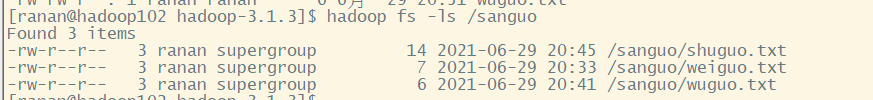

-ls 显示目录信息

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -ls /sanguo

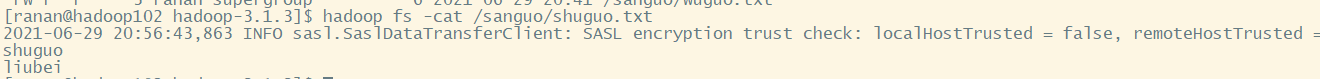

-cat 显示文件内容

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -cat /sanguo/shuguo.txt

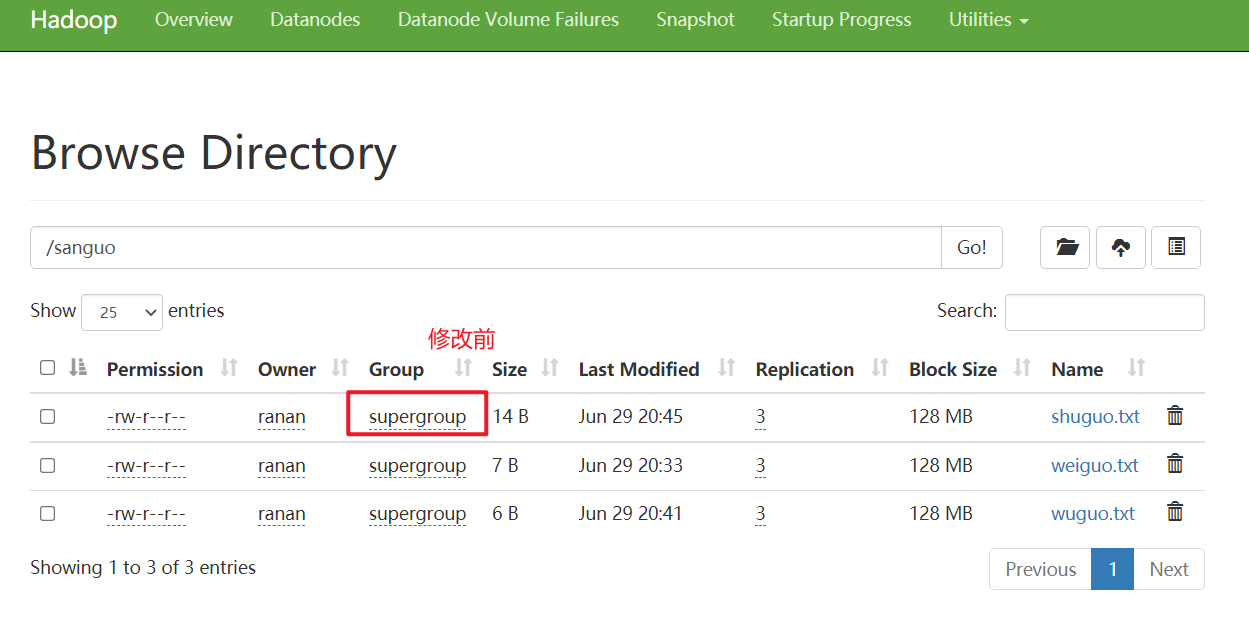

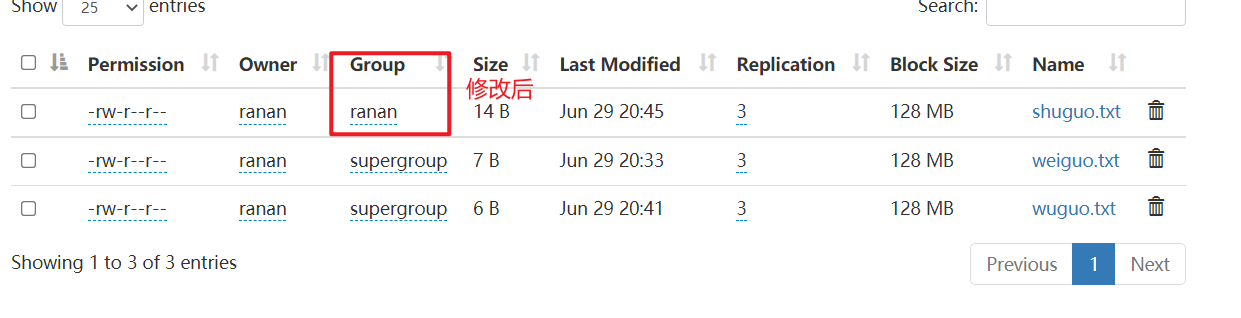

-chgrp/-chmod/-chown/ 修改文件所属权限

和Linux文件系统中的用法一样

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -chgrp ranan /sanguo/shuguo.txt

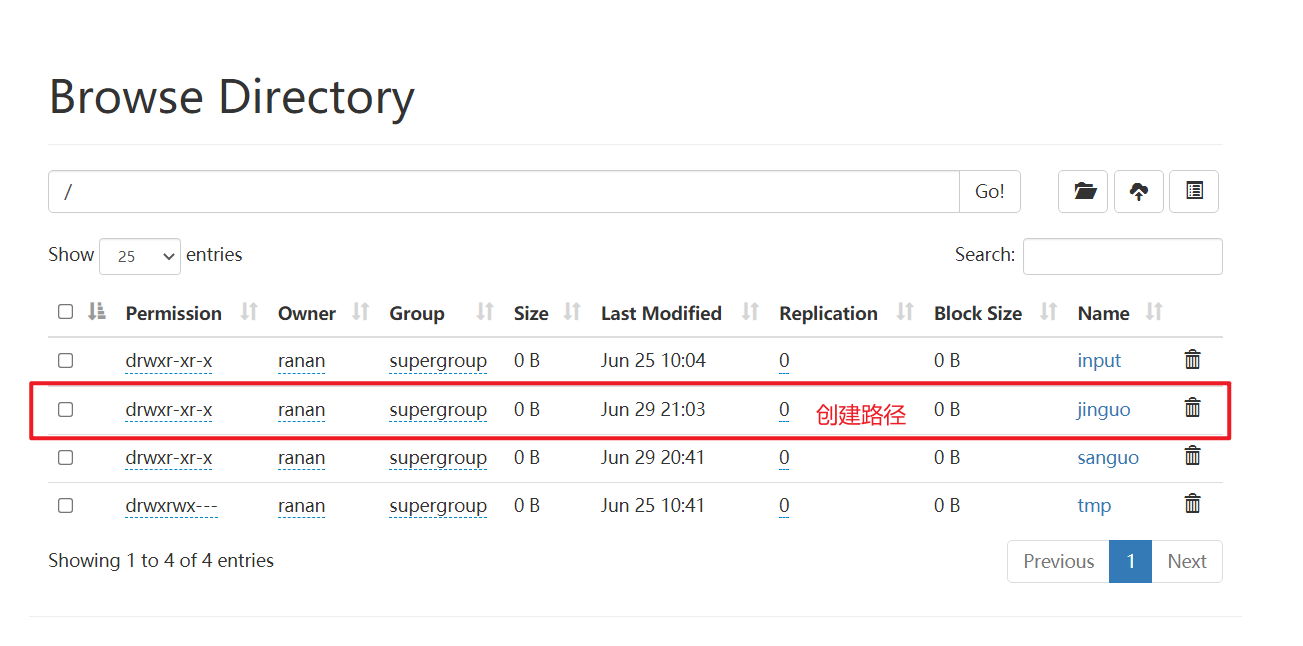

-mkdir 创建路径

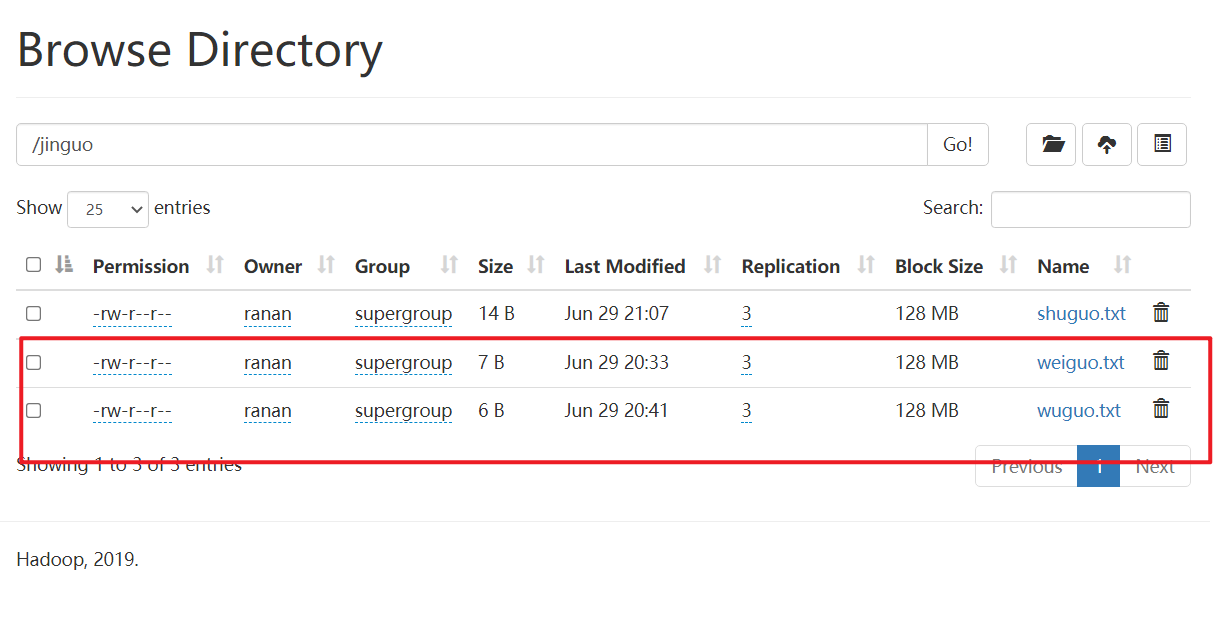

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -mkdir /jinguo

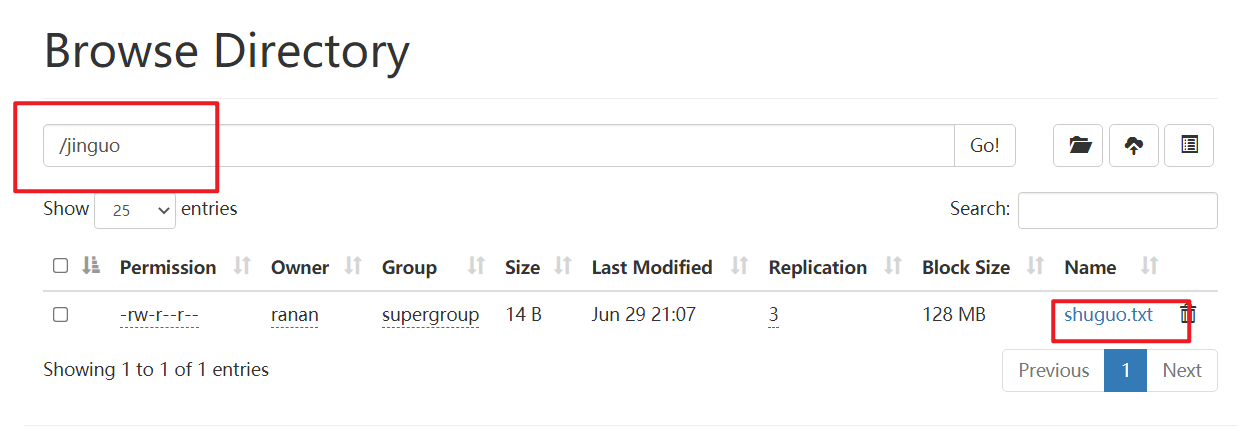

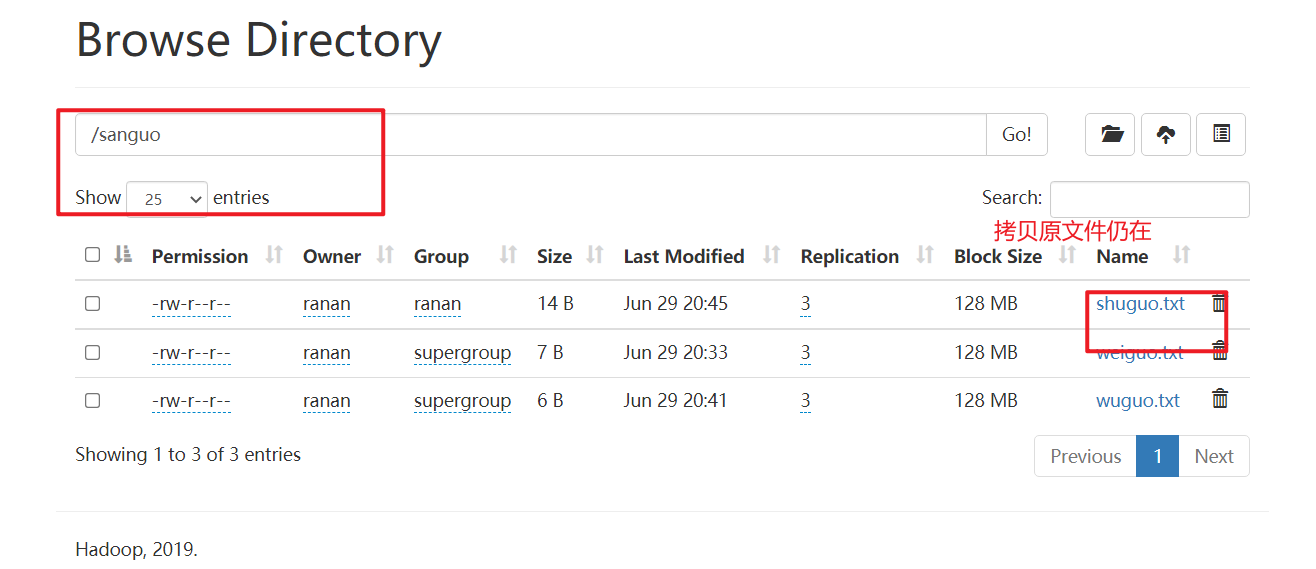

-cp HDFS中拷贝

将shuguo.txt拷贝到/jinguo

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -cp /sanguo/shuguo.txt /jinguo

-mv 在HDFS目录中移动文件

mv oldNameFile newNameFile(重命名)

mv 原目录 目标目录(移动剪切)

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -mv /sanguo/wuguo.txt /jinguo

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -mv /sanguo/weiguo.txt /jinguo

-tail 显示文件末尾的数据

显示文件末尾1kb的数据。因为只能追加修改,末尾的一般是最新的。

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -tail /jinguo/shuguo.txt

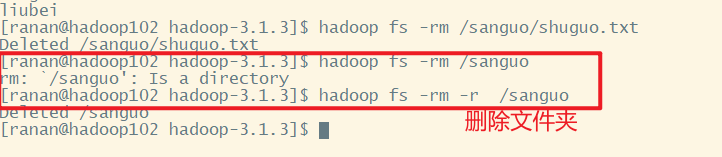

-rm 删除文件/文件夹

删除指令要注意使用

-rm 删除文件或文件夹

-rm -r 递归删除文件夹及文件夹里面的类容

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -rm /sanguo/shuguo.txt

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -rm -r /sanguo

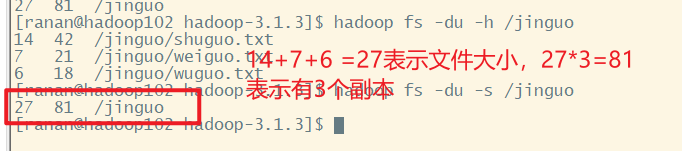

-du 统计文件夹的大小信息

-s 显示总共的

-h 显示具体的细节

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -du -s /jinguo

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -du -h /jinguo

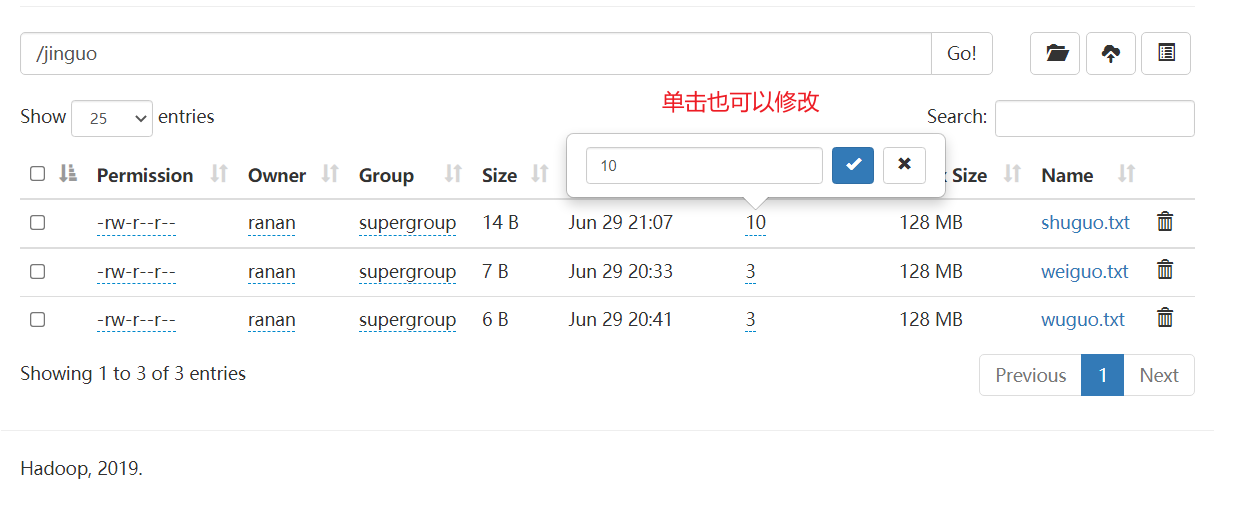

-setrep 设置HDFS中文件的副本数量

[ranan@hadoop102 hadoop-3.1.3]$ hadoop fs -setrep 10 /jinguo/shuguo.txt

但是我们只有三台服务器,实际还是只有3个副本。因为每台机器只能存储其一份副本

副本数会记录在 NameNode 的元数据中,如果后续增加服务器,会拷贝副本过去。

HDFS02 HDFS的Shell操作的更多相关文章

- Hadoop开发第6期---HDFS的shell操作

一.HDFS的shell命令简介 我们都知道HDFS 是存取数据的分布式文件系统,那么对HDFS 的操作,就是文件系统的基本操作,比如文件的创建.修改.删除.修改权限等,文件夹的创建.删除.重命名等. ...

- 大数据:Hadoop(JDK安装、HDFS伪分布式环境搭建、HDFS 的shell操作)

所有的内容都来源与 Hadoop 官方文档 一.Hadoop 伪分布式安装步骤 1)JDK安装 解压:tar -zxvf jdk-7u79-linux-x64.tar.gz -C ~/app 添加到系 ...

- Hadoop读书笔记(二)HDFS的shell操作

Hadoop读书笔记(一)Hadoop介绍:http://blog.csdn.net/caicongyang/article/details/39898629 1.shell操作 1.1全部的HDFS ...

- HDFS基本shell操作

在客户端输入Hadoop fs,可以查看所有的,hadoop shell # -help [cmd] //显示命令的帮助信息,如: hadoop fs -help ls # -ls(r) <pa ...

- HDFS的shell操作

bin/hadoop命令操作: namenode -format 格式化文件系统 fs(缩写:FileSystem) 运行一个文件系统的用户客户端 bin/hadoop fs常用命令操作: -ls h ...

- [HDFS_2] HDFS 的 Shell 操作

0. 说明 在 Shell 下完成对 HDFS 的增删改查操作 1. 在 Shell 下完成对 HDFS 的增删改查操作 [1.0 查看帮助] [centos@s101 ~]$ hdfs dfs -h ...

- Hadoop框架之HDFS的shell操作

既然HDFS是存取数据的分布式文件系统,那么对HDFS的操作,就是文件系统的基本操作,比如文件的创建.修改.删除.修改权限等,文件夹的创建.删除.重命名等.对HDFS的操作命令类似于Linux的she ...

- Hadoop HDFS的Shell操作实例

本文发表于本人博客. 我们知道HDFS是Hadoop的分布式文件系统,那既然是文件系统那最起码会有管理文件.文件夹之类的功能吧,这个类似我们的Windows操作系统一样的吧,创建.修改.删除.移动.复 ...

- 4 weekend110的hdfs&mapreduce测试 + hdfs的实现机制初始 + hdfs的shell操作 + 无密登陆配置

Hdfs是根/目录,windows是每一个盘符, 1 从Linux里传一个到,hdfs里去 2 从hdfs里下一个到,linux里去 想从hdfs里,下载到linux, 涨知识,记住,hdfs是建 ...

随机推荐

- MyBatis源码分析(八):设计模式

Mybatis中用到的设计模式 1. 建造者(Builder)模式: 表示一个类的构建与类的表示分离,使得同样的构建过程可以创建不同的表示.建造者模式是一步一步创建一个复杂的对象,他只允许用户只通过指 ...

- 转:Linux常用命令总结

学习linux也有一阵子了,现总结一些常用的linux操作命令,方便大家查找1. cd命令这个命令是最基本的也是最常用的.它用于切换当前目录,可以是绝对路径,也可以是相对路径.例:cd /root/h ...

- PHP笔记3__简易计算器

<?php header("Content-type: text/html; charset=utf-8"); error_reporting(E_ALL & ~E_ ...

- python中将xmind转成excel

需求:最近公司项目使用tapd进行管理,现在遇到的一个难题就是,使用固定的模板编写测试用例,使用excel导入tapd进行测试用例管理,觉得太过麻烦,本人一直喜欢使用导图来写测试用例,故产生了这个工具 ...

- Django settings.py设置 DEBUG=False后静态文件无法加载解决

解决办法: settings.py 文件 DEBUG = False STATIC_ROOT = os.path.join(BASE_DIR,'static') #新增 urls.py文件(项目的) ...

- 流媒体技术的应用,如何搭建一个SimpleNVR流媒体服务系统

Onvif/RTSP流媒体服务 SimpleNVR Onvif/RTSP流媒体服务是一款软硬一体音视频流媒体服务软件.它是在5G.AI.云计算.大数据.物联网等网络技术大规模商用后,用户要求视频随时随 ...

- Typecho 反序列化漏洞 分析及复现

0x00 漏洞简介 CVE-2018-18753 漏洞概述: typecho 是一款非常简洁快速博客 CMS,前台 install.php 文件存在反序列化漏洞,通过构造的反序列化字符串注入可以执行任 ...

- Screenshot 库和Collections 库

一.screenShot 是 robot framework的标准类库,用于截取当前窗口,需要手动加载. 示例: 运行结果: 二.Collections 库 Collections 库同样为 Robo ...

- 子查询之 exists 和 in

exists exists用于检查一个子查询是否至少会返回一行数据(即检测行的存在),返回值为boolean型,true或false 语法 exists subquery /* 参数: subquer ...

- 了解php数据库常用语法增删改查

数据库基本语法 MySQL增:insert into 表名 (字段1,...,字段n) values (值1,...,值n) MySQL删:delete from 表名 where 条件 MySQL改 ...