spark基本概念整理

app

基于spark的用户程序,包含了一个driver program和集群中多个executor

driver和executor存在心跳机制确保存活

3 --conf spark.executor.instances=5 --conf spark.executor.cores=8 --conf spark.executor.memory=80G

rdd

弹性分布式数据集

只读的、分区(partition)记录的集合

初代rdd处于血统的顶层,记录任务所需的数据的分区信息,每个分区数据的读取方法

子代rdd不真正的存储信息,只记录血统信息

真正的数据读取,应该是task具体被执行的时候,触发action操作的时候才发生的

算子

分为transformation和action

transformation: map filter flatMap union groupByKey reduceByKey sortByKey join

action: reduce collect count first saveAsTextFile countByKey foreach

partition

rdd存储机制类似hdfs,分布式存储

hdfs被切分成多个block(默认128M)进行存储,rdd被切分为多个partition进行存储

不同的partition可能在不同的节点上

再spark读取hdfs的场景下,spark把hdfs的block读到内存就会抽象为spark的partition

将RDD持久化到hdfs上,RDD的每个partition就会存成一个文件,如果文件小于128M,就可以理解为一个partition对应hdfs的一个block。反之,如果大于128M,就会被且分为多个block,这样,一个partition就会对应多个block。

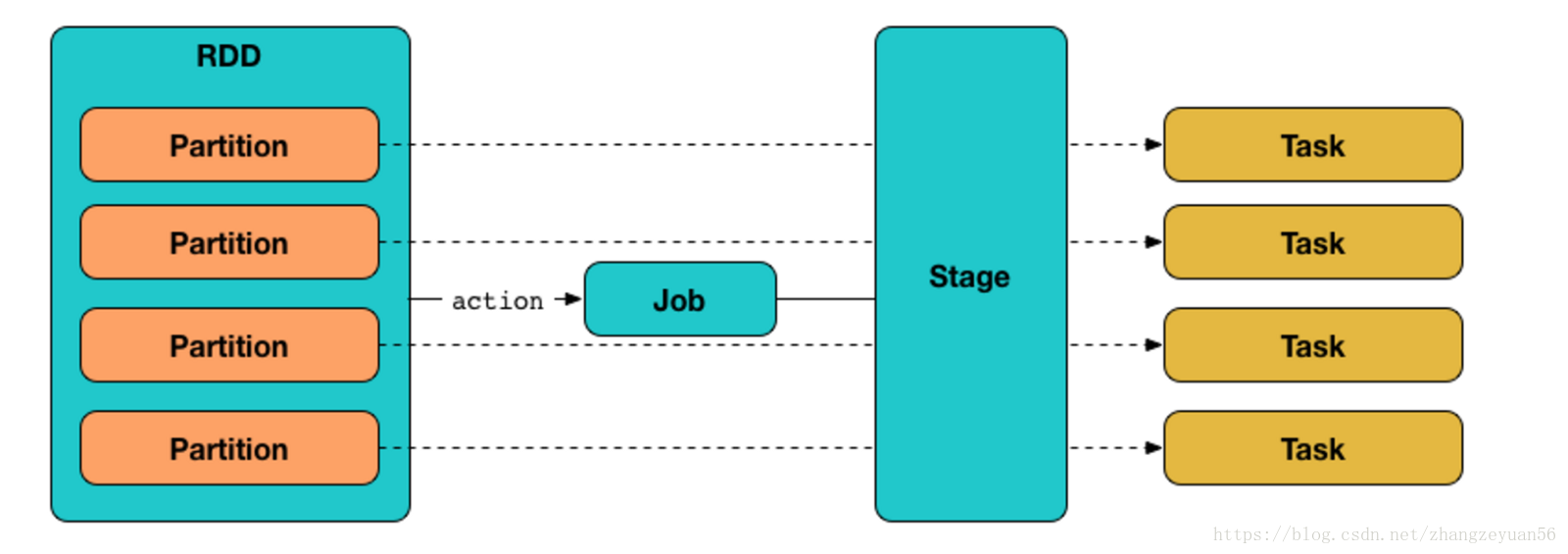

job

一个action算子触发一个job

一个job中有好多的task,task是执行job的逻辑单元(猜测是根据partition划分任务)

一个job根据是否有shuffle发生可以分为好多的stage

stage

rdd中的依赖关系(血统)分为宽依赖和窄依赖

窄依赖:父RDD的一个分区只被一个子RDD的分区使用,不产生shuffle,即父子关系为“一对一”或者“多对一”

宽依赖:产生shuffle,父子关系为“一对多”或者“多对多”

spark根据rdd之间的依赖关系形成DAG有向无环图,DAG提交给DAGScheduler,DAGScheduler会把DAG划分相互依赖的多个stage,划分stage的依据就是rdd之间的宽窄依赖

遇到宽依赖就划分stage

每个stage包含一个或多个task任务

这些task以taskSet的形式提交给TaskScheduler运行

stage是由一组并行的task组成

stage切割规则:从后往前,遇到宽依赖就切割stage。

10 一个stage以外部文件或者shuffle结果作为开始,以产生shuffle或者生成最终结果时结束

11 猜测stage与TaskSet为一一对应的关系

task

分为两种:shuffleMapTask和resultTask

2 默认按照partition进行拆分task

--conf spark.default.parallelism=1000 设置task并行的数量

个人理解以上各种概念都是抽象概念,即简单的理解为全部发生在driver端,只有task相关的信息会被序列化发送到executor去执行

参考链接:

https://www.cnblogs.com/jechedo/p/5732951.html

https://www.2cto.com/net/201802/719956.html

https://blog.csdn.net/fortuna_i/article/details/81170565

https://www.2cto.com/net/201712/703261.html

https://blog.csdn.net/zhangzeyuan56/article/details/80935034

https://www.jianshu.com/p/3e79db80c43c?from=timeline&isappinstalled=0

spark基本概念整理的更多相关文章

- 【知识点】业务连接服务(BCS)认证概念整理

业务连接服务(BCS)认证概念整理 I. BDC认证模型 BDC服务支持两种认证模型:信任的子系统,模拟和代理. 在信任的子系统模型中,中间层(通常是Web服务器)通过一个固定的身份来向后端服务器取得 ...

- DNS,TCP,IP,HTTP,socket,Servlet概念整理

DNS,TCP,IP,HTTP,socket,Servlet概念整理 常见的协议虽然很容易理解,但是看了之后过一段时间不看还是容易忘,笔记如下,比较零碎,勉强供各位复习.如有错误欢迎指正. D ...

- 【Spark深入学习-11】Spark基本概念和运行模式

----本节内容------- 1.大数据基础 1.1大数据平台基本框架 1.2学习大数据的基础 1.3学习Spark的Hadoop基础 2.Hadoop生态基本介绍 2.1Hadoop生态组件介绍 ...

- IIS Web 服务器/ASP.NET 运行原理基本知识概念整理 转

转http://www.cnblogs.com/loongsoft/p/7272830.html IIS Web 服务器/ASP.NET 运行原理基本知识概念整理 前言: 记录 IIS 相 ...

- Spark 基本概念 & 安装

1. Spark 基本概念 1.0 官网 传送门 1.1 简介 Spark 是用于大规模数据处理的快如闪电的统一分析引擎. 1.2 速度 Spark 可以获得更高的性能,针对 batch 计算和流计算 ...

- AIFramework基本概念整理

AIFramework基本概念整理 本文介绍: 对天元 MegEngine 框架中的 Tensor, Operator, GradManager 等基本概念有一定的了解: 对深度学习中的前向传播.反向 ...

- spark基本概念

Client:客户端进程,负责提交作业到Master. Application:Spark Application的概念和Hadoop MapReduce中的类似,指的是用户编写的Spark应用程序, ...

- 西瓜书概念整理(chapter 1-2)

括号表示概念出现的其他页码, 如有兴趣协同整理,请到issue中认领章节 完整版见我的github:ahangchen 觉得还不错的话可以点个star ^_^ 第一章 绪论 Page2: 标记(lab ...

- IIS Web 服务器/ASP.NET 运行原理基本知识概念整理

前言: 记录 IIS 相关的笔记还是从公司笔试考核题开始的,问 Application Pool 与 AppDomain 的区别? 促使我对进程池进了知识的学习,所以记录一下学习 ...

随机推荐

- Linux 系统常用管理命令(精简笔记)

Linux是一套免费使用和自由传播的类Unix操作系统,下面的笔记是我从鸟菜中摘抄出来的重要命令,并进行了一定的排版,摒弃了一些用不到的乱七八糟的命令,目的是在生产环境中能够快速的定位并查询需要命令的 ...

- Dubbo如何支持本地调用?injvm方式解析

Dubbo是一个远程调用的框架,对于一个服务提供者,暴露了一个接口供外部消费者调用,那么对于提供者自己是否可以调用这个接口,需要什么特殊处理吗? 这篇文章就分享下Dubbo关于本地调用的实现机制,以及 ...

- abp vnext2.0之核心组件模块加载系统源码解析与简单应用

abp vnext是abp官方在abp的基础之上构建的微服务架构,说实话,看完核心组件源码的时候,很兴奋,整个框架将组件化的细想运用的很好,真的超级解耦.老版整个框架依赖Castle的问题,vnext ...

- asp.net core 3.x 身份验证-1涉及到的概念

前言 从本篇开始将围绕asp.net core身份验证写个小系列,希望你看完本系列后,脑子里对asp.net core的身份验证原理有个大致印象.至于身份验证是啥?与授权有啥联系?就不介绍了,太啰嗦. ...

- 痞子衡嵌入式:Ethos-U55,ARM首款面向Cortex-M的microNPU

大家好,我是痞子衡,是正经搞技术的痞子.今天痞子衡给大家介绍的是ARM Ethos-U55. ARM 前几天刚发布了 Cortex-M 家族最新一款内核 - Cortex-M55 以及首款面向 Cor ...

- 使用小书匠及markdown here编辑博客和微信公众号

1. 使用小书匠连接Evernote并发布笔记到博客园 1.1 小书匠初探 我平时的信息收集的主要方法是采用Pocket+Evernote. 简单来说: 如果访问到非常有用,而且是必须要立刻记录的内容 ...

- Codeforces_835

A.比较两人总时间. #include<bits/stdc++.h> using namespace std; int s,v1,v2,t1,t2; int main() { ios::s ...

- 题解 CSP2019-J2T4【加工零件】

这题我们要求的是啥呢?仔细读题可以发现,工人传送带的关系可以看成一个 \(n\) 个点和 \(m\) 条边的无向图,然后对于每组询问 \((a,L)\),其实就是问: \(1\) 到 \(a\) 有没 ...

- 2020牛客寒假算法基础集训营4 C : 子段乘积

C:子段乘积 考察点 : 线段树,尺取,乘法逆元 坑点 : 区间要做到不重不漏, long long 侃侃 : 这道题在比赛是写的尺取,但是写了半天发现不好处理除 0 问题(浮点错误),需要用到乘法逆 ...

- error C2338: No Q_OBJECT in the class with the signal (NodeCreator.cpp)

在Qt中,当派生类需要用到信号与槽机制时,有两个要求. 1.该类派生自QObject类. 2.类中有Q_OBJECT宏. 本次报错的原因就是因为没有在类中添加Q_OBJECT宏. 而我的出错原因更傻逼 ...