<爬虫实战>糗事百科

1.糗事百科段子.py

# 目标:爬取糗事百科段子信息(文字)

# 信息包括:作者头像,作者名字,作者等级,段子内容,好笑数目,评论数目

# 解析用学过的几种方法都实验一下①正则表达式.②BeautifulSoup③xpath

import requests

import re # 正则表达式

import json

from bs4 import BeautifulSoup # BS

from lxml import etree # xpath def get_one_page(url):

response = requests.get(url)

if response.status_code == 200:

return response.text

return None def zhengze_parse(html):

pattern = re.compile(

'<img src="//(.*?)".*?alt="(.*?)".*?<a.*?<div class=".*?">(.*?)</div>'

+ '.*?<div class=.*?<span>(.*?)</span>.*?<span class=".*?".*?<i.*?>(.*?)<'

+ '.*?<i.*?>(.*?)<',

re.S)

items = re.findall(pattern, html)

for item in items:

content = item[3].replace('<br/>', '').strip()

content = content.replace('\x01', '')

if item[5] == '京公网安备11010502031601号':

break

yield {

'image': "http://" + item[0],

'name': item[1],

'grade': item[2],

'content': content,

'fun_Num': item[4],

'com_Num': item[5]

} def soup_parse(html):

soup = BeautifulSoup(html, 'lxml')

for data in soup.find_all('div', class_='article'):

image = "http:" + data.img['src']

name = data.img['alt']

# 匿名用户没有等级

if name=="匿名用户":

grade = "匿名用户"

else:

grade = data.find('div', class_='articleGender').text

content = data.find('div', class_='content').span.text.strip()

fun_Num = data.find('i', class_='number').text

com_Num = data.find('a', class_='qiushi_comments').i.text yield {

'image': image,

'name': name,

'grade': grade,

'content': content,

'fun_Num': fun_Num,

'com_Num': com_Num,

} def xpath_parse(html):

html = etree.HTML(html)

for data in html.xpath('//div[@class="col1"]/div'):

image = "http:"+ str(data.xpath('.//img/@src')[0])

name = data.xpath('.//img/@alt')[0]

if name == '匿名用户':

grade = '匿名用户'

else:

grade = data.xpath('./div[1]/div/text()')[0]

content = data.xpath('./a/div/span/text()')[0:]

content = str(content).strip().replace('\\n','')

fun_Num = data.xpath('./div[2]/span[1]/i/text()')[0]

com_Num = data.xpath('.//div[2]/span[2]/a/i/text()')[0]

# print(image, name, grade, content, fun_Num, com_Num)

yield {

'image': image,

'name': name,

'grade': grade,

'content': content,

'fun_Num': fun_Num,

'com_Num': com_Num,

} def write_to_file(content, flag):

with open('糗百段子(' + str(flag) + ').txt', 'a', encoding='utf-8')as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n') def search(Num):

url = 'https://www.qiushibaike.com/text/page/' + str(Num) + '/'

html = get_one_page(url)

# 正则匹配不到匿名用户的等级,不会匹配匿名用户的段子,所以少一些数据

# 稍微加个判断逻辑就行了,懒得弄了

for item in zhengze_parse(html):

write_to_file(item, '正则表达式') for item in soup_parse(html):

write_to_file(item, 'BS4') for item in xpath_parse(html):

write_to_file(item, 'xpath')

page = str(Num)

print("正在爬取第" + page + '页') def main():

# 提供页码

for Num in range(1, 14):

search(Num)

print("爬取完成") if __name__ == '__main__':

# 入口

main()

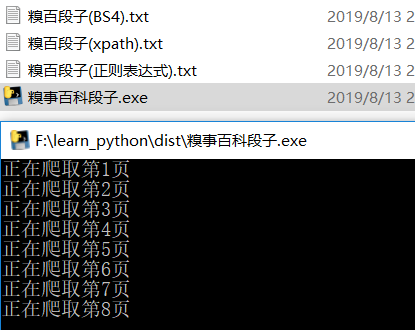

2.打包

pyinstaller -F 糗事百科段子.py

3.运行效果

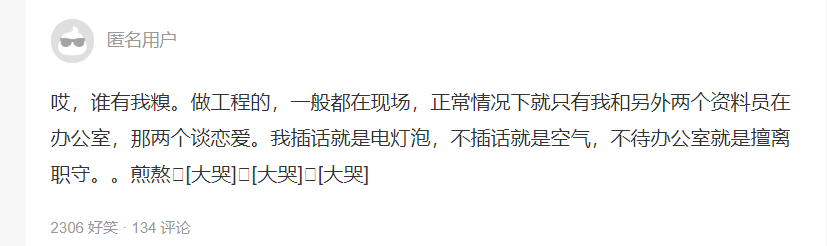

网页上匿名用户段子的显示情况

<爬虫实战>糗事百科的更多相关文章

- 爬虫_糗事百科(scrapy)

糗事百科scrapy爬虫笔记 1.response是一个'scrapy.http.response.html.HtmlResponse'对象,可以执行xpath,css语法来提取数据 2.提取出来的数 ...

- python scrapy实战糗事百科保存到json文件里

编写qsbk_spider.py爬虫文件 # -*- coding: utf-8 -*- import scrapy from qsbk.items import QsbkItem from scra ...

- Python爬虫_糗事百科

本爬虫任务: 爬虫糗事百科网站(https://www.qiushibaike.com/)--段子版块中所有的[段子].[投票数].[神回复]等内容 步骤: 通过翻页寻找url规律,构造url列表 查 ...

- 手动爬虫之糗事百科(ptyhon3)

一.调用封装的Url_ProxyHelper类,源码如下 import urllib.request as ur class Url_ProxyHelper: def __init__(self, u ...

- 8.Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- Python爬虫实战之爬取糗事百科段子【华为云技术分享】

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

随机推荐

- 关于提BUG的一点思考以及工作中总结的规范

在测试的工作中,提BUG是日常工作. 以前自己为了省事,省时,仅仅是截图,在图片上注明一下问题,就放到BUG库中了. 现在发现这样会造成开发的时间的浪费,增加了沟通成本. 对于BUG,当发现了异常时, ...

- python pip时openssl的错误

也不知道看了哪个方法弄成这个样子的,也没办法,下面方法可用 https://blog.csdn.net/chr1341901410/article/details/80995451

- 区分slice,splice,split

原文:https://www.cnblogs.com/webjoker/p/5218114.html 1.slice(数组) 用法:array.slice(start,end) 解释:该方法是对数组进 ...

- vue项目使用js-xlsx进行excel表格的导入和导出方法的简单原型封装

前提:已经安装好 file-saver xlsx和 script-loader,如未安装,请查看 https://www.cnblogs.com/luyuefeng/p/8031597.html 新建 ...

- java-day21

# DQL:查询语句 1. 排序查询 * 语法:order by 子句 * order by 排序字段1 排序方式1 , 排序字段2 排序方式2... ...

- 11-Ubuntu-根目录下各目录的功能详细介绍

转自: https://www.cnblogs.com/yudar/p/5809219.html 注:总结的非常详细

- Kettle 中的循环

说道循环,小伙伴们肯定不陌生,就是重复干一件事:而kettle中的循环一般是发生在job中,因为job是串行执行的: kettle的循环有两种,一种是通过js脚本,另外一种是通过遍历前面步骤返回的每一 ...

- Ubuntu16.04 使用PPA安装JDK8

安装Java 8 ( 支持 Ubuntu 10.04 - Ubuntu 16.04 ) 1.如果你在 Ubuntu 软件中心安装过 OpenJDK,请先使用如下命令将其删除: sudo apt-get ...

- 服务器搭建SVN

linux服务器搭建SVN https://blog.csdn.net/itbird58/article/details/80445521

- this.$router.push

跳转详情页this.$router.push({ path: `/activityDetails/${id}` })