python初探爬虫

python爬虫初探

爬取前50名豆瓣电影:

废话少说,直接上代码!

import re

import requests

from bs4 import BeautifulSoup

def get_content(url,):

try:

user_agent = "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.109 Safari/537.36"

response = requests.get(url, headers={'User-Agent': user_agent})

response.raise_for_status() # 如果返回的状态码不是200, 则抛出异常;

response.encoding = response.apparent_encoding # 判断网页的编码格式, 便于respons.text知道如何解码;

except Exception as e:

print("爬取错误")

else:

print(response.url)

print("爬取成功!")

return response.content

def parser_content(htmlContent):

# 实例化soup对象, 便于处理;

soup = BeautifulSoup(htmlContent, 'html.parser')

# 1). 电影信息存储在ol标签里面的li标签:

# <ol class="grid_view">

olObj = soup.find_all('ol', class_='grid_view')[0]

# 2). 获取每个电影的详细信息, 存储在li标签;

details = olObj.find_all('li')

for detail in details:

# # 3). 获取电影名称;

movieName = detail.find('span', class_='title').get_text()

# 4). 电影评分:

movieScore = detail.find('span', class_='rating_num').get_text()

# 5). 评价人数***************

# 必须要转换类型为字符串

movieCommentNum = str(detail.find(text=re.compile('\d+人评价')))

# 6). 电影短评

movieCommentObj = detail.find('span', class_='inq')

if movieCommentObj:

movieComment = movieCommentObj.get_text()

else:

movieComment = "无短评"

movieInfo.append((movieName, movieScore, movieCommentNum, movieComment))

import openpyxl

def create_to_excel(wbname, data, sheetname='Sheet1', ):

"""

将制定的信息保存到新建的excel表格中;

:param wbname:

:param data: 往excel中存储的数据;

:param sheetname:

:return:

"""

print("正在创建excel表格%s......" % (wbname))

# wb = openpyxl.load_workbook(wbname)

# 如果文件不存在, 自己实例化一个WorkBook的对象;

wb = openpyxl.Workbook()

# 获取当前活动工作表的对象

sheet = wb.active

# 修改工作表的名称

sheet.title = sheetname

# 将数据data写入excel表格中;

print("正在写入数据........")

for row, item in enumerate(data): # data发现有4行数据, item里面有三列数据;

print(item)

for column, cellValue in enumerate(item):

# cell = sheet.cell(row=row + 1, column=column + 1, value=cellValue)

cell = sheet.cell(row=row+1, column=column + 1)

cell.value = cellValue

wb.save(wbname)

print("保存工作薄%s成功......." % (wbname))

if __name__ == '__main__':

doubanTopPage = 2

perPage = 25

# [(), (), ()]

movieInfo = []

# 1, 2, 3 ,4, 5

for page in range(1, doubanTopPage+1):

# start的值= (当前页-1)*每页显示的数量(25)

url = "https://movie.douban.com/top250?start=%s" %((page-1)*perPage)

content = get_content(url)

parser_content(content)

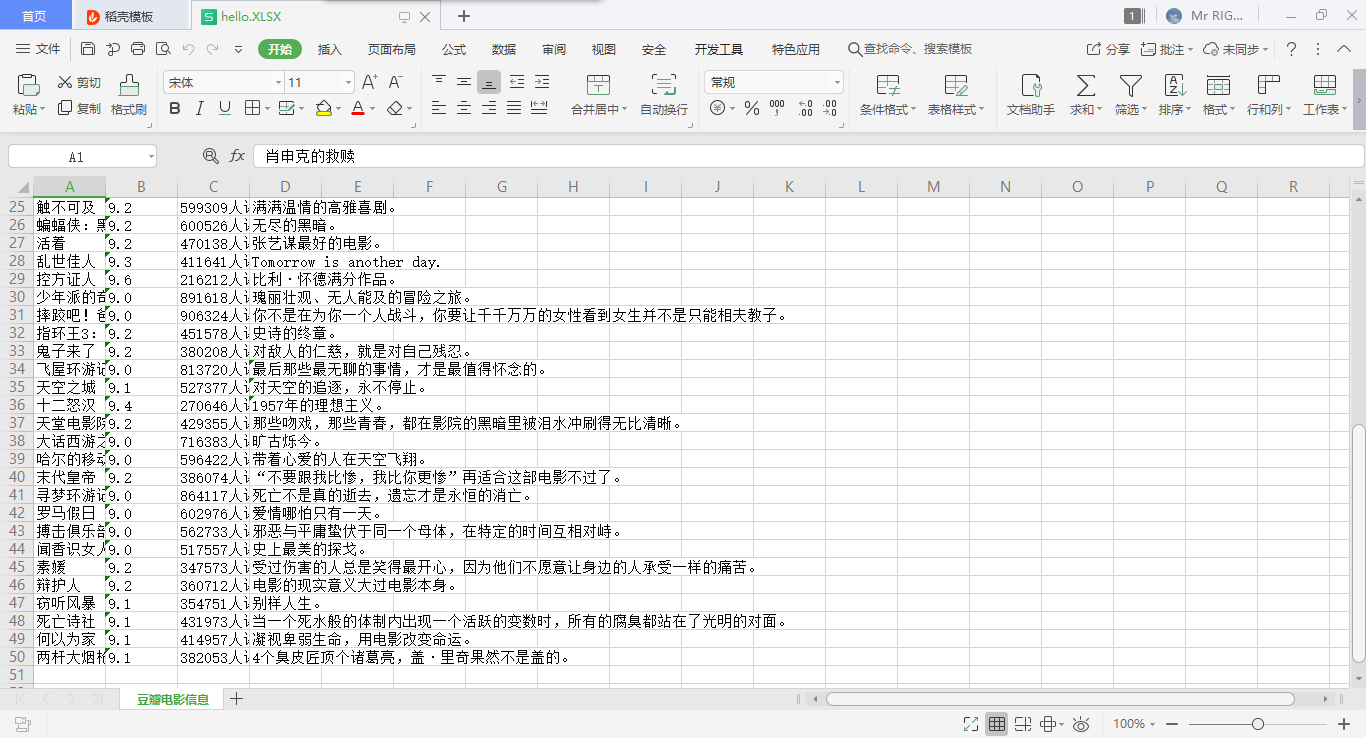

create_to_excel('/tmp/hello.xlsx', movieInfo, sheetname="豆瓣电影信息")

如果你是直接复制粘贴的,那你这里一定会出现一大串儿红字

解决办法:

创建一个tmp文件夹里边存一个hello.xlsx

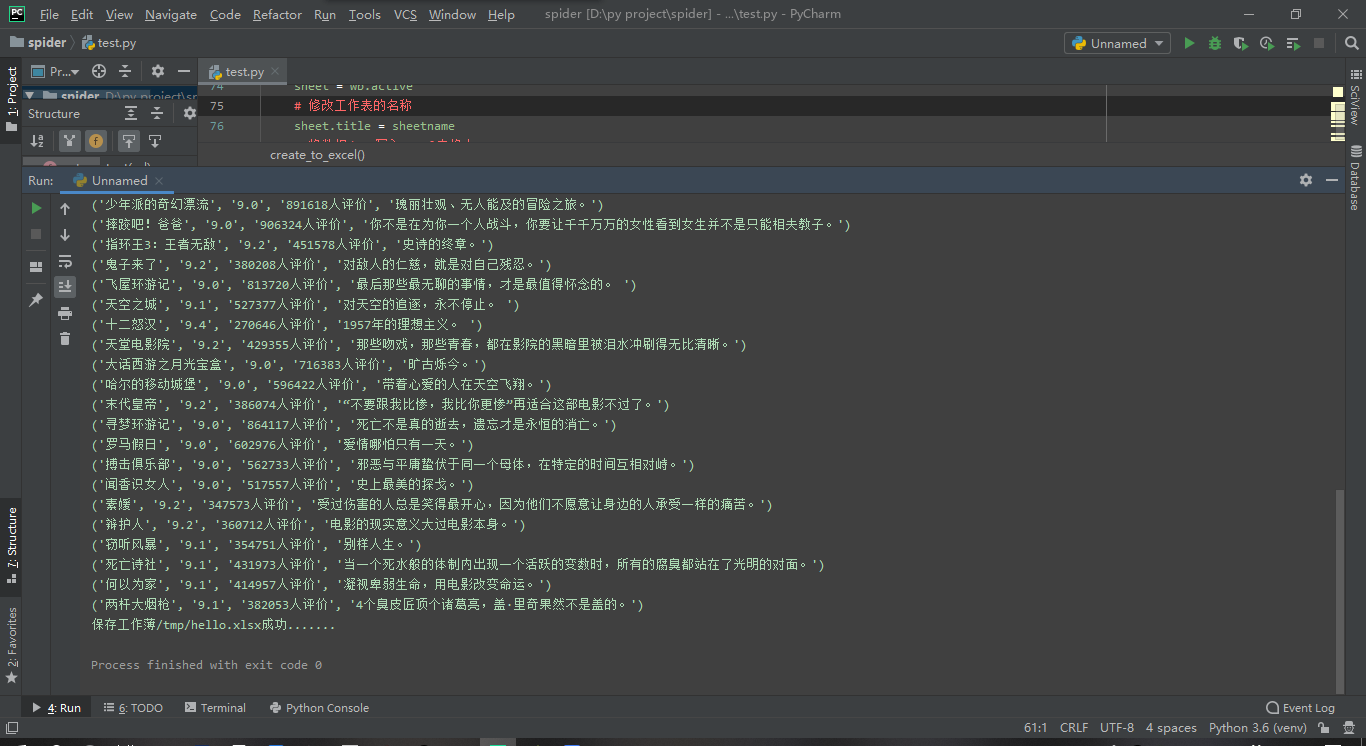

运行截图:

python初探爬虫的更多相关文章

- Python简单爬虫入门三

我们继续研究BeautifulSoup分类打印输出 Python简单爬虫入门一 Python简单爬虫入门二 前两部主要讲述我们如何用BeautifulSoup怎去抓取网页信息以及获取相应的图片标题等信 ...

- Ubuntu下配置python完成爬虫任务(笔记一)

Ubuntu下配置python完成爬虫任务(笔记一) 目标: 作为一个.NET汪,是时候去学习一下Linux下的操作了.为此选择了python来边学习Linux,边学python,熟能生巧嘛. 前期目 ...

- Python简单爬虫入门二

接着上一次爬虫我们继续研究BeautifulSoup Python简单爬虫入门一 上一次我们爬虫我们已经成功的爬下了网页的源代码,那么这一次我们将继续来写怎么抓去具体想要的元素 首先回顾以下我们Bea ...

- [Python] 网络爬虫和正则表达式学习总结

以前在学校做科研都是直接利用网上共享的一些数据,就像我们经常说的dataset.beachmark等等.但是,对于实际的工业需求来说,爬取网络的数据是必须的并且是首要的.最近在国内一家互联网公司实习, ...

- python简易爬虫来实现自动图片下载

菜鸟新人刚刚入住博客园,先发个之前写的简易爬虫的实现吧,水平有限请轻喷. 估计利用python实现爬虫的程序网上已经有太多了,不过新人用来练手学习python确实是个不错的选择.本人借鉴网上的部分实现 ...

- GJM : Python简单爬虫入门(二) [转载]

感谢您的阅读.喜欢的.有用的就请大哥大嫂们高抬贵手"推荐一下"吧!你的精神支持是博主强大的写作动力以及转载收藏动力.欢迎转载! 版权声明:本文原创发表于 [请点击连接前往] ,未经 ...

- Python分布式爬虫原理

转载 permike 原文 Python分布式爬虫原理 首先,我们先来看看,如果是人正常的行为,是如何获取网页内容的. (1)打开浏览器,输入URL,打开源网页 (2)选取我们想要的内容,包括标题,作 ...

- Python 网页爬虫 & 文本处理 & 科学计算 & 机器学习 & 数据挖掘兵器谱(转)

原文:http://www.52nlp.cn/python-网页爬虫-文本处理-科学计算-机器学习-数据挖掘 曾经因为NLTK的缘故开始学习Python,之后渐渐成为我工作中的第一辅助脚本语言,虽然开 ...

- 关于Python网络爬虫实战笔记③

Python网络爬虫实战笔记③如何下载韩寒博客文章 Python网络爬虫实战笔记③如何下载韩寒博客文章 target:下载全部的文章 1. 博客列表页面规则 也就是, http://blog.sina ...

随机推荐

- 在Visual C++中使用内联汇编

一.内联汇编的优缺点 因为在Visual C++中使用内联汇编不需要额外的编译器和联接器,且可以处理Visual C++中不能处理的一些事情,而且可以使用在C/C++中的变量,所以非常方便.内联汇编主 ...

- fiddler抓包工具详解

转自:http://www.cnblogs.com/yyhh/p/5140852.html Fiddler 抓包工具总结 阅读目录 1. Fiddler 抓包简介 1). 字段说明 2). Sta ...

- 搭建单机版spark

二.下载软件 JDK,Scala,SBT,Maven 版本信息如下: JDK jdk-7u79-linux-x64.gz Scala scala-2.10.5.tgz 三.解压上述文件并进行环境变量配 ...

- 输入流当中的read方法和readfully方法的区别与原理

原文链接:https://blog.csdn.net/yangjingyuan/article/details/6151234?locationNum=3 DataInputStream类中的read ...

- Codeforces 1191B Tokitsukaze and Mahjong

题目链接:http://codeforces.com/problemset/problem/1191/B 题意:类似于麻将,三个一样花色一样数字的,或者三个同花顺就赢了,新抽的能当任何类型,问至少几个 ...

- 拾遗:Vim 批量删除匹配到的行

删除包含特定字符的行 g/pattern/d (全局删除匹配行) ,5g/pattern/d (删除第1-5行里的匹配行) 删除不包含指定字符的行 v/pattern/d g!/pattern/d ( ...

- cesium相关学习网址

cesium相关学习网址: cesium资料大全网址:https://www.cnblogs.com/cesium1/p/10062942.html http://192.168.101. ...

- playbackRate控制音频播放倍速

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- 前端(十四)—— JavaScript常用类:Number、Date类、字符串、数组、Math类、正则

JS常用类:Number类.Date类.Math类.字符串.数组.正则 一.Number 1.常用数字 整数:10 小数:3.14 科学计数法:1e5 | 1e-5 正负无穷:Infinity | - ...

- Ubuntu12.04下删除文件夹内所有的.svn文件

前段时间在公司里遇到一个问题,从svn上下载下来的文件含有.svn文件,如何删除当前目录下的所有.svn文件呢? 一个个手动删除显然不可能,太多了.其实在Ubuntu12.04下延伸至其他所搜的Lin ...