常用损失函数 LossFunction

文章结构

- 损失函数在神经网络中的位置

- 常用的损失函数(结构:解释,公式,缺点,适用于,pytorch 函数)

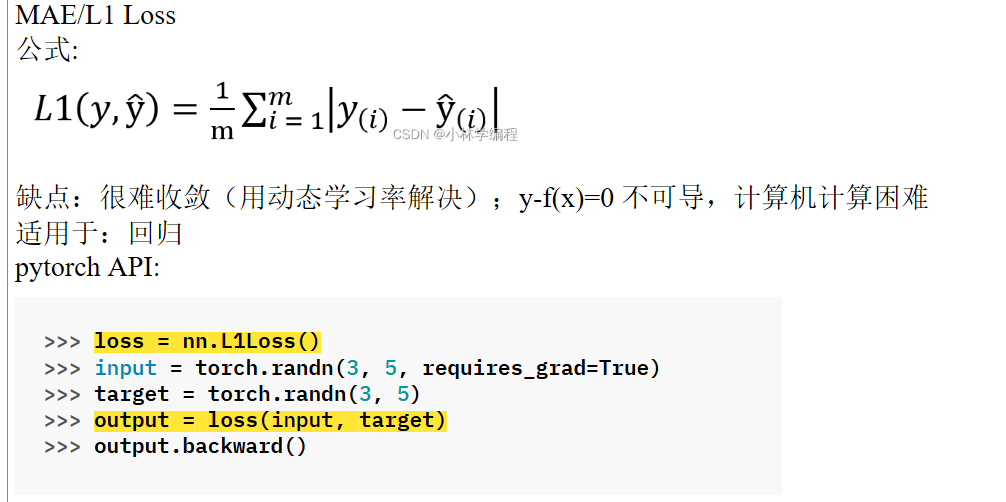

- MAE/L1 Loss

- MSE/L2 Loss

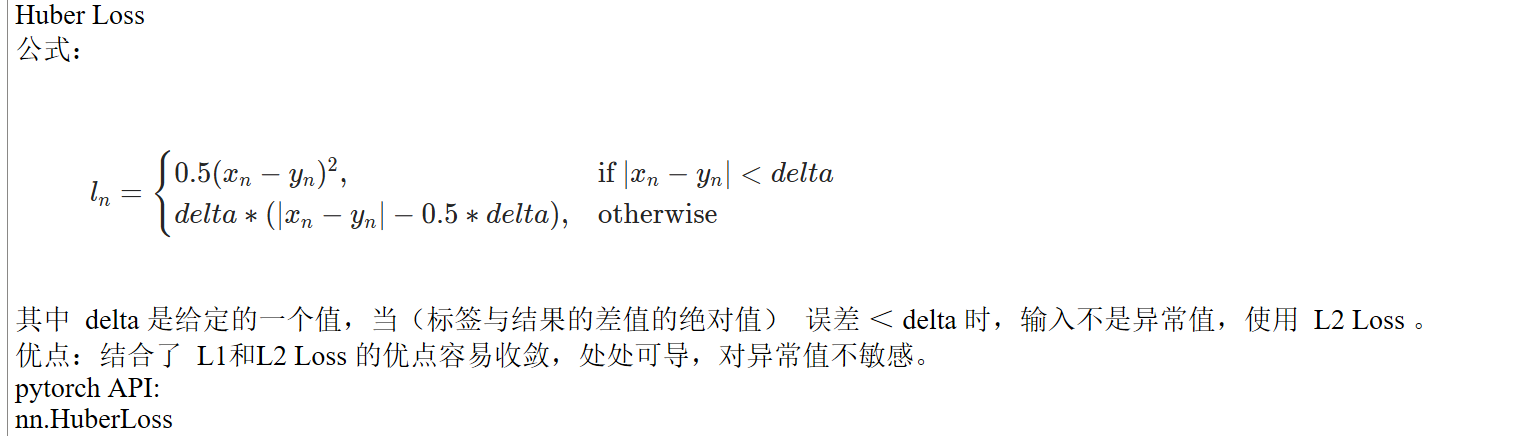

- Huber Loss

- 对信息量、熵的解释

- relative entropy 相对熵/ Kullback-Leibler KL Loss

- Cross Entropy Loss 交叉熵(包含对softmax 层的解释)

- 相对熵、熵、和交叉熵的关系

- Hinge Loss

损失函数在神经网络中的位置

forward → loss → backward

常用的损失函数

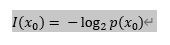

信息量

由香农引入,可以理解为对事件X发生概率的估计。一件事越经常发生,就越容易预测,它所包含的信息量就越小。

公式:

其中,  表示信息量,

表示信息量, 表示事件X中的一个种类,

表示事件X中的一个种类,  表示该种类的概率分布。

表示该种类的概率分布。

取对数  是为了方便计算,接下来都用简写

是为了方便计算,接下来都用简写 代替。

代替。

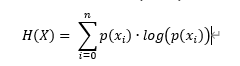

熵

每个种类的发生概率与信息量的乘积和,表示一个系统不确定性或混乱程度。

对于系统的不确定性可以理解为,由概率分布计算得到的信息量越大,表示越不容易预测,同时意味着并不遵循一定的规律,越混乱/不确定。

公式:

其中 , 表示熵,求和上标

表示熵,求和上标 表示事件X的种类/分类的个数(举例,掷硬币这一事件的种类有正、反2种),

表示事件X的种类/分类的个数(举例,掷硬币这一事件的种类有正、反2种),  表示第i种类的概率分布。

表示第i种类的概率分布。

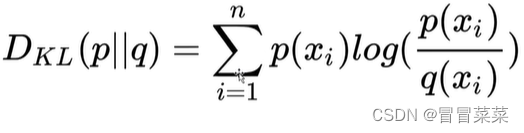

relative entropy 相对熵/ Kullback-Leibler KL Loss

、

、 为 事件X 中取值的两个概率分布,

为 事件X 中取值的两个概率分布, 对

对 的相对熵(≥ 0 ):

的相对熵(≥ 0 ):

公式引用自:http://t.csdnimg.cn/hRb5X

这里的两个概率分布可以是(由标签/target 计算得到的)真实概率 和模型预测概率

和模型预测概率 。

。

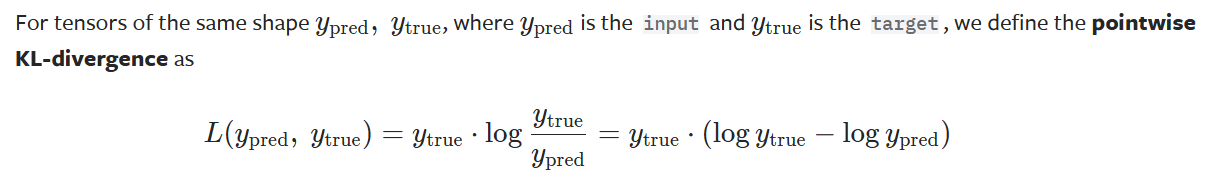

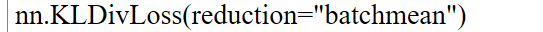

在pytorch 官方文档中 KLDivLoss — PyTorch 2.3 documentation 解释为

pytorch 函数:

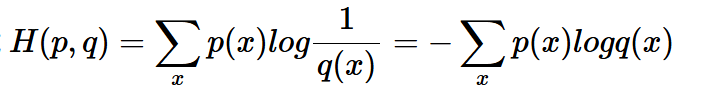

Cross Entropy Loss 交叉熵

公式:

表示 真实概率 和预测概率

和预测概率 的差距。

的差距。

公式引用自详解机器学习中的熵、条件熵、相对熵和交叉熵 - 遍地胡说 - 博客园 (cnblogs.com)

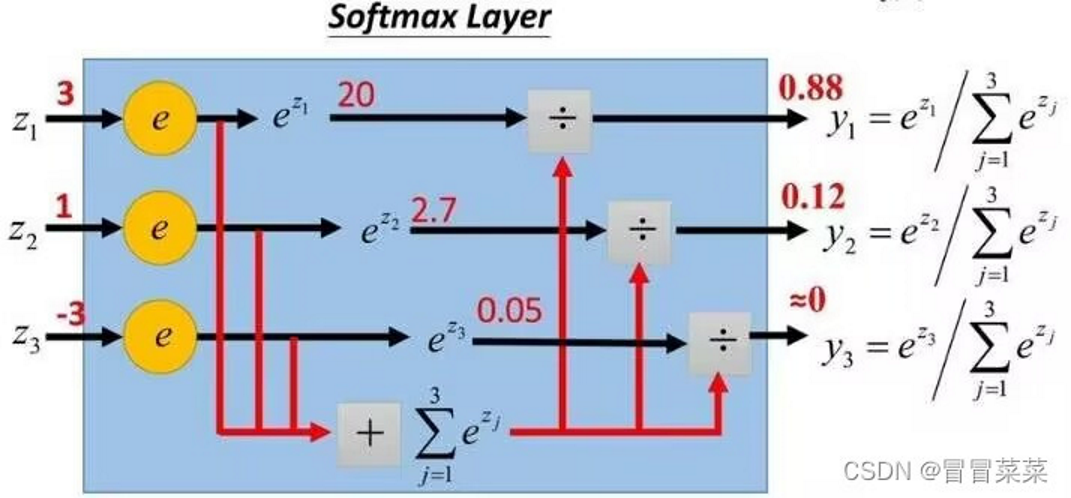

其中, 在实际运用中,由 softmax 层 计算得到 。

在实际运用中,由 softmax 层 计算得到 。

Softmax 层输出的是每个分类的概率分布,将数字转化为概率。

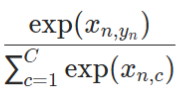

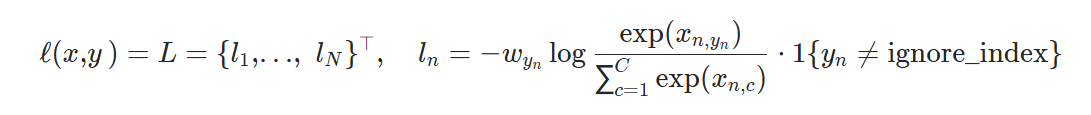

在pytorch 官方文档中,其中 是一个1D 的张量,为每个类别分配权重,C 为事件的分类总数,相当于上文中的n。

是一个1D 的张量,为每个类别分配权重,C 为事件的分类总数,相当于上文中的n。

为softmax的输出。

为softmax的输出。

适用于:分类;样本分布不平衡的训练集

pytorch 函数:

其中,官方文档解释,input不需要normalize。

常用损失函数 LossFunction的更多相关文章

- 【深度学习】一文读懂机器学习常用损失函数(Loss Function)

最近太忙已经好久没有写博客了,今天整理分享一篇关于损失函数的文章吧,以前对损失函数的理解不够深入,没有真正理解每个损失函数的特点以及应用范围,如果文中有任何错误,请各位朋友指教,谢谢~ 损失函数(lo ...

- pytorch常用损失函数

损失函数的基本用法: criterion = LossCriterion() #构造函数有自己的参数 loss = criterion(x, y) #调用标准时也有参数 得到的loss结果已经对min ...

- 损失函数 hinge loss vs softmax loss

1. 损失函数 损失函数(Loss function)是用来估量你模型的预测值 f(x) 与真实值 Y 的不一致程度,它是一个非负实值函数,通常用 L(Y,f(x)) 来表示. 损失函数越小,模型的鲁 ...

- [AI]神经网络章3 损失函数

损失函数 作用 在有监督的学习中,需要衡量神经网络输出和所预期的输出之间的差异大小.这种误差函数需要能够反映出当前网络输出和实际结果之间一种量化之后的不一致程度,也就是说函数值越大,反映出模型预测的结 ...

- 机器学习中的损失函数 (着重比较:hinge loss vs softmax loss)

https://blog.csdn.net/u010976453/article/details/78488279 1. 损失函数 损失函数(Loss function)是用来估量你模型的预测值 f( ...

- 对于分类问题的神经网络最后一层的函数:sigmoid、softmax与损失函数

对于分类问题的神经网络最后一层的函数做如下知识点总结: sigmoid和softmax一般用作神经网络的最后一层做分类函数(备注:sigmoid也用作中间层做激活函数): 对于类别数量大于2的分类问题 ...

- [ch03-00] 损失函数

系列博客,原文在笔者所维护的github上:https://aka.ms/beginnerAI, 点击star加星不要吝啬,星越多笔者越努力. 第3章 损失函数 3.0 损失函数概论 3.0.1 概念 ...

- [PyTorch 学习笔记] 4.2 损失函数

本章代码: https://github.com/zhangxiann/PyTorch_Practice/blob/master/lesson4/loss_function_1.py https:// ...

- Tensorflow 2.0 深度学习实战 —— 详细介绍损失函数、优化器、激活函数、多层感知机的实现原理

前言 AI 人工智能包含了机器学习与深度学习,在前几篇文章曾经介绍过机器学习的基础知识,包括了监督学习和无监督学习,有兴趣的朋友可以阅读< Python 机器学习实战 >.而深度学习开始只 ...

- 深度学习常见的优化方法(Optimizer)总结:Adam,SGD,Momentum,AdaGard等

机器学习的常见优化方法在最近的学习中经常遇到,但是还是不够精通.将自己的学习记录下来,以备不时之需 基础知识: 机器学习几乎所有的算法都要利用损失函数 lossfunction 来检验算法模型的优劣, ...

随机推荐

- 龙哥量化:通达信板块概念FAQ,*期强势、*期弱势是怎么划分的?等问题是官网的解释,股友可以根据文章的提示迸发策略灵感

如果您需要代写公式, 请联系我. 龙哥QQ:591438821 龙哥微信:Long622889 比如第9条,*期强势:20日涨幅>=30%, 3日涨幅>0,非停牌.非ST.非未开板 ...

- Opencv 中 Mat中元素的值读取方法总结

1.利用 at 函数读取 (1)单通道图像读取方式 Mat img1 = imread(filename,IMREAD_GRAYSCALE); for( size_t nrow = 0; nrow & ...

- Matlab R2009b 版 license 到期问题

打开2009b Matlab,反复提示需要激活,是lisense到期了,到期时间2017年11月11日.解决方法: 将以下内容替换 Matlab 安装路径下 license/*.lic 文件中的所有内 ...

- JMeter JDBC 请求实战宝典

<JMeter JDBC 请求实战宝典> 宝子们,今天咱就来唠唠 JMeter 里超厉害的 JDBC 请求,这玩意儿就像是数据库世界的神奇魔杖,能帮咱把数据库里的各种秘密(数据)都挖出来, ...

- CDS标准视图:测量点数据 I_MeasuringPointData

视图名称:测量点数据 I_MeasuringPointData 视图类型:基础视图 视图代码: 点击查看代码 @AbapCatalog.sqlViewName: 'IMEASPOINTDATA' @A ...

- unordered_map比map慢?

先说结论:unordered_map不维护键的顺序,因此不能按顺序访问元素,因此如果你需要遍历表时若选用unordered_map就肯定比map慢 1. 数据结构与底层实现 unordered_map ...

- UWP ManipulationStarted 移动图片或控件不要滑出父容器的判断

假设自定义一个用户控件用以在父容器Grid里拖动/移动: <UserControl x:Class="App6.Pic" xmlns="http://schemas ...

- uwp 图片剪切

public async void BitmapTransformAndSaveTest() { var uncroppedfile = await Windows.Storage.Applicati ...

- 深入理解ReentrantLock的实现原理

文章目录ReentrantLock简介AQS回顾ReentrantLock原理ReentrantLock结构非公平锁的实现原理lock方法获取锁tryRelease锁的释放公平锁的实现原理lock方法 ...

- CRT优化RSA

转载:利用中国剩余定理加速 RSA RSA 作为世界上使用最为流行的公钥密码算法,被广泛应用在数据加密和数字签名上. 为了提高加密和签名验证的效率,一般会将RSA的加密指数(一般是公钥位数)设置的较小 ...