其它语言通过HiveServer2访问Hive

先解释一下几个名词:

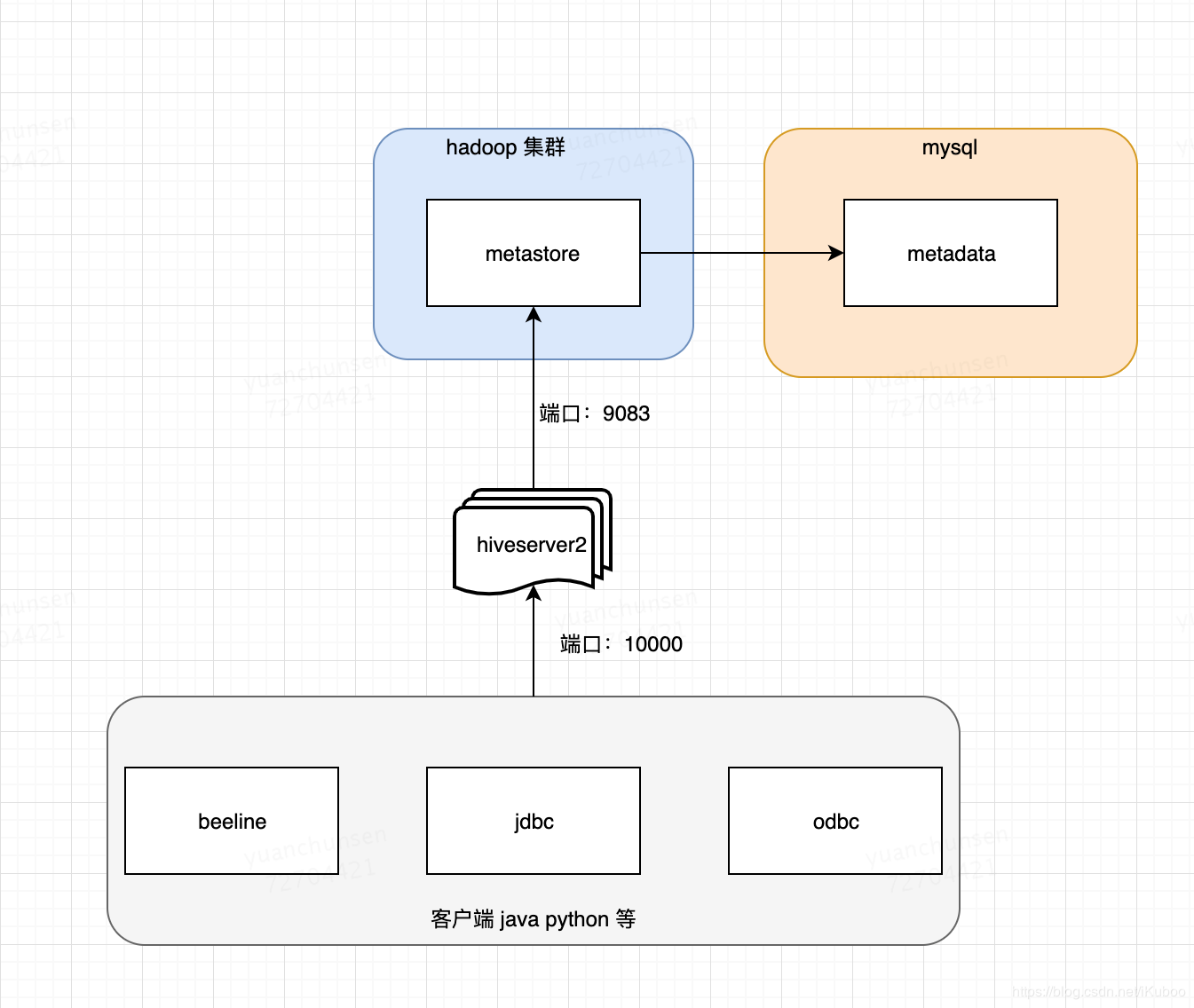

metadata :hive元数据,即hive定义的表名,字段名,类型,分区,用户这些数据。一般存储关系型书库mysql中,在测试阶段也可以用hive内置Derby数据库。

metastore :hivestore服务端。主要提供将DDL,DML等语句转换为MapReduce,提交到hdfs中。

hiveserver2:hive服务端。提供hive服务。客户端可以通过beeline,jdbc(即用java代码链接)等多种方式链接到hive。

beeline:hive客户端链接到hive的一个工具。可以理解成mysql的客户端。如:navite cat 等。

其它语言访问hive主要是通过hiveserver2服务,HiveServer2(HS2)是一种能使客户端执行Hive查询的服务。HiveServer2可以支持对 HiveServer2 的嵌入式和远程访问,支持多客户端并发和身份认证。旨在为开放API客户端(如JDBC和ODBC)提供更好的支持。

会启动一个hive服务端默认端口为:10000,可以通过beeline,jdbc,odbc的方式链接到hive。hiveserver2启动的时候会先检查有没有配置hive.metastore.uris,如果没有会先启动一个metastore服务,然后在启动hiveserver2。如果有配置hive.metastore.uris。会连接到远程的metastore服务。这种方式是最常用的。部署在图如下:

Python连接Hive

Python3访问hive需要安装的依赖有:

- pip3 install thrift

- pip3 install PyHive

- pip3 install sasl

- pip3 install thrift_sasl

这里有一个Python访问Hive的工具类:

# -*- coding:utf-8 -*-

from pyhive import hive

class HiveClient(object):

"""docstring for HiveClient"""

def __init__(self, host='hadoop-master',port=10000,username='hadoop',password='hadoop',database='hadoop',auth='LDAP'):

"""

create connection to hive server2

"""

self.conn = hive.Connection(host=host,

port=port,

username=username,

password=password,

database=database,

auth=auth)

def query(self, sql):

"""

query

"""

with self.conn.cursor() as cursor:

cursor.execute(sql)

return cursor.fetchall()

def insert(self, sql):

"""

insert action

"""

with self.conn.cursor() as cursor:

cursor.execute(sql)

# self.conn.commit()

# self.conn.rollback()

def close(self):

"""

close connection

"""

self.conn.close()

使用的时候,只需要导入,然后创建一个对象实例即可,传入sql调用query方法完成查询。

# 拿一个连接

hclient = hive.HiveClient()

# 执行查询操作

...

# 关闭连接

hclient.close()

注意:在insert插入方法中,我将self.conn.commit()和self.conn.rollback()即回滚注释了,这是传统关系型数据库才有的事务操作,Hive中是不支持的。

Java连接Hive

Java作为大数据的基础语言,连接hive自然是支持的很好的,这里介绍通过jdbc和mybatis两种方法连接hive。

1. Jdbc连接

java通过jdbc连接hiveserver,跟传统的jdbc连接mysql方法一样。

需要hive-jdbc依赖:

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-jdbc</artifactId>

<version>1.2.1</version>

</dependency>

代码跟连接mysql套路一样,都是使用的DriverManager.getConnection(url, username, password):

@NoArgsConstructor

@AllArgsConstructor

@Data

@ToString

public class HiveConfigModel {

private String url = "jdbc:hive2://localhost:10000";

private String username = "hadoop";

private String password = "hadoop";

}

@Test

public void test(){

// 初始化配置

HiveConfigModel hiveConfigModel = ConfigureContext.getInstance("hive-config.properties")

.addClass(HiveConfigModel.class)

.getModelProperties(HiveConfigModel.class);

try {

Connection conn = DriverManager.getConnection(hiveConfigModel.getUrl(),

hiveConfigModel.getUsername(), hiveConfigModel.getPassword());

String sql = "show tables";

PreparedStatement preparedStatement = conn.prepareStatement(sql);

ResultSet rs = preparedStatement.executeQuery();

List<String> tables = new ArrayList<>();

while (rs.next()){

tables.add(rs.getString(1));

}

System.out.println(tables);

} catch (SQLException e) {

e.printStackTrace();

}

}

在hive-jdbc-1.2.1.jar的META-INF下有个services目录,里面有个java.sql.Driver文件,内容是:

org.apache.hive.jdbc.HiveDriver

java.sql.DriverManager使用spi实现了服务接口与服务实现分离以达到解耦,在这里jdbc的实现org.apache.hive.jdbc.HiveDriver根据java.sql.Driver提供的统一规范实现逻辑。客户端使用jdbc时不需要去改变代码,直接引入不同的spi接口服务即可。

DriverManager.getConnection(url, username, password)

这样即可拿到连接,前提是具体实现需要遵循相应的spi规范。

2. 整合mybatis

通常都会使用mybatis来做dao层访问数据库,访问hive也是类似的。

配置文件sqlConfig.xml:

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE configuration PUBLIC "-//mybatis.org//DTD Config 3.0//EN"

"http://mybatis.org/dtd/mybatis-3-config.dtd">

<configuration>

<environments default="production">

<environment id="production">

<transactionManager type="JDBC"/>

<dataSource type="POOLED">

<property name="driver" value="org.apache.hive.jdbc.HiveDriver"/>

<property name="url" value="jdbc:hive2://master:10000/default"/>

<property name="username" value="hadoop"/>

<property name="password" value="hadoop"/>

</dataSource>

</environment>

</environments>

<mappers>

<mapper resource="mapper/hive/test/test.xml"/>

</mappers>

</configuration>

mapper代码省略,实现代码:

public classTestMapperImpl implements TestMapper {

private static SqlSessionFactory sqlSessionFactory = HiveSqlSessionFactory.getInstance().getSqlSessionFactory();

@Override

public int getTestCount(String dateTime) {

SqlSession sqlSession = sqlSessionFactory.openSession();

TestMapper testMapper = sqlSession.getMapper(TestMapper.class);

int count = testMapper.getTestCount(dateTime);

sqlSession.close();

return count;

}

}

其它语言通过HiveServer2访问Hive的更多相关文章

- Spark&Hive:如何使用scala开发spark访问hive作业,如何使用yarn resourcemanager。

背景: 接到任务,需要在一个一天数据量在460亿条记录的hive表中,筛选出某些host为特定的值时才解析该条记录的http_content中的经纬度: 解析规则譬如: 需要解析host: api.m ...

- Hive基础(2)---(启动HiveServer2)Hive严格模式

启动方式 1, hive 命令行模式,直接输入/hive/bin/hive的执行程序,或者输入 hive –service cli 用于linux平台命令行查询,查询语句基本跟mysql查询语句类似 ...

- ODBC database driver for Go:Go语言通过ODBC 访问SQL server

Go语言通过ODBC 访问SQL server,这里需要用到go-odbc库,开源地址::https://github.com/weigj/go-odbc 一.驱动安装 在cmd中打开GOPATH: ...

- SparkSQL On Yarn with Hive,操作和访问Hive表

转载自:http://lxw1234.com/archives/2015/08/466.htm 本文将介绍以yarn-cluster模式运行SparkSQL应用程序,访问和操作Hive中的表,这个和在 ...

- 使用spark访问hive错误记录

在spark集群中执行./spark-shell时报以下错误: 18/07/23 10:02:39 WARN DataNucleus.Connection: BoneCP specified but ...

- Spark访问Hive表

知识点1:Spark访问HIVE上面的数据 配置注意点:. 1.拷贝mysql-connector-java-5.1.38-bin.jar等相关的jar包到你${spark_home}/lib中(sp ...

- spark on yarn模式下配置spark-sql访问hive元数据

spark on yarn模式下配置spark-sql访问hive元数据 目的:在spark on yarn模式下,执行spark-sql访问hive的元数据.并对比一下spark-sql 和hive ...

- pyinstaller打包python源程序访问hive

1.需求 使用hvie server一段时间后,业务部门需要自己不定时的查询业务数据,之前这一块都是他们提需求我们来做,后来发现这样重复一样的工作放在我们这边做是在没有效率,遂提出给他们工具或者web ...

- 访问hive显示原数据报错

访问hive报错如下: FAILED: SemanticException org.apache.hadoop.hive.ql.metadata.HiveException: java.lang.Ru ...

随机推荐

- IDEA主题加高亮

IntelliJ Idea的黑色主题,使用就是file-->import settings 选择压缩包里的jar包,主题就被导入了,之后会提示重启,重启完就可以在设置中使用了. IDEA主题下载 ...

- java中高级面试利器(boot,cloud,vue前后端提升)

https://github.com/Snailclimb/JavaGuide Java知识大全(面试) https://github.com/doocs/advanced-java Java工 ...

- 下载器Folx如何实现排队下载功能

用户在下载多个文件时,当然会希望这些文件都能同时下载,以达到短时间内完成下载任务的目的.但另一方面来说,同时下载过多文件,会分散带宽资源,降低了每个文件的下载速度,从而导致下载时间的延长. 为了实现多 ...

- GAN和GAN的改进

GAN 原始GAN中判别器要最小化如下损失函数,尽可能把真实样本分为正例,生成样本分为负例: 其中是真实样本分布,是由生成器产生的样本分布. 第一个式子我们不看梯度符号的话即为判别器的损失函数,log ...

- Docker中搭建FastDFS文件系统(多图)

关于FastDFS FastDFS 是以 C 语言开发的一项开源轻量级分布式文件系统,他对文件进行管理,主要功能有:文件存储,文件同步,文件访问(文件上传/下载)等,特别适合以文件为载体的在线服务,如 ...

- maven私服拉取jar失败(内网)

解决方案: 1.私服没jar,找私服负责人添加 2.私服有拉不下来,重启nexus服务端(负责人做) 3.本地有jar但是idea中没找到,先执行一下reimport,不行的话,随意修改下pom文件, ...

- PyQt学习随笔:槽函数获取信号发送对象的方法

在PyQt中,相似控件发送的信号可以每个控件信号对应一个槽函数,也可以将相似控件的相同信号对应到一个槽函数,但如果槽函数相同,怎么区分信号是谁发送的呢?那就是在信号函数中使用sender()函数获取信 ...

- PyQt(Python+Qt)学习随笔:Qt Designer中部件的样式表styleSheet属性

styleSheet属性是定义部件外观的属性样式表,在Qt中styleSheet样式表是类似于html的css样式一样的方法,只是时专门为Qt中的部件开发的.styleSheet的定义语法也是类似CS ...

- APP软件系统测试

1.功能模块测试 2.交叉事件测试 3.压力测试 存储压力测试 边界压力测试 响应能力压力测试 网络流量测试 4.容量测试 5.安装卸载测试 6.易用性.用户体验测试 7.UI界面测试

- 团队作业 需求改进&系统设计

PaChat聊天系统 一.需求&原型改进: 1.针对课堂讨论环节老师和其他组的问题及建议,对修改选题及需求进行修改 问题1:功能划分条理不够清晰. 修改1:改为流程图的形式. 问题2:功能不能 ...