手把手教你使用LabVIEW OpenCV dnn实现图像分类(含源码)

@

前言

上一篇和大家一起分享了如何使用LabVIEW OpenCV dnn实现手写数字识别,今天我们一起来看一下如何使用LabVIEW OpenCV dnn实现图像分类。

一、什么是图像分类?

1、图像分类的概念

图像分类,核心是从给定的分类集合中给图像分配一个标签的任务。实际上,这意味着我们的任务是分析一个输入图像并返回一个将图像分类的标签。标签总是来自预定义的可能类别集。

示例:我们假定一个可能的类别集categories = {dog, cat, eagle},之后我们提供一张图片(下图)给分类系统。这里的目标是根据输入图像,从类别集中分配一个类别,这里为eagle,我们的分类系统也可以根据概率给图像分配多个标签,如eagle:95%,cat:4%,panda:1%

2、MobileNet简介

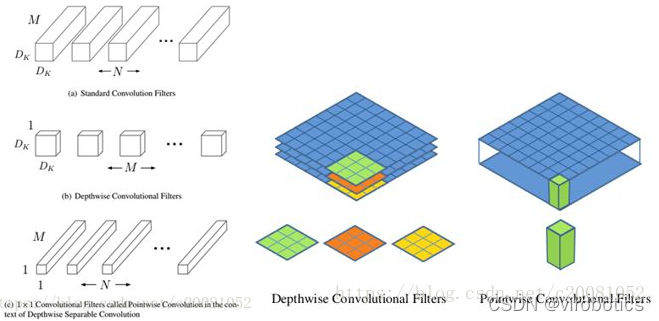

MobileNet:基本单元是深度级可分离卷积(depthwise separable convolution),其实这种结构之前已经被使用在Inception模型中。深度级可分离卷积其实是一种可分解卷积操作(factorized convolutions),其可以分解为两个更小的操作:depthwise convolution和pointwise convolution,如图1所示。Depthwise convolution和标准卷积不同,对于标准卷积其卷积核是用在所有的输入通道上(input channels),而depthwise convolution针对每个输入通道采用不同的卷积核,就是说一个卷积核对应一个输入通道,所以说depthwise convolution是depth级别的操作。而pointwise convolution其实就是普通的卷积,只不过其采用1x1的卷积核。图2中更清晰地展示了两种操作。对于depthwise separable convolution,其首先是采用depthwise convolution对不同输入通道分别进行卷积,然后采用pointwise convolution将上面的输出再进行结合,这样其实整体效果和一个标准卷积是差不多的,但是会大大减少计算量和模型参数量。

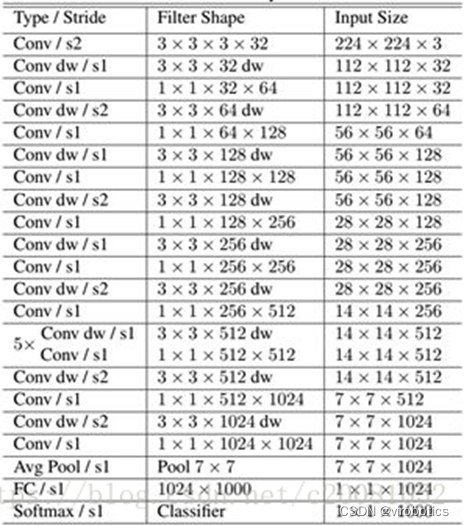

MobileNet的网络结构如表所示。首先是一个3x3的标准卷积,然后后面就是堆积depthwise separable convolution,并且可以看到其中的部分depthwise convolution会通过strides=2进行down sampling。然后采用average pooling将feature变成1x1,根据预测类别大小加上全连接层,最后是一个softmax层。如果单独计算depthwise convolution和pointwise convolution,整个网络有28层(这里Avg Pool和Softmax不计算在内)。

二、使用python实现图像分类(py_to_py_ssd_mobilenet.py)

1、获取预训练模型

- 使用tensorflow.keras.applications获取模型(以mobilenet为例);

from tensorflow.keras.applications import MobileNet

original_tf_model = MobileNet(

include_top=True,

weights="imagenet"

)

- 把original_tf_model打包成pb

def get_tf_model_proto(tf_model):

# define the directory for .pb model

pb_model_path = "models"

# define the name of .pb model

pb_model_name = "mobilenet.pb"

# create directory for further converted model

os.makedirs(pb_model_path, exist_ok=True)

# get model TF graph

tf_model_graph = tf.function(lambda x: tf_model(x))

# get concrete function

tf_model_graph = tf_model_graph.get_concrete_function(

tf.TensorSpec(tf_model.inputs[0].shape, tf_model.inputs[0].dtype))

# obtain frozen concrete function

frozen_tf_func = convert_variables_to_constants_v2(tf_model_graph)

# get frozen graph

frozen_tf_func.graph.as_graph_def()

# save full tf model

tf.io.write_graph(graph_or_graph_def=frozen_tf_func.graph,

logdir=pb_model_path,

name=pb_model_name,

as_text=False)

return os.path.join(pb_model_path, pb_model_name)

2、使用opencv_dnn进行推理

- 图像预处理(blob)

def get_preprocessed_img(img_path):

# read the image

input_img = cv2.imread(img_path, cv2.IMREAD_COLOR)

input_img = input_img.astype(np.float32)

# define preprocess parameters

mean = np.array([1.0, 1.0, 1.0]) * 127.5

scale = 1 / 127.5

# prepare input blob to fit the model input:

# 1. subtract mean

# 2. scale to set pixel values from 0 to 1

input_blob = cv2.dnn.blobFromImage(

image=input_img,

scalefactor=scale,

size=(224, 224), # img target size

mean=mean,

swapRB=True, # BGR -> RGB

crop=True # center crop

)

print("Input blob shape: {}\n".format(input_blob.shape))

return input_blob

- 调用pb模型进行推理

def get_tf_dnn_prediction(original_net, preproc_img, imagenet_labels):

# inference

preproc_img = preproc_img.transpose(0, 2, 3, 1)

print("TF input blob shape: {}\n".format(preproc_img.shape))

out = original_net(preproc_img)

print("\nTensorFlow model prediction: \n")

print("* shape: ", out.shape)

# get the predicted class ID

imagenet_class_id = np.argmax(out)

print("* class ID: {}, label: {}".format(imagenet_class_id, imagenet_labels[imagenet_class_id]))

# get confidence

confidence = out[0][imagenet_class_id]

print("* confidence: {:.4f}".format(confidence))

3、实现图像分类 (代码汇总)

import os

import cv2

import numpy as np

import tensorflow as tf

from tensorflow.keras.applications import MobileNet

from tensorflow.python.framework.convert_to_constants import convert_variables_to_constants_v2

def get_tf_model_proto(tf_model):

# define the directory for .pb model

pb_model_path = "models"

# define the name of .pb model

pb_model_name = "mobilenet.pb"

# create directory for further converted model

os.makedirs(pb_model_path, exist_ok=True)

# get model TF graph

tf_model_graph = tf.function(lambda x: tf_model(x))

# get concrete function

tf_model_graph = tf_model_graph.get_concrete_function(

tf.TensorSpec(tf_model.inputs[0].shape, tf_model.inputs[0].dtype))

# obtain frozen concrete function

frozen_tf_func = convert_variables_to_constants_v2(tf_model_graph)

# get frozen graph

frozen_tf_func.graph.as_graph_def()

# save full tf model

tf.io.write_graph(graph_or_graph_def=frozen_tf_func.graph,

logdir=pb_model_path,

name=pb_model_name,

as_text=False)

return os.path.join(pb_model_path, pb_model_name)

def get_preprocessed_img(img_path):

# read the image

input_img = cv2.imread(img_path, cv2.IMREAD_COLOR)

input_img = input_img.astype(np.float32)

# define preprocess parameters

mean = np.array([1.0, 1.0, 1.0]) * 127.5

scale = 1 / 127.5

# prepare input blob to fit the model input:

# 1. subtract mean

# 2. scale to set pixel values from 0 to 1

input_blob = cv2.dnn.blobFromImage(

image=input_img,

scalefactor=scale,

size=(224, 224), # img target size

mean=mean,

swapRB=True, # BGR -> RGB

crop=True # center crop

)

print("Input blob shape: {}\n".format(input_blob.shape))

return input_blob

def get_imagenet_labels(labels_path):

with open(labels_path) as f:

imagenet_labels = [line.strip() for line in f.readlines()]

return imagenet_labels

def get_opencv_dnn_prediction(opencv_net, preproc_img, imagenet_labels):

# set OpenCV DNN input

opencv_net.setInput(preproc_img)

# OpenCV DNN inference

out = opencv_net.forward()

print("OpenCV DNN prediction: \n")

print("* shape: ", out.shape)

# get the predicted class ID

imagenet_class_id = np.argmax(out)

# get confidence

confidence = out[0][imagenet_class_id]

print("* class ID: {}, label: {}".format(imagenet_class_id, imagenet_labels[imagenet_class_id]))

print("* confidence: {:.4f}\n".format(confidence))

def get_tf_dnn_prediction(original_net, preproc_img, imagenet_labels):

# inference

preproc_img = preproc_img.transpose(0, 2, 3, 1)

print("TF input blob shape: {}\n".format(preproc_img.shape))

out = original_net(preproc_img)

print("\nTensorFlow model prediction: \n")

print("* shape: ", out.shape)

# get the predicted class ID

imagenet_class_id = np.argmax(out)

print("* class ID: {}, label: {}".format(imagenet_class_id, imagenet_labels[imagenet_class_id]))

# get confidence

confidence = out[0][imagenet_class_id]

print("* confidence: {:.4f}".format(confidence))

def main():

# configure TF launching

#set_tf_env()

# initialize TF MobileNet model

original_tf_model = MobileNet(

include_top=True,

weights="imagenet"

)

# get TF frozen graph path

full_pb_path = get_tf_model_proto(original_tf_model)

print(full_pb_path)

# read frozen graph with OpenCV API

opencv_net = cv2.dnn.readNetFromTensorflow(full_pb_path)

print("OpenCV model was successfully read. Model layers: \n", opencv_net.getLayerNames())

# get preprocessed image

input_img = get_preprocessed_img("yaopin.png")

# get ImageNet labels

imagenet_labels = get_imagenet_labels("classification_classes.txt")

# obtain OpenCV DNN predictions

get_opencv_dnn_prediction(opencv_net, input_img, imagenet_labels)

# obtain TF model predictions

get_tf_dnn_prediction(original_tf_model, input_img, imagenet_labels)

if __name__ == "__main__":

main()

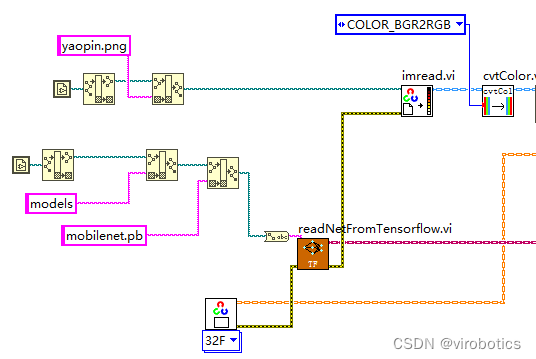

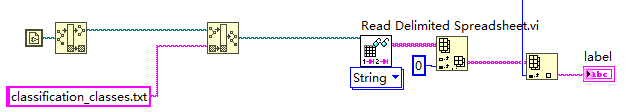

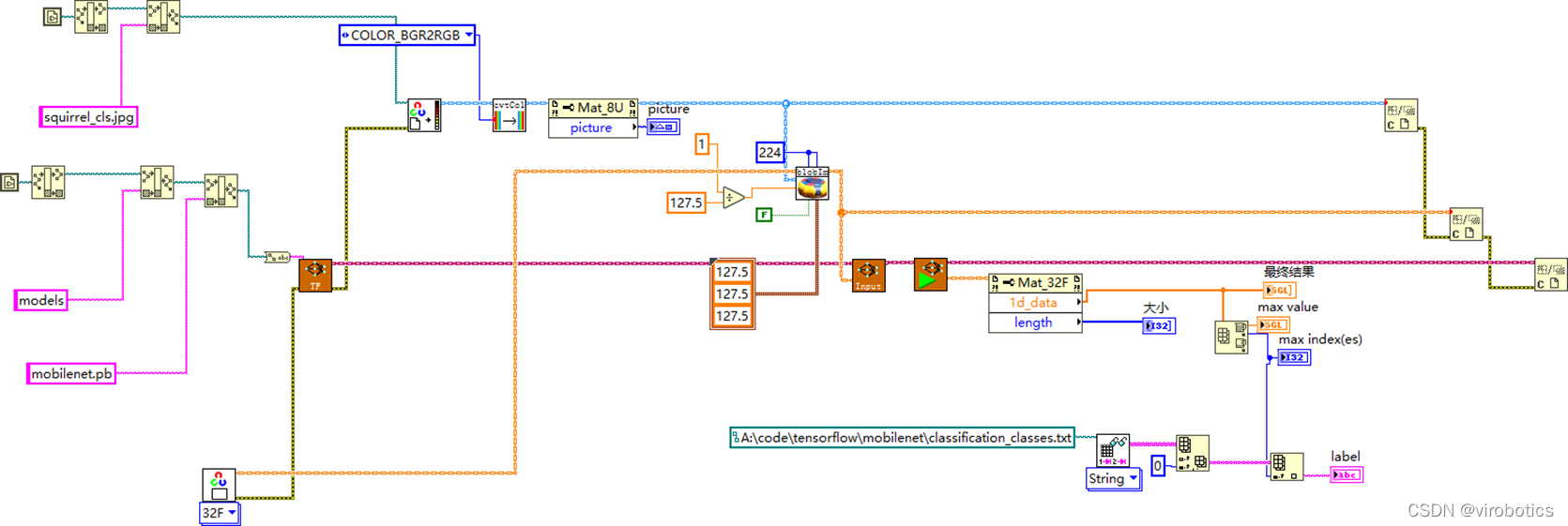

三、使用LabVIEW dnn实现图像分类(callpb_photo.vi)

本博客中所用实例基于LabVIEW2018版本,调用mobilenet pb模型

1、读取待分类的图片和pb模型

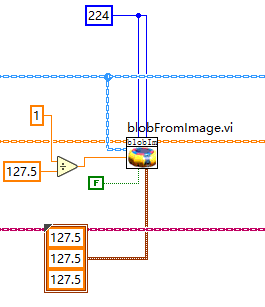

2、将待分类的图片进行预处理

3、将图像输入至神经网络中并进行推理

4、实现图像分类

5、总体程序源码:

按照如下图所示程序进行编码,实现图像分类,本范例中使用了一分类,分类出置信度最高的物体。

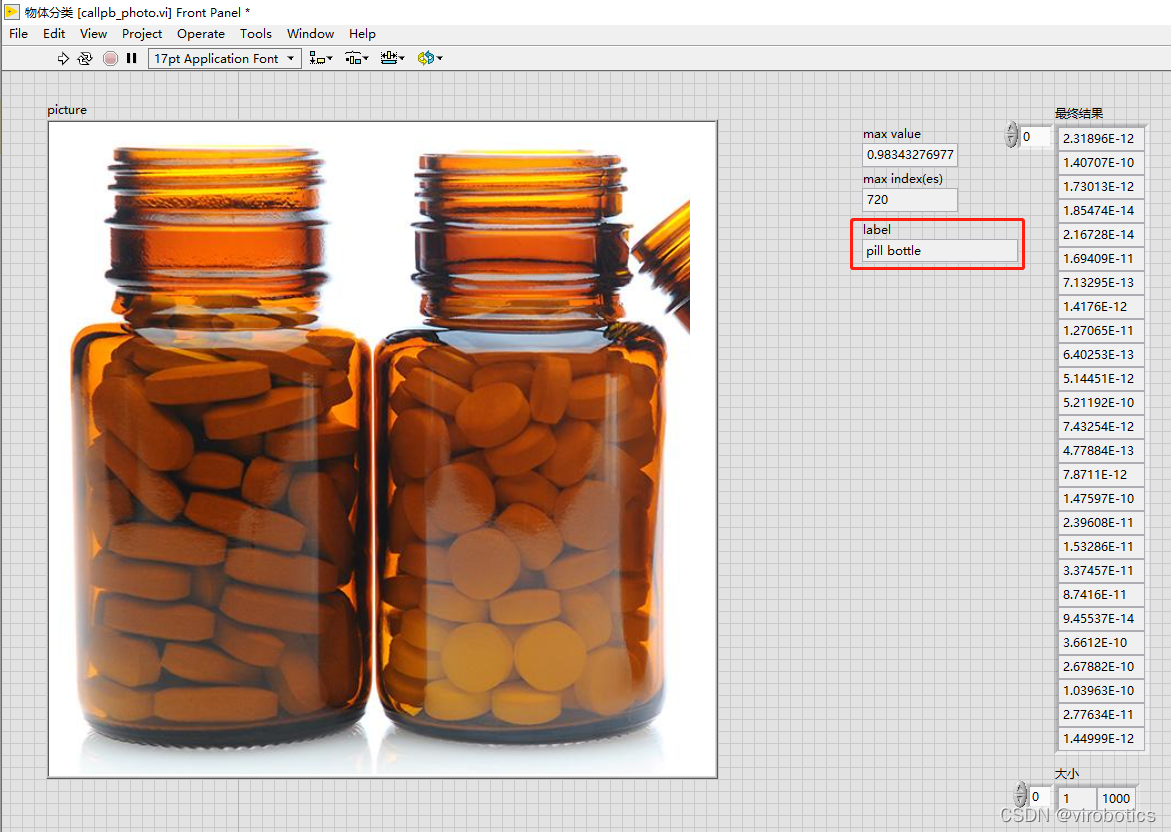

如下图所示为加载药瓶图片得到的分类结果,在前面板可以看到图片和label:

四、源码下载

链接:https://pan.baidu.com/s/10yO72ewfGjxAg_f07wjx0A?pwd=8888

提取码:8888

总结

更多关于LabVIEW与人工智能技术,可添加技术交流群进一步探讨。qq群号:705637299,请备注暗号:LabVIEW 机器学习

手把手教你使用LabVIEW OpenCV dnn实现图像分类(含源码)的更多相关文章

- 手把手教你使用LabVIEW OpenCV DNN实现手写数字识别(含源码)

@ 目录 前言 一.OpenCV DNN模块 1.OpenCV DNN简介 2.LabVIEW中DNN模块函数 二.TensorFlow pb文件的生成和调用 1.TensorFlow2 Keras模 ...

- 手把手教你使用LabVIEW OpenCV dnn实现物体识别(Object Detection)含源码

前言 今天和大家一起分享如何使用LabVIEW调用pb模型实现物体识别,本博客中使用的智能工具包可到主页置顶博客LabVIEW AI视觉工具包(非NI Vision)下载与安装教程中下载 一.物体识别 ...

- 手把手教你使用LabVIEW人工智能视觉工具包快速实现传统Opencv算子的调用(含源码)

前言 今天我们一起来使用LabVIEW AI视觉工具包快速实现图像的滤波与增强:图像灰度处理:阈值处理与设定:二值化处理:边缘提取与特征提取等基本操作.工具包的安装与下载方法可见之前的博客. 一.图像 ...

- Android应用系列:手把手教你做一个小米通讯录(附图附源码)

前言 最近心血来潮,突然想搞点仿制品玩玩,很不幸小米成为我苦逼的第一个试验品.既然雷布斯的MIUI挺受欢迎的(本人就是其的屌丝用户),所以就拿其中的一些小功能做一些小demo来玩玩.小米的通讯录大家估 ...

- 【YOLOv5】手把手教你使用LabVIEW ONNX Runtime部署 TensorRT加速,实现YOLOv5实时物体识别(含源码)

前言 上一篇博客给大家介绍了LabVIEW开放神经网络交互工具包[ONNX],今天我们就一起来看一下如何使用LabVIEW开放神经网络交互工具包实现TensorRT加速YOLOv5. 以下是YOLOv ...

- 手把手教你使用LabVIEW实现Mask R-CNN图像实例分割

前言 前面给大家介绍了使用LabVIEW工具包实现图像分类,目标检测,今天我们来看一下如何使用LabVIEW实现Mask R-CNN图像实例分割. 一.什么是图像实例分割? 图像实例分割(Instan ...

- 手把手教你使用LabVIEW人工智能视觉工具包快速实现图像读取与采集(含源码)

目录 前言 一.工具包位置 二.图像采集与色彩空间转换 1.文件读写 2.实现图片读取 3.使用算子cvtColor实现颜色空间转换 三.从摄像头采集图像 1.Camera类 2.属性节点 3.实现摄 ...

- 自已开发IM有那么难吗?手把手教你自撸一个Andriod版简易IM (有源码)

本文由作者FreddyChen原创分享,为了更好的体现文章价值,引用时有少许改动,感谢原作者. 1.写在前面 一直想写一篇关于im即时通讯分享的文章,无奈工作太忙,很难抽出时间.今天终于从公司离职了, ...

- 【YOLOv5】LabVIEW+YOLOv5快速实现实时物体识别(Object Detection)含源码

前言 前面我们给大家介绍了基于LabVIEW+YOLOv3/YOLOv4的物体识别(对象检测),今天接着上次的内容再来看看YOLOv5.本次主要是和大家分享使用LabVIEW快速实现yolov5的物体 ...

随机推荐

- 关于2022年3月9日之后Typora登录不了--已解决

p.s.今天是2022.7.27,软件版本:13.6.1 (以下所有方法,亲自尝试后整理出的) 报错信息: This beta version of typora is expired, please ...

- linux nginx搭建与使用

安装nginx yum -y install nginx 测试是否安装正确: nginx -t 打印如下: nginx: the configuration file /etc/nginx/nginx ...

- Selenium自动化测试之Selenium IDE

简介 Selenium IDE 是实现Web自动化的一种便捷工具,本质上它是一种浏览器插件.该插件支持Chrome和Firefox浏览器,拥有录制.编写及回放操作等功能,能够快速实现Web的自动化测试 ...

- YII事件EVENT示例

模型中/** * 在初始化时进行事件绑定 */ public function init() { $this->on(self::EVENT_HELLO,[$this,'sendMail']); ...

- MYSQL常见可优化场景

1.应尽量避免在 where 子句中对字段进行 null 值判断,否则将导致引擎放弃使用索引而进行全表扫描,如:select id from t where num is null 可以在num上设置 ...

- GreatSQL季报(2021.12.26)

欢迎来到 GreatSQL社区分享的MySQL技术文章,如有疑问或想学习的内容,可以在下方评论区留言,看到后会进行解答 自从GreatSQL 8.0.25 于 2021.8.26发布以来,针对MGR的 ...

- NRooks采样类定义和测试

类声明: #pragma once #ifndef __NROOKS_HEADER__ #define __NROOKS_HEADER__ #include "sampler.h" ...

- iOS白嫖系列Testflight

1.Picsart 白嫖一年会员 使用 Picsart 照片编辑器和视频编辑器,您可以将您的创意变为现实.制作专业级拼贴画.设计和添加贴纸.快速移除和交换背景.尝试热门编辑,如黄金时段.镜子自拍和复古 ...

- 持久化-DLL劫持

持久化-DLL劫持 原理 通过篡改.替换和代理原dll文件来达到劫持. 原理演示 假定演练流程 假定我们要劫持的目标是 c:\temp\legit.dll 获取 c:\temp\legit.dll 所 ...

- window桌面背景图片

通过修改注册表项: \HKEY_CURRENT_USER\Control Panel\Desktop下的几个值,及可以将我们想要的图片设置成桌面的背景图 TileWallpaper Wallpap ...