DQN(Deep Reiforcement Learning) 发展历程(一)

目录

马尔可夫理论

马尔可夫性质

- P[St+1 | St] = P[St+1 | S1,...,St]

- 给定当前状态 St ,过去的状态可以不用考虑

- 当前状态 St 可以代表过去的所有状态

- 给定当前状态的条件下,未来的状态和过去的状态相互独立。

马尔可夫过程(MP)

- 形式化地描述了强化学习的环境。

- 包括二元组(S,P)

- 根据给定的转移概率矩阵P,从当前状态St转移到下一状态St+1,

- 基于模型的(Model-based):事先给出了转移概率矩阵P

马尔可夫奖励过程(MRP)

- 和马尔可夫过程相比,加入了奖励r,加入了折扣因子gamma,gamma在0~1之间。

- 马尔可夫奖励过程是一个四元组⟨S, P, R, γ⟩

- 需要折扣因子的原因是

- 使未来累积奖励在数学上易于计算

- 由于可能经过某些重复状态,避免累积奖励的计算成死循环

- 用于表示未来的不确定性

- gamma越大表示越看中未来的奖励

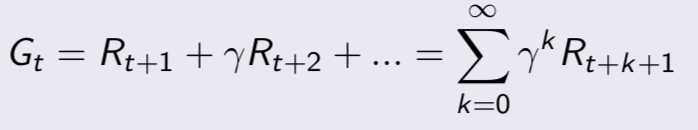

值函数(value function)

- 引入了值函数(value function),给每一个状态一个值V,以从当前状态St到评估未来的目标G的累积折扣奖励的大小

MRP求解

- v = R + γPv (矩阵形式)

- 直接解出上述方程时间复杂度O(n^3), 只适用于一些小规模问题

马尔可夫决策过程(MDP)

- 加入了一个动作因素a,用于每个状态的决策

- MDP是一个五元组⟨S, A, P, R, γ⟩

- 策略policy是从S到A的一个映射

效用函数

- 相比于值函数,加入了一个动作因素

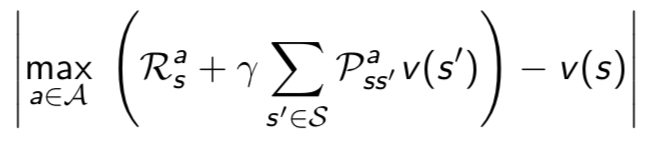

优化的值函数

- 为了求最佳策略,在值函数求解时,选择一个最大的v来更新当前状态对应的v

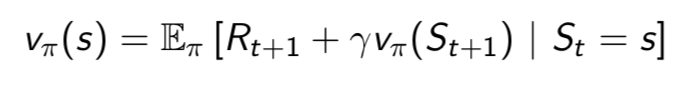

贝尔曼等式

- 和值函数的求解方法相比,不需要从当前状态到目标求解,只需要从当前状态到下一状态即可(根据递推公式)

参考

david siver 课程

https://home.cnblogs.com/u/pinard/

DQN(Deep Reiforcement Learning) 发展历程(一)的更多相关文章

- DQN(Deep Reiforcement Learning) 发展历程(五)

目录 值函数的近似 DQN Nature DQN DDQN Prioritized Replay DQN Dueling DQN 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) ...

- DQN(Deep Reiforcement Learning) 发展历程(三)

目录 不基于模型(Model-free)的预测 蒙特卡罗方法 时序差分方法 多步的时序差分方法 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) DQN发展历程(四) DQN发展 ...

- DQN(Deep Reiforcement Learning) 发展历程(四)

目录 不基于模型的控制 选取动作的方法 在策略上的学习(on-policy) 不在策略上的学习(off-policy) 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) DQN发 ...

- DQN(Deep Reiforcement Learning) 发展历程(二)

目录 动态规划 使用条件 分类 求解方法 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) DQN发展历程(四) DQN发展历程(五) 动态规划 动态规划给出了求解强化学习的一种 ...

- [DQN] What is Deep Reinforcement Learning

已经成为DL中专门的一派,高大上的样子 Intro: MIT 6.S191 Lecture 6: Deep Reinforcement Learning Course: CS 294: Deep Re ...

- Deep Reinforcement Learning 基础知识(DQN方面)

Introduction 深度增强学习Deep Reinforcement Learning是将深度学习与增强学习结合起来从而实现从Perception感知到Action动作的端对端学习的一种全新的算 ...

- 论文笔记之:Dueling Network Architectures for Deep Reinforcement Learning

Dueling Network Architectures for Deep Reinforcement Learning ICML 2016 Best Paper 摘要:本文的贡献点主要是在 DQN ...

- Deep Reinforcement Learning: Pong from Pixels

这是一篇迟来很久的关于增强学习(Reinforcement Learning, RL)博文.增强学习最近非常火!你一定有所了解,现在的计算机能不但能够被全自动地训练去玩儿ATARI(译注:一种游戏机) ...

- 论文笔记之:Human-level control through deep reinforcement learning

Human-level control through deep reinforcement learning Nature 2015 Google DeepMind Abstract RL 理论 在 ...

随机推荐

- pts/0代表什么意思?

在linux命令行中经常看到pts/0,这是什么意思呢??妈蛋!! 先说pts/0吧,man里面是这样说的:ptmx and pts - pseudo-terminal master and slav ...

- ubuntu执行sudo apt-get update 时出现的错误及解决办法

一.错误描述 W: GPG error: http://ppa.launchpad.net/fkrull/deadsnakes/ubuntu xenial InRelease: The followi ...

- Oracle 修改SYS、system用户密码

Oracle 修改SYS.system用户密码 by:授客 QQ:1033553122 概念 SYS用户是Oracle中权限最高的用户,而SYSTEM是一个用于数据库管理的用户.在数据库安装完之后,应 ...

- 有关 Android Studio 重复引入包的问题和解决方案

虽然相同包名相同类名的文件在不同 SDK 中出现的概率极低,但是一旦出现,处理起来就比较棘手.最好的解决方案就是联系提供 SDK 的技术人员反映问题,让其通过修改源码重新打包一个新的 Jar 包. 还 ...

- 《Inside C#》笔记(一) .NET平台

C# 基于.NET运行时,所以有必要首先对.NET以及C#与.NET平台的关系有一定的了解. 一 .NET平台 .NET背后的基本思想是将原本独立工作的设备.网络服务整合在一个统一的平台上,从而可以为 ...

- Python+Selenium笔记(十五)调用JS

(一) 方法 方法 简单说明 execute_async_script(script, args) 异步执行JS代码 script:被执行的JS代码 args:js代码中的任意参数 execute_s ...

- aix rootvg镜像

就一般生产系统而已,操作系统层面都要进行备份,而最常见的操作系统备份方式之一就是做镜像(mirror),而实践过程中,往往是把rootvg这个卷组做镜像操作.查看rootvg是否已经进行镜像方法: 1 ...

- TCP的socket资源被耗尽的问题

一. 故障现象 部分机顶盒用户出现大面积登录APP时,界面停留在登陆页面,无反应. 二. 现象初步分析 本次问题出现时,所有AAA出现了异常流量波动,在AAA异常流量段期间接到用户故障报障.此时主要表 ...

- MD5密码加密

using System; using System.Security.Cryptography; using System.Text; namespace DimoNetwork.Common.DE ...

- AD用户移除所属组

AD用户移除所属组: $Membership = Get-ADPrincipalGroupMembership $Users $Membership.distinguishedName Remove- ...