zookeeper分布式锁原理及使用 curator 实现分布式锁

本文为博主原创,未经允许不得转载:

1. zookeeper 分布式锁应用场景及特点分析

2. zookeeper 分布式原理

3. curator 实现分布式锁

1. zookeeper 分布式锁:

(1)优点:ZooKeeper分布式锁(如InterProcessMutex),能有效的解决分布式问题,不可重入问题,使用起来也较为简单。

(2)缺点:ZooKeeper实现的分布式锁,性能并不太高。为啥呢?

因为每次在创建锁和释放锁的过程中,都要动态创建、销毁瞬时节点来实现锁功能。大家知道,ZK中创建和删除节点只能通过Leader服务器来执行,

然后Leader服务器还需要将数据同不到所有的Follower机器上,这样频繁的网络通信,性能的短板是非常突出的。

总之,在高性能,高并发的场景下,不建议使用ZooKeeper的分布式锁。而由于ZooKeeper的高可用特性,所以在并发量不是太高的场景,推荐

使用ZooKeeper的分布式锁。

对比 redis 分布式锁:

(1)基于ZooKeeper的分布式锁,适用于高可靠(高可用)而并发量不是太大的场景;

(2)基于Redis的分布式锁,适用于并发量很大、性能要求很高的、而可靠性问题可以通过其他方案去弥补的场景。

2. zookeeper 分布式锁原理:

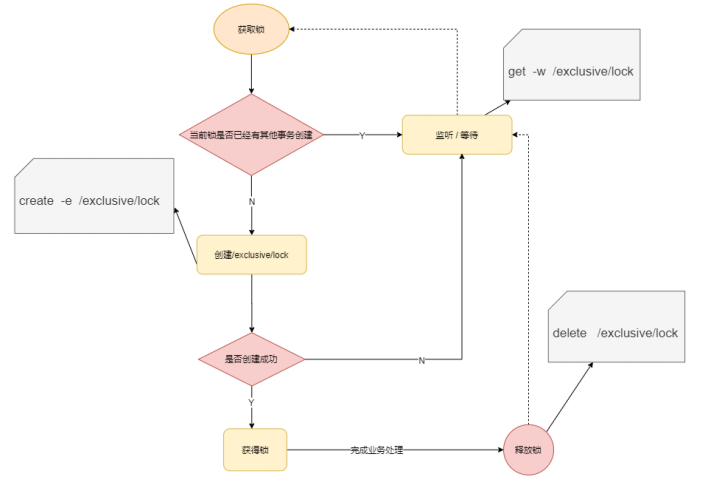

非公共锁方式实现流程:

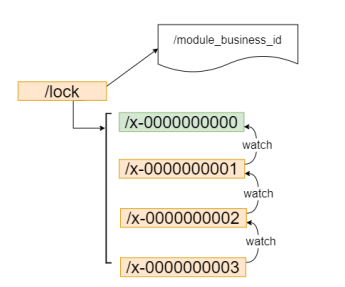

zookeeper 公平锁实现:

流程:

1. 请求进来,直接在 /lock 节点下穿件一个临时顺序节点

2. 判断自己是不是 lock 节点下最小的节点: 如果是最小的,则获取锁,反之对前面的节点进行监听

3. 获得锁的请求,处理完释放锁,即delete 节点,然后后继第一个节点收到通知,并重复第二步判断。

<dependency>

<groupId>org.apache.curator</groupId>

<artifactId>curator‐recipes</artifactId>

<version>5.0.0</version>

<exclusions>

<exclusion>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

<version>3.5.8</version>

</dependency>

封装的工具类:

import org.apache.commons.lang3.exception.ExceptionUtils;

import org.apache.commons.logging.Log;

import org.apache.commons.logging.LogFactory;

import org.apache.curator.RetryPolicy;

import org.apache.curator.framework.CuratorFramework;

import org.apache.curator.framework.CuratorFrameworkFactory;

import org.apache.curator.framework.recipes.leader.LeaderLatch;

import org.apache.curator.retry.ExponentialBackoffRetry;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.stereotype.Component; import java.util.concurrent.TimeUnit; @Component

public class BaseJob {

Log log = LogFactory.getLog(this.getClass());

@Value("${zookeeper.connectstring}")

private String zookeeperHost;

@Value("${zookeeper.parent.path}")

private String zookeeperPath = "/dlocks/zk/demo";

@Value("${curator.leadership.wait}")

private int leaderShipWait = 60000;

@Value("${curator.leadership.release}")

private int leaderShipRelease = 360000; protected static String Zookeeper_KEY = "zk/lag/count";

public boolean getZkLock(String tokenKey) {

return getZkLock(tokenKey, leaderShipRelease);

} public boolean getZkLock(String tokenKey, final int lShipRelease) {

CuratorFramework client = null;

LeaderLatch ll = null;

try {

RetryPolicy policy = new ExponentialBackoffRetry(4000, 3);

client = CuratorFrameworkFactory.newClient(zookeeperHost, policy);

client.start();

ll = new LeaderLatch(client, String.format("%s/ppcloud/"+tokenKey+"/lock", zookeeperPath));

ll.start();

boolean get = ll.await(leaderShipWait, TimeUnit.MILLISECONDS);

if (get) {

final CuratorFramework client2 = client;

final LeaderLatch ll2 = ll;

new Thread(new Runnable() { public void run() {

try {

Thread.sleep(lShipRelease);

} catch (Throwable e1) {

}

try {

ll2.close();

} catch (Throwable t) {

}

try {

client2.close();

} catch (Throwable e) {

}

}

}).start();

return true;

} else {

ll.close();

client.close();

log.error(String.format("Zookeeper return:%s", get));

//hack code temp

//return true;

} } catch (Throwable e) {

log.error(String.format("Zookeeper failed:%s", ExceptionUtils.getStackTrace(e)));

try {

if (ll != null) {

ll.close();

}

} catch (Exception e2) {

}

try {

if (client != null) {

client.close();

}

} catch (Exception e2) {

}

}

return false;

}

}

zookeeper分布式锁原理及使用 curator 实现分布式锁的更多相关文章

- 【分布式锁】02-使用Redisson实现公平锁原理

前言 前面分析了Redisson可重入锁的原理,主要是通过lua脚本加锁及设置过期时间来保证锁执行的原子性,然后每个线程获取锁会将获取锁的次数+1,释放锁会将当前锁次数-1,如果为0则表示释放锁成功. ...

- 一般实现分布式锁都有哪些方式?使用redis如何设计分布式锁?使用zk来设计分布式锁可以吗?这两种分布式锁的实现方式哪种效率比较高?

#(1)redis分布式锁 官方叫做RedLock算法,是redis官方支持的分布式锁算法. 这个分布式锁有3个重要的考量点,互斥(只能有一个客户端获取锁),不能死锁,容错(大部分redis节点创建了 ...

- 分布式事务(3)---RocketMQ实现分布式事务原理

分布式事务(3)-RocketMQ实现分布式事务原理 之前讲过有关分布式事务2PC.3PC.TCC的理论知识,博客地址: 1.分布式事务(1)---2PC和3PC原理 2.分布式事务(2)---TCC ...

- 女朋友也能看懂的Zookeeper分布式锁原理

前言 关于分布式锁,在互联网行业的使用场景还是比较多的,比如电商的库存扣减,秒杀活动,集群定时任务执行等需要进程互斥的场景.而实现分布式锁的手段也很多,大家比较常见的就是redis跟zookeep ...

- zookeeper(4)--zookeeper分布式锁原理

目前几乎很多大型网站及应用都是分布式部署的,分布式场景中的数据一致性问题一直是一个比较重要的话题.分布式的CAP理论告诉我们“任何一个分布式系统都无法同时满足一致性(Consistency).可用性( ...

- Redis、Zookeeper实现分布式锁——原理与实践

Redis与分布式锁的问题已经是老生常谈了,本文尝试总结一些Redis.Zookeeper实现分布式锁的常用方案,并提供一些比较好的实践思路(基于Java).不足之处,欢迎探讨. Redis分布式锁 ...

- 关于分布式锁原理的一些学习与思考-redis分布式锁,zookeeper分布式锁

首先分布式锁和我们平常讲到的锁原理基本一样,目的就是确保,在多个线程并发时,只有一个线程在同一刻操作这个业务或者说方法.变量. 在一个进程中,也就是一个jvm 或者说应用中,我们很容易去处理控制,在j ...

- zookeeper 分布式锁原理

zookeeper 分布式锁原理: 1 大家也许都很熟悉了多个线程或者多个进程间的共享锁的实现方式了,但是在分布式场景中我们会面临多个Server之间的锁的问题,实现的复杂度比较高.利用基于googl ...

- Zookeeper--0300--java操作Zookeeper,临时节点实现分布式锁原理

删除Zookeeper的java客户端有 : 1,Zookeeper官方提供的原生API, 2,zkClient,在原生api上进行扩展的开源java客户端 3, 一.Zookeeper原生API ...

- zookeeper分布式锁原理

一.分布式锁介绍分布式锁主要用于在分布式环境中保护跨进程.跨主机.跨网络的共享资源实现互斥访问,以达到保证数据的一致性. 二.架构介绍在介绍使用Zookeeper实现分布式锁之前,首先看当前的系统架构 ...

随机推荐

- 图片Base64相互转换

一.简介 Base64编码是一种广泛应用于网络传输和数据存储的编码方式.在实际应用中,我们将图片转换为Base64编码,可以大大减少数据量,便于传输和存储.本文将详细介绍图片Base64编码的相互转换 ...

- Bugku CTF web题

web2 查看网页源码,发现flag

- 使用dtd定义元素

- ElasticSearch之Index modules

索引的参数,分为两类: 静态参数,仅支持在创建索引时指定,或者关闭索引后指定. 动态参数,允许在索引工作期间指定或者修改. 静态参数 index.number_of_shards 默认值为1. 本参数 ...

- 序列化性能测试:jdk和fastjson

序列化性能测试:jdk和fastjson 我开发一个认证授权框架时,需要添加数据库存储token或者会话,于是想测试使用jdk的blob存储解析快还是存储string的json序列化解析快,从而选择他 ...

- Ubuntu20.04 安装shutter

1 sudo add-apt-repository ppa:linuxuprising/shutter 2 3 sudo apt install shutter 4 5 卸载 6 sudo apt-g ...

- linux中nginx下载安装部署

反向代理 动静结合 负载均衡 下载 wget https://nginx.org/download/nginx-1.24.0.tar.gz 官网下载稳定版 解压 tar -zxvf nginx-1.2 ...

- 华为云河图KooMap:夯实数字孪生底座,点燃燎原星火

摘要:7月8日,华为开发者大会2023(Cloud)华为云河图KooMap技术分论坛在东莞溪村顺利举办. 7月8日,华为开发者大会2023(Cloud)华为云河图KooMap技术分论坛在东莞溪村顺利举 ...

- 你的Parquet该升级了:IOException: totalValueCount == 0问题定位之旅

摘要:使用Spark SQL进行ETL任务,在读取某张表的时候报错:"IOException: totalValueCount == 0",但该表在写入时,并没有什么异常. 本文分 ...

- 基于KubeEdge的边缘节点分组管理设计与实现

摘要:KubeEdge 1.11版本提供了"边缘节点分组管理"新特性,抽象出了跨地域的应用部署模型. 本文分享自华为云社区<基于KubeEdge的边缘节点分组管理设计与实现& ...