实现一个正则表达式引擎in Python(一)

前言

项目地址:Regex in Python

开学摸鱼了几个礼拜,最近几天用Python造了一个正则表达式引擎的轮子,在这里记录分享一下。

实现目标

实现了所有基本语法

st = 'AS342abcdefg234aaaaabccccczczxczcasdzxc'

pattern = '([A-Z]+[0-9]*abcdefg)([0-9]*)(\*?|a+)(zx|bc*)([a-z]+|[0-9]*)(asd|fgh)(zxc)'

regex = Regex(st, pattern)

result = regex.match()

log(result)

更多示例可以在github上看到

前置知识

其实正则表达式的引擎完全可以看作是一个小型的编译器,所以完全可以按之前写的那个C语言的编译器的思路来,只是没有那么复杂而已

- 首先进行词法分析

- 语法分析(这里用自顶向下)

- 语义分析 (因为正则的表达能力非常弱,所以可以省略生成AST的部分直接进行代码生成)

- 代码生成,这里也就是进行NFA的生成

- NFA到DFA的转换,这里开始就是正则和状态机的相关的知识了

- DFA的最小化

NFA和DFA

有限状态机可以看作是一个有向图,状态机中有若干个节点,每个节点都可以根据输入字符来跳转到下一个节点,而区别NFA((非确定性有限状态自动机)和DFA(确定性有限状态自动机)的是DFA的下一个跳转状态是唯一确定的)

有限状态自动机从开始的初始状态开始读取输入的字符串,自动机使用状态转移函数move根据当前状态和当前的输入字符来判断下一个状态,但是NFA的下一个状态不是唯一确定的,所以只能确定的是下一个状态集合,这个状态集合还需要依赖之后的输入才能确定唯一所处的状态。如果当自动机完成读取的时候,它处于接收状态的话,则说明NFA可以接收这个输入字符串

对于所有的NFA最后都可以转换为对应的DFA

NFA构造O(n),匹配O(nm)

DFA构造O(2^n),最小化O(kn'logn')(N'=O(2^n)),匹配O(m)

n=regex长度,m=串长,k=字母表大小,n'=原始的dfa大小

NFA接受的所有字符串的集合是NFA接受的语言。这个语言是正则语言。

例子

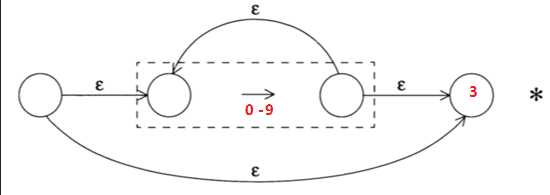

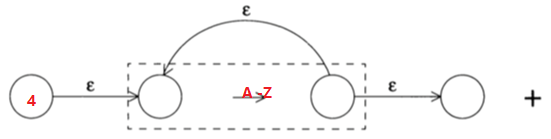

对于正则表达式:[0-9]*[A-Z]+,对应的NFA就是将下面两个NFA的节点3和节点4连接起来

词法分析

对于NFA和DFA其实只要知道这么多和一些相应的算法就已经足够了,相应的算法在后面提及,先完成词法分析的部分,

这个词法分析比之前C语言编译器的语法分析要简单许多,只要处理几种可能性

- 普通字符

- 含有语义的字符

- 转义字符

token

token没什么好说的,就是对应正则里的语法

Tokens = {

'.': Token.ANY,

'^': Token.AT_BOL,

'$': Token.AT_EOL,

']': Token.CCL_END,

'[': Token.CCL_START,

'}': Token.CLOSE_CURLY,

')': Token.CLOSE_PAREN,

'*': Token.CLOSURE,

'-': Token.DASH,

'{': Token.OPEN_CURLY,

'(': Token.OPEN_PAREN,

'?': Token.OPTIONAL,

'|': Token.OR,

'+': Token.PLUS_CLOSE,

}

advance

advance是词法分析里最主要的函数,用来返回当前输入字符的Token类型

def advance(self):

pos = self.pos

pattern = self.pattern

if pos > len(pattern) - 1:

self.current_token = Token.EOS

return Token.EOS

text = self.lexeme = pattern[pos]

if text == '\\':

self.isescape = not self.isescape

self.pos = self.pos + 1

self.current_token = self.handle_escape()

else:

self.current_token = self.handle_semantic_l(text)

return self.current_token

advance的主要逻辑就是读入当前字符,再来判断是否是转义字符或者是其它字符

handle_escape用来处理转义字符,当然转义字符最后本质上返回的还是普通字符类型,这个函数的主要功能就是来记录当前转义后的字符,然后赋值给lexem,供之后构造自动机使用

handle_semantic_l只有两行,一是查表,这个表保存了所有的拥有语义的字符,如果查不到就直接返回普通字符类型了

完整代码就不放上来了,都在github上

构造NFA

构造NFA的主要文件都在nfa包下,nfa.py是NFA节点的定义,construction.py是实现对NFA的构造

NFA节点定义

NFA节点的定义也很简单,其实这个正则表达式引擎完整的实现只有900行左右,每一部分拆开看都非常简单

edge和input_set都是用来指示边的,边一共可能有四种种可能的属性

- 对应的节点有两个出去的ε边

edge = PSILON = -1 - 边对应的是字符集

edge = CCL = -2

input_set = 相应字符集 - 一条ε边

edge = EMPTY = -3 - 边对应的是单独的一个输入字符c

edge = c

- 对应的节点有两个出去的ε边

status_num每个节点都有唯一的一个标识

visited则是为了debug用来遍历NFA

class Nfa(object):

STATUS_NUM = 0

def __init__(self):

self.edge = EPSILON

self.next_1 = None

self.next_2 = None

self.visited = False

self.input_set = set()

self.set_status_num()

def set_status_num(self):

self.status_num = Nfa.STATUS_NUM

Nfa.STATUS_NUM = Nfa.STATUS_NUM + 1

def set_input_set(self):

self.input_set = set()

for i in range(ASCII_COUNT):

self.input_set.add(chr(i))

简单节点的构造

节点的构造在nfa.construction下,这里为了简化代码把Lexer作为全局变量,让所有函数共享

正则表达式的BNF范式如下,这样我们可以采用自顶向下来分析,从最顶层的group开始向下递归

group ::= ("(" expr ")")*

expr ::= factor_conn ("|" factor_conn)*

factor_conn ::= factor | factor factor*

factor ::= (term | term ("*" | "+" | "?"))*

term ::= char | "[" char "-" char "]" | .

BNF在之前写C语言编译器的时候有提到:从零写一个编译器(二)

主入口

这里为了简化代码,就把词法分析器作为全局变量,让所有函数共享

主要逻辑非常简单,就是初始化词法分析器,然后传入NFA头节点开始进行递归创建节点

def pattern(pattern_string):

global lexer

lexer = Lexer(pattern_string)

lexer.advance()

nfa_pair = NfaPair()

group(nfa_pair)

return nfa_pair.start_node

term

虽然是采用的是自顶向下的语法分析,但是从自底向上看会更容易理解,term是最底部的构建,也就是像单个字符、字符集、.符号的节点的构建

term ::= char | "[" char "-" char "]" | | .

term的主要逻辑就是根据当前读入的字符来判断应该构建什么节点

def term(pair_out):

if lexer.match(Token.L):

nfa_single_char(pair_out)

elif lexer.match(Token.ANY):

nfa_dot_char(pair_out)

elif lexer.match(Token.CCL_START):

nfa_set_nega_char(pair_out)

三种节点的构造函数都很简单,下面图都是用markdown的mermaid随便画画的

- nfa_single_char

单个字符的NFA构造就是创建两个节点然后把当前匹配的字符作为edge

def nfa_single_char(pair_out):

if not lexer.match(Token.L):

return False

start = pair_out.start_node = Nfa()

pair_out.end_node = pair_out.start_node.next_1 = Nfa()

start.edge = lexer.lexeme

lexer.advance()

return True

- nfa_dot_char

. 这个的NFA和上面单字符的唯一区别就是它的edge被设置为CCL,并且设置了input_set

# . 匹配任意单个字符

def nfa_dot_char(pair_out):

if not lexer.match(Token.ANY):

return False

start = pair_out.start_node = Nfa()

pair_out.end_node = pair_out.start_node.next_1 = Nfa()

start.edge = CCL

start.set_input_set()

lexer.advance()

return False

- nfa_set_nega_char

这个函数逻辑上只比上面的多了一个处理input_set

def nfa_set_nega_char(pair_out):

if not lexer.match(Token.CCL_START):

return False

neagtion = False

lexer.advance()

if lexer.match(Token.AT_BOL):

neagtion = True

start = pair_out.start_node = Nfa()

start.next_1 = pair_out.end_node = Nfa()

start.edge = CCL

dodash(start.input_set)

if neagtion:

char_set_inversion(start.input_set)

lexer.advance()

return True

小结

篇幅原因,现在已经写到了三百多行,所以就分篇写,准备在三篇内完成。下一篇写构造更复杂的NFA和通过构造的NFA来分析输入字符串。最后写从NFA转换到DFA,再最后用DFA分析输入的字符串

实现一个正则表达式引擎in Python(一)的更多相关文章

- 实现一个正则表达式引擎in Python(二)

项目地址:Regex in Python 在看一下之前正则的语法的 BNF 范式 group ::= ("(" expr ")")* expr ::= fact ...

- 实现一个正则表达式引擎in Python(三)

项目地址:Regex in Python 前两篇已经完成的写了一个基于NFA的正则表达式引擎了,下面要做的就是更近一步,把NFA转换为DFA,并对DFA最小化 DFA的定义 对于NFA转换为DFA的算 ...

- 1000行代码徒手写正则表达式引擎【1】--JAVA中正则表达式的使用

简介: 本文是系列博客的第一篇,主要讲解和分析正则表达式规则以及JAVA中原生正则表达式引擎的使用.在后续的文章中会涉及基于NFA的正则表达式引擎内部的工作原理,并在此基础上用1000行左右的JAVA ...

- Python的regex模块——更强大的正则表达式引擎

Python自带了正则表达式引擎(内置的re模块),但是不支持一些高级特性,比如下面这几个: 固化分组 Atomic grouping 占有优先量词 Possessive quantifi ...

- 基于ε-NFA的正则表达式引擎

正则表达式几乎每个程序员都会用到,对于这么常见的一个语言,有没有想过怎么去实现一个呢?乍一想,也许觉得困难,实际上实现一个正则表达式的引擎并没有想像中的复杂,<编译原理>一书中有一章专门讲 ...

- DEELX 正则表达式引擎(v1.2)

DEELX 正则表达式引擎(v1.2) 简介见文末. 选择使用deelx的理由:全部代码位于一个头文件(.h)中, 比任何引擎都使用简单和方便. 利用分组从字符串当中提取出化学元素英文名.比如 Ag, ...

- 正则表达式学习与python中的应用

目录: 一.正则表达式的特殊符号 二.几种重要的正则表达式 三.python的re模块应用 四.参考文献 一.正则表达式的特殊符号 特殊符号可以说是正则表达式的关键,掌握并且可以灵活运用重要的pyth ...

- 一个简单的多线程Python爬虫(一)

一个简单的多线程Python爬虫 最近想要抓取拉勾网的数据,最开始是使用Scrapy的,但是遇到了下面两个问题: 前端页面是用JS模板引擎生成的 接口主要是用POST提交参数的 目前不会处理使用JS模 ...

- 只有20行Javascript代码!手把手教你写一个页面模板引擎

http://www.toobug.net/article/how_to_design_front_end_template_engine.html http://barretlee.com/webs ...

随机推荐

- 多渠道推广场景下,如何实现 App 用户增长的精准归因?

为了实现用户的快速增长,以推广 App 为目标的线上广告投放是很多平台获取新用户的重要方式.随道移动互联网的发展,现在 App 推广的渠道越来越丰富,除了 WAP 站点.第三方 App 之外,HTML ...

- Docker跨服务器通信Overlay解决方案(上) Consul单实例

场景 公司微服务快上线了,微服务都是用Docker容器进行部署的,在同一台主机下,把服务都部署上,注册到Nacos的IP与PORT都是内网的IP与Dockerfile中定义的端口号,看起来好像也没什么 ...

- springboot启动慢解决方法

jdk的配置文件中,使用securerandom.source设置了熵源: cat /usr/java/jdk1.8.0_121/jre/lib/security/java.security secu ...

- egret之红包满屏随意飘动

在做这个需求之前,我们假设屏幕上同时飘动的红包数最大为10 ) { let redBag = GameUtil.createBitmapByName("Red_bag_png"); ...

- Java——excel导入导出demo

1. java导入 package xx; import org.apache.poi.hssf.usermodel.HSSFCell;import org.apache.poi.hssf.userm ...

- Jenkins教程——从安装到部署Docker服务(二)声明式流水线HelloWorld

前言 本文通过一个声明式流水线的HelloWorld程序做一下流水线基础入门,对常用的流水线参数进行简要说明 什么是流水线 现实中的流水线 流水线比较好理解,类比于现实生活中的生产流水线,每个流程只做 ...

- [Mysql] GroupBy 分组,按天、周、月

简单说明: 最近在做报表功能的时候,需要将数据按天.周和月进行合并展示(数据记录都是按天20190701). 正文: 说明:数据表中date都是int类型:如 20190701 一.按天 SELECT ...

- 【原创】(二)Linux物理内存初始化

背景 Read the fucking source code! --By 鲁迅 A picture is worth a thousand words. --By 高尔基 说明: Kernel版本: ...

- C++ 并发编程之互斥锁和条件变量的性能比较

介绍 本文以最简单生产者消费者模型,通过运行程序,观察该进程的cpu使用率,来对比使用互斥锁 和 互斥锁+条件变量的性能比较. 本例子的生产者消费者模型,1个生产者,5个消费者. 生产者线程往队列里放 ...

- 前端通过Blob实现文件下载

最近遇到一个需求,需要将页面中的配置信息下载下来供用户方便使用,以前这个场景的需求有时候会放到后端处理,然后给返回一个下载链接.其实并不需要这么麻烦,这样既增大了服务器的负载,也让用户产生了没有必要的 ...