CHD-5.3.6集群上Flume安装

Flume is a distributed, reliable, and available service for efficiently collecting, aggregating, and moving large amounts of log data. It has a simple and flexible architecture based on streaming data flows. It is robust and fault tolerant with tunable reliability mechanisms and many failover and recovery mechanisms. It uses a simple extensible data model that allows for online analytic application.

翻译:

Flume是一种分布式、可靠且可用的服务,用于高效地收集、聚合和移动大量日志数据。它具有基于流数据流的简单灵活的体系结构。它具有鲁棒性和容错性,具有可调的可靠性机制和许多故障转移和恢复机制。它使用一个简单的可扩展数据模型,允许在线分析应用程序。

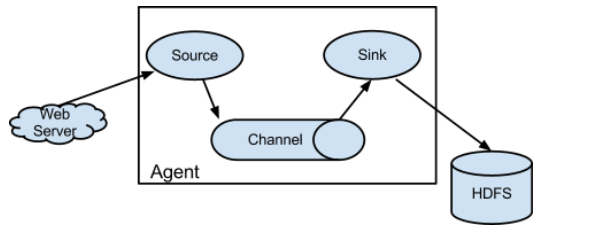

web Server 端产生日志,Source到具体目录下获取日志文件,把日志Channel中,Sink写到HDFS上

Source → Channel 可以进行数据清洗

Channel → Sink 可以进行数据清洗

vent是Flume数据传输的基本单元

Flume以事件的形式将数据从源头传送到最终的目的

Event由可选的header和载有数据的一个byte array构成

载有的数据对flume是不透明的

Header是容纳了key-value字符串对的无序集合,key在集合内是唯 一的。

Header可以在上下文路由中使用扩展

前提依赖:

* 运行在有log的地方

* 运行在LINUX

* JVM

解压:flume-ng-1.5.0-cdh5.3.6.tar.gz

mv apache-flume-1.5.0-cdh5.3.6-bin/ flume-1.5.0-cdh5.3.6

cd /home/hadoop/CDH5.3.6/flume-1.5.0-cdh5.3.6/conf

cp flume-env.sh.template flume-env.sh

vi flume-env.sh

export JAVA_HOME=/usr/local/jdk1.

[hadoop@master flume-1.5.-cdh5.3.6]$ bin/flume-ng Usage: bin/flume-ng <command> [options]... commands:

agent run a Flume agent

avro-client run an avro Flume client

version show Flume version info global options:

--conf,-c <conf> use configs in <conf> directory-Dproperty=value sets a Java system property value agent options:

--name,-n <name> the name of this agent (required)

--conf-file,-f <file> specify a config file (required if -z missing)

运行命令:

bin/flume-ng agent --conf conf --name agent-test --conf-file test.conf

bin/flume-ng agent -c conf -n agent-test -f test.conf

配置一个a.conf

# The configuration file needs to define the sources,

# the channels and the sinks.

# Sources, channels and sinks are defined per agent,

# in this case called 'agent' ###define agent

a1.sources = r1

a1.channels = c1

a1.sinks = k1 ### define sources

a1.sources.r1.type = netcat

a1.sources.r1.bind = master

a1.sources.r1.port = ### define channel

a1.channels.c1.type = memory

a1.channels.c1.capacity =

a1.channels.c1.transactionCapacity = ### define sink

a1.sinks.k1.type=logger

a1.sinks.k1.maxBytyesToLog = ### bind the source and sinks to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

安装 xinetd

[root@master telnet]# ll

total 224

----rwxr-x. 1 hadoop hadoop 59120 Jun 22 23:49 telnet-0.17-47.el6_3.1.x86_64.rpm

----rwxr-x. 1 hadoop hadoop 37748 Jun 22 23:49 telnet-server-0.17-47.el6_3.1.x86_64.rpm

----rwxr-x. 1 hadoop hadoop 124280 Jun 22 23:49 xinetd-2.3.14-38.el6.x86_64.rpm

[root@master telnet]# rpm -ivh *.rpm

warning: telnet-0.17-47.el6_3.1.x86_64.rpm: Header V3 RSA/SHA1 Signature, key ID c105b9de: NOKEY

Preparing... ########################################### [100%]

1:xinetd ########################################### [ 33%]

2:telnet-server ########################################### [ 67%]

3:telnet ########################################### [100%]

[root@master telnet]#

启动服务:

[root@master telnet]# /etc/rc.d/init.d/xinetd restart

Stopping xinetd: [FAILED]

Starting xinetd: [ OK ]

[root@master telnet]#

运行命令:

bin/flume-ng agent -c conf -n a1 -f conf/a.conf -D flume.root.logger=DEBUG,consol

查看端口:

[root@master flume-1.5.0-cdh5.3.6]# netstat -tnlp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 192.168.1.30:19888 0.0.0.0:* LISTEN 3735/java

tcp 0 0 0.0.0.0:10033 0.0.0.0:* LISTEN 3735/java

tcp 0 0 0.0.0.0:50070 0.0.0.0:* LISTEN 2715/java

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1924/sshd

tcp 0 0 127.0.0.1:631 0.0.0.0:* LISTEN 1685/cupsd

tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 2299/master

tcp 0 0 0.0.0.0:50010 0.0.0.0:* LISTEN 2815/java

tcp 0 0 0.0.0.0:50075 0.0.0.0:* LISTEN 2815/java

tcp 0 0 192.168.1.30:10020 0.0.0.0:* LISTEN 3735/java

tcp 0 0 0.0.0.0:50020 0.0.0.0:* LISTEN 2815/java

tcp 0 0 192.168.1.30:9000 0.0.0.0:* LISTEN 2715/java

tcp 0 0 192.168.1.30:50090 0.0.0.0:* LISTEN 2990/java

tcp 0 0 :::22 :::* LISTEN 1924/sshd

tcp 0 0 ::1:631 :::* LISTEN 1685/cupsd

tcp 0 0 ::1:25 :::* LISTEN 2299/master

tcp 0 0 ::ffff:192.168.1.30:44444 :::* LISTEN 17488/java

tcp 0 0 :::3306 :::* LISTEN 2152/mysqld

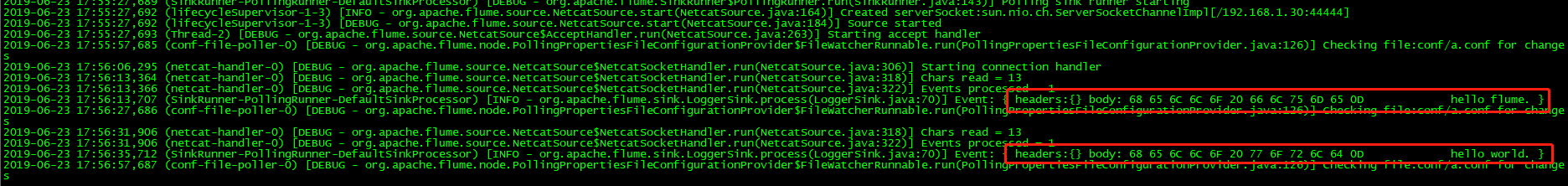

运行命令:bin/flume-ng agent -c conf -n a1 -f conf/a.conf -Dflume.root.logger=DEBUG,console

在另一个控制台

[hadoop@master ~]$ telnet master 44444

Trying 192.168.1.30...

Connected to master.

Escape character is '^]'.

hello flume

OK

hello world

OK

在控制台的运行命令下,会出现:

CHD-5.3.6集群上Flume安装的更多相关文章

- CHD-5.3.6集群上Flume的文件监控

收集hive的log hive的运行日志: /home/hadoop/CDH5.3.6/hive-0.13.1-cdh5.3.6/log/hive.log * memory *hdfs ...

- CHD-5.3.6集群上oozie安装

参考文档:http://archive.cloudera.com/cdh5/cdh/5/oozie-4.0.0-cdh5.3.6/DG_QuickStart.html tar -zxvf oozie ...

- CHD-5.3.6集群上sqoop安装

Sqoop(发音:skup)是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql.postgresql...)间进行数据的传递,可以将一个关系型数据库(例如 : MySQL ...

- CHD-5.3.6集群上hive安装

解压过后: [hadoop@master CDH5.3.6]$ ls -rlttotal 8drwxr-xr-x. 17 hadoop hadoop 4096 Jun 2 16:07 hadoop- ...

- hive1.2.1安装步骤(在hadoop2.6.4集群上)

hive1.2.1在hadoop2.6.4集群上的安装 hive只需在一个节点上安装即可,这里再hadoop1上安装 1.上传hive安装包到/usr/local/目录下 2.解压 tar -zxvf ...

- 在Ubuntu16.04集群上手工部署Kubernetes

目前Kubernetes为Ubuntu提供的kube-up脚本,不支持15.10以及16.04这两个使用systemd作为init系统的版本. 这里详细介绍一下如何以非Docker方式在Ubuntu1 ...

- 在集群上运行caffe程序时如何避免Out of Memory

不少同学抱怨,在集群的GPU节点上运行caffe程序时,经常出现"Out of Memory"的情况.实际上,如果我们在提交caffe程序到某个GPU节点的同时,指定该节点某个比较 ...

- 分布式Hbase-0.98.4在Hadoop-2.2.0集群上的部署

fesh个人实践,欢迎经验交流!本文Blog地址:http://www.cnblogs.com/fesh/p/3898991.html Hbase 是Apache Hadoop的数据库,能够对大数据提 ...

- Hadoop集群上使用JNI,调用资源文件

hadoop是基于java的数据计算平台,引入第三方库,例如C语言实现的开发包将会大大增强数据分析的效率和能力. 通常在是用一些工具的时候都要用到一些配置文件.资源文件等.接下来,借一个例子来说明ha ...

随机推荐

- Python排序算法之选择排序定义与用法示例

Python排序算法之选择排序定义与用法示例 这篇文章主要介绍了Python排序算法之选择排序定义与用法,简单描述了选择排序的功能.原理,并结合实例形式分析了Python定义与使用选择排序的相关操作技 ...

- JAVA 基础编程练习题48 【程序 48 加密】

48 [程序 48 加密] 题目:某个公司采用公用电话传递数据,数据是四位的整数,在传递过程中是加密的,加密 规则如下:每位数字都加上 5,然后用和除以 10 的余数代替该数字,再将第一位和第四位交 ...

- 在Windows操作系统中安装MongoDB

如何在Windows操作系统中安装MongoDB: https://docs.mongodb.com/manual/tutorial/install-mongodb-on-windows/ 启动Mon ...

- Oracle拼接同一个字段多行的值

本文引用自- https://www.cnblogs.com/qianyuliang/p/6649983.html https://blog.csdn.net/defonds/article/de ...

- c++学习笔记_2

前言:本笔记所对应的课程为中国大学mooc中北京大学的程序设计与算法(三)C++面向对象程序设计,主要供自己复习使用,且本笔记建立在会使用c和java的基础上,只针对与c和java的不同来写 第二章 ...

- 关于使用Arduino做开发的理解

转载自arduino中文社区 https://www.arduino.cn/thread-5414-1-1.html 见到很多人对Arduino的开发方法 .应用场景有误解,特别开个帖子说明下. 误解 ...

- OpenCV_CS.测试

1.在C#中使用OpenCV(使用OpenCVSharp) - jsxyhelu - 博客园.html(https://www.cnblogs.com/jsxyhelu/p/9669583.html) ...

- 使用tensorflow训练SSD(一):相关环境的配置

在使用TensorFlow进行目标检测时,首先需要下载tensorflow object detection API模型,该模型的下载地址为https://github.com/tensorflow/ ...

- 2019牛客多校赛第一场 补题 I题

I题 Points Division 题意: 给你n个点,每个点有坐标(xi,yi)和属性(ai,bi),将点集划分为两个集合, 任意 A 集合的点 i 和 B 集合点 j, 不允许 xi > ...

- Kubernetes---资源控制器之DaemonSet、Job和CronJob

⒈DaemonSet介绍,什么是DaemonSet DaemonSet 确保全部(或者一些)Node 上运行一个Pod的副本[注意主节点并不会参加调度].当有 Node 加入集群时,也会为他们新增一个 ...