中文分词中的战斗机-jieba库

英文分词的第三方库NLTK不错,中文分词工具也有很多(盘古分词、Yaha分词、Jieba分词等)。但是从加载自定义字典、多线程、自动匹配新词等方面来看。

大jieba确实是中文分词中的战斗机。

请随意观看表演

安装

- 使用pip包傻瓜安装:

py -3 -m pip install jieba/pip install jiba(windows下推荐第一种,可以分别安装python2和3对应jieba) - pypi下载地址

分词

3种模式

- 精确模式:试图将句子最精确地切开,适合文本分析

- 全模式:把句子中所有的可以成词的词语都扫描出来(速度快)

- 搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词

实现方式

- 精确模式:

jieba.cut(sen) - 全模式:

jieba.cut(sen,cut_all=True) - 搜索引擎模式:

jieba.cut_for_search(sen)

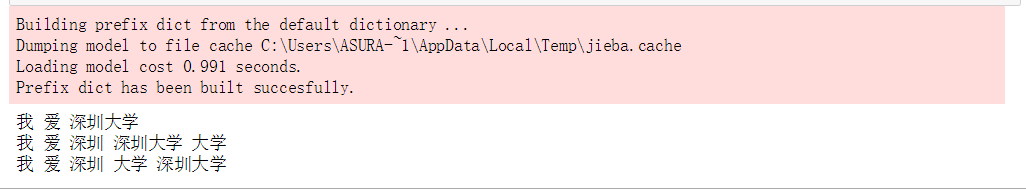

import jieba

sen = "我爱深圳大学"

sen_list = jieba.cut(sen)

sen_list_all = jieba.cut(sen,cut_all=True)

sen_list_search = jieba.cut_for_search(sen)

for i in sen_list:

print(i,end=" ")

print()

for i in sen_list_all:

print(i,end=" ")

print()

for i in sen_list_search:

print(i,end=" ")

print()

结果:附截图

自定义词典

创建方式

- 后缀:txt

- 格式:词语( 权重 词性 )

- 注意事项:

- windows下txt不能用自带的编辑器,否则会乱码。可以用VSCODE,或者其他编辑器

- 可以只有词语

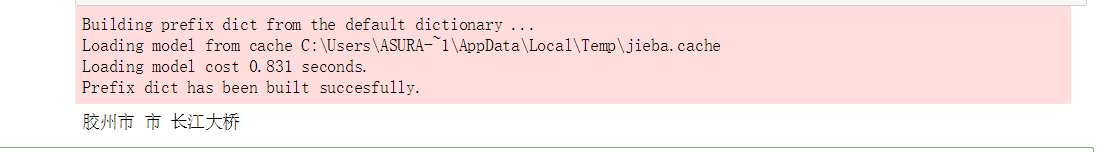

- 在没有权重的情况下,只有比默认词典长的词语才可以加载进去。附截图

加载字典

jieba.load_userdict(txtFile)

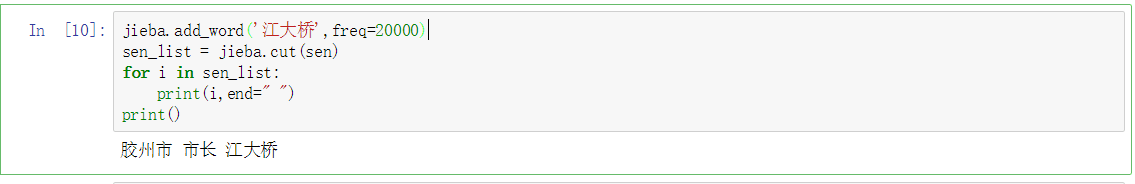

调整字典

添加词:jieba.add_word(word,freq=None,tag=None)

删除词:jieba.del_word(word)

import jieba

sen = "胶州市市长江大桥"

sen_list = jieba.cut(sen)

for i in sen_list:

print(i,end=" ")

print()

胶州市 市 长江大桥

jieba.add_word('江大桥',freq=20000)

sen_list = jieba.cut(sen)

for i in sen_list:

print(i,end=" ")

print()

结果附截图

改变主字典

- 占用内存较小的词典文件

- 支持繁体分词更好的词典文件

- 加载方法:

jieba.set_dictionary('data/dict.txt.big')

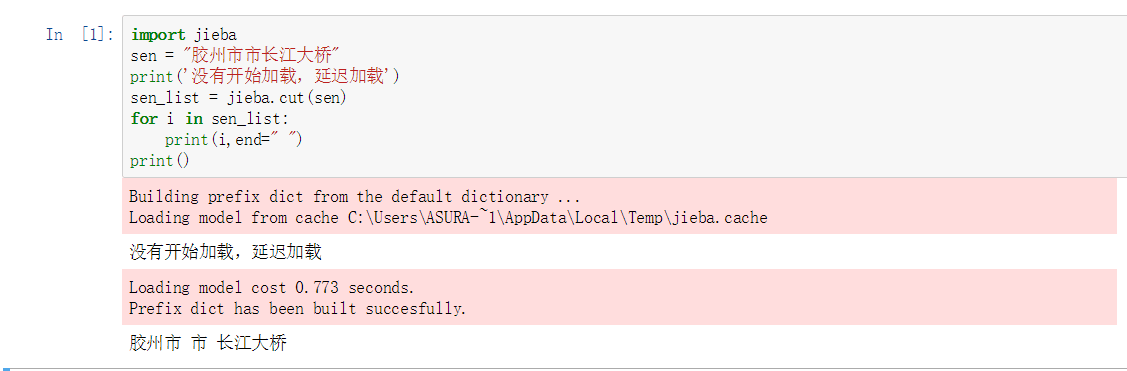

延迟加载

之前发现,词典不是一次性加载的,说明它采用的是延迟加载。即:当遇到应用的时候才会加载。有点类似于python高级特性中的

yield(节省内存)

效果图如下:

- 手动加载的方法:

jieba.initialize()

关键词提取

jieba.analyse.extract_tags(sentence,topK=20):返回topK个TF/IDF权重最大的词语

import jieba.analyse

sen_ana = jieba.analyse.extract_tags(sen,3)

for i in sen_ana:

print(i)

江大桥

胶州市

市长

词性标注

jieba.posseg.cut(sen):返回的每个迭代对象有两个属性-> word 词语 + flag 词性

import jieba.posseg

words = jieba.posseg.cut(sen)

for word in words:

print(word.flag," ",word.word)

ns 胶州市

n 市长

x 江大桥

词语定位

jieba.tokenize(sen,mode):mode可以设置为search,开启搜索模式

index= jieba.tokenize(sen)

for i in index:

print(i[0],"from",i[1],"to",i[2])

胶州市 from 0 to 3

市长 from 3 to 5

江大桥 from 5 to 8

内部算法

- 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG)

- 采用了动态规划查找最大概率路径, 找出基于词频的最大切分组合

- 对于未登录词,采用了基于汉字成词能力的HMM模型,使用了Viterbi算法。

参考文献

中文分词中的战斗机-jieba库的更多相关文章

- SCWS中文分词,向xdb词库添加新词

SCWS是个不错的中文分词解决方案,词库也是hightman个人制作,总不免有些不尽如人意的地方.有些词语可能不会及时被收入词库中. 幸好SCWS提供了词库XDB导出导入词库的工具(phptool_f ...

- Hanlp在java中文分词中的使用介绍

项目结构 该项目中,.jar和data文件夹和.properties需要从官网/github下载,data文件夹下载 项目配置 修改hanlp.properties: 1 #/Test/src/han ...

- 结巴(jieba)中文分词及其应用实践

中文文本分类不像英文文本分类一样只需要将单词一个个分开就可以了,中文文本分类需要将文字组成的词语分出来构成一个个向量.所以,需要分词. 这里使用网上流行的开源分词工具结巴分词(jieba),它可以有效 ...

- 如何运用jieba库分词

使用jieba库分词 一.什么是jieba库 1.jieba库概述 jieba是优秀的中文分词第三方库,中文文本需要通过分词获得单个词语. 2.jieba库的使用:(jieba库支持3种分词模式) 通 ...

- 运用jieba库分词

代码: 统计出团队中文简介中词频 import jieba txt=open("C:\\Users\\Administrator\\Desktop\\介绍.txt","r ...

- NLP舞动之中文分词浅析(一)

一.简介 针对现有中文分词在垂直领域应用时,存在准确率不高的问题,本文对其进行了简要分析,对中文分词面临的分词歧义及未登录词等难点进行了介绍,最后对当前中文分词实现的算法原理(基于词表. ...

- HMM(隐马尔科夫)用于中文分词

隐马尔可夫模型(Hidden Markov Model,HMM)是用来描述一个含有隐含未知参数的马尔可夫过程. 本文阅读了2篇blog,理解其中的意思,附上自己的代码,共同学习. 一.理解隐马尔科夫 ...

- R语言中文分词包jiebaR

R语言中文分词包jiebaR R的极客理想系列文章,涵盖了R的思想,使用,工具,创新等的一系列要点,以我个人的学习和体验去诠释R的强大. R语言作为统计学一门语言,一直在小众领域闪耀着光芒.直到大数据 ...

- 开源中文分词工具探析(四):THULAC

THULAC是一款相当不错的中文分词工具,准确率高.分词速度蛮快的:并且在工程上做了很多优化,比如:用DAT存储训练特征(压缩训练模型),加入了标点符号的特征(提高分词准确率)等. 1. 前言 THU ...

随机推荐

- tab栏切换,内容为不断实时刷新数据的vue实现方法

先说一下产品需求,就是有几个tab栏,每个tab栏对应的ajax请求不一样,内容区域一样,内容为实时刷新数据,每3s需要重新请求,返回的数据在内容区域展示,每点击一次tab栏需停止其他tab栏ajax ...

- sencha touch 总结

Ext.define("CM.product.MainviewListModel", { extend: "Ext.data.Model", config: { ...

- vue2.0+elementUI构建单页面后台管理平台

git:https://github.com/reg21st/vue2-management-platform 访问:https://reg21st.github.io/vue2-management ...

- Unity3D 协程 浅谈

协程 理解:协程不是线程,也不是异步执行(知道就行). 1.协程和MonoBehaviour的Update函数一样,也是在MainThread中执行的(一定得明白这句话意思). void Start ...

- [转]DevExpress GridControl 关于使用CardView的一点小结

最近项目里需要显示商品的一系列图片,打算用CardView来显示,由于第一次使用,遇到许多问题,发现网上这方面的资源很少,所以把自己的一点点实际经验小结一下,供自己和大家以后参考. 1.选择CardV ...

- CentOS 'mysql/mysql.h': No such file or directory

需要安装mysql-devel # yum install mysql-devel

- css过渡模块和2d转换模块

今天,我们一起来研究一下css3中的过渡模块.2d转换模块和3d转换模块 一.过渡模块transition (一)过度模块的三要素: 1.必须要有属性发生变化 2.必须告诉系统哪个属性需要执行过渡效果 ...

- 事件的preventDefault方法

事件有一个preventDefault()方法,该方法可以用来取消事件的默认行为.许多事件都有默认执行的关联行为.例如,如果用户在文本字段中键入一个字符,则默认行为就是在文本字段中显示该字符.由于可以 ...

- HNOI2017 滚粗记

这次HNOI,感觉自己收获了很多啊,高一的蒟蒻,也就是去历练一番,长长见识吧.. $day0$ 上午做了一道斜率优化的题,下午好像在颓??晚上也不想复习了,看了会电视,$12$点才睡.. $day1$ ...

- bzoj2144 【国家集训队2011】跳跳棋

Description 跳跳棋是在一条数轴上进行的.棋子只能摆在整点上.每个点不能摆超过一个棋子.我们用跳跳棋来做一个简单的游戏:棋盘上有3颗棋子,分别在a,b,c这三个位置.我们要通过最少的跳动把他 ...