CNTK 搞深度学习-1

CNTK 搞深度学习

Computational Network Toolkit (CNTK) 是微软出品的开源深度学习工具包。本文介绍CNTK的基本内容,如何写CNTK的网络定义语言,以及跑通一个简单的例子。

根据微软开发者的描述,CNTK的性能比Caffe,Theano, TensoFlow等主流工具都要强。它支持CPU和GPU模式,所以没有GPU,或者神经网络比较小的实验,直接用CPU版的CNTK跑就行了。 其开源主页在 https://github.com/Microsoft/CNTK 它把神经网络描述成一个有向图的结构,叶子节点代表输入或者网络参数,其他节点计算步骤。 它支持卷积神经网络和递归神经网络。 由于CNTK刚推出不久,大众教程估计不多,而且bug估计也不少。我学习的时候,主要参考三个资料:

1 官方入门教程 https://github.com/Microsoft/CNTK/wiki/Tutorial 本文也主要以这里的教程为例

2 官方论坛 https://github.com/Microsoft/CNTK/issues

3 官方论文 http://research.microsoft.com/pubs/226641/CNTKBook-20160217..pdf 这个有150页,我是当作字典来用,遇到问题的时候就在里面搜

安装CNTK: https://github.com/Microsoft/CNTK/wiki/CNTK-Binary-Download-and-Configuration 去这个页面找符合自己系统的版本。 我是Windows用户,CNTK有编译好的CPU和GPU版本。由于本人的显卡不是英伟达的,所以无奈只能用CPU版凑合用用。已经编译好的包最方便了,解压,然后把目录(类似%...%、CNTK-2016-02-08-Windows-64bit-CPU-Only\cntk\cntk)添加到PATH变量中就行了。 有条件的人也可以自己编译源代码,稍微麻烦一些,各种依赖关系,好处是源码更新的比较快,CNTK一大特点就是目前各种小bug比较多,比如我现在用的编译好的包还是两个月前发布的,已经自己填了好多坑了。

安装好CNTK之后,运行一个程序,就是一个简单的命令行: CNTK configFile=your_config_file , 其中,your_config_file 是网络的定义文件,大概长这样:

command=Train:Test

Train=[

action="train"

NDLNetworkBuilder = [

...

]

SGD = [

...

]

reader = [

...

]

]Test=[ ... ]

运行的入口就是command命令,command后面接需要依次运行的模块,用冒号分开。 每个模块里面需要定义的事情比较类似,主要是定义输入的格式,网络结构,学习算法(目前只有SGD)和参数。 在定义网络结构的时候,会指明哪些节点是优化目标,哪些是评价指标,以及哪些是输出的点。

众所周知,把神经网络的隐藏层去掉之后,输入直接连到输出层,这样就行成了一个logistics regression分类器。所以https://github.com/Microsoft/CNTK/wiki/Tutorial 这个教程就指导大家如何构建一个LR。 我这里稍微变一下,学习一下如何构建带有一层隐藏层的neural network,如下图:

定义网络结构

CNTK用网络描述语言(network description language, NDL)描述一个神经网络。 简单的说,我们要描述输入的feature,输入的label,一些参数,参数和输入之间的计算关系,以及目标节点是什么。

NDLNetworkBuilder=[

run=ndlLR

ndlLR=[

# sample and label dimensions

SDim=$dimension$

LDim=1

features=Input(SDim, 1)

labels=Input(LDim, 1)

# parameters to learn

B0 = Parameter(4)

W0 = Parameter(4, SDim)

B = Parameter(LDim)

W = Parameter(LDim, 4)

# operations

t0 = Times(W0, features)

z0 = Plus(t0, B0)

s0 = Sigmoid(z0)

t = Times(W, s0)

z = Plus(t, B)

s = Sigmoid(z)

LR = Logistic(labels, s)

EP = SquareError(labels, s)

# root nodes

FeatureNodes=(features)

LabelNodes=(labels)

CriteriaNodes=(LR)

EvalNodes=(EP)

OutputNodes=(s,t,z,s0,W0)

]

]

features=Input(SDim, 1) labels=Input(LDim, 1) 和 B0 = Parameter(4) 等可以想象成是在定义变量。 输入是列向量,CNTK里面的运算全是矩阵运算,所以就把输入当做只有一列的矩阵。 t0 = Times(W0, features) 是做矩阵乘法,t0把输入和权重相乘,z0 是在t0上面加了一个bias,

s0表示经过一个激活函数。 B0,W0,t0,z0,s0构成了隐层的操作,这里定义的隐层有4个节点。 t,z,s是输出层的操作,s就是输出节点的值。 框架定义好之后,还需要指定一些根节点,用来指定特殊的任务,例如 FeatureNodes=(features) 和LabelNodes=(labels)分别规定了输入和输出节点,CriteriaNodes 是训练的

时候优化的目标,EvalNodes 是在做评测的时候输出的参考值。OutputNodes 指定了需要输出到文件的节点。

设置训练算法

SGD = [

epochSize=0 # 每轮迭代使用的样例数, =0 表示使用整个训练集

minibatchSize=25 # 训练25个样本就更新一次参数

learningRatesPerMB=0.1 # learning rates per MB

maxEpochs=50 #迭代50次

]

目前只有SGD(以及在SGD上的各种变种),可以在里面设置各种参数。

设置输入格式

reader = [

#customDelimiter = " "

readerType = "UCIFastReader"

file = "Train.txt"

miniBatchMode = "partial"

verbosity = 1

randomize = "none" features=[

dim = $dimension$

start = 0

] labels=[

start = $dimension$ # skip $dimension$ elements before reading the label (i.e. the first two dimensions so we have "x1 x2 y" basically)

dim = 1 # label has 1 dimension

labelType=regression

labelMappingFile = "SimpleMapping.txt"

]

]

这也是CNTK的一个特点(吐槽点), 指定用什么方式读取数据文件。 readerType = "UCIFastReader" 指定用普通的扁平化表格的格式(一行一个样例,同一行内用空格隔开不同的数值),还有别的格式类型,例如图像格式,文本语料格式等。UCIFastReader 是将被弃用的,而且在目前最新的binary包中是有bug的 (所以说,有条件的同学尽量自己编译最新的源码)。 用官方教程里的设置直接跑回出bug,以上是我修改过的代码。 输入格式主要描述了feature是哪几列,维度是多少,label是哪几列, label的类型等等。

综上,Train这个模块就是定义了这几件事情:输入格式,网络内容,训练模式。 运行的时候也是这个步骤: 读取数据-> SGD 训练.

其他

除了Train之外的模块的流程比较类似,它们不需要再定义网络结构和训练模式,但是输入格式还是要指定的。 例如Test模块的流程是: 读取数据->计算网络->得到预测值->评估. 评估针对的是在网络结构中被定义为EvalNodes 的节点。 SquareError 只是其中的一种评估指标。如果想用别的误差函数,可以去查字典http://research.microsoft.com/pubs/226641/CNTKBook-20160217..pdf

Test=[

action="test"

reader=[

readerType="UCIFastReader"

file="Test.txt"

features=[

dim=2

start=0

]

labels=[

start=$dimension$

dim=1

labelDim=2

]

]

]

Output模块和Test的流程基本一样,只不过最后一个不是评估,而是把属于OutputNodes的值给输出到文件。 Output模块会指定一个输出目录 outputPath = "LR.txt" , 输出的文件以“LR.txt”为前缀,再加上变量命作为文件名。例如"LR.txt.W0"。

# output the results

Output=[

action="write"

reader=[

readerType="UCIFastReader"

file="Test.txt"

features=[

dim=$dimension$

start=0

]

labels=[

start=2

dim=1

labelType=regression

]

]

outputPath = "LR.txt" # dump the output as text

]

dumpNodeInfo 用来输出参数的值。这在调试中很有用,例如去看看网络的参数是如何变化的:

dumpNodeInfo=[

action=dumpnode

printValues=true

] ####################################################################

B=LearnableParameter [1,1] NeedGradient=true

-6.67130613

####################################################################

EP=SquareError ( labels , s )

features=InputValue [ 2 x 1 {1,2} ]

labels=InputValue [ 1 x 1 {1,1} ]

LR=Logistic ( labels , s )

s=Sigmoid ( z )

t=Times ( W , features )

W=LearnableParameter [1,2] NeedGradient=true

1.23924482 1.59913719

####################################################################

z=Plus ( t , B )

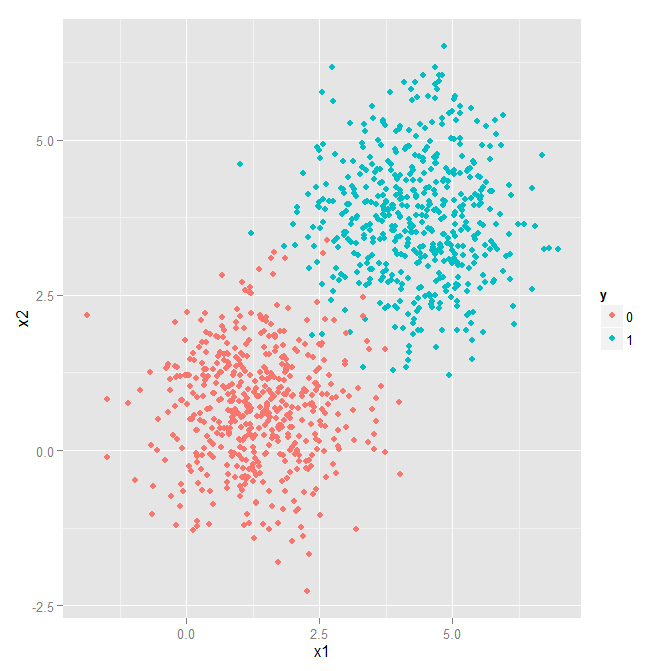

全部的代码如下。 train文件 https://github.com/Microsoft/CNTK/wiki/Tutorial/Train-3Classes.txt test 文件 https://github.com/Microsoft/CNTK/wiki/Tutorial/Test-3Classes.txt。 数据是2维的:

# Copyright (c) Microsoft. All rights reserved.

# Licensed under the MIT license. See LICENSE file in the project root for full license information. # logistic regression cntk script -- Network Description Language # which commands to run

command=Train:Output:dumpNodeInfo:Test #required...

modelPath="Models/LR_reg.dnn" # where to write the model to

deviceId=-1 # CPU

dimension=2 # input data dimensions # training config

Train=[

action="train"

traceLevel = 1

NDLNetworkBuilder=[ run=ndlLR ndlLR=[

# sample and label dimensions

SDim=$dimension$

LDim=1 features=Input(SDim, 1)

labels=Input(LDim, 1) # parameters to learn

B0 = Parameter(4)

W0 = Parameter(4, SDim) B = Parameter(LDim)

W = Parameter(LDim, 4) # operations

t0 = Times(W0, features)

z0 = Plus(t0, B0)

s0 = Sigmoid(z0) t = Times(W, s0)

z = Plus(t, B)

s = Sigmoid(z) LR = Logistic(labels, s)

EP = SquareError(labels, s) # root nodes

FeatureNodes=(features)

LabelNodes=(labels)

CriteriaNodes=(LR)

EvalNodes=(EP)

OutputNodes=(s,t,z,s0,W0)

]

] SGD = [

epochSize=0 # =0 means size of the training set

minibatchSize=25

learningRatesPerMB=0.1 # learning rates per MB

maxEpochs=50

] # parameter values for the reader

reader = [

#customDelimiter = " "

readerType = "UCIFastReader"

file = "Train.txt"

miniBatchMode = "partial"

verbosity = 1

randomize = "none" features=[

dim = $dimension$

start = 0

] labels=[

start = $dimension$ # skip $dimension$ elements before reading the label (i.e. the first two dimensions so we have "x1 x2 y" basically)

dim = 1 # label has 1 dimension

labelType=regression

labelMappingFile = "SimpleMapping.txt"

]

]

] # test

Test=[

action="test"

reader=[

readerType="UCIFastReader"

randomize = "none"

file="Test.txt"

features=[

dim=$dimension$

start=0

]

labels=[

start = $dimension$ # skip $dimension$ elements before reading the label (i.e. the first two dimensions so we have "x1 x2 y" basically)

dim = 1 # label has 1 dimension

labelType=regression

labelMappingFile = "SimpleMapping.txt"

]

]

] # output the results

Output=[

action="write"

reader=[

readerType="UCIFastReader"

file="Test.txt"

randomize = "none"

features=[

dim=$dimension$

start=0

] labels=[

start = $dimension$ # skip $dimension$ elements before reading the label (i.e. the first two dimensions so we have "x1 x2 y" basically)

dim = 1 # label has 1 dimension

labelType=regression

labelMappingFile = "SimpleMapping.txt"

]

]

outputPath = "LR.txt" # dump the output as text

] dumpNodeInfo=[

action=dumpnode

printValues=false

]

后一篇:

用CNTK搞深度学习 (二) 训练基于RNN的自然语言模型 ( language model )

http://www.cnblogs.com/sylvanas2012/p/5419477.html

CNTK 搞深度学习-1的更多相关文章

- 用 CNTK 搞深度学习 (一) 入门

Computational Network Toolkit (CNTK) 是微软出品的开源深度学习工具包.本文介绍CNTK的基本内容,如何写CNTK的网络定义语言,以及跑通一个简单的例子. 根据微软开 ...

- 用CNTK搞深度学习 (二) 训练基于RNN的自然语言模型 ( language model )

前一篇文章 用 CNTK 搞深度学习 (一) 入门 介绍了用CNTK构建简单前向神经网络的例子.现在假设读者已经懂得了使用CNTK的基本方法.现在我们做一个稍微复杂一点,也是自然语言挖掘中很火 ...

- Computational Network Toolkit (CNTK) 是微软出品的开源深度学习工具包

Computational Network Toolkit (CNTK) 是微软出品的开源深度学习工具包 用 CNTK 搞深度学习 (一) 入门 Computational Network Toolk ...

- 玩深度学习选哪块英伟达 GPU?有性价比排名还不够!

本文來源地址:https://www.leiphone.com/news/201705/uo3MgYrFxgdyTRGR.html 与“传统” AI 算法相比,深度学习(DL)的计算性能要求,可以说完 ...

- Windows10 利用 Docker 配置 TensofFlow 深度学习工具

TensorFlow 这个不用多介绍了吧,大家都知道,Google的开源深度学习软件库,官网点这里:https://www.tensorflow.org/ 当然这个工具官方支持装在 Ubuntu 和 ...

- 【转】贾扬清:希望Caffe成为深度学习领域的Hadoop

[转:http://www.csdn.net/article/2015-07-07/2825150] 在深度学习(Deep Learning)的热潮下,Caffe作为一个高效.实用的深度学习框架受到了 ...

- 【Todo】【转载】深度学习&神经网络 科普及八卦 学习笔记 & GPU & SIMD

上一篇文章提到了数据挖掘.机器学习.深度学习的区别:http://www.cnblogs.com/charlesblc/p/6159355.html 深度学习具体的内容可以看这里: 参考了这篇文章:h ...

- 深度学习Tensorflow生产环境部署(上·环境准备篇)

最近在研究Tensorflow Serving生产环境部署,尤其是在做服务器GPU环境部署时,遇到了不少坑.特意总结一下,当做前车之鉴. 1 系统背景 系统是ubuntu16.04 ubuntu@ub ...

- tensorflow(深度学习框架)详细讲解及实战

还未完全写完,本人会一直持续更新!~ 各大深度学习框架总结和比较 各个开源框架在GitHub上的数据统计,如下表: 主流深度学习框架在各个维度的评分,如下表: Caffe可能是第一个主流的工业级深度学 ...

随机推荐

- LinkedIn Cubert 实践指南

· LinkedIn Cubert安装指南 · Understanding Cubert Concepts(一)Partitioned Blocks · Understanding Cubert Co ...

- Excel显示当前日期

https://zhidao.baidu.com/question/431460329693825764.html 直接选中单元格,在公示栏输入=now()

- 怎样通过MSG_WAITALL设置阻塞时间,IO模式精细讲解: MSG_DONTWAIT 、 MSG_WAITALL

首先给出MSDN上一段设置阻塞超时的代码:(网址为http://social.msdn.microsoft.com/Forums/zh-SG/visualcpluszhchs/thread/3d9da ...

- FFT之大数乘法

#include <iostream> #include <stdio.h> #include <cmath> #include <algorithm> ...

- ssh框架的总结

一.spring:是基础,可以管理对象,也可以通过关键对象管理另一个框架.但是首先应该明确spring并不是只能应用于web方面,而是可以应用在一般的java项目中.只是如果在web环境下使用需要在w ...

- 【canvas】跟随鼠标的星空连线

2019-01-23 19:57:38 挂一个比较简单的一个canvas应用,利用CPU进行粒子实时计算,直接面向过程写的 帧动画:浏览器在下一个动画帧安排一次网页重绘, requestAnimat ...

- 【CS Round #39 (Div. 2 only) D】Seven-segment Display

[Link]:https://csacademy.com/contest/round-39/task/seven-segment-display/ [Description] 0..9各自有一个数字, ...

- Font-Awesome最新版完整使用教程

何为Font-Awesome Font Awesome gives you scalable vector icons that can instantly be customized - size, ...

- 牛客网剑指offer刷题总结

二维数组中的查找: 题目描述:在一个二维数组中,每一行都按照从左到右递增的顺序排序,每一列都按照从上到下递增的顺序排序.请完成一个函数,输入这样的一个二维数组和一个整数,判断数组中是否含有该整数. 两 ...

- wpf app全局变量传参方法(代码片段 )

清空某行绑定的行数据: int RowIndex = datagrid.SelectedIndex; _Table.Rows[RowIndex]["AVERAGE_PRICE"] ...