CDH6.2.0安装并使用基于HBase的Geomesa

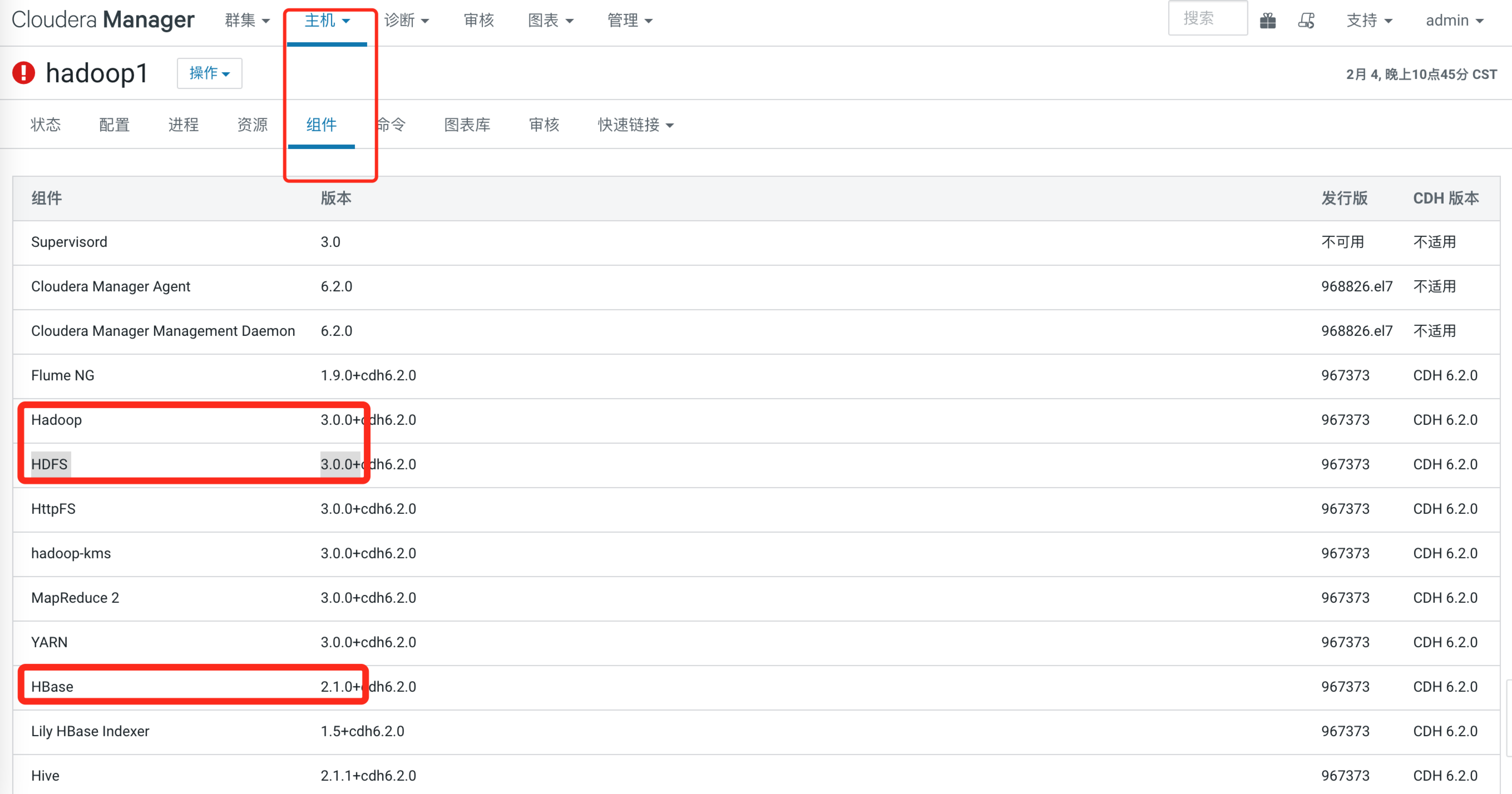

1. 查看CDH 安装的hadoop 和 hbase 对应的版本

具体可以参考以下博客:

https://www.cxyzjd.com/article/spark_Streaming/108762904

直接给出答案

- hadoop 版本 3.0.0

- hbase 版本 2.1.0

2. 在 github 找到其hbase版本对应的geomesa的版本

github 地址:

https://github.com/locationtech/geomesa/releases

这里我使用 3.1.1 的版本进行安装

进入安装了 hbase 的服务器(假设hbase已安装完毕),执行以下命令:

# 如果没有这个目录,自行创建

cd /opt/software

# 拉取安装包

wget "https://github.com/locationtech/geomesa/releases/download/geomesa_2.11-3.1.1/geomesa-hbase_2.11-3.1.1-bin.tar.gz"

# 解压缩, 如果没有这个目录,自行创建

tar -xvf geomesa-hbase_2.11-3.1.1-bin.tar.gz -C /opt/module

3. 将解压缩目录同步到各个hbase大数据节点

cd /opt/module

# xsync 脚本 之前的博客里有,自行copy,或者scp -r也可以

xsync geomesa-hbase_2.11-3.1.1

4. 配置相关环境变量,修改/etc/profile,增加以下内容

export GEOMESA_HBASE_HOME=/opt/module/geomesa-hbase_2.11-3.1.1

export HADOOP_HOME=/opt/cloudera/parcels/CDH/lib/hadoop

export HBASE_HOME=/opt/cloudera/parcels/CDH/lib/hbase

export PATH="${PATH}:${GEOMESA_HBASE_HOME}/bin"

记得最后source /etc/profile 一下

5. 安装 GeoMesa HBase分布式运行时JAR(重要一步)

cp $GEOMESA_HBASE_HOME/dist/hbase/geomesa-hbase-distributed-runtime-hbase2_2.11-3.1.1.jar ${HBASE_HOME}/lib

每台hbase节点都要操作

PS: 官网上的方法我没有跑通,最后推测原因是我用了最新版的tutorial,与运行时的jar版本不匹配导致,但最后没有再验证,这里仅记录我跑通的方案

6. 注册协处理器

修改hbase配置文件hbase-site.xml

位置

/opt/cloudera/parcels/CDH/lib/hbase/conf/hbase-site.xml

在configuration标签中添加:

<property>

<name>hbase.coprocessor.user.region.classes</name>

<value>org.locationtech.geomesa.hbase.coprocessor.GeoMesaCoprocessor</value>

</property>

每台hbase节点都要操作,或者xsync分发该配置文件到每个节点

PS: 官网上的方法我没有跑通,最后推测原因是我用了最新版的tutorial,与运行时的jar版本不匹配导致,但最后没有再验证,这里仅记录我跑通的方案

7. 验证

- command line 验证

geomesa-hbase

----

GeoMesa tools version: 3.1.1

Commit ID: d24fbb48458fa609dcea5b2f95d987674d19eefa

Branch: d24fbb48458fa609dcea5b2f95d987674d19eefa

Build date: 2021-04-26T12:21:01+0000

$GEOMESA_HBASE_HOME/bin/geomesa-hbase ingest -c example-csv -s example-csv \

-C example-csv $GEOMESA_HBASE_HOME/examples/ingest/csv/example.csv

#执行ok

# hbase shell 后 list 可以看到表已创建

TABLE

example-csv

example-csv_example_2dcsv_attr_name_geom_lastseen_v8

example-csv_example_2dcsv_id_v4

example-csv_example_2dcsv_z2_geom_v5

example-csv_example_2dcsv_z3_geom_lastseen_v6

- 代码验证

拉取官方的tutorial代码

地址:git clone https://github.com/geomesa/geomesa-tutorials.git

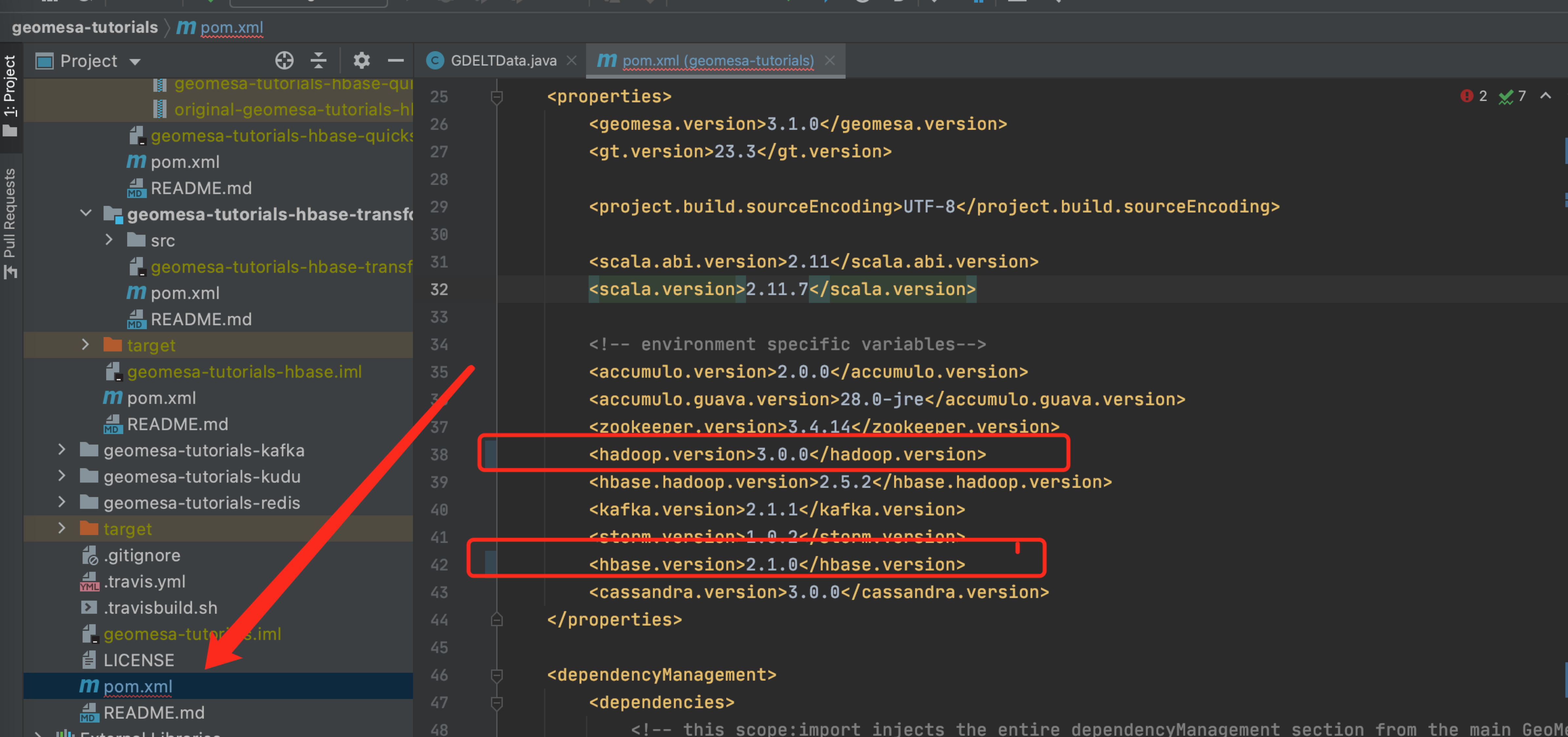

这里有两个小坑

【1】首先要切换到和自己运行时JAR对应的版本上去(没找到3.1.1,切到tag 3.1.0上)

git checkout geomesa-tutorials-3.1.0

【2】pom里指定的hadoop版本和hbase版本不对,需要改成我们对应的版本

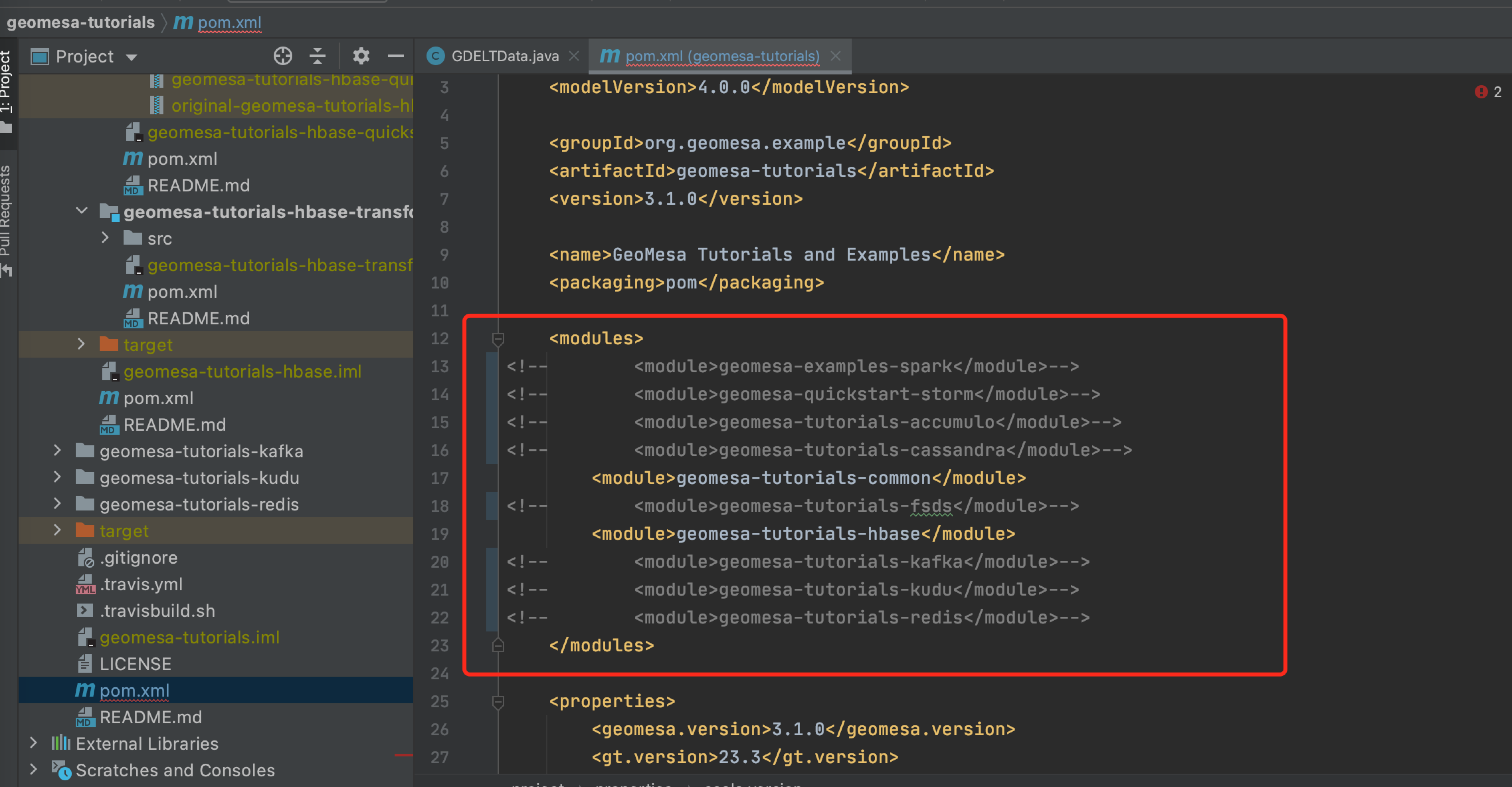

【3】为了加快拉取依赖,注释掉不需要的module

构建项目

mvn clean install -pl geomesa-tutorials-hbase/geomesa-tutorials-hbase-quickstart -am

- 将jar包丢到hbase对应的服务器上,执行

java -cp geomesa-tutorials-hbase-quickstart-3.1.0.jar \

org.geomesa.example.hbase.HBaseQuickStart \

--hbase.zookeepers hadoop1,hadoop2,hadoop3 \

--hbase.catalog geomesa_grady

可以查看到正确日志,以下为日志:

[hadoop@hadoop1 test]# java -cp geomesa-tutorials-hbase-quickstart-3.1.0.jar \

org.geomesa.example.hbase.HBaseQuickStart \

--hbase.zookeepers hadoop1,hadoop2,hadoop3 \

--hbase.catalog geomesa_grady

Loading datastore

Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Creating schema: GLOBALEVENTID:String,Actor1Name:String,Actor1CountryCode:String,Actor2Name:String,Actor2CountryCode:String,EventCode:String,NumMentions:Integer,NumSources:Integer,NumArticles:Integer,ActionGeo_Type:Integer,ActionGeo_FullName:String,ActionGeo_CountryCode:String,dtg:Date,geom:Point:srid=4326

The version of ZooKeeper being used doesn't support Container nodes. CreateMode.PERSISTENT will be used instead.

Table geomesa_grady not enabled, it is not exists

Table geomesa_grady not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_z3_geom_dtg_v6 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_z3_geom_dtg_v6 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_z2_geom_v5 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_z2_geom_v5 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_z2_geom_v5 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_id_v4 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_id_v4 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_attr_EventCode_geom_dtg_v8 not enabled, it is not exists

Table geomesa_grady_gdelt_2dquickstart_attr_EventCode_geom_dtg_v8 not enabled, it is not exists

Generating test data

Writing test data

Wrote 2356 features

Running query BBOX(geom, -120.0,30.0,-75.0,55.0) AND dtg DURING 2017-12-31T00:00:00+00:00/2018-01-02T00:00:00+00:00

01 719025288=719025288|CANADA|CAN|||190|4|1|4|4|Penticton, British Columbia, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-119.583 49.5)

02 719025945=719025945|DEPARTMENT OF EDUCATION||OBAMA|USA|090|20|2|20|2|North Dakota, United States|US|2018-01-01T00:00:00.000Z|POINT (-99.793 47.5362)

03 719025853=719025853|PRESIDENT||MEXICO|MEX|0874|3|3|3|2|Minnesota, United States|US|2018-01-01T00:00:00.000Z|POINT (-93.9196 45.7326)

04 719025856=719025856|PRESIDENT||MEXICO|MEX|131|3|3|3|2|Minnesota, United States|US|2018-01-01T00:00:00.000Z|POINT (-93.9196 45.7326)

05 719026960=719026960|UNITED STATES|USA|||071|6|1|6|2|Minnesota, United States|US|2018-01-01T00:00:00.000Z|POINT (-93.9196 45.7326)

06 719024925=719024925|||CORPORATION||172|2|1|2|4|Saskatoon, Saskatchewan, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-106.667 52.1333)

07 719025289=719025289|CANADA|CAN|CORPORATION||115|6|1|6|4|Saskatoon, Saskatchewan, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-106.667 52.1333)

08 719025290=719025290|CANADA|CAN|CORPORATION||172|8|1|8|4|Saskatoon, Saskatchewan, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-106.667 52.1333)

09 719025276=719025276|SASKATCHEWAN|CAN|||020|20|1|10|4|Saskatchewan, Manitoba, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-97.7167 52.15)

10 719025946=719025946|PREMIER||||015|6|1|6|4|Saskatchewan, Manitoba, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-97.7167 52.15)

Returned 669 total features

Running query BBOX(geom, -120.0,30.0,-75.0,55.0) AND dtg DURING 2017-12-31T00:00:00+00:00/2018-01-02T00:00:00+00:00

Returning attributes [GLOBALEVENTID, dtg, geom]

01 719025288=719025288|2018-01-01T00:00:00.000Z|POINT (-119.583 49.5)

02 719025945=719025945|2018-01-01T00:00:00.000Z|POINT (-99.793 47.5362)

03 719025853=719025853|2018-01-01T00:00:00.000Z|POINT (-93.9196 45.7326)

04 719025856=719025856|2018-01-01T00:00:00.000Z|POINT (-93.9196 45.7326)

05 719026960=719026960|2018-01-01T00:00:00.000Z|POINT (-93.9196 45.7326)

06 719024925=719024925|2018-01-01T00:00:00.000Z|POINT (-106.667 52.1333)

07 719025289=719025289|2018-01-01T00:00:00.000Z|POINT (-106.667 52.1333)

08 719025290=719025290|2018-01-01T00:00:00.000Z|POINT (-106.667 52.1333)

09 719025276=719025276|2018-01-01T00:00:00.000Z|POINT (-97.7167 52.15)

10 719025946=719025946|2018-01-01T00:00:00.000Z|POINT (-97.7167 52.15)

Returned 669 total features

Running query EventCode = '051'

01 719025634=719025634|FIJI|FJI|||051|2|1|2|1|Fiji|FJ|2018-01-01T00:00:00.000Z|POINT (178 -18)

02 719027116=719027116|UNITED STATES|USA|KING||051|8|1|8|3|San Diego, California, United States|US|2018-01-01T00:00:00.000Z|POINT (-117.157 32.7153)

03 719027117=719027117|LOS ANGELES|USA|KING||051|26|3|26|2|California, United States|US|2018-01-01T00:00:00.000Z|POINT (-119.746 36.17)

04 719025036=719025036|||SENATE||051|5|1|5|2|Alabama, United States|US|2018-01-01T00:00:00.000Z|POINT (-86.8073 32.799)

05 719026318=719026318|SENATE||UNITED STATES|USA|051|2|1|2|2|Alabama, United States|US|2018-01-01T00:00:00.000Z|POINT (-86.8073 32.799)

06 719026296=719026296|CHAMBER||||051|20|1|20|3|Springfield, South Carolina, United States|US|2018-01-01T00:00:00.000Z|POINT (-81.2793 33.4968)

07 719025744=719025744|CIVIL SERVANT||||051|20|1|10|3|White House, District of Columbia, United States|US|2018-01-01T00:00:00.000Z|POINT (-77.0364 38.8951)

08 719026946=719026946|INDIANA|USA|||051|12|1|12|2|Indiana, United States|US|2018-01-01T00:00:00.000Z|POINT (-86.2604 39.8647)

09 719025279=719025279|EDMONTON|CAN|||051|5|1|5|4|Dufferin County, Ontario, Canada|CA|2018-01-01T00:00:00.000Z|POINT (-80.1667 44.0833)

10 719027252=719027252|AMERICAN CIVIL LIBERTIES UNION|USA|||051|2|1|2|2|Pennsylvania, United States|US|2018-01-01T00:00:00.000Z|POINT (-77.264 40.5773)

Returned 138 total features

Running query EventCode = '051' AND dtg DURING 2017-12-31T00:00:00+00:00/2018-01-02T00:00:00+00:00

Returning attributes [GLOBALEVENTID, dtg, geom]

01 719025248=719025248|2018-01-01T00:00:00.000Z|POINT (135 -25)

02 719026319=719026319|2018-01-01T00:00:00.000Z|POINT (-97.6475 31.106)

03 719027258=719027258|2018-01-01T00:00:00.000Z|POINT (-97.6475 31.106)

04 719026945=719026945|2018-01-01T00:00:00.000Z|POINT (-119.746 36.17)

05 719027115=719027115|2018-01-01T00:00:00.000Z|POINT (-121.494 38.5816)

06 719025112=719025112|2018-01-01T00:00:00.000Z|POINT (-97.3375 37.6922)

07 719025110=719025110|2018-01-01T00:00:00.000Z|POINT (-81.9296 33.7896)

08 719026297=719026297|2018-01-01T00:00:00.000Z|POINT (-77.0364 38.8951)

09 719026943=719026943|2018-01-01T00:00:00.000Z|POINT (-87.6501 41.85)

10 719026364=719026364|2018-01-01T00:00:00.000Z|POINT (-77.264 40.5773)

Returned 138 total features

Done

验证ok

CDH6.2.0安装并使用基于HBase的Geomesa的更多相关文章

- ①CM+CDH6.2.0安装(全网最全)

CM+CDH6.2.0环境准备 一 虚拟机及CentOs7配置 CentOS下载地址 master(16g+80g+2cpu+2核)+2台slave(8g+60g+2cpu+2核) 1.1 打开&qu ...

- CDH6.3.0下Apache Atlas2.1.0安装与配置

CDH6.3.0下Apache Atlas2.1.0安装与配置 0. 说明 文中的${ATLAS_HOME}, ${HIVE_HOME} 环境变更需要根据实际环境进行替换. 1. 依赖 A. 软件依赖 ...

- 安装配置和使用HBASE Cluster(基于发行版CDH5.0.2)——系列随笔

本系列文章只是记录了笔者本人在学习实验安装和使用基于CDH5.0.2的HBASE集群过程中的一些经验教训和心得,绝不是详细的安装过程,因本人不过一初学者,很多方面不甚了了,如果能让不幸读到的人有所得则 ...

- CDH6.1.0离线安装——笔记

一. 概述 该文档主要记录大数据平台的搭建CDH版的部署过程,以供后续部署环境提供技术参考. 1.1 主流大数据部署方法 目前主流的hadoop平台部署方法主要有以下三种: Apache hadoop ...

- 【K8S】K8S 1.18.2安装dashboard(基于kubernetes-dashboard 2.0.0版本)

[K8S]K8S 1.18.2安装dashboard(基于kubernetes-dashboard 2.0.0版本) 写在前面 K8S集群部署成功了,如何对集群进行可视化管理呢?别着急,接下来,我们一 ...

- CDH6.2.0离线安装(详细)

目录 01 准备工作 02 环境配置 03 CDH安装 报错 01 准备工作 官网地址下载页面:https://www.cloudera.com/downloads/cdh.html,现在下载好像需要 ...

- phoenix部署手册-基于hbase

背景描述: phoenix基于hbase的SQL层,映射hbase的表,也可以映射视图(VIEW) 部署安装比较简单 映射表和视图的区别: 映射表: 在Phoenix建表错误不易更改: 删除会连同hb ...

- 一种基于HBase韵海量图片存储技术

针对海量图片存储,已有若干个基于Hadoop的方案被设计出来.这些方案在系统层小文件合并.全局名字空间以及通用性方面存在不足.本文基于HBase提出了一种海量图片存储技术,成功解决了上述问题.本文将介 ...

- CDH6.2离线安装(整理版)

1.概述 CDH,全称Cloudera's Distribution, including Apache Hadoop.是Hadoop众多分支中对应中的一种,由Cloudera维护,基于稳定版本的Ap ...

随机推荐

- UiPath鼠标操作元素的介绍和使用

一.鼠标(mouse)操作的介绍 模拟用户使用鼠标操作的一种行为,例如单击,双击,悬浮.根据作用对象的不同我们可以分为对元素的操作.对文本的操作和对图像的操作 二.鼠标对元素的操作在UiPath中的使 ...

- NC14731 逆序对

NC14731 逆序对 题目 题目描述 求所有长度为 \(n\) 的 \(01\) 串中满足如下条件的二元组个数: 设第 \(i\) 位和第 \(j\) 位分别位 \(a_i\) 和 \(a_j\) ...

- NC16618 [NOIP2008]排座椅

NC16618 [NOIP2008]排座椅 题目 题目描述 上课的时候总有一些同学和前后左右的人交头接耳,这是令小学班主任十分头疼的一件事情.不过,班主任小雪发现了一些有趣的现象,当同学们的座次确定下 ...

- WPF双滑块控件以及强制捕获鼠标事件焦点

效果 概述 最近有个小需求要用双滑块表示一个取值范围,于是就简单做了个用户控件,在此记录下. 使用矩形Rectangle表示范围,椭圆Ellipse表示滑块,使用Canvas控制滑块的左右移动. 椭圆 ...

- HTTP Status 405 - Request method 'GET' not supported?(尚硅谷Restful案例练习关于Delete方法出现的错误)

哈罗大家好,最近在如火如荼的学习java开发----Spring系列框架,当学习到SpringMVC,动手实践RESTFUL案例时,发现了以上报错405,get请求方法没有被支持. 首先第一步,我查看 ...

- 注意力机制最新综述:A Comprehensive Overview of the Developments in Attention Mechanism

(零)注意力模型(Attention Model) 1)本质:[选择重要的部分],注意力权重的大小体现选择概率值,以非均匀的方式重点关注感兴趣的部分. 2)注意力机制已成为人工智能的一个重要概念,其在 ...

- .NET ORM框架HiSql实战-第三章-使用自定义编号生成【申请编号】

一.引言 上一篇.NET ORM框架HiSql实战-第二章-使用Hisql实现菜单管理(增删改查) 中菜单编号采用的是雪花ID,生成的编号无法自定义.比如本系统的一个申请业务,需要按前缀+日期+流水号 ...

- java线程池开启多线程

// //maximumPoolSize设置为2 ,拒绝策略为AbortPolic策略,直接抛出异常 ThreadPoolExecutor pool = new ThreadPoolExecutor( ...

- UVA195 Anagram 题解

To 题目 主要思路:全排列 + 亿点点小技巧. 不会全排列的可以先把这道题过了 \(P1706\). 这道题的难点就在于有重复的单词,只记一次. 第一个想法是将所有以生成的单词记录下来,然后每次判断 ...

- 【HMS core】【FAQ】HMS Toolkit典型问题合集1

1.[开发工具][HMS Toolkit][问题描述] HMS Toolkit 插件导致Android Studio崩溃无法使用 [解决方案] 1) 检查Android Studi ...