【自然语言处理】利用LDA对希拉里邮件进行主题分析

首先是读取数据集,并将csv中ExtractedBodyText为空的给去除掉

import pandas as pd

import re

import os dir_path=os.path.dirname(os.path.abspath(__file__))

data_path=dir_path+"/Database/HillaryEmails.csv"

df=pd.read_csv(data_path)

df=df[['Id','ExtractedBodyText']].dropna()

对于这些邮件信息,并不是所有的词都是有意义的,也就是先要去除掉一些噪声数据:

def clean_email_text(text):

text = text.replace('\n'," ") #新行,我们是不需要的

text = re.sub(r"-", " ", text) #把 "-" 的两个单词,分开。(比如:july-edu ==> july edu)

text = re.sub(r"\d+/\d+/\d+", "", text) #日期,对主体模型没什么意义

text = re.sub(r"[0-2]?[0-9]:[0-6][0-9]", "", text) #时间,没意义

text = re.sub(r"[\w]+@[\.\w]+", "", text) #邮件地址,没意义

text = re.sub(r"/[a-zA-Z]*[:\//\]*[A-Za-z0-9\-_]+\.+[A-Za-z0-9\.\/%&=\?\-_]+/i", "", text) #网址,没意义

pure_text = ''

# 以防还有其他特殊字符(数字)等等,我们直接把他们loop一遍,过滤掉

for letter in text:

# 只留下字母和空格

if letter.isalpha() or letter==' ':

pure_text += letter

# 再把那些去除特殊字符后落单的单词,直接排除。

# 我们就只剩下有意义的单词了。

text = ' '.join(word for word in pure_text.split() if len(word)>1)

return text

然后取出ExtractedBodyText的那一列,对每一行email进行噪声过滤,并返回一个对象:

docs = df['ExtractedBodyText']

docs = docs.apply(lambda s: clean_email_text(s))

然后我们呢把里面的email提取出来:

doclist=docs.values

接下来,我们使用gensim库来进行LDA模型的构建,gensim可用指令pip install -U gensim安装。但是,要注意输入到模型中的数据的格式。例如:将[[一条邮件字符串],[另一条邮件字符串], ...]转换成[[一,条,邮件,在,这里],[第,二,条,邮件,在,这里],[今天,天气,肿么,样],...]。对于英文的分词,只需要对空白处分割即可。同时,有些词语(不同于噪声)是没有意义的,我们要过滤掉那些没有意义的词语,这里简单的写一个停止词列表:

stoplist = ['very', 'ourselves', 'am', 'doesn', 'through', 'me', 'against', 'up', 'just', 'her', 'ours',

'couldn', 'because', 'is', 'isn', 'it', 'only', 'in', 'such', 'too', 'mustn', 'under', 'their',

'if', 'to', 'my', 'himself', 'after', 'why', 'while', 'can', 'each', 'itself', 'his', 'all', 'once',

'herself', 'more', 'our', 'they', 'hasn', 'on', 'ma', 'them', 'its', 'where', 'did', 'll', 'you',

'didn', 'nor', 'as', 'now', 'before', 'those', 'yours', 'from', 'who', 'was', 'm', 'been', 'will',

'into', 'same', 'how', 'some', 'of', 'out', 'with', 's', 'being', 't', 'mightn', 'she', 'again', 'be',

'by', 'shan', 'have', 'yourselves', 'needn', 'and', 'are', 'o', 'these', 'further', 'most', 'yourself',

'having', 'aren', 'here', 'he', 'were', 'but', 'this', 'myself', 'own', 'we', 'so', 'i', 'does', 'both',

'when', 'between', 'd', 'had', 'the', 'y', 'has', 'down', 'off', 'than', 'haven', 'whom', 'wouldn',

'should', 've', 'over', 'themselves', 'few', 'then', 'hadn', 'what', 'until', 'won', 'no', 'about',

'any', 'that', 'for', 'shouldn', 'don', 'do', 'there', 'doing', 'an', 'or', 'ain', 'hers', 'wasn',

'weren', 'above', 'a', 'at', 'your', 'theirs', 'below', 'other', 'not', 're', 'him', 'during', 'which']

然后我们将输入转换成gensim所需的格式,并过滤掉停用词:

texts = [[word for word in doc.lower().split() if word not in stoplist] for doc in doclist]

再将这所有的单词放入到一个词袋中,把每个单词用一个数字index指代:

from gensim import corpora, models, similarities

import gensim

dictionary = corpora.Dictionary(texts)

再分别统计每一篇email中每个词语在这个词袋中出现的次数,并返回一个列表:

corpus = [dictionary.doc2bow(text) for text in texts]

这个列表告诉我们,第14(从0开始是第一)个邮件中,一共6个有意义的单词(经过我们的文本预处理,并去除了停止词后)其中,51号单词出现1次,505号单词出现1次,以此类推。。。

最后,就可以开始构建我们的模型了:

lda = gensim.models.ldamodel.LdaModel(corpus=corpus, id2word=dictionary, num_topics=20)

print(lda.print_topic(10, topn=5))

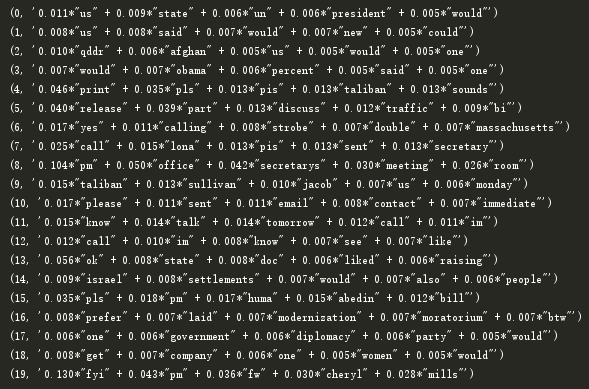

可以看到,第11个主题最常用的单词,接下来,我们看下所有的主题:

for i in lda.print_topics(num_topics=20, num_words=5):

print(i)

我们再看下第一篇email属于哪一个主题:

print(lda.get_document_topics(corpus[0]))

属于第四个主题的概率是0.95

相关代码和数据:链接: https://pan.baidu.com/s/1sl1I5IeQFDHjVwf2a0C89g 提取码: xqqf

【自然语言处理】利用LDA对希拉里邮件进行主题分析的更多相关文章

- centos下利用mail命令进行邮件发送

centos下默认自带mail命令: 可以用如下命令查看存放位置: which mail 结果如下: 如果没有安装可以使用 如下命令安装 yum -y install mailx 利用mail命令进行 ...

- JavaMail(二):利用JavaMail发送复杂邮件

上一篇文章我们学习了利用JavaMail发送简单邮件,这篇文章我们利用JavaMail发送稍微复杂一点的邮件(包含文本.图片.附件).这里只贴出核心代码,其余代码可参考JavaMail(一):利用Ja ...

- Android利用tcpdump抓包,用wireshark分析包。

1.前言 主要介绍在android手机上如何利用tcpdump抓包,用wireshark分析包. android tcpdump官网: http://www.androidtcpdump.com/ t ...

- 利用 Memory Dump Diagnostic for Java (MDD4J) 分析内存管理问题

利用 Memory Dump Diagnostic for Java (MDD4J) 分析内存管理问题(2) 启动和理解 MDD4J[size=1.0625]为了充分理解如何使用 MDD4J,您需要了 ...

- 前端性能优化之利用 Chrome Dev Tools 进行页面性能分析

背景 我们经常使用 Chrome Dev Tools 来开发调试,但是很少知道怎么利用它来分析页面性能,这篇文章,我将详细说明怎样利用 Chrome Dev Tools 进行页面性能分析及性能报告数据 ...

- LDA模型应用实践-希拉里邮件主题分类

#coding=utf8 import numpy as np import pandas as pd import re from gensim import corpora, models, si ...

- 自然语言处理基础与实战(8)- 主题模型LDA理解与应用

本文主要用于理解主题模型LDA(Latent Dirichlet Allocation)其背后的数学原理及其推导过程.本菇力求用简单的推理来论证LDA背后复杂的数学知识,苦于自身数学基础不够,因此文中 ...

- django实现利用mailgun进行收发邮件

django窗口类运用和邮件收发 运用django窗口类来完成表单html 1 具体你看网址: https://www.cnblogs.com/guguobao/p/9322027.html 利用窗口 ...

- 如何利用sendmail发送外部邮件?

在写监控脚本时,为了更好的监控服务器性能,如磁盘空间.系统负载等,有必要在系统出现瓶颈时,及时向管理员进行报告.在这里通常采用邮件报警,同时,邮件设置为收到邮件,即向指定手机号码发送短信.这样可以实现 ...

随机推荐

- Vue部分编译不生效,解决Vue渲染时候会闪一下

0828自我总结 Vue部分编译不生效,解决Vue渲染时候会闪一下 一.Vue编译不生效 在标签里添加v-pre <script src="vue.js"></s ...

- 【C语言笔记】#define与typedef的区别

1.#define define是预处理指令,在编译时不进行任何检查,只进行简单的替换 宏定义的一般形式为: #define 宏名 字符串 这里所说的字符串是一般意义上的字符序列,不要和C语言中的字符 ...

- Unity 场景中看不到物体或者OnDrawGizmos画的线看不到

有时候,Unity中的场景里面,物体突然看不见了,可以这样做: 首先,在 Hierarchy 面板选择看不见的物体,按下快捷键 f.如果物体还是看不见,见下图: 看看图中圈红的地方.如果,如果 ...

- 动画讲解TCP

前言 TCP 三次握手过程对于面试是必考的一个,所以不但要掌握 TCP 整个握手的过程,其中有些小细节也更受到面试官的青睐. 对于这部分掌握以及 TCP 的四次挥手,小鹿将会以动画的形式呈现给每个人, ...

- [JZOJ5456]【NOIP2017提高A组冲刺11.6】奇怪的队列

Description nodgd的粉丝太多了,每天都会有很多人排队要签名.今天有

- gojs常用API (中文文档)

常用API 操作类API API 例子 应用场景 添加节点 myDiagram.model.addNodeData(node); var node = {}; node["key&q ...

- ES常用操作备忘

格式:<REST Verb>/<Index>/<Type>/<ID> 集群健康:curl -u lases:1fw@2soc#3vpn -XGET 'l ...

- (二)Kinect关节识别

基础:添加KinectManager 组件 1)局部关节获取(参考插件场景KinectOverlayDemo1) 要获取局部某一关节及其位置,添加脚本JointOverlayer即可,通过Tracke ...

- 关于高淇JAVA中SORM总结学习笔记详细个人解释

代码来源于高淇JAVA教学视频 谢谢高淇老师的教学. 因为自己在学习的过程中发现了很多困难点,总结下希望对自己接下来学框架提升.给像我一样得初学者方便. SORM框架是一个简单的ORM,关系对象映射, ...

- Scrapy 框架入门简介

一.Scrapy框架简介 Scrapy 是用 Python 实现的一个为了爬取网站数据.提取结构性数据而编写的应用框架. Scrapy 常应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中. ...