Python3获取拉勾网招聘信息

为了了解跟python数据分析有关行业的信息,大概地了解一下对这个行业的要求以及薪资状况,我决定从网上获取信息并进行分析。既然想要分析就必须要有数据,于是我选择了拉勾,冒着危险深入内部,从他们那里得到了信息。不得不说,拉勾的反爬技术还挺厉害的,稍后再说明。话不多说,直接开始。

一、明确目的

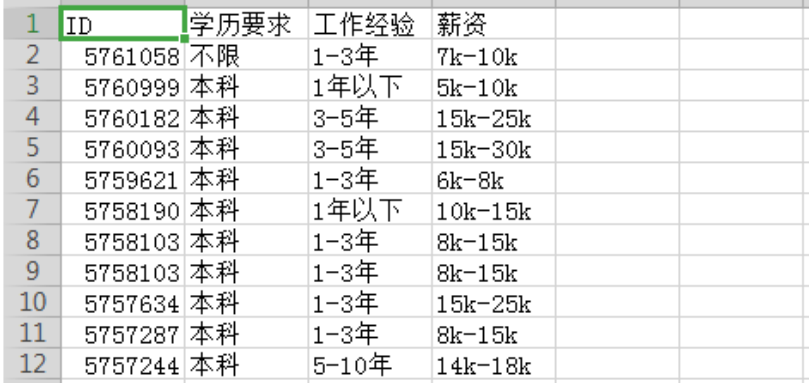

每次爬虫都要有明确的目的,刚接触随便找东西试水的除外。我想要知道的是python数据分析的要求以及薪资状况,因此,薪资、学历、工作经验以及一些任职要求就是我的目的。

既然明确了目的,我们就要看一下它们在什么位置,所以我们打开浏览器,寻找目标。像拉勾这种网站他们的信息一般都是通过ajax加载的,而且在输入“python数据分析”敲击回车之后跳转的页面,招聘信息不是一开始就显示出来的,通过点击页码也只是招聘信息在变化甚至连network都没多大变化,可以大胆猜测他是通过post请求的,所以我们只关注post请求以及XHR文件,很快就发现了我们要的东西。

点击preview可见详细信息以json形式保存着,其中‘salary’、‘workYear’、‘education’、‘positionID’(招聘信息详情页有关的id)是我们要的。再观察一下它的form data,其中kd=关键字,pn=pageNum(页码)这是我们请求的时候要带上的参数。另外我们要注意请求头的referer参数,待会儿要用。知道了目标之后,爬起来!

二、开始爬虫

先设置请求头headers,把平时用的user-agent带上,再把formdata也带上,用requests库直接requests.post(url, headers=headers, data=formdata),然后就开始报错了:{"status":false,"msg":"您操作太频繁,请稍后再访问","clientIp":"......","state":2402}。

解决这个问题的关键在于,了解拉勾的反爬机制:在进入python数据分析招聘页之前,我们要在主页,不妨叫它start_url输入关键字跳转。在这个过程中,服务器会传回来一个cookies,如果带着这个cookies请求的话我们就可以得到要的东西,所以要先请求start_url获取cookies在请求目标url,而且在请求目标地址的话还要带上referer这个请求头参数,referer的含义大概是这样:告诉服务器我是从哪个页面链接过来的,服务器基此可以获得一些信息用于处理。另外,睡眠时间也要设置的长一点,不然很容易被封。知道了反爬机制之后,话不多说,直接上代码。

'''

@author: Max_Lyu

Create time: 2019/4/1

url: https://github.com/MaxLyu/Lagou_Analyze

'''

# 请求起始 url 返回 cookies

def get_start_url(self):

session = requests.session()

session.get(self.start_url, headers=self.headers, timeout=3)

cookies = session.cookies

return cookies # 将返回的 cookies 一起 post 给 target_url 并获取数据

def post_target_url(self):

cookies = self.get_start_url()

pn = 1

for pg in range(30):

formdata = {

'first': 'false',

'pn': pn,

'kd': 'python数据分析'

}

pn += 1 response = requests.post(self.target_url, data=formdata, cookies=cookies, headers=self.headers, timeout=3)

self.parse(response)

time.sleep(60) # 拉勾的反扒技术比较强,短睡眠时间会被封 # 解析 response,获取 items

def parse(self, response):

print(response)

items = []

print(response.text)

data = json.loads(response.text)['content']['positionResult']['result'] if len(data):

for i in range(len(data)):

positionId = data[i]['positionId']

education = data[i]['education']

workYear = data[i]['workYear']

salary = data[i]['salary']

list = [positionId, education, workYear, salary]

items.append(list)

self.save_data(items)

time.sleep(1.3)

其中save_data(items)是保存文件,我是保存在csv文件。篇幅有限,这里就不展示了。

三、获取招聘详情

上面说了positionID 是为了获取详情页,详情页里面有要的任职要求。这个要获取就相对容易了,不过文本的处理并没有很简单,我只能通过“要求”这两个字获取任职要求(虽然有的为任职技能啥的,就这样进行取舍了)。

'''

@author: Max_Lyu

Create time: 2019/4/1

url: https://github.com/MaxLyu/Lagou_Analyze

'''

def get_url():

urls = []

with open("analyst.csv", 'r', newline='') as file:

# 读取文件

reader = csv.reader(file)

for row in reader:

# 根据 positionID 补全 url

if row[0] != "ID":

url = "https://www.lagou.com/jobs/{}.html".format(row[0])

urls.append(url) file.close()

return urls # 获取详细信息

def get_info():

urls = get_url()

length = len(urls)

for url in urls:

print(url)

description = ''

print(length)

response = requests.get(url, headers=headers)

response.encoding = 'utf-8'

content = etree.HTML(response.text)

detail = content.xpath('//*[@id="job_detail"]/dd[2]/div/p/text()')

print(detail) for i in range(1, len(detail)): if '要求' in detail[i-1]:

for j in range(i, len(detail)):

detail[j] = detail[j].replace('\xa0', '')

detail[j] = re.sub('[、;;.0-9。]', '', detail[j])

description = description + detail[j] + '/'

print(description)

write_file(description)

length -= 1

time.sleep(3)

四、成果与展示

到这里,爬取的任务就结束了,源码地址:https://github.com/MaxLyu/Lagou_Analyze 。获得数据之后就是小小地分析一下了,这个下次再总结。

Python3获取拉勾网招聘信息的更多相关文章

- 爬取拉勾网招聘信息并使用xlwt存入Excel

xlwt 1.3.0 xlwt 文档 xlrd 1.1.0 python操作excel之xlrd 1.Python模块介绍 - xlwt ,什么是xlwt? Python语言中,写入Excel文件的扩 ...

- 使用Spark分析拉勾网招聘信息(一):准备工作

本系列专属github地址:https://github.com/ios122/spark_lagou 前言 我觉得如果动笔,就应该努力地把要说的东西表达清楚.今后一段时间,尝试下系列博客文章.简单说 ...

- 使用Spark分析拉勾网招聘信息(二): 获取数据

要获取什么样的数据? 我们要获取的数据,是指那些公开的,可以轻易地获取地数据.如果你有完整的数据集,肯定是极好的,但一般都很难通过还算正当的方式轻易获取.单就本系列文章要研究的实时招聘信息来讲,能获取 ...

- 使用Spark分析拉勾网招聘信息(四): 几个常用的脚本与图片分析结果

概述 前一篇文章,已经介绍了BMR的基础用法,再结合Spark和Scala的文档,我想应该是可以开始你的数据分析之路的.这一篇文章,着重进行一些简单的思路上的引导和分析.如果你分析招聘数据时,卡在了某 ...

- Python3获取大量电影信息:调用API

实验室这段时间要采集电影的信息,给出了一个很大的数据集,数据集包含了4000多个电影名,需要我写一个爬虫来爬取电影名对应的电影信息. 其实在实际运作中,根本就不需要爬虫,只需要一点简单的Python基 ...

- python-scrapy爬虫框架爬取拉勾网招聘信息

本文实例为爬取拉勾网上的python相关的职位信息, 这些信息在职位详情页上, 如职位名, 薪资, 公司名等等. 分析思路 分析查询结果页 在拉勾网搜索框中搜索'python'关键字, 在浏览器地址栏 ...

- python3获取网页天气预报信息并打印

查到一个可以提供区域天气预报的url, https://www.sojson.com/open/api/weather/json.shtml?city=%E6%88%90%E9%83%BD打算用pyt ...

- 使用Spark分析拉勾网招聘信息(三): BMR 入门

简述 本文,意在以最小的篇幅,来帮助对大数据和Spark感兴趣的小伙伴,能尽快搭建一个可用的Spark开发环境.力求言简意赅.文章,不敢自称BMR的最佳实践,但绝对可以帮助初学者,迅速入门,能够专心于 ...

- Python爬取拉勾网招聘信息并写入Excel

这个是我想爬取的链接:http://www.lagou.com/zhaopin/Python/?labelWords=label 页面显示如下: 在Chrome浏览器中审查元素,找到对应的链接: 然后 ...

随机推荐

- go语言的条件语句和循环语句

一,条件语句 常见的就是if语句: 单支条件语句: if 条件 :执行语句 (注,如果是没有逻辑运算符连接的话,是可以不需要括号的,也可以加上括号,如:if (条件):执行语句) 双支 ...

- Dev gridcontrol 添加多列按钮

gridcontrol中添加按钮的步骤: 1. 把列的ColumnEdit属性设置为RepositoryItemButtonEdit 2. 把TextEditStyle属性设置为HideTextEdi ...

- HDU 6382 odds (暴力 + 剪枝优化)

odds Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 131072/131072 K (Java/Others)Total Subm ...

- 2019/3/1 IO流的学习总结

Java学习之IO流 学习Io流之前,我们先了解文件,以及在Java中对文件的操作.首先对文件进行操作,就必须用 File F = new File(“d:\\文件名”); 表示该文件或文件夹的地址寻 ...

- linux之Ubuntu学习

开始学习Linux系统是在通过虚拟机VMware上安装Ubuntu操作系统来学习的. 一.Ubuntu安装及使用 第一步:安装虚拟机VMware 第二步:虚拟机安装好之后,创建一个新的虚拟机,安装Ub ...

- Java中main方法参数String[ ] args的使用。

我们刚开始学习java时都会被要求记住主方法(main)的写法,就像这样: public static void main(String[] args){ } public static void m ...

- Linux下Oracle表空间及用户创建

记录详细过程以备使用 Connected to Oracle Database 11g Enterprise Edition Release 11.2.0.1.0 Connected as sys@i ...

- Tmux会话的使用

不想看废话的直接拖到下面看干货部分! 我们管理Linux服务器通常是通过ssh远程连接过去,如果在服务器上执行比较耗时的操作,比如下载安装软件.编译等等,如果需要数个小时来完成这些工作,但是又不得不关 ...

- 使用bat脚本部署hexo到coding和github

因项目的不同适当的改造吧,本文以hexo为例. 拉取coding.net的代码和github的代码到本地 确保代码能够正常的运行,commit,push 在项目的目录外新建一个push.bat文件 快 ...

- Javascript高级编程学习笔记(52)—— DOM2和DOM3(4)元素大小

在日常实践中,我们在使用JS的时候难免会需要获取元素的大小及位置 首先要声明的是,这一部分的内容并不属于DOM2样式规范,因为DOM中并没有对我们如何获取元素大小的相关信息做出规范 偏移量 偏移量及元 ...