高可用OpenStack(Queen版)集群-9.Cinder控制节点集群

参考文档:

- Install-guide:https://docs.openstack.org/install-guide/

- OpenStack High Availability Guide:https://docs.openstack.org/ha-guide/index.html

- 理解Pacemaker:http://www.cnblogs.com/sammyliu/p/5025362.html

十三.Cinder控制节点集群

1. 创建cinder数据库

# 在任意控制节点创建数据库,后台数据自动同步,以controller01节点为例;

[root@controller01 ~]# mysql -uroot -pmysql_pass MariaDB [(none)]> CREATE DATABASE cinder;

MariaDB [(none)]> GRANT ALL PRIVILEGES ON cinder.* TO 'cinder'@'localhost' IDENTIFIED BY 'cinder_dbpass';

MariaDB [(none)]> GRANT ALL PRIVILEGES ON cinder.* TO 'cinder'@'%' IDENTIFIED BY 'cinder_dbpass'; MariaDB [(none)]> flush privileges;

MariaDB [(none)]> exit;

2. 创建cinder-api

# 在任意控制节点操作,以controller01节点为例;

# 调用cinder服务需要认证信息,加载环境变量脚本即可

[root@controller01 ~]# . admin-openrc

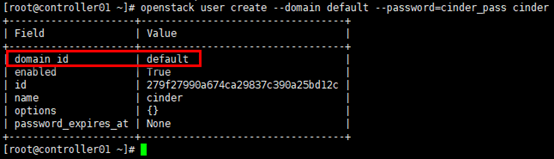

1)创建cinder用户

# service项目已在glance章节创建;

# neutron用户在”default” domain中

[root@controller01 ~]# openstack user create --domain default --password=cinder_pass cinder

2)cinder赋权

# 为cinder用户赋予admin权限

[root@controller01 ~]# openstack role add --project service --user cinder admin

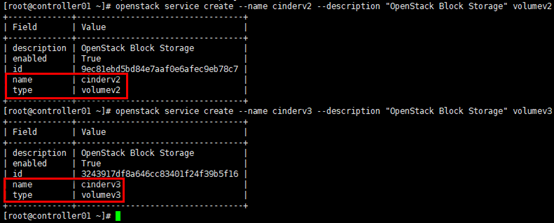

3)创建cinder服务实体

# cinder服务实体类型”volume”;

# 创建v2/v3两个服务实体

[root@controller01 ~]# openstack service create --name cinderv2 --description "OpenStack Block Storage" volumev2

[root@controller01 ~]# openstack service create --name cinderv3 --description "OpenStack Block Storage" volumev3

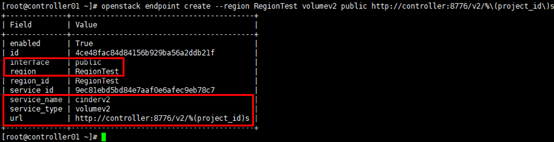

4)创建cinder-api

# 注意--region与初始化admin用户时生成的region一致;

# api地址统一采用vip,如果public/internal/admin分别使用不同的vip,请注意区分;

# cinder-api 服务类型为volume;

# cinder-api后缀为用户project-id,可通过”openstack project list”查看

# v2 public api

[root@controller01 ~]# openstack endpoint create --region RegionTest volumev2 public http://controller:8776/v2/%\(project_id\)s

# v2 internal api

[root@controller01 ~]# openstack endpoint create --region RegionTest volumev2 internal http://controller:8776/v2/%\(project_id\)s

# v2 admin api

[root@controller01 ~]# openstack endpoint create --region RegionTest volumev2 admin http://controller:8776/v2/%\(project_id\)s

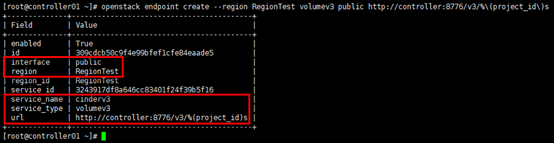

# v3 public api

[root@controller01 ~]# openstack endpoint create --region RegionTest volumev3 public http://controller:8776/v3/%\(project_id\)s

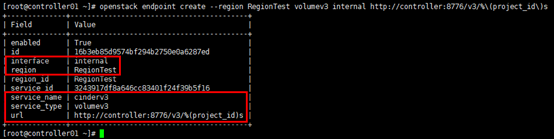

# v3 internal api

[root@controller01 ~]# openstack endpoint create --region RegionTest volumev3 internal http://controller:8776/v3/%\(project_id\)s

# v3 admin api

[root@controller01 ~]# openstack endpoint create --region RegionTest volumev3 admin http://controller:8776/v3/%\(project_id\)s

3. 安装cinder

# 在全部控制节点安装cinder服务,以controller01节点为例

[root@controller01 ~]# yum install openstack-cinder -y

4. 配置cinder.conf

# 在全部控制节点操作,以controller01节点为例;

# 注意”my_ip”参数,根据节点修改;

# 注意cinder.conf文件的权限:root:cinder

[root@controller01 ~]# cp /etc/cinder/cinder.conf /etc/cinder/cinder.conf.bak

[root@controller01 ~]# egrep -v "^$|^#" /etc/cinder/cinder.conf

[DEFAULT]

state_path = /var/lib/cinder

my_ip = 172.30.200.31

glance_api_servers = http://controller:9292

auth_strategy = keystone

osapi_volume_listen = $my_ip

osapi_volume_listen_port = 8776

log_dir = /var/log/cinder

# 前端采用haproxy时,服务连接rabbitmq会出现连接超时重连的情况,可通过各服务与rabbitmq的日志查看;

# transport_url = rabbit://openstack:rabbitmq_pass@controller:5673

# rabbitmq本身具备集群机制,官方文档建议直接连接rabbitmq集群;但采用此方式时服务启动有时会报错,原因不明;如果没有此现象,强烈建议连接rabbitmq直接对接集群而非通过前端haproxy

transport_url=rabbit://openstack:rabbitmq_pass@controller01:5672,controller02:5672,controller03:5672

[backend]

[backend_defaults]

[barbican]

[brcd_fabric_example]

[cisco_fabric_example]

[coordination]

[cors]

[database]

connection = mysql+pymysql://cinder:cinder_dbpass@controller/cinder

[fc-zone-manager]

[healthcheck]

[key_manager]

[keystone_authtoken]

www_authenticate_uri = http://controller:5000

auth_url = http://controller:35357

memcached_servers = controller01:11211,controller02:11211,controller03:11211

auth_type = password

project_domain_id = default

user_domain_id = default

project_name = service

username = cinder

password = cinder_pass

[matchmaker_redis]

[nova]

[oslo_concurrency]

lock_path = $state_path/tmp

[oslo_messaging_amqp]

[oslo_messaging_kafka]

[oslo_messaging_notifications]

[oslo_messaging_rabbit]

[oslo_messaging_zmq]

[oslo_middleware]

[oslo_policy]

[oslo_reports]

[oslo_versionedobjects]

[profiler]

[service_user]

[ssl]

[vault]

5. 配置nova.conf

# 在全部控制节点操作,以controller01节点为例;

# 配置只涉及nova.conf的”[cinder]”字段;

# 加入对应regiong

[root@controller01 ~]# vim /etc/nova/nova.conf

[cinder]

os_region_name=RegionTest

6. 同步cinder数据库

# 任意控制节点操作;

# 忽略部分”deprecation”信息

[root@controller01 ~]# su -s /bin/sh -c "cinder-manage db sync" cinder # 验证

[root@controller01 ~]# mysql -h controller -ucinder -pcinder_dbpass -e "use cinder;show tables;"

7. 启动服务

# 全部控制节点操作;

# 变更nova配置文件,首先需要重启nova服务

[root@controller01 ~]# systemctl restart openstack-nova-api.service # 开机启动

[root@controller01 ~]# systemctl enable openstack-cinder-api.service openstack-cinder-scheduler.service # 启动

[root@controller01 ~]# systemctl restart openstack-cinder-api.service

[root@controller01 ~]# systemctl restart openstack-cinder-scheduler.service

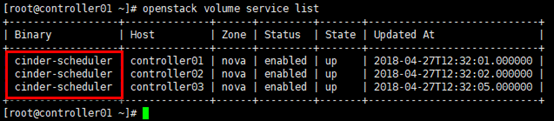

8. 验证

[root@controller01 ~]# . admin-openrc # 查看agent服务;

# 或:cinder service-list

[root@controller01 ~]# openstack volume service list

9. 设置pcs资源

# 在任意控制节点操作;

# 添加资源cinder-api与cinder-scheduler

[root@controller01 ~]# pcs resource create openstack-cinder-api systemd:openstack-cinder-api --clone interleave=true

[root@controller01 ~]# pcs resource create openstack-cinder-scheduler systemd:openstack-cinder-scheduler --clone interleave=true # cinder-api与cinder-scheduler以active/active模式运行;

# openstack-nova-volume以active/passive模式运行 # 查看资源

[root@controller01 ~]# pcs resource

高可用OpenStack(Queen版)集群-9.Cinder控制节点集群的更多相关文章

- cinder控制节点集群

#cinder控制节点集群 openstack pike 部署 目录汇总 http://www.cnblogs.com/elvi/p/7613861.html #cinder块存储控制节点.txt.s ...

- 高可用OpenStack(Queen版)集群-6.Nova控制节点集群

参考文档: Install-guide:https://docs.openstack.org/install-guide/ OpenStack High Availability Guide:http ...

- Nova控制节点集群

#Nova控制节点集群 openstack pike 部署 目录汇总 http://www.cnblogs.com/elvi/p/7613861.html ##Nova控制节点集群 # control ...

- Neutron控制节点集群

#Neutron控制节点集群 openstack pike 部署 目录汇总 http://www.cnblogs.com/elvi/p/7613861.html #.Neutron控制节点集群 #本实 ...

- 高可用OpenStack(Queen版)集群-3.高可用配置(pacemaker&haproxy)

参考文档: Install-guide:https://docs.openstack.org/install-guide/ OpenStack High Availability Guide:http ...

- openstack高可用集群21-生产环境高可用openstack集群部署记录

第一篇 集群概述 keepalived + haproxy +Rabbitmq集群+MariaDB Galera高可用集群 部署openstack时使用单个控制节点是非常危险的,这样就意味着单个节 ...

- Corosync+Pacemaker+DRBD+MySQL 实现高可用(HA)的MySQL集群

大纲一.前言二.环境准备三.Corosync 安装与配置四.Pacemaker 安装与配置五.DRBD 安装与配置六.MySQL 安装与配置七.crmsh 资源管理 推荐阅读: Linux 高可用(H ...

- 高可用,完全分布式Hadoop集群HDFS和MapReduce安装配置指南

原文:http://my.oschina.net/wstone/blog/365010#OSC_h3_13 (WJW)高可用,完全分布式Hadoop集群HDFS和MapReduce安装配置指南 [X] ...

- 用Kolla在阿里云部署10节点高可用OpenStack

为展现 Kolla 的真正实力,我在阿里云使用 Ansible 自动创建 10 台虚机,部署一套多节点高可用 OpenStack 集群! 前言 上次 Kolla 已经表示了要打 10 个的愿望,这次我 ...

随机推荐

- 1055. [HAOI2008]玩具取名【区间DP】

Description 某人有一套玩具,并想法给玩具命名.首先他选择WING四个字母中的任意一个字母作为玩具的基本名字.然后 他会根据自己的喜好,将名字中任意一个字母用“WING”中任意两个字母代替, ...

- Dictionary<string, object>

Dictionary<string, object> dcic = JsonHelper.DataRowFromJSON(resultdepth); foreach (var depthk ...

- REST接口设计规范总结

简介 Representational State Transfer 简称 REST 描述了一个架构样式的网络系统.REST 指的是一组架构约束条件和原则.满足这些约束条件和原则的应用程序或设计就是 ...

- Service通信

1.简介 Service通信是双向的, 它不仅可以发送消息, 同时还会有反馈. 所以service包括两部分, 一部分是请求方( Clinet) , 另一部分是应答方/服务提供方( Server) . ...

- Jmeter不同线程组之间的变量引用

用过LoadRunner的小伙伴应该知道,它的脚本主要分为三个部分,即Login,Action,End三个模块.Login中一般是“初始化”环境所用,而Action模块主要做一些诸如压测的动作.举个例 ...

- GitHub 源码,Framework 框架

https://github.com/CoderLN/Apple-GitHub-Codeidea Apple 译文.GitHub 源码,随原作者 (大版本) 迭代注解.--- 不知名开发者 https ...

- Windows下修改iTunes备份路径

0.准备工作: 关闭itunes 在任务管理器中杀掉iTunes开头的服务 1,找到iTunes默认备份路径:C:\Users\xxx\AppData\Roaming\Apple Computer\M ...

- Vue脚手架搭建步骤

Vue脚手架的搭建步骤 1. 去node.js官网下载node.js并安装,如下图: 2. 找到下载的文件并点击安装: 一直到finish完成.安装成功 3. 通过DOS密令打开: 输入: ...

- iOS swift项目IM实现,从长连接到数据流解析分析之Socket

iOS swift项目IM实现,从长连接到底层数据解析分析之Socket 一:项目简介: 去年开始接手了一个国企移动项目,项目的需求是实现IM即时通讯功能. * 一期版本功能包括了: ...

- 读取和修改app.config文件

本处主要是指读取和修改appSettings节点: 读取: string port = ConfigurationManager.AppSettings["port"]; //p ...