airflow(二)集成EMR使用

1. 准备工作

1.1. 安装并初始化airflow,参考以下文档:

https://www.cnblogs.com/zackstang/p/11082322.html

其中还要额外安装的是:

sudo pip-3.6 install -i https://pypi.tuna.tsinghua.edu.cn/simple 'apache-airflow[celery]'

sudo pip-3.6 install -i https://pypi.tuna.tsinghua.edu.cn/simple boto3

1.2. 配置好本地AWS Credentials,此credential需有启动EMR 的权限。

1.3. 置数据库为外部数据库:

编辑 airflow.cfg 文件,修改数据库连接配置(需提前在数据库中创建好airflowdb 的数据库):

sql_alchemy_conn = mysql://user:password@database_location/airflowdb

使用下面的命令检查并初始化:

airflow initdb

1.4. 配置executor 为 CeleryExecutor

编辑airflow.cfg 文件,修改executor配置:

executor = CeleryExecutor

修改后可以保证相互无依赖的任务可以并行执行。默认为SequentialExecutor,也就是按顺序执行。

1.5 配置broker_url 与 result_backend

airflow.cfg 文件中修改以下两个条目:

broker_url = sqla+mysql:// user:password@database_location:3306/airflowdb

result_backend = db+mysql:// user:password@database_location:3306/airflowdb

配置完后启动airflow 的web ui,worker,flower以及scheduler:

airflow webserver -p 8080 &

airflow worker &

airflow flower &

airflow scheduler &

2. 定义工作流

创建dag_trasform.py 文件,在文件中定义工作流:

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

from datetime import datetime, timedelta

from airflow.sensors.external_task_sensor import ExternalTaskSensor default_args = {

'owner': 'Airflow',

'depends_on_past': False,

'start_date': datetime.now().replace(microsecond=0),

'email': [‘xxxxxx@qq.com'],

'email_on_failure': False,

'email_on_retry': False,

'retries': 0,

'retry_delay': timedelta(minutes=5),

# 'queue': 'bash_queue',

# 'pool': 'backfill',

# 'priority_weight': 10,

# 'end_date': datetime(2016, 1, 1),

} dag = DAG('dag_transform', default_args=default_args,

schedule_interval=timedelta(days=1)) # create emr cluster

t0 = BashOperator(

task_id='create_emr_cluster',

bash_command='python3 /home/hadoop/scripts/launch_emr.py',

dag=dag) # do wordcount

t1 = BashOperator(

task_id='spark_job',

bash_command='python3 /home/hadoop/scripts/submit_spark_job.py',

dag=dag) # check result in s3

t2 = BashOperator(

task_id='check_s3',

bash_command='python3 /home/hadoop/scripts/check_s3_result.py',

dag=dag) # hive query

t3 = BashOperator(

task_id='query',

bash_command='python3 /home/hadoop/scripts/query_result.py',

dag=dag) # terminate cluster

t4 = BashOperator(

task_id='terminate_cluster',

bash_command='python3 /home/hadoop/scripts/terminate_cluster.py',

dag=dag) # define airflow DAG

t0 >> t1

t1 >> t2

t2 >> t3

t3 >> t4

其中各个BashOperator中的脚本需自行实现,根据需求实现即可。

3. 重制Airflow数据库

将 dag_transform.py 文件放入 airflow/dags/ 下,然后重置 airflow 数据库:airflow resetdb

4. 运行

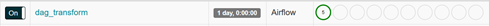

在airflow里手动执行这个DAG,可以看到这个DAG已经开始运行:

查看 dag_transform 可以看到已经在运行启动emr的脚本了:

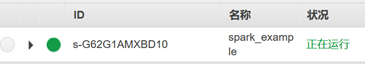

[[2020-03-12 12:42:54,197] {bash_operator.py:105} INFO - Temporary script location: /tmp/airflowtmptwdg7a_6/create_emr_clusterlbzuu36e[2020-03-12 12:42:54,197] {bash_operator.py:115} INFO - Running command: python3 /home/hadoop/scripts/launch_emr.py可以看到 EMR 集群正在启动:

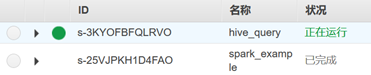

t1 spark wordcount 开始执行:

t2 完成后,t3 hive query 开始执行:

最后,整个DAG执行完毕:

我们也可以看到EMR集群开始自动终止:

参考文档:

airflow(二)集成EMR使用的更多相关文章

- Asp.NetCoreWebApi图片上传接口(二)集成IdentityServer4授权访问(附源码)

写在前面 本文地址:http://www.cnblogs.com/yilezhu/p/9315644.html 作者:yilezhu 上一篇关于Asp.Net Core Web Api图片上传的文章使 ...

- Springboot整合二 集成 rabbitmq

1.在application.yml文件中进行RabbitMQ的相关配置先上代码 spring: rabbitmq: host: 192168.21.11 port: username: guest ...

- Apache CXF实战之二 集成Sping与Web容器

本文链接:http://blog.csdn.net/kongxx/article/details/7525481 Apache CXF实战之一 Hello World Web Service 书接上文 ...

- Spring boot后台搭建二集成Shiro实现用户验证

上一篇文章中介绍了Shiro 查看 将Shiro集成到spring boot的步骤: (1)定义一个ShiroConfig,配置SecurityManager Bean,SecurityManager ...

- SpringBoot进阶教程(二十二)集成RabbitMQ---MQ实战演练

RabbitMQ是一个在AMQP基础上完成的,可复用的企业消息系统.他遵循Mozilla Public License开源协议.RabbitMQ是流行的开源消息队列系统,用erlang语言开发.Rab ...

- Spring boot后台搭建二集成Shiro权限控制

上一篇文章,实现了用户验证 查看,接下来实现下权限控制 权限控制,是管理资源访问的过程,用于对用户进行的操作授权,证明该用户是否允许进行当前操作,如访问某个链接,某个资源文件等 Apache Shir ...

- Spring boot后台搭建二集成Shiro添加Remember Me

上一片文章实现了用户验证 查看 当用户成功登录后,关闭浏览器,重新打开浏览器访问http://localhost:8080,页面会跳转到登录页,因为浏览器的关闭后之前的登录已失效 Shiro提供了R ...

- iOS开发之集成iOS9中的Core Spotlight Framework搜索App的内容

Spotlight在iOS9上做了一些新的改进, 也就是开放了一些新的API, 通过Core Spotlight Framework你可以在你的app中集成Spotlight.集成Spotlight的 ...

- Spring+Struts集成(第二种方案)

在上一篇文章中我们了解到了第一种Spring跟Struts集成的方案,但此集成方案的不足是WEB层中知道Spring的相关内容,因为需要去主动的查找对象:BeanFactory.方案二便是通过依赖注入 ...

- iOS支付宝,微信,银联支付集成封装(上)

一.集成支付宝支付 支付宝集成官方教程https://docs.open.alipay.com/204/105295/ 支付宝集成官方demo https://docs.open.alipay.com ...

随机推荐

- Git实战技巧:恢复被强制push -f失踪的代码

前言 Git是一个易学难精的分布式版本控制系统,被我们码农常用于代码的管理.如果你还不了解Git,建议先通过廖雪峰的Git教程进行了解,再来看本文,因为本文以使用技巧为主,不会在基础名词上做过多解释. ...

- DB2查找最耗时SQL

两种方法:db2top和snapshot for dynamic sql 1. db2top -d <dbname>

- 开启 ssh 服务

开启 ssh 服务 vim /etc/ssh/sshd_config 重启 ssh 服务:/etc/init.d/ssh restart 设置服务自启动:update-rc.d ssh enable

- 鸿蒙HarmonyOS实战-ArkUI事件(单一手势)

一.单一手势 应用程序的手势操作是指在移动设备上使用手指或手势进行与应用程序交互的方式.手势操作可以包括点击.滑动.双击.捏合等动作,用于实现不同的功能和操作. HarmonyOS中常见的手势操作及其 ...

- java调用webservice接口

1.直接AXIS调用远程的webservice 注意:不同版本的Axis相差很大,大家最好以apache网站上的例子为准,这里仅仅用于说明其基本用法. import org.apache.axis.c ...

- Splashtop远程桌面再次增强:支持4K视频流

远程桌面工具,主流的有10款总有,国内用的比较多的有teamviewer.Splashtop.向日葵等.几款软件各有千秋,其中Splashtop最大的特性就是快速.流畅.产品无敌,运营佛系,哈哈.下面 ...

- 通过ref返回解决C# struct结构体链式调用的问题

通常结构体不能进行链式调用,因为返回值是一个新的值,需要赋回原值.但现在通过ref关键字配合扩展方法,也能进行链式调用了. 结构体: public struct Foo { public int a; ...

- IDEA社区版(IDEA Community Edition)创建Springboot父子项目

1. 因为社区办不支持使用spring Spring Initializr 的方式创建项目, 但是我们可以考虑使用别的方式达到效果: 创建方式有3种: 第一种:使用https://start.spri ...

- vulnhub靶场 --> Red: 1

靶机下载地址 Red: 1 << 点我 开始打靶 IP发现 nmap扫描网段发现靶机ip:192.168.111.142 端口发现 对靶机进行常规端口扫描 访问网站 到处点击发现存在一个可 ...

- 详解Spring循环依赖

一. 什么是循环依赖 循环依赖,就是两个或则两个以上的bean互相依赖对方,最终形成闭环.比如"A对象依赖B对象,而B对象也依赖A对象",或者"A对象依赖B对象,B对象依 ...