[Machine Learning] 逻辑回归 (Logistic Regression) -分类问题-逻辑回归-正则化

在之前的问题讨论中,研究的都是连续值,即y的输出是一个连续的值。但是在分类问题中,要预测的值是离散的值,就是预测的结果是否属于某一个类。例如:判断一封电子邮件是否是垃圾邮件;判断一次金融交易是否是欺诈;之前我们也谈到了肿瘤分类问题的例子,区别一个肿瘤是恶性的还是良性的。

我们先说二分类问题,我们将一些自变量分为负向类和正向类,那么因变量为0,1;0表示负向类,1表示正向类。

如果用线性回归来讨论分类问题,那么假设输出的结果会大于1,但是我们的假设函数的输出应该是在0,1之间。所以我们把输出结果在0,1之间的算法叫做逻辑回归算法。

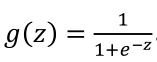

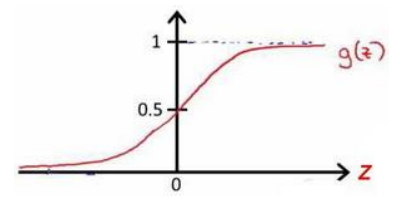

因为线性回归算法中,函数的输出肯定会大约1,所以我们定义了一个新的函数来作为分类问题的函数,我们用g代表逻辑函数,它通常是一个S形函数,公式为:

Python代码:

import numpy as np

def sigmoid(z):

return 1 / (1 + np.exp(-z))

函数图像为:

这样,无论自变量取值是多少,函数的输出值一直在0,1之间。

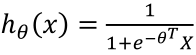

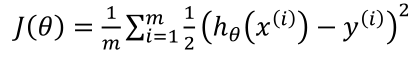

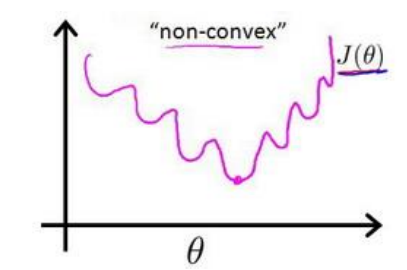

在线性回归模型中,我们定义的代价函数是所有模型误差的平方和。当在逻辑回归模型中,如果还延用这个定义,将 代入,我们得到是一个非凸函数

代入,我们得到是一个非凸函数 :

:

这意味着我们的代价函数有许多局部最小值,这将影响梯度下降算法寻找全局最小值。

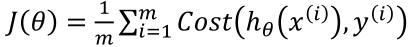

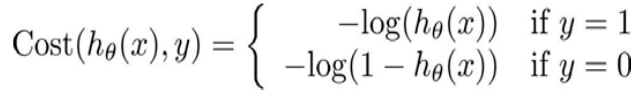

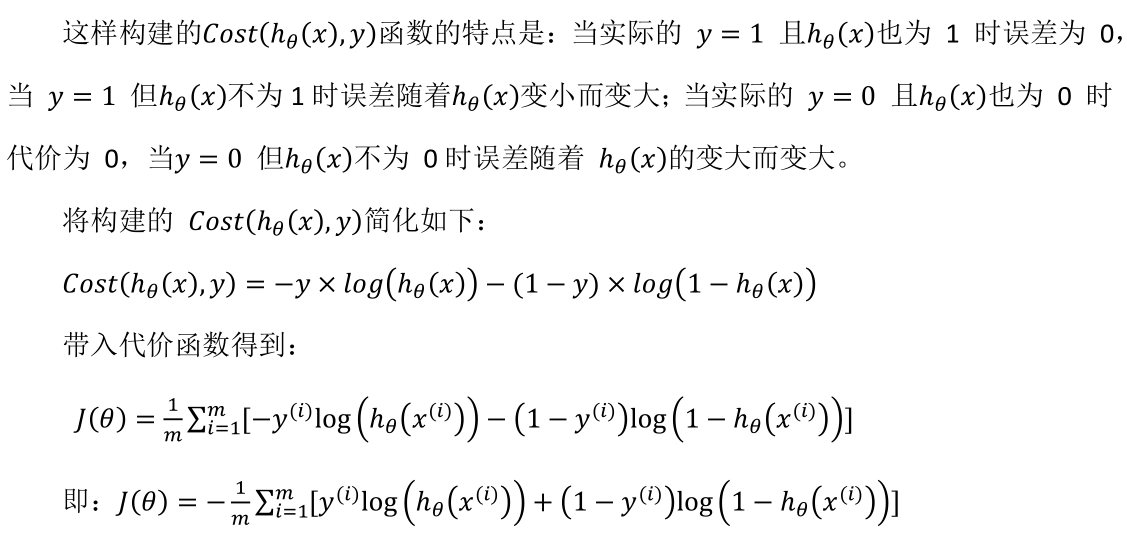

我们重新定义逻辑回归的代价函数为: ,其中

,其中  。

。

Python代码:

import numpy as np

def cost(theta, X, y):

theta = np.matrix(theta)

X = np.matrix(X)

y = np.matrix(y)

first = np.multiply(-y, np.log(sigmoid(X* theta.T)))

second = np.multiply((1 - y), np.log(1 - sigmoid(X* theta.T)))

return np.sum(first - second) / (len(X))

在多分类问题,我们遇到的问题是一对多。而相对于而分类来说,在多分类中,我们可以把相近的认为是一类,把一个多分类问题认为是多个二分类问题,从而实现多分类问题的解决方案。

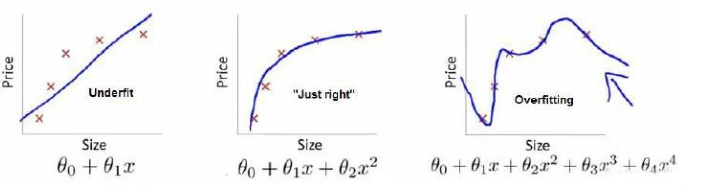

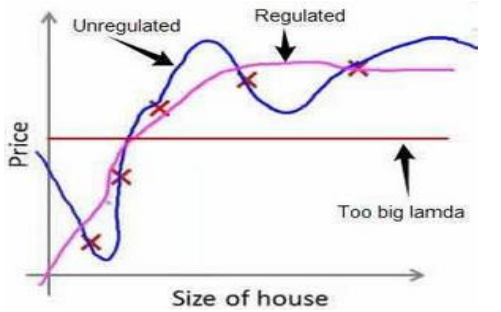

在回归问题中,还有一个过拟合的问题,如下图所示:

上图中,只有图二比较好,第一个图型是欠拟合,第三个是过拟合:过去强调拟合原始数据而丢失了算法的本质。

那么解决上述的问题有两个方法:

1.丢弃一些不能帮助我们正确预测的特征。可以是手工选择保留哪些特征,或者使用一些模型选择的算法来帮忙(例如 PCA)

2.正则化。 保留所有的特征,但是减少参数的大小(magnitude)。

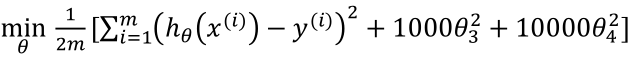

在回归问题中,出现过拟合的原因是因为高阶系数太大了,如果让高阶系数接近0的话就可以解决这个问题了。所以要做的就是在一定程度上减小这些参数的值,这就是正则化的基本方法。

对于一个代价函数,我们修改后的结果如下: 。

。

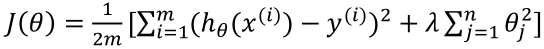

如果我们不知道哪些特征需要惩罚,我们将对所有的特征进行惩罚,并让代价函数最优软件来选择这些惩罚的程度。

其中的λ称为正则化参数,如果选择的正则化参数 λ 过大,则会把所有的参数都最小化了,导致模型变成 ℎ

[Machine Learning] 逻辑回归 (Logistic Regression) -分类问题-逻辑回归-正则化的更多相关文章

- [Machine Learning]学习笔记-Logistic Regression

[Machine Learning]学习笔记-Logistic Regression 模型-二分类任务 Logistic regression,亦称logtic regression,翻译为" ...

- 机器学习---朴素贝叶斯与逻辑回归的区别(Machine Learning Naive Bayes Logistic Regression Difference)

朴素贝叶斯与逻辑回归的区别: 朴素贝叶斯 逻辑回归 生成模型(Generative model) 判别模型(Discriminative model) 对特征x和目标y的联合分布P(x,y)建模,使用 ...

- Andrew Ng Machine Learning 专题【Logistic Regression & Regularization】

此文是斯坦福大学,机器学习界 superstar - Andrew Ng 所开设的 Coursera 课程:Machine Learning 的课程笔记. 力求简洁,仅代表本人观点,不足之处希望大家探 ...

- CheeseZH: Stanford University: Machine Learning Ex3: Multiclass Logistic Regression and Neural Network Prediction

Handwritten digits recognition (0-9) Multi-class Logistic Regression 1. Vectorizing Logistic Regress ...

- machine learning(10) -- classification:logistic regression cost function 和 使用 gradient descent to minimize cost function

logistic regression cost function(single example) 图像分布 logistic regression cost function(m examples) ...

- Machine Learning in Action -- Logistic regression

这个系列,重点关注如何实现,至于算法基础,参考Andrew的公开课 相较于线性回归,logistic回归更适合用于分类 因为他使用Sigmoid函数,因为分类的取值是0,1 对于分类,最完美和自然的函 ...

- Machine Learning No.3: Logistic Regression

1. Decision boundary when hθ(x) > 0, g(z) = 1; when hθ(x) < 0, g(z) = 0. so the hyppthesis is: ...

- 逻辑回归(Logistic Regression)详解,公式推导及代码实现

逻辑回归(Logistic Regression) 什么是逻辑回归: 逻辑回归(Logistic Regression)是一种基于概率的模式识别算法,虽然名字中带"回归",但实际上 ...

- 机器学习 (三) 逻辑回归 Logistic Regression

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang 的个人 ...

随机推荐

- JZOJ2020年8月7日提高组反思

JZOJ2020年8月7日提高组反思 T1 暴力枚举 枚举起点和\(p\) 然后就 过了?! 根据本人不严谨的推算 时间复杂度\(O(\dfrac{n^7}{4})\) 数据太水就过去了QAQ T2 ...

- 小白也能看懂的mySQL进阶【单表查询】

目录 1.查询基础 SELECT语句基础 列的查询 为列设定别名 常数的查询 过滤表中重复数据 根据WHERE语句来选择记录 注释的书写方法 算术运算符和比较运算符 算术运算符 需要注意NULL 比较 ...

- 使用Jmeter测试快速入门

一 创建线程组 1.1.2. 线程组主要包含三个参数:线程数.准备时长(Ramp-Up Period(in seconds)).循环次数. 1.1.3. 线程数:虚拟用户数.一个虚拟用户占用 ...

- Fiddler 4 断点调试(修改request请求参数)

1.选中要测试的链接 2然后点击规则的Automatic Breakpoints 的Before Requests 3.重新发送请求找到测试的点链接 最终效果如下

- 微软面试题: LeetCode 151. 翻转字符串里的单词 出现次数:6

题目描述: 给定一个字符串,逐个翻转字符串中的每个单词. 说明: 无空格字符构成一个 单词 .输入字符串可以在前面或者后面包含多余的空格,但是反转后的字符不能包括.如果两个单词间有多余的空格,将反转后 ...

- 第8.25节 Python风格的__getattribute__属性访问方法语法释义及使用

一. 引言 在<第8.13节 Python类中内置方法__repr__详解>老猿介绍了在命令行方式直接输入"对象"就可以调用repr内置函数或__repr__方法查看对 ...

- 【系统设计】WMS系统中 库存、盘点、移库、拆库功能的设计(库内管理)

最近负责WMS系统 盘点 移库 两个功能模块的功能及数据库设计. 物流仓储系统的搭建,要基于仓库的实际情况,整理内部员工需求,再参考其他WMS系统,经过长时间的讨论和研究,最终转化为产品需求. 这里先 ...

- 堆叠注入tips

漏洞成因 使用mysqli_multi_query()这种支持多语句执行的函数 使用PDO的方式进行数据查询,创建PDO实例时PDO::MYSQL_ATTR_MULTI_STATEMENTS设置为tr ...

- flask中的return、过滤器详解

之前吧一直学习flask的时候,一直不明白response是怎么产生,今天是明白了.retrun 哎呀,这个地方看着挺小心的东西, 蕴含的能量可不小啊.今天我详细总结总结. 先来写jinjia2语法 ...

- vulnstack靶机实战01

前言 vulnstack是红日安全的一个实战环境,地址:http://vulnstack.qiyuanxuetang.net/vuln/detail/2/最近在学习内网渗透方面的相关知识,通过对靶机的 ...