一、使用 BeautifulSoup抓取网页信息信息

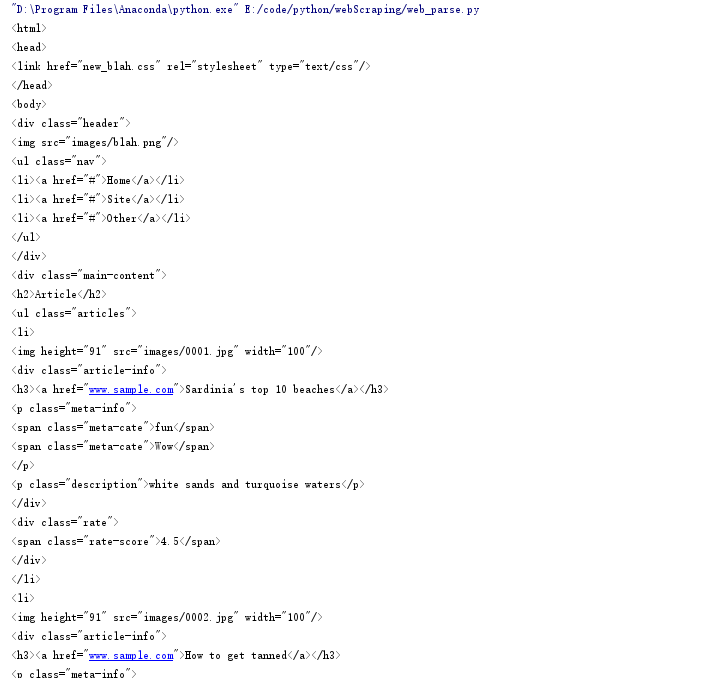

一、解析网页信息

from bs4 import BeautifulSoup

with open('C:/Users/michael/Desktop/Plan-for-combating-master/week1/1_2/1_2code_of_video/web/new_index.html','r') as web_data:

Soup = BeautifulSoup(web_data,'lxml')

print(Soup)

二、获取要爬取元素的位置

浏览器右键-》审查元素-》copy-》seletor

"""

body > div.main-content > ul > li:nth-child(1) > div.article-info > h3 > a

body > div.main-content > ul > li:nth-child(1) > div.article-info > p.meta-info > span:nth-child(2)

body > div.main-content > ul > li:nth-child(1) > div.article-info > p.description

body > div.main-content > ul > li:nth-child(1) > div.rate > span

body > div.main-content > ul > li:nth-child(1) > img

"""

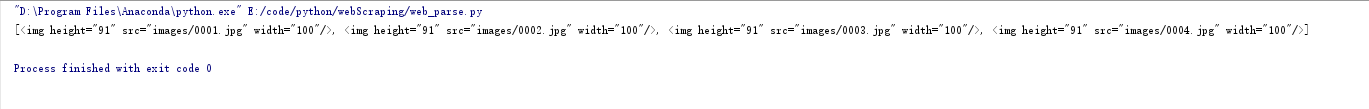

images = Soup.select('body > div.main-content > ul > li:nth-child(1) > img')

print(images)

修改成:

images = Soup.select('body > div.main-content > ul > li:nth-of-type(1) > img')

print(images)

这时候能获取到一个

images = Soup.select('body > div.main-content > ul > li > img')

print(images)

获取到了所有图片

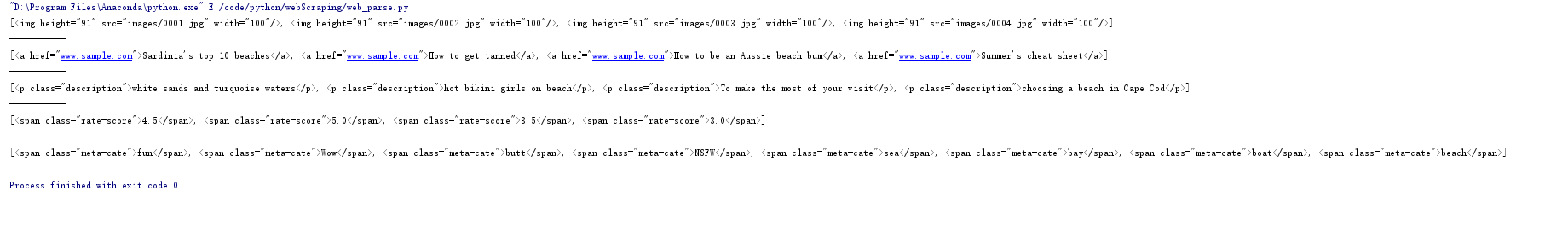

titles = Soup.select('body > div.main-content > ul > li > div.article-info > h3 > a')

descs = Soup.select('body > div.main-content > ul > li > div.article-info > p.description')

rates = Soup.select(' body > div.main-content > ul > li > div.rate > span')

cates = Soup.select(' body > div.main-content > ul > li > div.article-info > p.meta-info > span')

print(images,titles,descs,rates,cates,sep='\n-----------\n')

获取到了其他信息

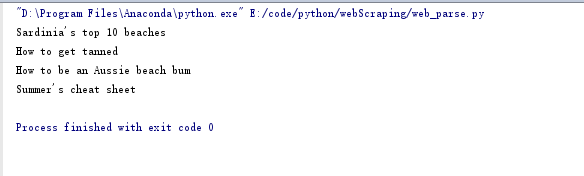

三、获取标签中的文本信息(get_text())及属性(get())

for title in titles:

print(title.get_text())

封装成字典:

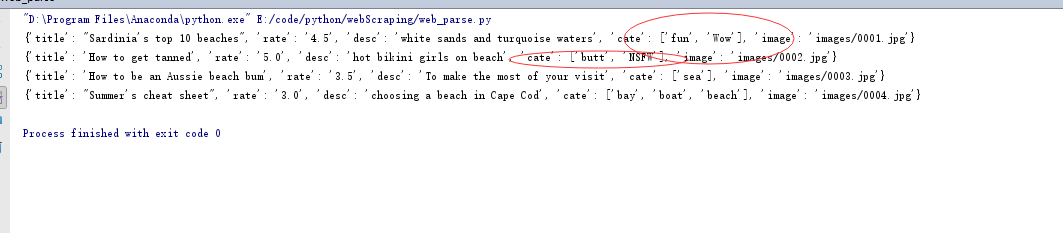

for title,image,desc,rate,cate in zip(titles,images,descs,rates,cates):

data = {

'title':title.get_text(),

'rate':rate.get_text(),

'desc':desc.get_text(),

'cate':cate.get_text(),

'image':image.get('src')

}

print(data)

因为cates有多个属性,需要上升到父节点

cates = Soup.select(' body > div.main-content > ul > li > div.article-info > p.meta-info')

for title,image,desc,rate,cate in zip(titles,images,descs,rates,cates):

data = {

'title':title.get_text(),

'rate':rate.get_text(),

'desc':desc.get_text(),

'cate':list(cate.stripped_strings),

'image':image.get('src')

}

print(data)

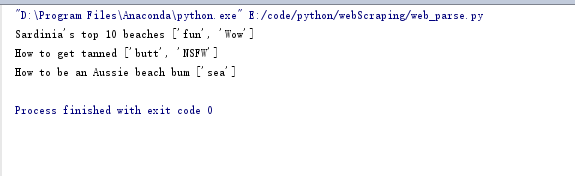

#找到评分大于3的文章

for i in info:

if float(i['rate'])>3:

print(i['title'],i['cate'])

四、完整代码

from bs4 import BeautifulSoup

info =[]

with open('C:/Users/michael/Desktop/Plan-for-combating-master/week1/1_2/1_2code_of_video/web/new_index.html','r') as web_data:

Soup = BeautifulSoup(web_data,'lxml')

# print(Soup)

"""

body > div.main-content > ul > li:nth-child(1) > div.article-info > h3 > a

body > div.main-content > ul > li:nth-child(1) > div.article-info > p.meta-info > span:nth-child(2)

body > div.main-content > ul > li:nth-child(1) > div.article-info > p.description

body > div.main-content > ul > li:nth-child(1) > div.rate > span

body > div.main-content > ul > li:nth-child(1) > img

"""

images = Soup.select('body > div.main-content > ul > li > img') titles = Soup.select('body > div.main-content > ul > li > div.article-info > h3 > a')

descs = Soup.select('body > div.main-content > ul > li > div.article-info > p.description')

rates = Soup.select(' body > div.main-content > ul > li > div.rate > span')

cates = Soup.select(' body > div.main-content > ul > li > div.article-info > p.meta-info')

# print(images,titles,descs,rates,cates,sep='\n-----------\n') for title,image,desc,rate,cate in zip(titles,images,descs,rates,cates):

data = {

'title':title.get_text(),

'rate':rate.get_text(),

'desc':desc.get_text(),

'cate':list(cate.stripped_strings),

'image':image.get('src')

}

#添加到列表中

info.append(data)

#找到评分大于3的文章

for i in info:

if float(i['rate'])>3:

print(i['title'],i['cate'])

一、使用 BeautifulSoup抓取网页信息信息的更多相关文章

- Python 抓取网页并提取信息(程序详解)

最近因项目需要用到python处理网页,因此学习相关知识.下面程序使用python抓取网页并提取信息,具体内容如下: #---------------------------------------- ...

- HttpClient+Jsoup 抓取网页信息(网易贵金属为例)

废话不多说直接讲讲今天要做的事. 利用HttpClient和Jsoup技术抓取网页信息.HttpClient是支持HTTP协议的客户端编程工具包,并且它支持HTTP协议. jsoup 是一款基于 Ja ...

- python爬虫抓取哈尔滨天气信息(静态爬虫)

python 爬虫 爬取哈尔滨天气信息 - http://www.weather.com.cn/weather/101050101.shtml 环境: windows7 python3.4(pip i ...

- python写的爬虫工具,抓取行政村的信息并写入到hbase里

python的版本是2.7.10,使用了两个第三方模块bs4和happybase,可以通过pip直接安装. 1.logger利用python自带的logging模块配置了一个简单的日志输出 2.get ...

- Java广度优先爬虫示例(抓取复旦新闻信息)

一.使用的技术 这个爬虫是近半个月前学习爬虫技术的一个小例子,比较简单,怕时间久了会忘,这里简单总结一下.主要用到的外部Jar包有HttpClient4.3.4,HtmlParser2.1,使用的开发 ...

- Python爬虫实战---抓取图书馆借阅信息

Python爬虫实战---抓取图书馆借阅信息 原创作品,引用请表明出处:Python爬虫实战---抓取图书馆借阅信息 前段时间在图书馆借了很多书,借得多了就容易忘记每本书的应还日期,老是担心自己会违约 ...

- 教您使用java爬虫gecco抓取JD全部商品信息

gecco爬虫 如果对gecco还没有了解可以参看一下gecco的github首页.gecco爬虫十分的简单易用,JD全部商品信息的抓取9个类就能搞定. JD网站的分析 要抓取JD网站的全部商品信息, ...

- 使用python抓取美团商家信息

抓取美团商家信息 import requests from bs4 import BeautifulSoup import json url = 'http://bj.meituan.com/' ur ...

- 使用selenium webdriver+beautifulsoup+跳转frame,实现模拟点击网页下一页按钮,抓取网页数据

记录一次快速实现的python爬虫,想要抓取中财网数据引擎的新三板板块下面所有股票的公司档案,网址为http://data.cfi.cn/data_ndkA0A1934A1935A1986A1995. ...

随机推荐

- PCIE、UART、I2C、SMBUS、SPI、eSPI、USB、PS2、CAN、SDIO等数据传输协议

M.2 wife一般支持USB.SDIO.PCIE三种传输

- kubernetes的Service Account和secret

系列目录 Service Account Service Account概念的引入是基于这样的使用场景:运行在pod里的进程需要调用Kubernetes API以及非Kubernetes API的其它 ...

- 深入Garbage First垃圾收集器(一)术语

Garbage垃圾收集器的原理,在这篇博客中有讲到,可以拿来参考下, Getting Started with the G1 Garbage Collector(译) 另外在这篇博客中也有讲到很多垃圾 ...

- JSP之Model1

watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQv/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/ ...

- 怎样得到QML package的具体API接口

虽然我们的developer站点有丰富的API介绍,可是,有些API的介绍可能并不全,有些API也在不断地演进中. 为了得到更具体的API,我们能够通过例如以下的命令来得到更加具体的信息.比方我们对& ...

- 2016/08/18 select

1.//得到select项的个数 2.jQuery.fn.size = function(){ 3. return jQuery(this).get(0).options.length; 4.} 5. ...

- 【BZOJ3307】雨天的尾巴 线段树合并

[BZOJ3307]雨天的尾巴 Description N个点,形成一个树状结构.有M次发放,每次选择两个点x,y对于x到y的路径上(含x,y)每个点发一袋Z类型的物品.完成所有发放后,每个点存放最多 ...

- js 怎么传递参数

<!DOCTYPE html> <html xmlns="http://www.w3.org/1999/xhtml"> <head runat=&qu ...

- eclipse中怎么删除重复的console

eclipse中不同的应用会开启不同的console,所以并不是重复. 如图: Terminate标志/操作按钮,可以停止当前的执行,以及标志此Console是Terminated状态: Remove ...

- [洛谷P3941] 入阵曲

题目背景 丹青千秋酿,一醉解愁肠. 无悔少年枉,只愿壮志狂. 入阵曲 题解在代码里. #include<iostream> #include<cstdio> #include& ...