Azkaban(三)Azkaban的使用

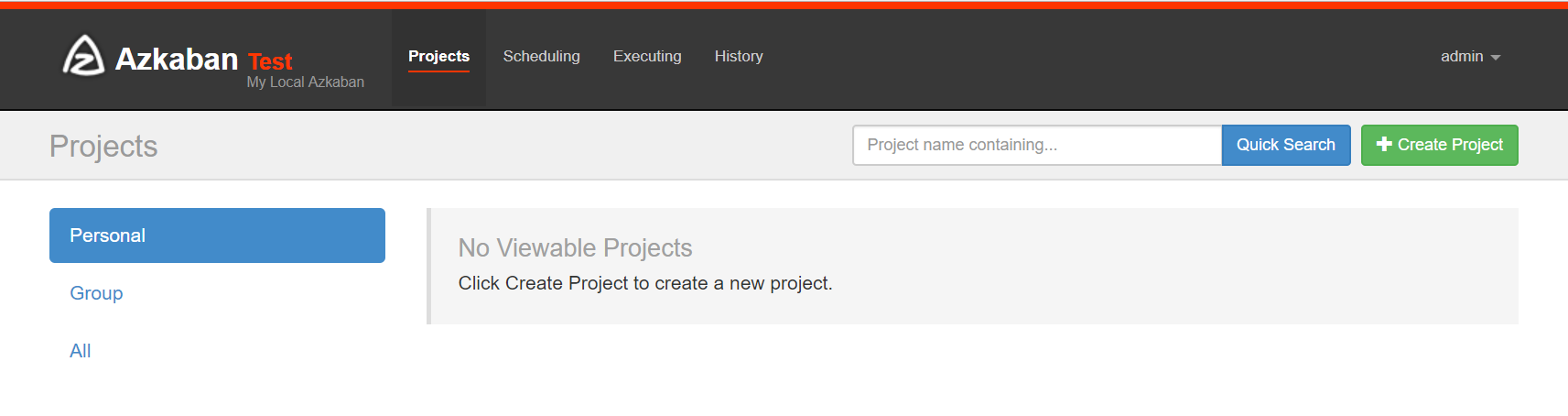

界面介绍

首页有四个菜单

- projects:最重要的部分,创建一个工程,所有flows将在工程中运行。

- scheduling:显示定时任务

- executing:显示当前运行的任务

- history:显示历史运行任务

介绍projects部分

概念介绍

创建工程:创建之前我们先了解下之间的关系,一个工程包含一个或多个flows,一个flow包含多个job。job是你想在azkaban中运行的一个进程,可以是简单的linux命令,可是java程序,也可以是复杂的shell脚本,当然,如果你安装相关插件,也可以运行插件。一个job可以依赖于另一个job,这种多个job和它们的依赖组成的图表叫做flow。

1、Command 类型单一 job 示例

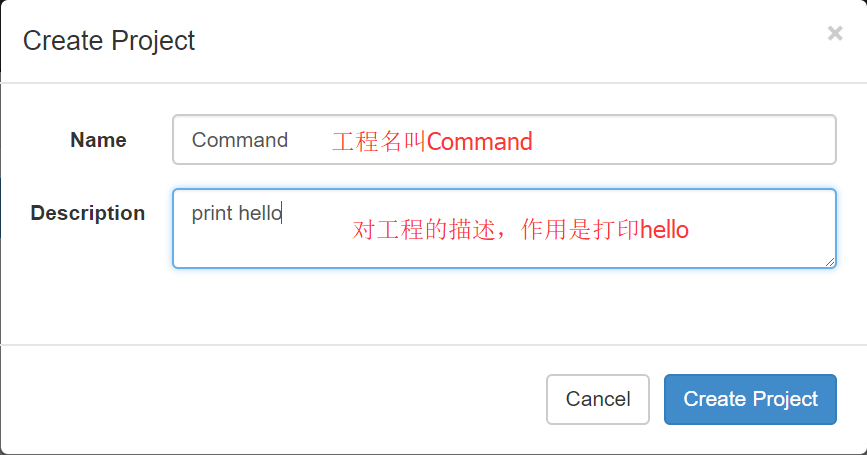

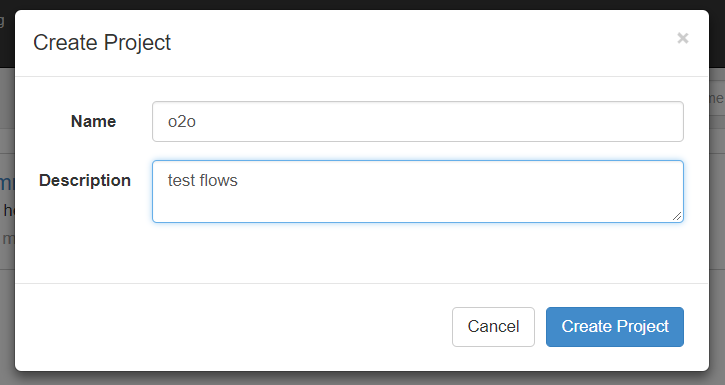

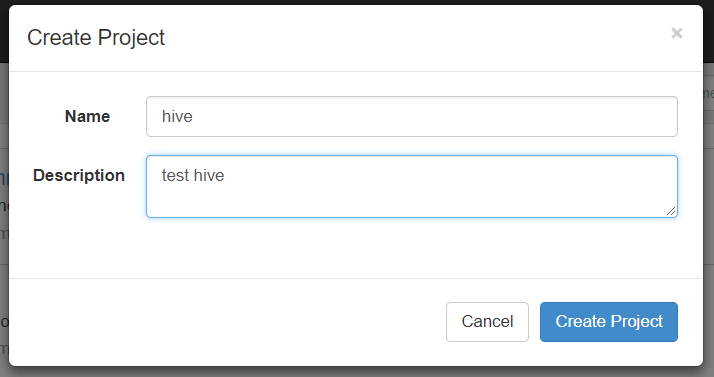

(1)首先创建一个工程,填写名称和描述

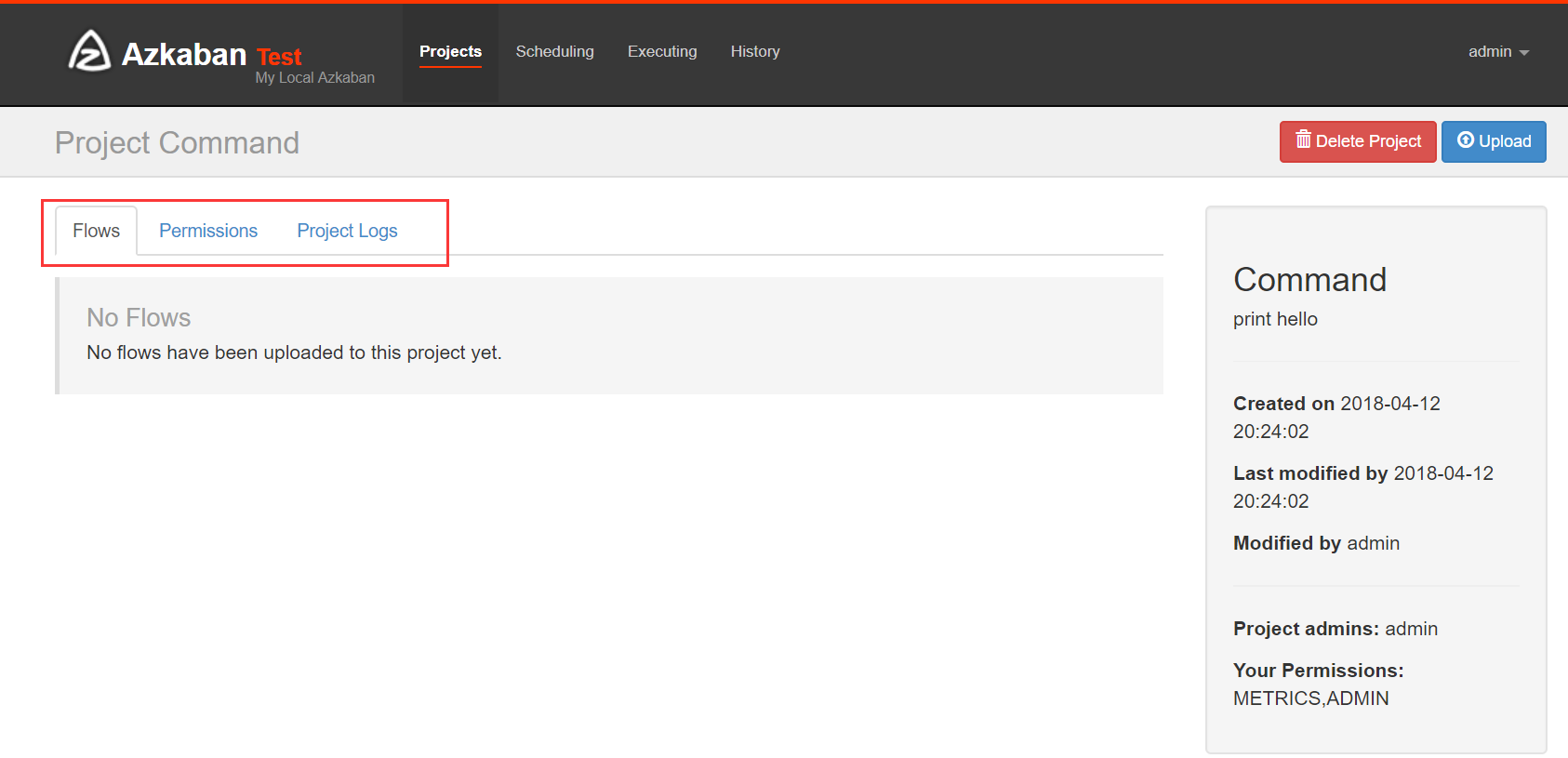

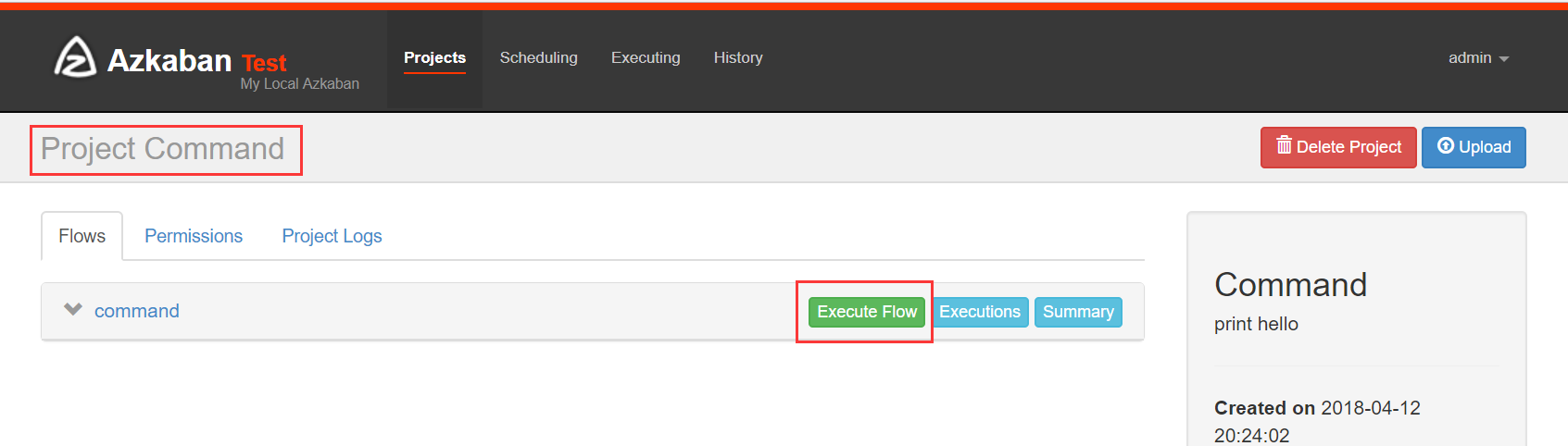

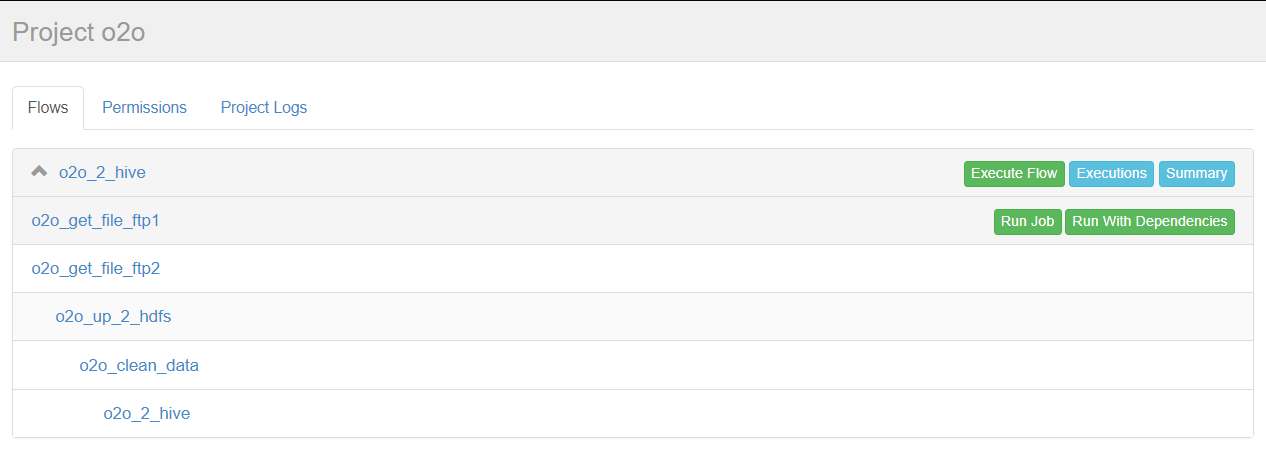

(2)点击创建之后

Flows:工作流程,有多个job组成

Permissions:权限管理

Project Logs:工程日志

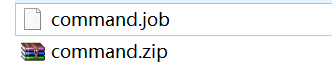

(3)job的创建

创建job很简单,只要创建一个以.job结尾的文本文件就行了,例如我们创建一个工作,用来打印hello,名字叫做command.job

#command.job

type=command

command=echo 'hello'

一个工程不可能只有一个job,我们现在创建多个依赖job,这也是采用azkaban的首要目的。

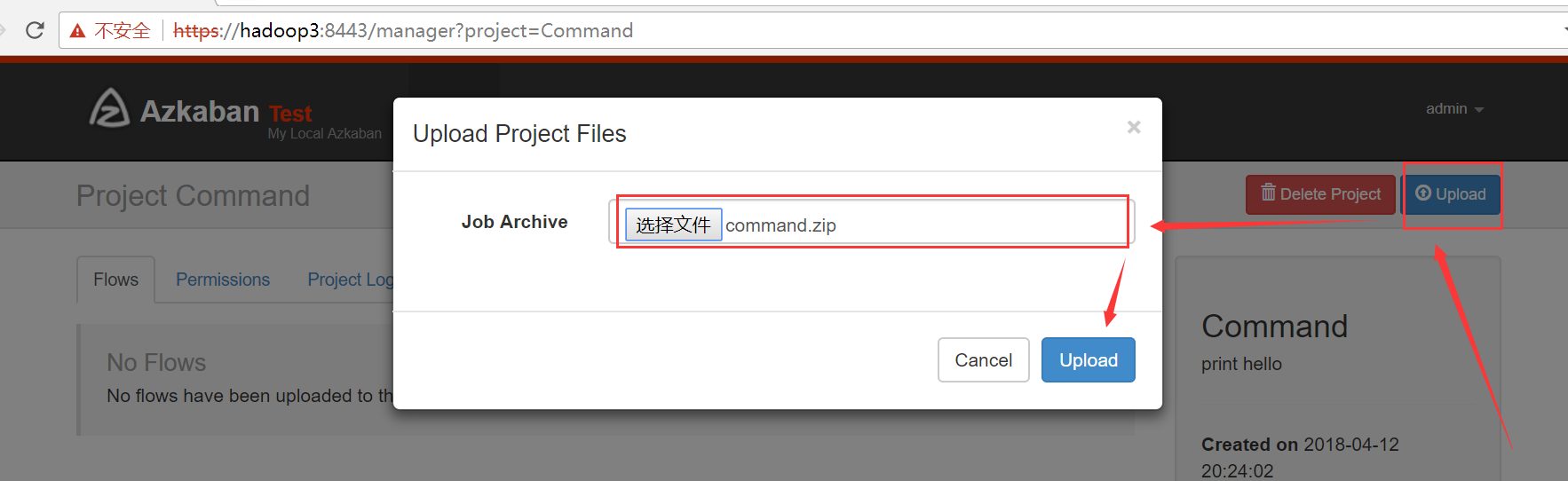

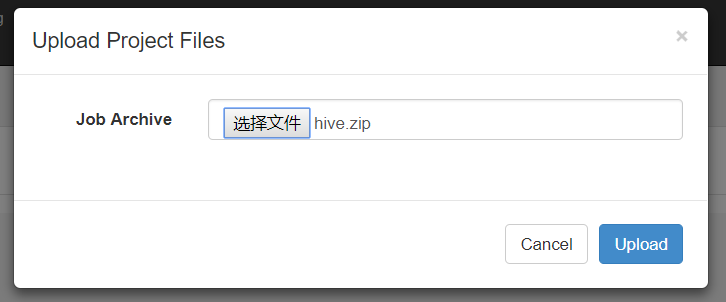

(4)将 job 资源文件打包

注意:只能是zip格式

(5)通过 azkaban web 管理平台创建 project 并上传压缩包

2、Command 类型多 job 工作流 flow

(1)创建项目

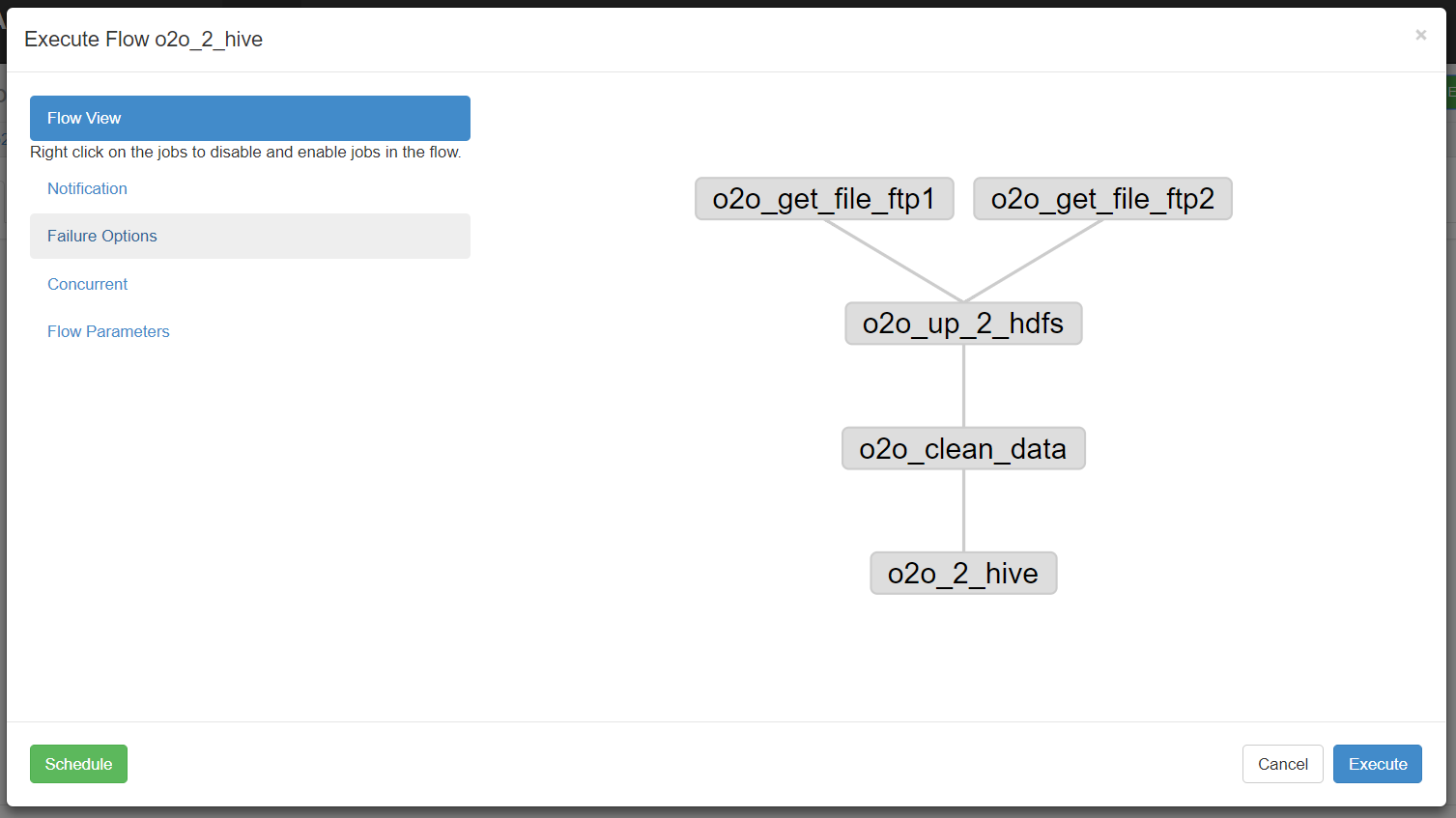

我们说过多个jobs和它们的依赖组成flow。怎么创建依赖,只要指定dependencies参数就行了。比如导入hive前,需要进行数据清洗,数据清洗前需要上传,上传之前需要从ftp获取日志。

定义5个job:

1、o2o_2_hive.job:将清洗完的数据入hive库

2、o2o_clean_data.job:调用mr清洗hdfs数据

3、o2o_up_2_hdfs.job:将文件上传至hdfs

4、o2o_get_file_ftp1.job:从ftp1获取日志

5、o2o_get_file_fip2.job:从ftp2获取日志

依赖关系:

3依赖4和5,2依赖3,1依赖2,4和5没有依赖关系。

o2o_2_hive.job

type=command

# 执行sh脚本,建议这样做,后期只需维护脚本就行了,azkaban定义工作流程

command=sh /job/o2o_2_hive.sh

dependencies=o2o_clean_data

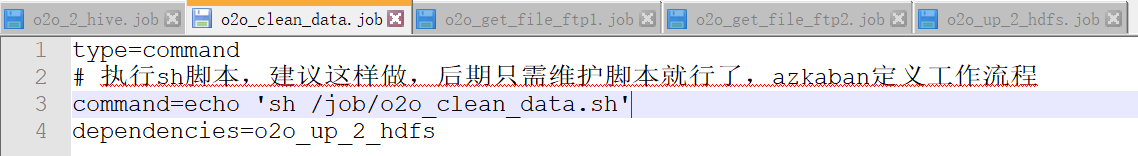

o2o_clean_data.job

type=command

# 执行sh脚本,建议这样做,后期只需维护脚本就行了,azkaban定义工作流程

command=sh /job/o2o_clean_data.sh

dependencies=o2o_up_2_hdfs

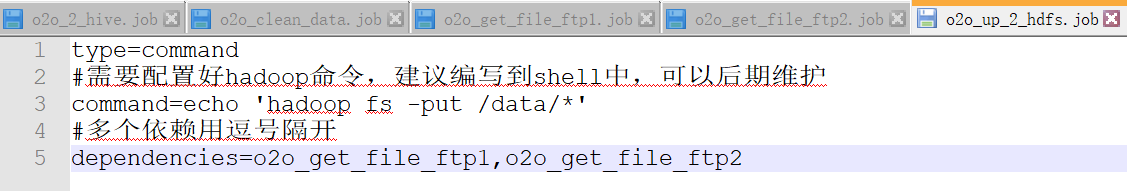

o2o_up_2_hdfs.job

type=command

#需要配置好hadoop命令,建议编写到shell中,可以后期维护

command=hadoop fs -put /data/*

#多个依赖用逗号隔开

dependencies=o2o_get_file_ftp1,o2o_get_file_ftp2

o2o_get_file_ftp1.job

type=command

command=wget "ftp://file1" -O /data/file1

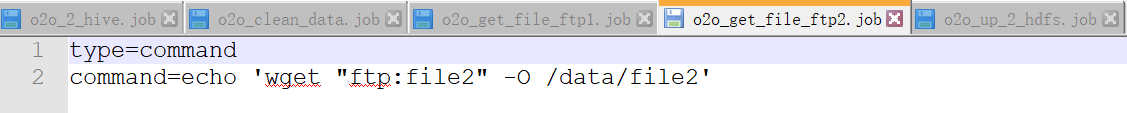

o2o_get_file_ftp2.job

type=command

command=wget "ftp:file2" -O /data/file2

可以运行unix命令,也可以运行python脚本(强烈推荐)。将上述job打成zip包。

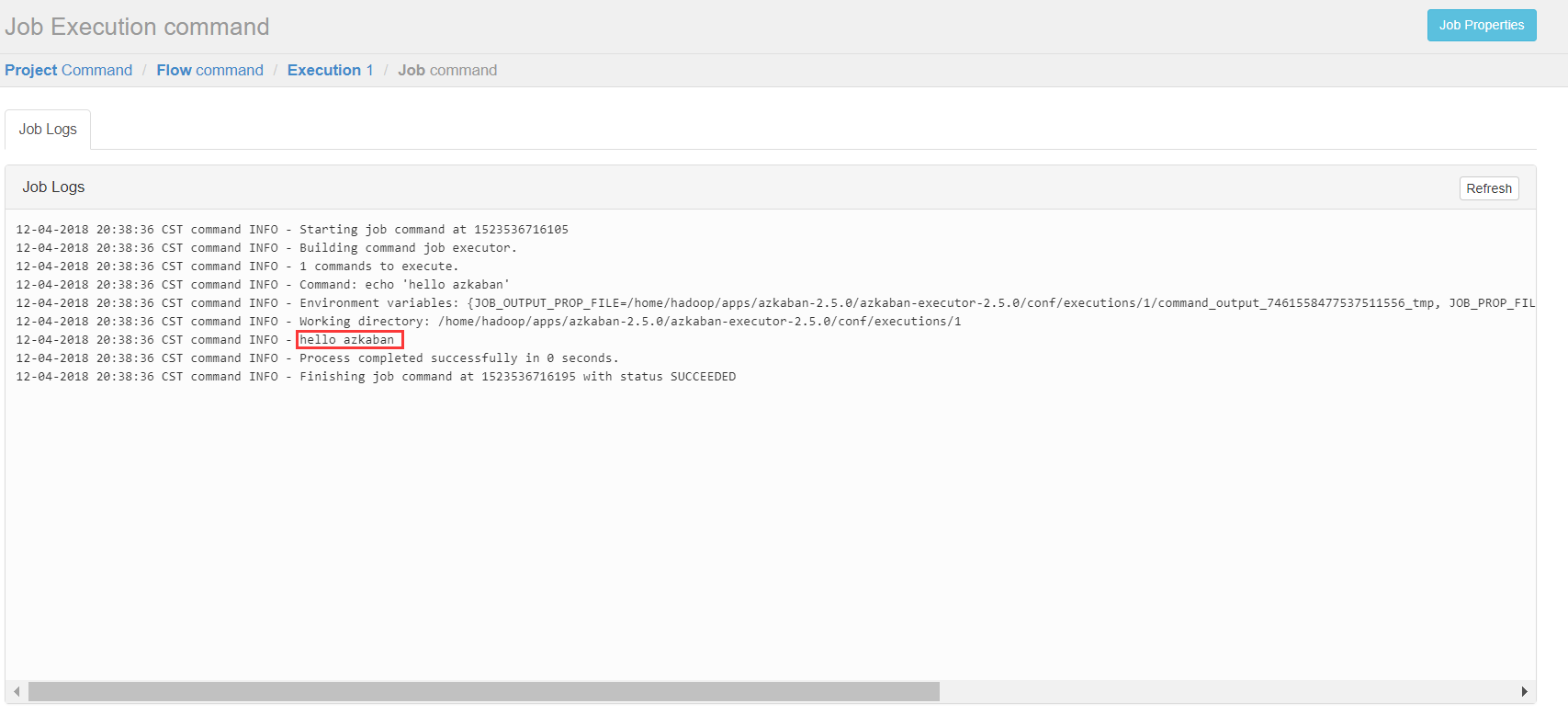

ps:为了测试流程,我将上述command都改为echo +相应命令

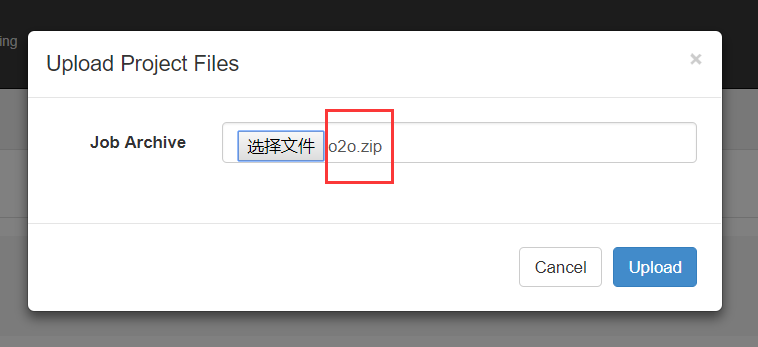

(2)上传

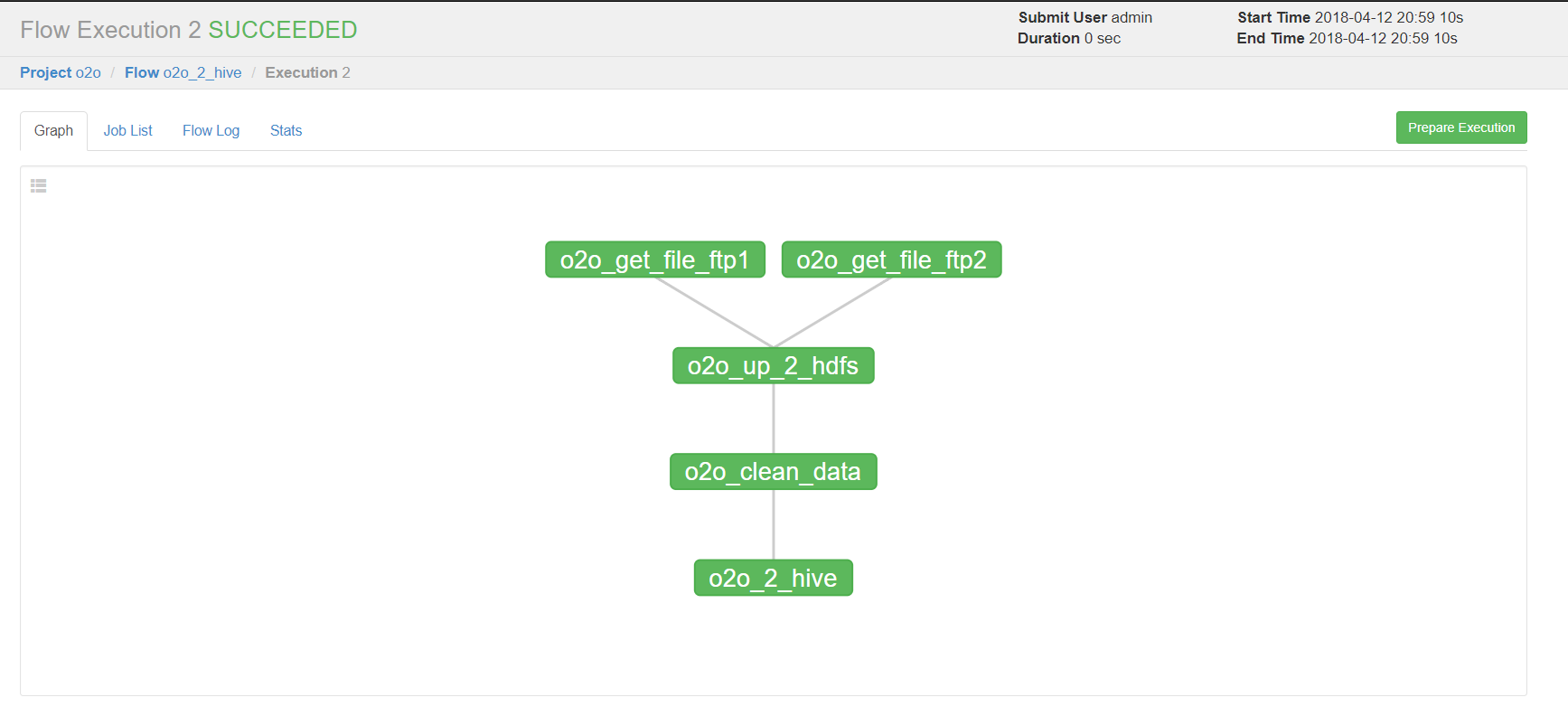

点击o2o_2_hive进入流程,azkaban流程名称以最后一个没有依赖的job定义的。

右上方是配置执行当前流程或者执行定时流程。

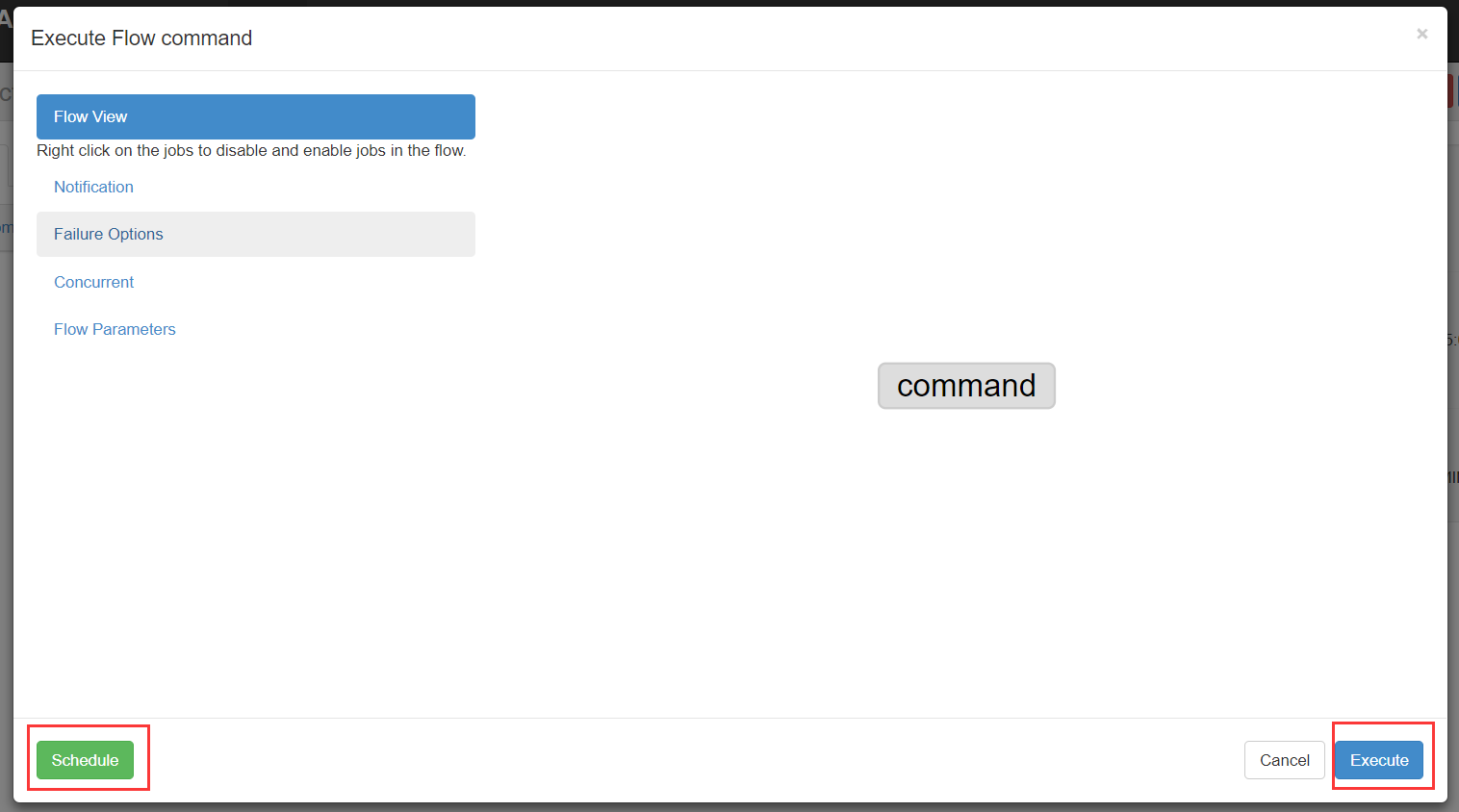

说明

Flow view:流程视图。可以禁用,启用某些job

Notification:定义任务成功或者失败是否发送邮件

Failure Options:定义一个job失败,剩下的job怎么执行

Concurrent:并行任务执行设置

Flow Parametters:参数设置。

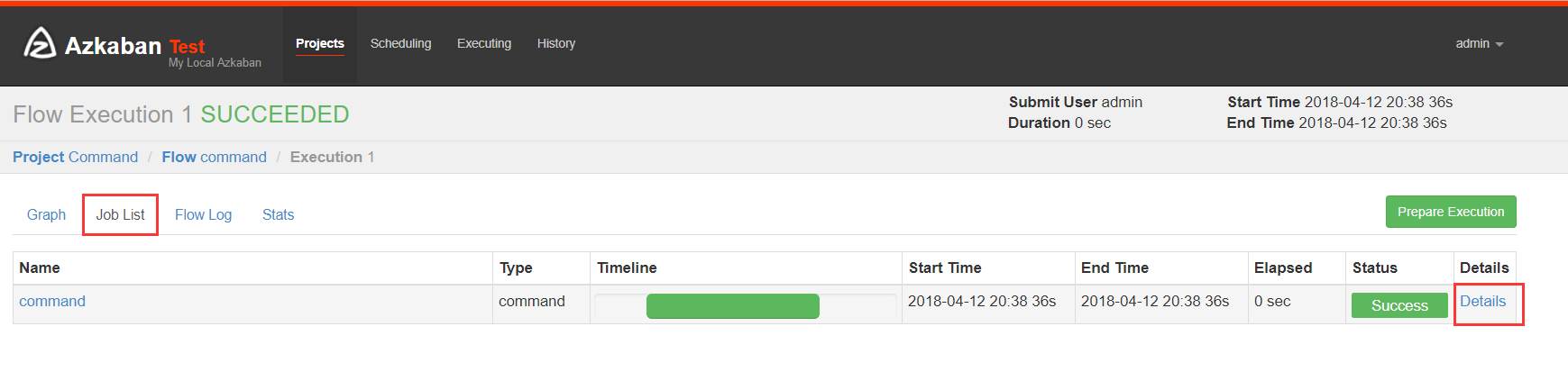

(3)执行一次

设置好上述参数,点击execute。

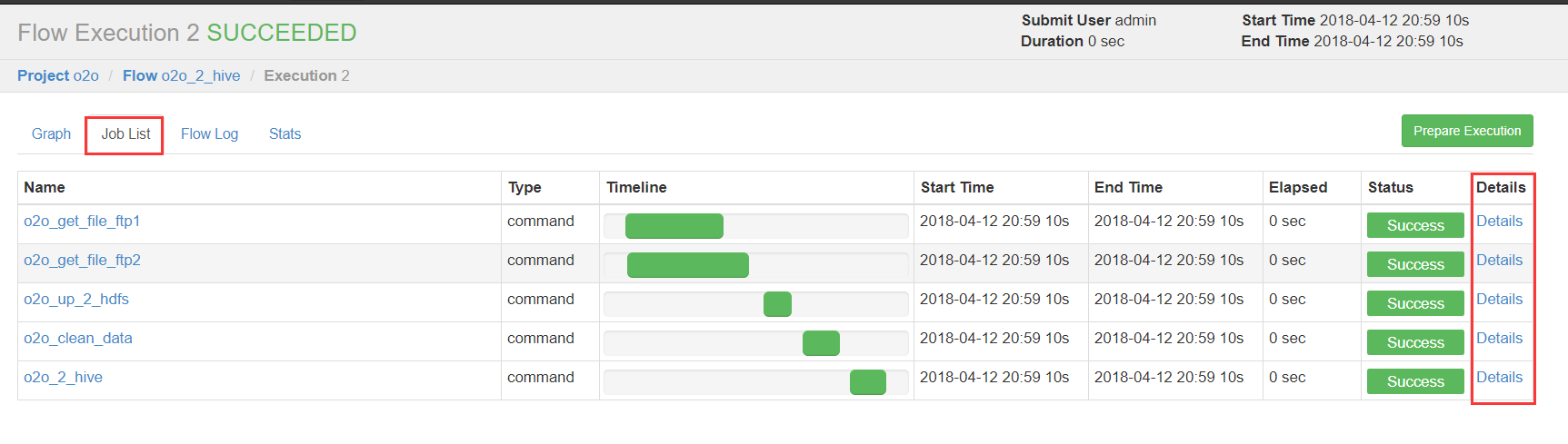

绿色代表成功,蓝色是运行,红色是失败。可以查看job运行时间,依赖和日志,点击details可以查看各个job运行情况。

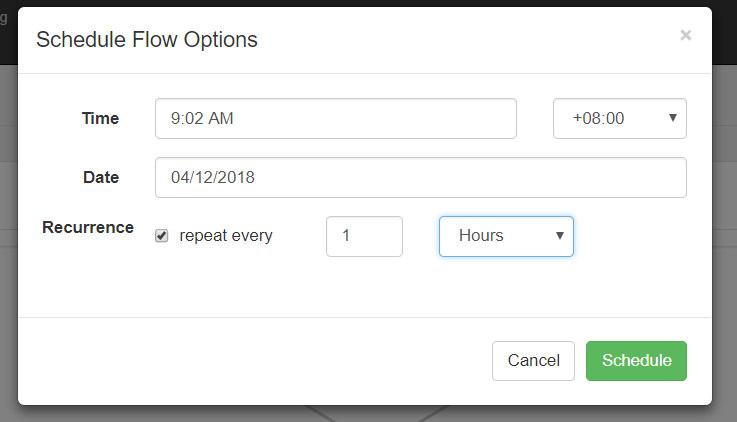

(4)执行定时任务

这时候注意到cst了吧,之前需要将配置中时区改为Asia/shanghai。

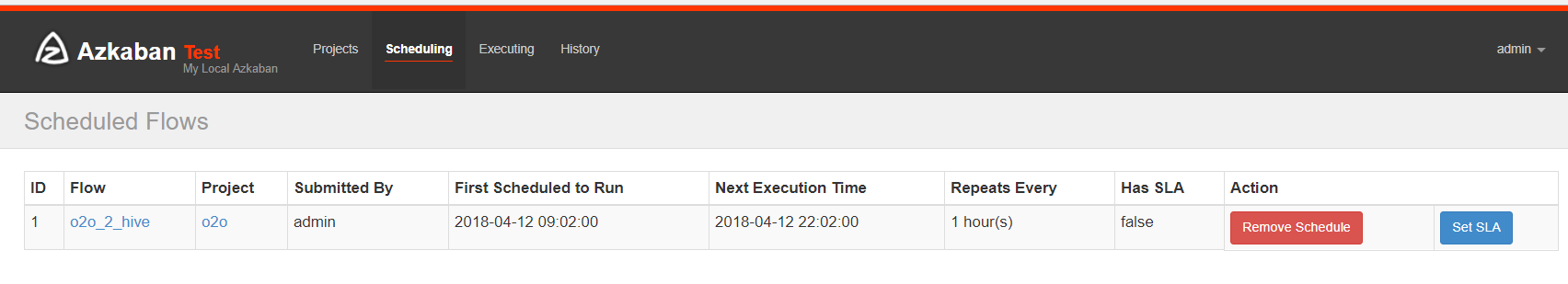

可以选择"天/时/分/月/周"等执行频率。

可以查看下次执行时间。

3、操作 MapReduce 任务

(1)创建 job 描述文件

mapreduce_wordcount.job

# mapreduce_wordcount.job

type=command

dependencies=mapreduce_pi

command=/home/hadoop/apps/hadoop-2.7.5/bin/hadoop

jar

/home/hadoop/apps/hadoop-2.7.5/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.5.jar

wordcount /wordcount/input /wordcount/output_azkaban

mapreduce_pi.job

# mapreduce_pi.job

type=command

command=/home/hadoop/apps/hadoop-2.7.5/bin/hadoop

jar

/home/hadoop/apps/hadoop-2.7.5/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.5.jar

pi 5 5

(2)创建 project 并上传 zip 包

(3)启动执行

4、Hive 脚本任务

(1) 创建 job 描述文件和 hive 脚本

Hive 脚本如下

test.sql

create database if not exists azkaban;

use azkaban;

drop table if exists student;

create table student(id int,name string,sex string,age int,deparment string) row format delimited fields terminated by ',';

load data local inpath '/home/hadoop/student.txt' into table student;

create table student_copy as select * from student;

insert overwrite directory '/aztest/hiveoutput' select count(1) from student_copy;

!hdfs dfs -cat /aztest/hiveoutput/000000_0;

drop database azkaban cascade;

Job 描述文件:

hivef.job

# hivef.job

type=command

command=/home/hadoop/apps/apache-hive-2.3.3-bin/bin/hive -f 'test.sql'

(2)将所有 job 资源文件打到一个 zip 包中

(3)在 azkaban 的 web 管理界面创建工程并上传 zip 包

5、启动 job

Azkaban(三)Azkaban的使用的更多相关文章

- 分布式计算(三)Azkaban介绍

转载自:Azkaban学习之路 (一)Azkaban的基础介绍 目录 一.为什么需要工作流调度器 二.工作流调度实现方式 三.常见工作流调度系统 四.各种调度工具对比 五.Azkaban 与 Oozi ...

- Azkaban学习之路 (三)Azkaban的使用

界面介绍 首页有四个菜单 projects:最重要的部分,创建一个工程,所有flows将在工程中运行. scheduling:显示定时任务 executing:显示当前运行的任务 history:显示 ...

- 初识Azkaban

先说下hadoop 内置工作流的不足 (1)支持job单一 (2)硬编码 (3)无可视化 (4)无调度机制 (5)无容错机制 在这种情况下Azkaban就出现了 1)Azkaban是什么 Azkaba ...

- Azkaban 2.5.0 搭建

一.前言 最近试着参照官方文档搭建 Azkaban,发现文档很多地方有坑,所以在此记录一下. 二.环境及软件 安装环境: 系统环境: ubuntu-12.04.2-server-amd64 安装目录: ...

- hadoop工作流引擎之azkaban [转]

介绍 Azkaban是twitter出的一个任务调度系统,操作比Oozie要简单很多而且非常直观,提供的功能比较简单.Azkaban以Flow为执行单元进行定时调度,Flow就是预定义好的由一个或多个 ...

- Oozie和Azkaban的技术选型和对比

1 两种调度工具功能对比图 下面的表格对上述2种hadoop工作流调度器的关键特性进行了比较,尽管这些工作流调度器能够解决的需求场景基本一致,但在设计理念,目标用户,应用场景等方面还是存在区别 特性 ...

- hadoop工作流引擎之azkaban

Azkaban是twitter出的一个任务调度系统,操作比Oozie要简单很多而且非常直观,提供的功能比较简单.Azkaban以Flow为执行单元进行定时调度,Flow就是预定义好的由一个或多个可存在 ...

- Azkaban 2.5.0 搭建和一些小问题

安装环境: 系统环境: ubuntu-12.04.2-server-amd64 安装目录: /usr/local/ae/ankaban JDK 安装目录: export JAVA_HOME=/usr/ ...

- 工作流调度器azkaban(以及各种工作流调度器比对)

1:工作流调度系统的作用: (1):一个完整的数据分析系统通常都是由大量任务单元组成:比如,shell脚本程序,java程序,mapreduce程序.hive脚本等:(2):各任务单元之间存在时间先后 ...

随机推荐

- python的匿名函数 lambda的使用方法详解以及使用案例

1.匿名函数是用lambda这个关键字定义 lambda x:x+1 第一个x代表形参,x+1相当于函数的返回值 #lambda x:x+1 第一个x代表形参,x+1相当于函数的返回值 def ...

- __metaclass__ 实现单列模式

class Singleton(type): """Singleton. @see: http://stackoverflow.com/questions/6760685 ...

- JVM 体系结构介绍

JVM是Java的一大利器.它可以屏蔽各个计算机平台相关软件和硬件之间的差异.把平台相关的耦合统一工作交由JVM的实现者. JVM(Java 虚拟机),它通过模拟一个计算机来达到一个计算机所拥有的计算 ...

- 一篇很棒的 MySQL 触发器学习教程

一.触发器概念 触发器(trigger):监视某种情况,并触发某种操作,它是提供给程序员和数据分析员来保证数据完整性的一种方法,它是与表事件相关的特殊的存储过程,它的执行不是由程序调用,也不是手工启动 ...

- [USACO07NOV]挤奶的时间Milking Time

https://daniu.luogu.org/problemnew/show/2889 按右端点从小到大排序后DP dp[i] 到第i个时间段的最大产奶量 不能按左端点排序,第i段由第j段更新时,第 ...

- 设计模式之————依赖注入(Dependency Injection)与控制反转(Inversion of Controller)

参考链接: 依赖注入(DI) or 控制反转(IoC) laravel 学习笔记 —— 神奇的服务容器 PHP 依赖注入,从此不再考虑加载顺序 名词解释 IoC(Inversion of Contro ...

- SearchSploit

在我们的GitHub上的Exploit Database存储库中包含一个名为"searchsploit"的Exploit-DB的命令行搜索工具,该工具还允许您在任何地方随身携带一个 ...

- 【总结】前端框架:react还是vue?

之前写了一篇前端框架的大汇总,主要介绍了当下主流的框架和其特性.最近除了bootstrap,就属react和vue最为热门,这篇就主要拿这两个框架来做一下详细对比. 究竟如何正确使用?作为小白的我们从 ...

- gnome桌面无法使用笔记本的触摸板

原来使用ubuntu的时候,升级了gnome之后触摸板就不能用了,不能说不能用了,应该是自己不会配置然后不好用了,具体状况如是,可以在登录界面gdm使用触摸板以及点击,但是进入桌面之后就不能点击了.后 ...

- Linux内核跟踪之ring buffer的实现【转】

转自:http://blog.chinaunix.net/uid-20543183-id-1930845.html ---------------------------------------- ...