【慕课网实战】Spark Streaming实时流处理项目实战笔记六之铭文升级版

铭文一级:

整合Flume和Kafka的综合使用

avro-memory-kafka.conf

avro-memory-kafka.sources = avro-source

avro-memory-kafka.sinks = kafka-sink

avro-memory-kafka.channels = memory-channel

avro-memory-kafka.sources.avro-source.type = avro

avro-memory-kafka.sources.avro-source.bind = hadoop000

avro-memory-kafka.sources.avro-source.port = 44444

avro-memory-kafka.sinks.kafka-sink.type = org.apache.flume.sink.kafka.KafkaSink

avro-memory-kafka.sinks.kafka-sink.brokerList = hadoop000:9092

avro-memory-kafka.sinks.kafka-sink.topic = hello_topic

avro-memory-kafka.sinks.kafka-sink.batchSize = 5

avro-memory-kafka.sinks.kafka-sink.requiredAcks =1

avro-memory-kafka.channels.memory-channel.type = memory

avro-memory-kafka.sources.avro-source.channels = memory-channel

avro-memory-kafka.sinks.kafka-sink.channel = memory-channel

flume-ng agent \

--name avro-memory-kafka \

--conf $FLUME_HOME/conf \

--conf-file $FLUME_HOME/conf/avro-memory-kafka.conf \

-Dflume.root.logger=INFO,console

flume-ng agent \

--name exec-memory-avro \

--conf $FLUME_HOME/conf \

--conf-file $FLUME_HOME/conf/exec-memory-avro.conf \

-Dflume.root.logger=INFO,console

kafka-console-consumer.sh --zookeeper hadoop000:2181 --topic hello_topic

铭文二级:

Kafka Producer java API编程:

建KafkaProperties类=>

申明三个静态属性:

public static final String

1.BROKER_LIST="192.168.0.115:9092" //IP地址修改成自己的地址

2.ZK="192.168.0.115:2181" //IP地址修改成自己的地址

3.TOPIC="hello_topic"

建KafkaProducer类=>

创建构造方法实现123小点,参数为topic:(构造方法为私有还是公有?公有)

1.申明Producer类(导入类为kafka.javaapi.Producer),查看返回值与参数值

2.参数值new ProducerConfig(),里面参数为properties(在构造方法中new出来)

3.properties需要put三个属性:

A.metadata.broker.list //类静态方法获得

B.serializer.class //kafka.serializer.StringEncoder

C.request.required.acks //值说明如下:

0:不等待任何握手机制;

1:写到本地log并返回ack,常用,但可能有一丁点数据丢失

-1:严格握手,只要有副本存活就没有数据丢失

4.使类继承Thread类,因为使用线程测试

public void run(){

int messageNo = 1;

while(true){

String message = "message_" + messageNo;

producer.send(new KeyedMessage<Integer,String>(topic,message));

system.out.println("Send:" + message);

messageNo++;

}

try{

Thread.sleep(2000);

}catch(Exception e){

e.printStackTrace();

}

}

建KafkaClientApp测试类:

1.申明main方法

2.new KafkaProducer(KafkaProperties.TOPIC).start();

3.jps查询是否已启动zookeeper、kafka、consumer,必须先启动

4.运行main方法可观察到控制台与consumer终端有内容输出

Kafka Consumer java API编程:

创建KafkaConsumer类=>

申明参数为topic的构造方法

private ConsumerConnector createConnector(){

Properties properties = new Properties();

properties.put("zookeeper.connect", KafkaProperties.ZK);

properties.put("group.id",KafkaProperties.GROUP_ID);

return Consumer.createJavaConsumerConnector(new ConsumerConfig(properties));

}

public void run() {

ConsumerConnector consumer = createConnector();

Map<String, Integer> topicCountMap = new HashMap<String, Integer>();

topicCountMap.put(topic, 1);

// topicCountMap.put(topic2, 1);

// topicCountMap.put(topic3, 1);

// String: topic

// List<KafkaStream<byte[], byte[]>> 对应的数据流

Map<String, List<KafkaStream<byte[], byte[]>>> messageStream = consumer.createMessageStreams(topicCountMap);

KafkaStream<byte[], byte[]> stream = messageStream.get(topic).get(0); //获取我们每次接收到的数据

ConsumerIterator<byte[], byte[]> iterator = stream.iterator();

while (iterator.hasNext()) {

String message = new String(iterator.next().message());

System.out.println("rec: " + message);

}

}

代码分析:

1.获取Consumer,根据分装过的topicCountMap生成信息流messageStream

topicCountMap.put(topic,1);//参数“1” 指生成一个信息流

2.此时messageStream里面还有topic,需要去除topic,返回stream

3.将stream进行迭代,返回iterator

4.通过while(iterator.hasNext())与iterator.next().message()生成message并返回

ps:KafkaProperties类勿忘需要加一个属性GROUP_ID并添加到properties,自起一个id即可

示例:

public static final String GROUP_ID = "test_group1";

properties.put("group.id",KafkaProperties.GROUP_ID);

Kafka实战=>

整合Flume和kafka完成实时数据采集

修改avro-memory-logger.conf//将sink改成kafka,详情可看CDH5里面的文档,官网新版有些小改动

type:org.apache.flume.sink.kafka.KafkaSink

brokerList:hadoop000:9092

非必须:

topic //自己尝试不设置是否可以,默认是调用含有topic参数的topic

batchSize:5

requiredAcks:1

分别开始,然后测试。

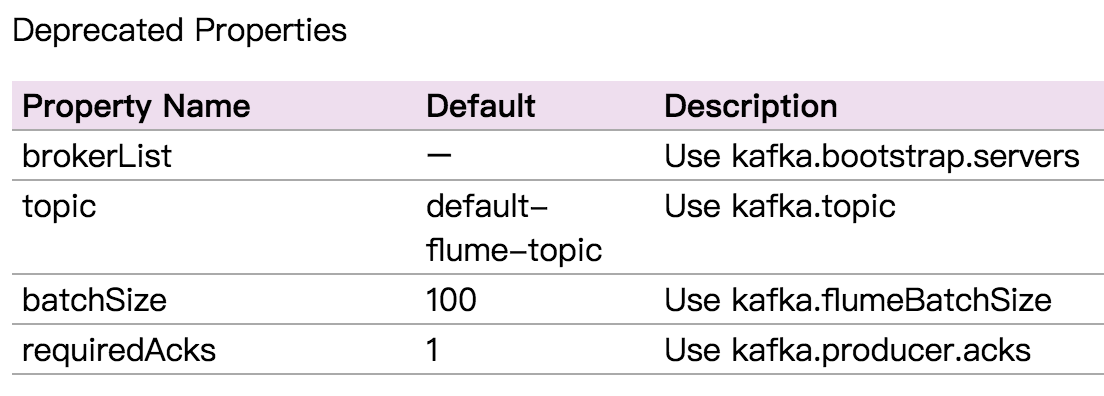

ps:上面属性名已经不推荐,最新官网为,可能跟版本有关,自行测试:

【慕课网实战】Spark Streaming实时流处理项目实战笔记六之铭文升级版的更多相关文章

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记十之铭文升级版

铭文一级: 第八章:Spark Streaming进阶与案例实战 updateStateByKey算子需求:统计到目前为止累积出现的单词的个数(需要保持住以前的状态) java.lang.Illega ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记七之铭文升级版

铭文一级: 第五章:实战环境搭建 Spark源码编译命令:./dev/make-distribution.sh \--name 2.6.0-cdh5.7.0 \--tgz \-Pyarn -Phado ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记十四之铭文升级版

铭文一级: 第11章 Spark Streaming整合Flume&Kafka打造通用流处理基础 streaming.conf agent1.sources=avro-sourceagent1 ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记二之铭文升级版

铭文一级: 第二章:初识实时流处理 需求:统计主站每个(指定)课程访问的客户端.地域信息分布 地域:ip转换 Spark SQL项目实战 客户端:useragent获取 Hadoop基础课程 ==&g ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记十六之铭文升级版

铭文一级: linux crontab 网站:http://tool.lu/crontab 每一分钟执行一次的crontab表达式: */1 * * * * crontab -e */1 * * * ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记十五之铭文升级版

铭文一级:[木有笔记] 铭文二级: 第12章 Spark Streaming项目实战 行为日志分析: 1.访问量的统计 2.网站黏性 3.推荐 Python实时产生数据 访问URL->IP信息- ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记十二之铭文升级版

铭文一级: ======Pull方式整合 Flume Agent的编写: flume_pull_streaming.conf simple-agent.sources = netcat-sources ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记十一之铭文升级版

铭文一级: 第8章 Spark Streaming进阶与案例实战 黑名单过滤 访问日志 ==> DStream20180808,zs20180808,ls20180808,ww ==> ( ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记九之铭文升级版

铭文一级: 核心概念:StreamingContext def this(sparkContext: SparkContext, batchDuration: Duration) = { this(s ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记八之铭文升级版

铭文一级: Spark Streaming is an extension of the core Spark API that enables scalable, high-throughput, ...

随机推荐

- MVC与WebApi中的异常统一处理

1.简单例子 /// <summary> /// 全局页面控制器异常记录 MVC的异常处理 /// </summary> public class CustomErrorAtt ...

- [Z]Spring Data JPA 之 一对一,一对多,多对多 关系映射

一.@OneToOne关系映射 JPA使用@OneToOne来标注一对一的关系. 实体 People :用户. 实体 Address:家庭住址. People 和 Address 是一对一的关系. 这 ...

- c# 关于取小数点后值四舍五入精度问题

---恢复内容开始--- 最近做一个校验码验证法算法的生成程序,涉及到取小数点后值的问题;对其中遇到的问题做一下总结: 1:ToString()转换时碰到0.9999999999999之类的数据,给自 ...

- 阿里巴巴Java开发手册及Java代码规约扫描eclipse插件

一.github地址: https://github.com/alibaba/p3c 二..eclipse插件的安装 此处示例采用eclipse,版本为 Neon.1 Release RC3 (4.6 ...

- hdu 5441 Travel (2015长春网赛)

http://acm.hdu.edu.cn/showproblem.php?pid=5441 题目大意是给一个n个城市(点)m条路线(边)的双向的路线图,每条路线有时间值(带权图),然后q个询问,每个 ...

- Delphi中静态方法重载还是覆盖的讨论

Delphi中静态方法重载还是覆盖的讨论 新人学习Delphi的时候,容易搞不懂的一个问题,当子类方法和基类方法同名,并且参数也一样的时候,叫做什么呢?是覆盖,还是重载呢? 答案是隐藏父类方法. 一般 ...

- generic_netlink 用法

参考资料: https://wiki.linuxfoundation.org/networking/generic_netlink_howto generic_netlink 框架 +-------- ...

- [Python] 代码中有中文注释会报错

原因 如果文件里有非ASCII字符,需要在第一行或第二行指定编码声明. 解决方法 在第一行或是第二行加入这么一句# -- coding: utf-8 -- ASCII知识普及: ASCII(Ameri ...

- js,jquery的数字型字符串变量比较大小

转:http://blog.csdn.net/dxnn520/article/details/8267173 var定义的变量应该是字符串,有时没有经过类型转换而进行比较的话,小于十的话还可以,如果大 ...

- java通过接口扩展枚举

package com.hra.riskprice; import com.hra.riskprice.SysEnum.Factor_Type; import com.hra.riskprice.po ...