Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息。

1.观察url

首先观察一下网址的结构 http://movie.douban.com/top250?start=0&filter=&type= :

可以看到,问号?后有三个参数 start、filter、type,其中start代表页码,每页展示25部电影,0代表第一页,以此类推25代表第二页,50代表第三页...

filter顾名思义,是过滤已经看过的电影,filter和type在这里不重要,可以不管。

2.查看网页源代码

打开上面的网址,查看源代码,可以看到信息的展示结构如下:

<ol class="grid_view">

<li>

<div class="item">

<div class="pic">

<em class="">1</em>

<a href="http://movie.douban.com/subject/1292052/">

<img alt="肖申克的救赎" src="http://img3.douban.com/view/movie_poster_cover/ipst/public/p480747492.jpg" class="">

</a>

</div>

<div class="info">

<div class="hd">

<a href="http://movie.douban.com/subject/1292052/" class="">

<span class="title">肖申克的救赎</span>

<span class="title"> / The Shawshank Redemption</span>

<span class="other"> / 月黑高飞(港) / 刺激1995(台)</span>

</a> <span class="playable">[可播放]</span>

</div>

<div class="bd">

<p class="">

导演: 弗兰克·德拉邦特 Frank Darabont 主演: 蒂姆·罗宾斯 Tim Robbins /...<br>

1994 / 美国 / 犯罪 剧情

</p> <div class="star">

<span class="rating5-t"><em>9.6</em></span>

<span>646374人评价</span>

</div> <p class="quote">

<span class="inq">希望让人自由。</span>

</p>

</div>

</div>

</div>

</li>

其中<em class="">1</em>代表排名,<span class="title">肖申克的救赎</span>代表电影名,其他信息的含义也很容易能看出来。

于是接下来可以写正则表达式:

pattern = re.compile(u'<div.*?class="item">.*?<div.*?class="pic">.*?'

+ u'<em.*?class="">(.*?)</em>.*?'

+ u'<div.*?class="info">.*?<span.*?class="title">(.*?)'

+ u'</span>.*?<span.*?class="title">(.*?)</span>.*?'

+ u'<span.*?class="other">(.*?)</span>.*?</a>.*?'

+ u'<div.*?class="bd">.*?<p.*?class="">.*?'

+ u'导演: (.*?) '

+ u'主演: (.*?)<br>'

+ u'(.*?) / (.*?) / '

+ u'(.*?)</p>'

+ u'.*?<div.*?class="star">.*?<em>(.*?)</em>'

+ u'.*?<span>(.*?)人评价</span>.*?<p.*?class="quote">.*?'

+ u'<span.*?class="inq">(.*?)</span>.*?</p>', re.S)

在此处flag参数re.S代表多行匹配。

3.使用面向对象的设计模式编码

代码如下:

# -*- coding:utf-8 -*-

__author__ = 'Jz'

import urllib2

import re

import sys class MovieTop250:

def __init__(self):

#设置默认编码格式为utf-8

reload(sys)

sys.setdefaultencoding('utf-8')

self.start = 0

self.param = '&filter=&type='

self.headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64)'}

self.movieList = []

self.filePath = 'D:/coding_file/python_file/File/DoubanTop250.txt' def getPage(self):

try:

URL = 'http://movie.douban.com/top250?start=' + str(self.start)

request = urllib2.Request(url = URL, headers = self.headers)

response = urllib2.urlopen(request)

page = response.read().decode('utf-8')

pageNum = (self.start + 25)/25

print '正在抓取第' + str(pageNum) + '页数据...'

self.start += 25

return page

except urllib2.URLError, e:

if hasattr(e, 'reason'):

print '抓取失败,具体原因:', e.reason def getMovie(self):

pattern = re.compile(u'<div.*?class="item">.*?<div.*?class="pic">.*?'

+ u'<em.*?class="">(.*?)</em>.*?'

+ u'<div.*?class="info">.*?<span.*?class="title">(.*?)'

+ u'</span>.*?<span.*?class="title">(.*?)</span>.*?'

+ u'<span.*?class="other">(.*?)</span>.*?</a>.*?'

+ u'<div.*?class="bd">.*?<p.*?class="">.*?'

+ u'导演: (.*?) '

+ u'主演: (.*?)<br>'

+ u'(.*?) / (.*?) / '

+ u'(.*?)</p>'

+ u'.*?<div.*?class="star">.*?<em>(.*?)</em>'

+ u'.*?<span>(.*?)人评价</span>.*?<p.*?class="quote">.*?'

+ u'<span.*?class="inq">(.*?)</span>.*?</p>', re.S)

while self.start <= 225:

page = self.getPage()

movies = re.findall(pattern, page)

for movie in movies:

self.movieList.append([movie[0], movie[1], movie[2].lstrip(' / '),

movie[3].lstrip(' / '), movie[4],

movie[5], movie[6].lstrip(), movie[7], movie[8].rstrip(),

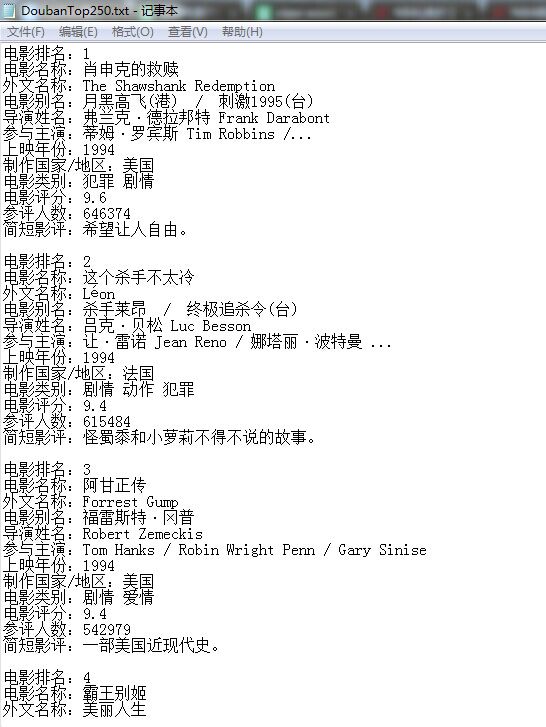

movie[9], movie[10], movie[11]]) def writeTxt(self):

fileTop250 = open(self.filePath, 'w')

try:

for movie in self.movieList:

fileTop250.write('电影排名:' + movie[0] + '\r\n')

fileTop250.write('电影名称:' + movie[1] + '\r\n')

fileTop250.write('外文名称:' + movie[2] + '\r\n')

fileTop250.write('电影别名:' + movie[3] + '\r\n')

fileTop250.write('导演姓名:' + movie[4] + '\r\n')

fileTop250.write('参与主演:' + movie[5] + '\r\n')

fileTop250.write('上映年份:' + movie[6] + '\r\n')

fileTop250.write('制作国家/地区:' + movie[7] + '\r\n')

fileTop250.write('电影类别:' + movie[8] + '\r\n')

fileTop250.write('电影评分:' + movie[9] + '\r\n')

fileTop250.write('参评人数:' + movie[10] + '\r\n')

fileTop250.write('简短影评:' + movie[11] + '\r\n\r\n')

print '文件写入成功...'

finally:

fileTop250.close() def main(self):

print '正在从豆瓣电影Top250抓取数据...'

self.getMovie()

self.writeTxt()

print '抓取完毕...' DouBanSpider = MovieTop250()

DouBanSpider.main()

代码比较简单,最后将信息写入一个文件,没有什么需要解释的地方。

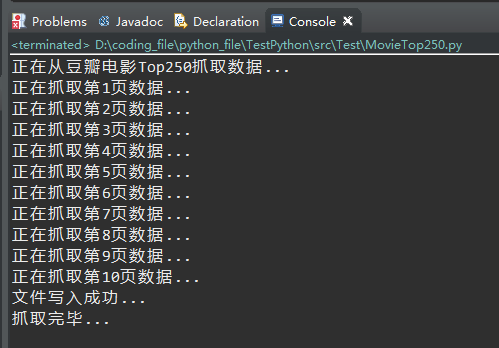

4.运行截图

5.问题说明

打开文件浏览时发现有个别电影没有抓取下来或者信息中出现html代码,后来排查发现是因为豆瓣有部分电影的信息不全,缺少主演等导致html代码出现差异而导致正则表达式没有匹配到或者匹配出错。

Python爬虫----抓取豆瓣电影Top250的更多相关文章

- Python小爬虫——抓取豆瓣电影Top250数据

python抓取豆瓣电影Top250数据 1.豆瓣地址:https://movie.douban.com/top250?start=25&filter= 2.主要流程是抓取该网址下的Top25 ...

- python爬虫 Scrapy2-- 爬取豆瓣电影TOP250

sklearn实战-乳腺癌细胞数据挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003& ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- python爬虫抓取豆瓣电影

抓取电影名称以及评分,并排序(代码丑炸) import urllib import re from bs4 import BeautifulSoup def get(p): t=0 k=1 n=1 b ...

- Python爬虫-爬取豆瓣电影Top250

#!usr/bin/env python3 # -*- coding:utf-8-*- import requests from bs4 import BeautifulSoup import re ...

- Python:python抓取豆瓣电影top250

一直对爬虫感兴趣,学了python后正好看到某篇关于爬取的文章,就心血来潮实战一把吧. 实现目标:抓取豆瓣电影top250,并输出到文件中 1.找到对应的url:https://movie.douba ...

- Python抓取豆瓣电影top250!

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理.作者:404notfound 一直对爬虫感兴趣,学了python后正好看到 ...

- python2.7抓取豆瓣电影top250

利用python2.7抓取豆瓣电影top250 1.任务说明 抓取top100电影名称 依次打印输出 2.网页解析 要进行网络爬虫,利用工具(如浏览器)查看网页HTML文件的相关内容是很有必要,我使用 ...

- Python3 抓取豆瓣电影Top250

利用 requests 抓取豆瓣电影 Top 250: import re import requests def main(url): global num headers = {"Use ...

随机推荐

- python读取/写入文件

<Python编程:从入门到实践>读书笔记 1.读取文件并且对文件内容进行打印有三种方式: with open('test.txt') as fo: for lins in fo: pri ...

- Java集合(5):HashSet

存入Set的每个元素必须是惟一的,因为Set不保存重复元素.加入Set的元素必须定义equals()方法以确保对象的唯一性.Set不保证维护元素的次序.Set与Collection有完全一样的接口. ...

- 解决XAMPP不能启动Apche服务问题

打开command prompt输入命令 netstat -ano 查看哪个 PID的进程占用了80端口.结果是inetinfo.exe 网上查了下,正是WIN XP IIS的进程,但是又不想删,就只 ...

- FileZilla Server IP限制设置

上面那个是黑名单. * 代表所有 下面那个是白名单. 多个是用 空格 分割

- JVM(4) 虚拟机性能监控与故障处理工具

1. Sun JDK 监控和故障处理工具 1)jps:JVM process Status Tool,显示指定系统内所有的HotSpot虚拟机进程.可以列出正在运行的虚拟机进程,并显示虚拟机执行主类( ...

- ubuntu16.04 虚拟机 安装win7/win10

http://www.xitongcheng.com/jiaocheng/xtazjc_article_26588.html https://blog.csdn.net/sunyao_123/arti ...

- SpringBoot 定义通过字段验证

第一步:定义ValidationResult类 public class ValidationResult { // 校验结果是否有错 private boolean hasErrors = fals ...

- spring注解方式注入bean

用注解的方式注入bean,spring的配置文件也要增加一些约束和导入注解所在的包 applicationContext.xml <?xml version="1.0" en ...

- Dispatcher initialization failedUnable to load configuration 解决办法

检查<package name="action" extends="struts-default"></package>中是否有exte ...

- 死循环的/etc/profile

用户服务器登陆后停在以下界面 Connecting to ... Connection established. To escape to local shell, press 'Ctrl+Alt+] ...