CentOS7+hadoop2.6.4+spark-1.6.1

环境:

CentOS7

hadoop2.6.4已安装两个节点:master、slave1

过程:

把下载的scala、spark压缩包拷贝到/usr/hadoop-2.6.4/thirdparty目录下。

安装scala:

$ sudo tar -zxvf scala-2.11..tgz

修改环境变量文件 /etc/profile,添加以下内容:

export SCALA_HOME=/usr/hadoop-2.6./thirdparty/scala-2.11.

export PATH=$PATH:$SCALA_HOME/bin

source 使之生效

$ source /etc/profile

验证 Scala 安装

slave1参照 master 机器安装步骤进行安装。

Spark 安装:

解压

$ sudo tar -zxvf spark-1.6.1-bin-hadoop2.6.tgz

修改环境变量文件 /etc/profile, 添加以下内容

export SPARK_HOME=/usr/hadoop-2.6./thirdparty/spark-1.6.-bin-hadoop2.

export PATH=$PATH:$SPARK_HOME/bin

source 使之生效

$ source /etc/profile

Spark 配置

进入 Spark 安装目录下的 conf 目录, 拷贝 spark-env.sh.template 到 spark-env.sh

$ cp spark-env.sh.template spark-env.sh

在其中添加以下配置信息:

export SCALA_HOME=/usr/hadoop-2.6./thirdparty/scala-2.10.

export JAVA_HOME=/usr/java/jdk1..0_101

export HADOOP_HOME=/usr/hadoop-2.6.

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export SPARK_MASTER_IP=192.168.23.101

export SPARK_LOCAL_DIRS=/usr/hadoop-2.6./thirdparty/spark-1.6.-bin-hadoop2.

export SPARK_WORKER_MEMORY=512m

JAVA_HOME 指定 Java 安装目录;

SCALA_HOME 指定 Scala 安装目录;

SPARK_MASTER_IP 指定 Spark 集群 Master 节点的 IP 地址;

SPARK_WORKER_MEMORY 指定的是 Worker 节点能够分配给 Executors 的最大内存大小;

HADOOP_CONF_DIR 指定 Hadoop 集群配置文件目录。

SPARK_WORKER_MEMORY 根据主机内存设置spark运行内存大小。

slaves

将 slaves.template 拷贝到 slaves

$ sudo cp slaves.template slaves

编辑其内容为

master

slave1

设置spark安装目录的所有组/用户:

$ sudo chown -R hadoop:hadoop spark-1.6.-bin-hadoop2.

slave1参照 master 机器安装步骤进行安装。

启动 Spark 集群

启动 Hadoop 集群

$ start-dfs.sh

启动 Spark 集群

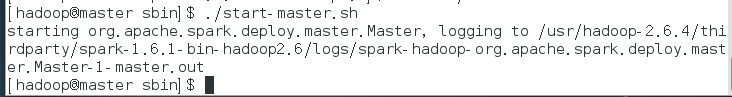

启动 Master 节点

运行 $SPARK_HOME/sbin 下面, start-master.sh

jps查看进程,多了一个Master进程

启动所有 Worker 节点

运行 $SPARK_HOME/sbin 下面,start-slaves.sh

jps查看进程,可以发现多了一个Work进程。

(由于虚拟机性能较差,因此后续步骤未实际验证,仅供参考)

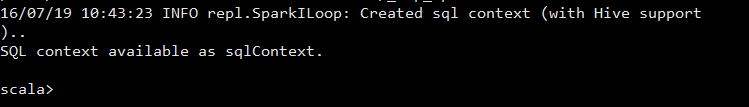

运行 spark-shell,可以进入 Spark 的 shell 控制台

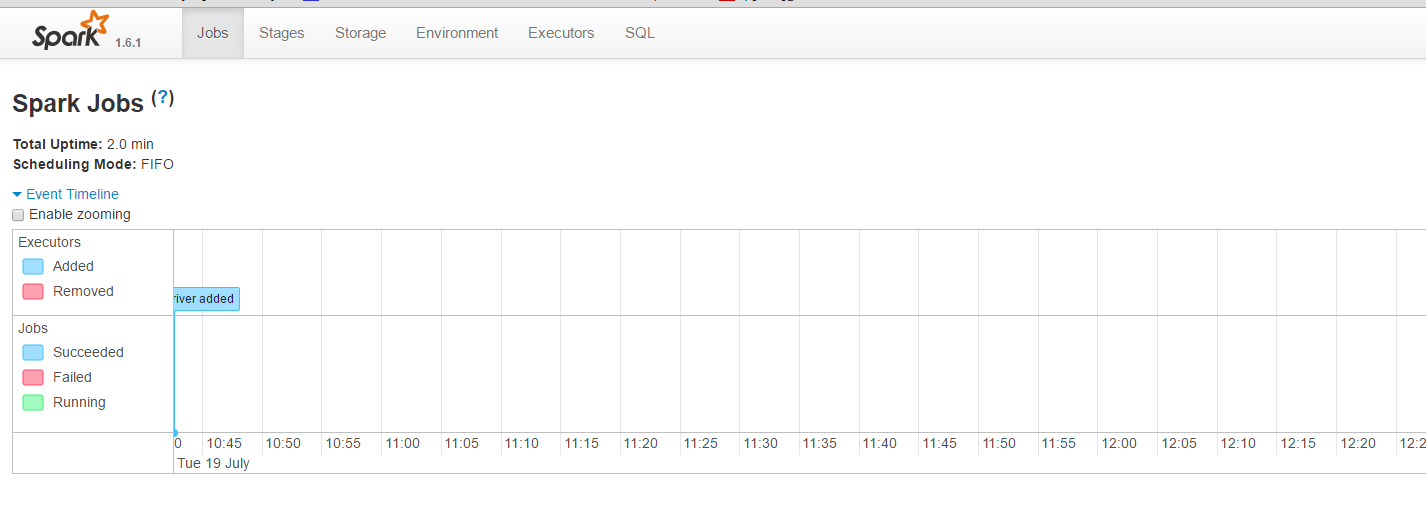

浏览器访问 SparkUI

可以从 SparkUI 上查看一些 如环境变量、Job、Executor等信息。

至此,整个 Spark 分布式集群的搭建就到这里结束。

停止 Spark 集群

停止 Master 节点

运行$SPARK_HOME/sbin,下面的stop-master.sh 来停止 Master 节点。

停止 Slaves 节点

运行$SPARK_HOME/sbin,下面的stop-slaves.sh (注意是stop-slavers 有s) 可以停止所有的 Worker 节点

最后再停止 Hadoop 集群。

原文地址:http://blog.csdn.net/sa14023053/article/details/51953836

CentOS7+hadoop2.6.4+spark-1.6.1的更多相关文章

- Linux上安装Hadoop集群(CentOS7+hadoop-2.8.0)

1下载hadoop 2安装3个虚拟机并实现ssh免密码登录 2.1安装3个机器 2.2检查机器名称 2.3修改/etc/hosts文件 2.4 给3个机器生成秘钥文件 2.5 在hserver1上创建 ...

- Linux上安装Hadoop集群(CentOS7+hadoop-2.8.3)

https://blog.csdn.net/pucao_cug/article/details/71698903 1下载hadoop 2安装3个虚拟机并实现ssh免密码登录 2.1安装3个机器 2.2 ...

- Linux上安装Hadoop集群(CentOS7+hadoop-2.8.0)--------hadoop环境的搭建

Linux上安装Hadoop集群(CentOS7+hadoop-2.8.0)------https://blog.csdn.net/pucao_cug/article/details/71698903 ...

- 在虚拟机下安装hadoop集成环境(centos7+hadoop-2.6.4+jdk-7u79)

[1]64为win7系统,用virtualbox建立linux虚拟机时,为什么没有64位的选项? 百度 [2]在virtualbox上安装centos7 [3]VirtualBox虚拟机网络环境解析和 ...

- centos7安装Scala、Spark(伪分布式)

centos7安装spark(伪分布式) spark是由scala语言开发的,首先需要安装scala. Scala安装 下载scala-2.11.8,(与spark版本要对应) 命令:wget htt ...

- CentOS7+Hadoop2.7.2(HA高可用+Federation联邦)+Hive1.2.1+Spark2.1.0 完全分布式集群安装

1 2 2.1 2.2 2.3 2.4 2.5 2.6 2.7 2.8 2.9 2.9.1 2.9.2 2.9.2.1 2.9.2.2 2.9.3 2.9.3.1 2.9.3.2 2.9.3.3 2. ...

- Hadoop2.0/YARN深入浅出(Hadoop2.0、Spark、Storm和Tez)

随着云计算.大数据迅速发展,亟需用hadoop解决大数据量高并发访问的瓶颈.谷歌.淘宝.百度.京东等底层都应用hadoop.越来越多的企 业急需引入hadoop技术人才.由于掌握Hadoop技术的开发 ...

- Centos7+hadoop2.7.3+jdk1.8

修改主机名 1. 修改主机名 vi /etc/sysconfig/network ,改为 master , slave1 , slave2 2. source /etc/sy ...

- Linux中基于hadoop安装hive(CentOS7+hadoop2.8.0+hive2.1.1)

http://blog.csdn.net/pucao_cug/article/details/71773665

随机推荐

- Cadence 建立封装:多个引脚于芯片内部连接的封装建立方式

Ti 家有一种片子,型号为CSD19534Q5A.此芯片的外观样式如图: 可以看到,这个片子共有8个引脚,其中5.6.7和8这四个引脚的内部是连接在一起的. Ti 在数据手册中也介绍了封装的样式: 下 ...

- Beta版本冲刺———第一天

会议照片: 项目燃尽图: 1.项目进展: 昨天的困难:对2048项目中方块颜色的调整 今天解决的进度:调整了方块的颜色,原来用UIColor.(颜色名)color颜色效果不是很好,现在改用了RGB调色 ...

- iOS常用---NSString,NSMutabuleString

普通的创建字符串: NSString *string =[[NSString alloc]init]; //创建一个空的字符串,即 @“” 一 .字符串读取本地文件: 参数一: 文件地址 参数二: 文 ...

- OkHttp 3.4入门

OkHttp 3.4入门 配置方法 (一)导入Jar包http://repo1.maven.org/maven2/com/squareup/okhttp3/okhttp/3.4.0-RC1/okhtt ...

- C/C++中NULL的涵义

参考:百度知道NULL表示空指针,用于表示一个无效的指针,它的值为0(早期C语言的实现中可能有非0空指针,现在已经不用).对指针置NULL即标记指针无效,避免“野指针”的恶果.NULL在C/C++标准 ...

- 【BZOJ 3527】【ZJOI 2014】力

代换一下变成多项式卷积,这里是的答案是两个卷积相减,FFT求一下两个卷积就可以啦 详细的题解:http://www.cnblogs.com/iwtwiioi/p/4126284.html #inclu ...

- PCA算法是怎么跟协方差矩阵/特征值/特征向量勾搭起来的?

PCA, Principle Component Analysis, 主成份分析, 是使用最广泛的降维算法. ...... (关于PCA的算法步骤和应用场景随便一搜就能找到了, 所以这里就不说了. ) ...

- java学习笔记--java中的基本数组[5]

java基础很重要, 今天呆家看java视频,顺便总结前几周看的java书籍,做一下简单的总结:1:数组的声明,2:数组的赋值: 3:数组的方法: 声明一个数组主要有两种方式: //类型 []数组名字 ...

- js-延迟处理函数

<script type="text/javascript"> var i = setTimeout('check()',5000); function check() ...

- TCP连接——爱的传声筒

TCP连接——爱的传声筒 TCP通信最重要的特征是:有序(ordering)和可靠(reliable).有序是通过将文本流分段并编号实现的.可靠是通过ACK回复和重复发送(retransmission ...