深度学习tensorflow实战笔记(2)图像转换成tfrecords和读取

1、准备数据

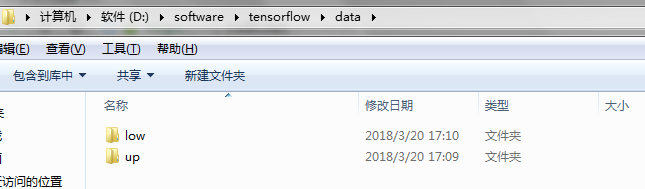

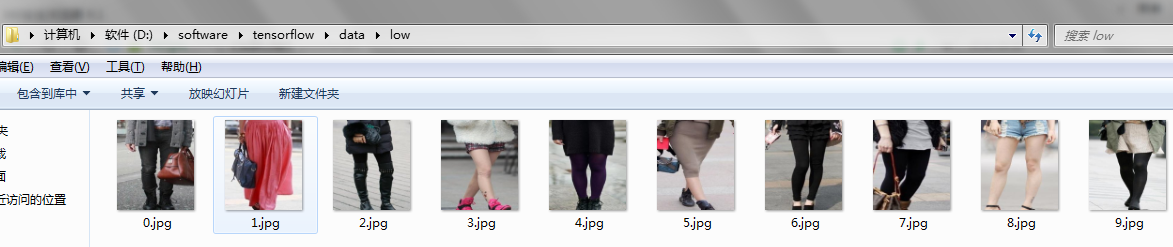

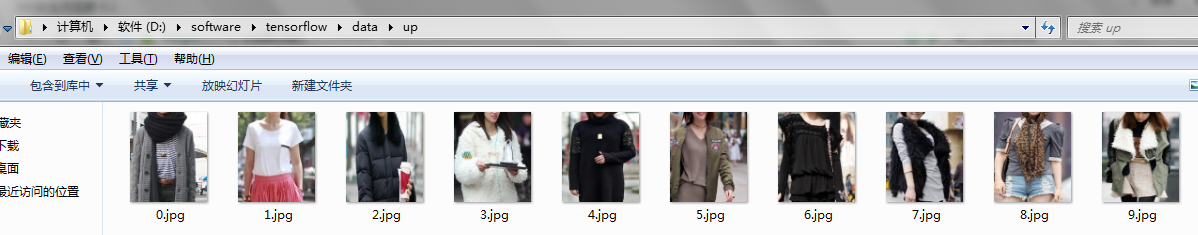

首选将自己的图像数据分类分别放在不同的文件夹下,比如新建data文件夹,data文件夹下分别存放up和low文件夹,up和low文件夹下存放对应的图像数据。也可以把up和low文件夹换成0和1。根据自己数据类别,自己设定。如图所示

以上三张图片注意看目录。这样数据就准备好了。

2、将图像数据转换成tfrecords

import os

import tensorflow as tf

from PIL import Image

import matplotlib.pyplot as plt

import numpy as np sess=tf.InteractiveSession()

cwd = "D://software//tensorflow//data//" #数据所在目录位置

classes = {'up', 'low'} #预先自己定义的类别,根据自己的需要修改

writer = tf.python_io.TFRecordWriter("train.tfrecords") #train表示转成的tfrecords数据格式的名字 for index, name in enumerate(classes):

class_path = cwd + name + "/"

for img_name in os.listdir(class_path):

img_path = class_path + img_name

img = Image.open(img_path)

img = img.resize((300, 300)) #图像reshape大小设置,根据自己的需要修改

img_raw = img.tobytes()

example = tf.train.Example(features=tf.train.Features(feature={

"label": tf.train.Feature(int64_list=tf.train.Int64List(value=[index])),

'img_raw': tf.train.Feature(bytes_list=tf.train.BytesList(value=[img_raw]))

}))

writer.write(example.SerializeToString())

writer.close()

3、从tfrecords中读取数据

直接上代码:

#读取文件

def read_and_decode(filename,batch_size):

#根据文件名生成一个队列

filename_queue = tf.train.string_input_producer([filename])

reader = tf.TFRecordReader()

_, serialized_example = reader.read(filename_queue) #返回文件名和文件

features = tf.parse_single_example(serialized_example,

features={

'label': tf.FixedLenFeature([], tf.int64),

'img_raw' : tf.FixedLenFeature([], tf.string),

}) img = tf.decode_raw(features['img_raw'], tf.uint8)

img = tf.reshape(img, [300, 300, 3]) #图像归一化大小

# img = tf.cast(img, tf.float32) * (1. / 255) - 0.5 #图像减去均值处理,根据自己的需要决定要不要加上

label = tf.cast(features['label'], tf.int32) #特殊处理,去数据的batch,如果不要对数据做batch处理,也可以把下面这部分不放在函数里 img_batch, label_batch = tf.train.shuffle_batch([img, label],

batch_size= batch_size,

num_threads=64,

capacity=200,

min_after_dequeue=150)

return img_batch, tf.reshape(label_batch,[batch_size])

需要注意的地方:

img = tf.cast(img, tf.float32) * (1. / 255) - 0.5 #图像减去均值处理,根据自己的需要决定要不要加上

#特殊处理,去数据的batch,如果不要对数据做batch处理,也可以把下面这部分不放在函数里

img_batch, label_batch = tf.train.shuffle_batch([img, label],

batch_size= batch_size,

num_threads=64,

capacity=200,

min_after_dequeue=150)

如果不需要把数据做batch处理,则函数的第二个形参batch_size就去掉,函数直接返回img和label。也可以把batch处理部分放在函数外面,根据自己的需要自己修改一下。

4、转换和读取函数的调用

tfrecords_file = 'train.tfrecords' #要读取的tfrecords文件

BATCH_SIZE = 4 #batch_size的大小

image_batch, label_batch = read_and_decode(tfrecords_file,BATCH_SIZE)

print(image_batch,label_batch) #注意,这里不是tensor,tensor需要做see.run()处理

下面就定义session,执行即可,有一个地方需要注意,

image_batch, label_batch = read_and_decode(tfrecords_file,BATCH_SIZE) #需要注意

虽然能够把数据读取出来,但是不是tensor,在训练的时候需要image,label=sess.run([image_batch,label_batch])处理后,才能投入训练。具体细节下一篇博客再做详细介绍。

如果还有问题未能得到解决,搜索887934385交流群,进入后下载资料工具安装包等。最后,感谢观看!

深度学习tensorflow实战笔记(2)图像转换成tfrecords和读取的更多相关文章

- 深度学习tensorflow实战笔记(1)全连接神经网络(FCN)训练自己的数据(从txt文件中读取)

1.准备数据 把数据放进txt文件中(数据量大的话,就写一段程序自己把数据自动的写入txt文件中,任何语言都能实现),数据之间用逗号隔开,最后一列标注数据的标签(用于分类),比如0,1.每一行表示一个 ...

- 深度学习tensorflow实战笔记 用预训练好的VGG-16模型提取图像特征

1.首先就要下载模型结构 首先要做的就是下载训练好的模型结构和预训练好的模型,结构地址是:点击打开链接 模型结构如下: 文件test_vgg16.py可以用于提取特征.其中vgg16.npy是需要单独 ...

- 深度学习-tensorflow学习笔记(1)-MNIST手写字体识别预备知识

深度学习-tensorflow学习笔记(1)-MNIST手写字体识别预备知识 在tf第一个例子的时候需要很多预备知识. tf基本知识 香农熵 交叉熵代价函数cross-entropy 卷积神经网络 s ...

- 深度学习-tensorflow学习笔记(2)-MNIST手写字体识别

深度学习-tensorflow学习笔记(2)-MNIST手写字体识别超级详细版 这是tf入门的第一个例子.minst应该是内置的数据集. 前置知识在学习笔记(1)里面讲过了 这里直接上代码 # -*- ...

- 深度学习入门实战(二)-用TensorFlow训练线性回归

欢迎大家关注腾讯云技术社区-博客园官方主页,我们将持续在博客园为大家推荐技术精品文章哦~ 作者 :董超 上一篇文章我们介绍了 MxNet 的安装,但 MxNet 有个缺点,那就是文档不太全,用起来可能 ...

- 深度学习Tensorflow相关书籍推荐和PDF下载

深度学习Tensorflow相关书籍推荐和PDF下载 baihualinxin关注 32018.03.28 10:46:16字数 481阅读 22,673 1.机器学习入门经典<统计学习方法&g ...

- 深度学习Keras框架笔记之AutoEncoder类

深度学习Keras框架笔记之AutoEncoder类使用笔记 keras.layers.core.AutoEncoder(encoder, decoder,output_reconstruction= ...

- 深度学习Keras框架笔记之TimeDistributedDense类

深度学习Keras框架笔记之TimeDistributedDense类使用方法笔记 例: keras.layers.core.TimeDistributedDense(output_dim,init= ...

- 深度学习Keras框架笔记之Dense类(标准的一维全连接层)

深度学习Keras框架笔记之Dense类(标准的一维全连接层) 例: keras.layers.core.Dense(output_dim,init='glorot_uniform', activat ...

随机推荐

- http post 请求,带参数,带请求头

#!/usr/bin/env python # -*- coding: utf-8 -*- import requests import json url = 'http://............ ...

- QR 码详解(下)

快速响应矩阵码(下) 书接上回,继续下半场. 纠错码 QR 码采用纠错算法生成一系列纠错码字,添加在数据码字序列之后,使得符号可以在遇到损坏时可以恢复.这就是为什么二维码即使有残缺也可以扫出来.没有残 ...

- BZOJ 4597: [Shoi2016]随机序列

4597: [Shoi2016]随机序列 Time Limit: 20 Sec Memory Limit: 256 MBSubmit: 255 Solved: 174[Submit][Status ...

- 尹吉峰:使用 OpenResty 搭建高性能 Web 应用

2019 年 8 月 31 日,OpenResty 社区联合又拍云,举办 OpenResty × Open Talk 全国巡回沙龙·成都站,原贝壳找房基础架构部工程师尹吉峰在活动上做了<使用 O ...

- 第10项:重写equals时请遵守通用约定

重写equals方法看起来似乎很简单,但是有许多重写方式会导致错误,而且后果非常严重.最容易避免这类问题的办法就是不覆盖equals方法,在这种情况下,类的每个实例都只能与它自身相等.如果满足了以 ...

- Be Nice!要善良

[1] It is nice to be important, but it is more important to be nice. [2] What simple act of kindne ...

- Python3实用编程技巧进阶 ☝☝☝

Python3实用编程技巧进阶 ☝☝☝ 1.1.如何在列表中根据条件筛选数据 # 1.1.如何在列表中根据条件筛选数据 data = [-1, 2, 3, -4, 5] #筛选出data列表中大于等 ...

- CH3801Rainbow的信号

Description Freda发明了传呼机之后,rainbow进一步改进了传呼机发送信息所使用的信号.由于现在是数字.信息时代,rainbow发明的信号用N个自然数表示.为了避免两个人的对话被大坏 ...

- 从.NET CORE2.2升级到3.0过程及遇到的一些问题

RoadFlow工作流引擎从.NET Core2.2升级到3.0遇到了一些问题及解决方式这里记录一下. 1.DLL项目框架从2.2选择到3.0,这个没什么好说的,没有问题.重点的WEB层的一些变化. ...

- 【干货系列之萌新知识点】python与变量和运算符

一.注释 注释一行:# 为注释符 注释多行:'或者"为注释符 二.print输出 print()函数,作用是打印一些信息语屏幕上. 例如:print("hello world!&q ...