基于服务器版centos7的Hadoop/spark搭建

前提说明:

1.Hadoop与spark是两个独立的框架,只安装spark也可独立运行,spark有自己的调度器(standalone模式);

2.在Hadoop的基础上安装spark就是为了使用yarn调度器与Hadoop的hdfs存储;

3.如果你只想安装spark,可不用看Hadoop的安装,并不影响spark的安装与使用。

4.并不需要单独安装scala,因为spark之中已经集成了Scala(如果想要对应的版本也可以自己安装)

我的安装环境:

centos7服务器版、jdk8、hadoop2.7.4、spark2.4.0(请自行下载到所有节点Linux虚拟机中)(我没有使用克隆虚拟机的方式)

虚拟机数量:3(master、slave、slave)

实体机:win10

一.前期环境的配置

1.IP配置

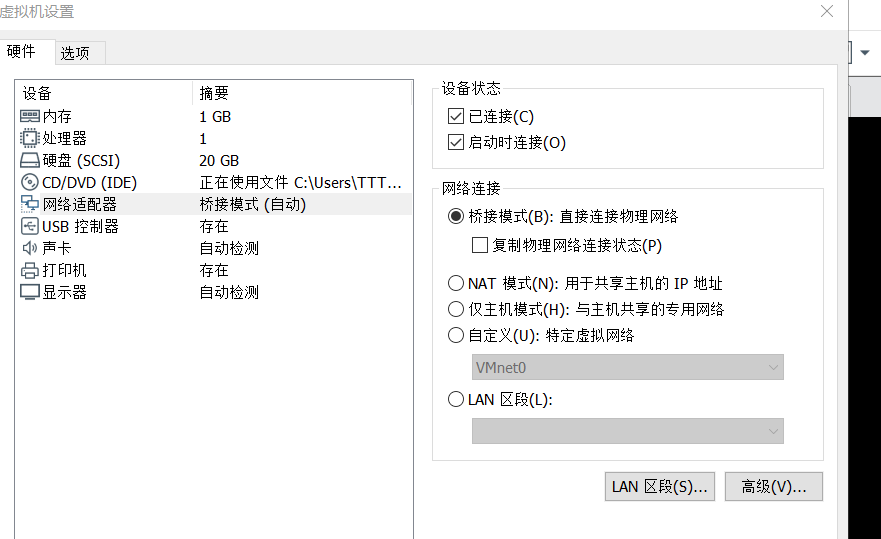

1.1虚拟机网络设置

三台虚拟机均要设置成桥接模式,不然无法使用外部浏览器访问虚拟机,虽然能ping通并且ssh能够连接上

1.2静态IP配置

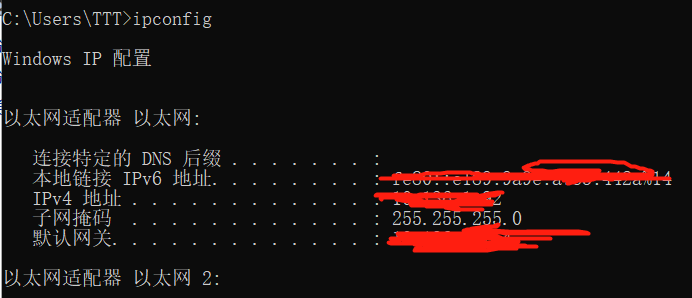

注:1.实体机在连接网线与wlan模式下IP不同,请在一种网络连接下配置(我的是在连接网线状态下)

2.如果不配置静态IP,在桥接模式下IP会自动获取,在后期无法使用

(1)首先在实体机中的cmd中查看并己住本机ip、网关、子掩网码:

(2)使用命令:ipconfig

(3)根据以上信息填写如下文件:

sudo vi /etc/sysconfig/network-scripts/ifcfg-ens33(有的是ifcfg-eno16777736文件)

改成如下:

2.1接下来按照如下链接进行

https://www.linuxidc.com/Linux/2018-06/152795.htm

注:在链接中的2.3中:

scp -r /usr/local/hadoop-2.6.5 root@hadoop2:/usr/local/

scp -r /usr/local/hadoop-2.6.5 root@hadoop3:/usr/local/

链接作者是使用root用户进行安装配置的,没有问题,但是就像我使用非root进行root进行安装的,所以后期启动hadoop\spark会报权限错误,可使用如下方法进行更改目录所属用户权限:

chown -R user /usr/local/hadoop-2.7.4

同样,配置spark时也是一样

按照链接进行配置,亲测可行,虽然系统有所差异,但是不大,皆可百度、谷歌解决。

感谢链接作者,非常详尽!

基于服务器版centos7的Hadoop/spark搭建的更多相关文章

- 基本环境安装: Centos7+Java+Hadoop+Spark+HBase+ES+Azkaban

1. 安装VM14的方法在 人工智能标签中的<跨平台踩的大坑有提到> 2. CentOS分区设置: /boot:1024M,标准分区格式创建. swap:4096M,标准分区格式创建. ...

- centos7 hdfs yarn spark 搭建笔记

1.搭建3台虚拟机 2.建立账户及信任关系 3.安装java wget jdk-xxx rpm -i jdk-xxx 4.添加环境变量(全部) export JAVA_HOME=/usr/java/j ...

- 基于腾讯Centos7云服务器搭建SVN版本控制库

基于腾讯Centos7云服务器搭建SVN版本控制库 最近在和小伙伴组队参加一个关于人工智能的比赛,无奈不知道怎么处理好每个人的代码托管问题,于是找到了晚上免费svn托管服务器的服务,但是所给的免费空间 ...

- 大数据项目实践:基于hadoop+spark+mongodb+mysql+c#开发医院临床知识库系统

一.前言 从20世纪90年代数字化医院概念提出到至今的20多年时间,数字化医院(Digital Hospital)在国内各大医院飞速的普及推广发展,并取得骄人成绩.不但有数字化医院管理信息系统(HIS ...

- 大数据学习系列之六 ----- Hadoop+Spark环境搭建

引言 在上一篇中 大数据学习系列之五 ----- Hive整合HBase图文详解 : http://www.panchengming.com/2017/12/18/pancm62/ 中使用Hive整合 ...

- 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

引言 在之前的大数据学习系列中,搭建了Hadoop+Spark+HBase+Hive 环境以及一些测试.其实要说的话,我开始学习大数据的时候,搭建的就是集群,并不是单机模式和伪分布式.至于为什么先写单 ...

- HADOOP+SPARK+ZOOKEEPER+HBASE+HIVE集群搭建(转)

原文地址:https://www.cnblogs.com/hanzhi/articles/8794984.html 目录 引言 目录 一环境选择 1集群机器安装图 2配置说明 3下载地址 二集群的相关 ...

- CentOS7下Hadoop伪分布式环境搭建

CentOS7下Hadoop伪分布式环境搭建 前期准备 1.配置hostname(可选,了解) 在CentOS中,有三种定义的主机名:静态的(static),瞬态的(transient),和灵活的(p ...

- Hadoop+Spark:集群环境搭建

环境准备: 在虚拟机下,大家三台Linux ubuntu 14.04 server x64 系统(下载地址:http://releases.ubuntu.com/14.04.2/ubuntu-14.0 ...

随机推荐

- ZOJ 3964 Yet Another Game of Stones Nim游戏变种

ZOJ3964 解题思路 此题的题意比较容易理解,可以简单的看着 Nim 博弈的变种.但问题在于 Alice 对第 i 堆石子的取法必须根据 bi 确定.所以如果这个问题能够归结到正常的 Nim 博弈 ...

- hdu1814 Peaceful Commission——2-SAT

题目:http://acm.hdu.edu.cn/showproblem.php?pid=1814 第一次的2-SAT,推荐博客:https://blog.csdn.net/jarjingx/arti ...

- java笔记线程方式1等待终止

public final void join():等待该线程终止 public class ThreadJoinDemo { public static void main(String[] args ...

- 基于PHP自带的mail函数实现发送邮件以及带有附件的邮件功能

PHPmail函数简介 bool mail ( string $to , string $subject , string $message [, string $additional_headers ...

- spring cloud config搭建说明例子(二)-添加eureka

添加注册eureka 服务端 ConfigServer pom.xml <dependency> <groupId>org.springframework.cloud</ ...

- mysql-5.7.20基本用法

第1章 安装mysql-5.7.20 1.1 系统环境 [root@mysql ~]# cat /etc/redhat-release CentOS Linux release 7.2.1511 (C ...

- MongoDB一些常用指令与他的JavaScript的对应表

- [读书笔记3]《C语言嵌入式系统编程修炼》

第五章 性能优化 5.1 使用宏定义 在C语言中,宏是产生内嵌代码的唯一方法.对于嵌入式系统而言,为了能达到性能要求,宏是一种很好的代替函数的方法. 写一个"标准"宏MIN ...

- ORACLE_AQ 队列

Oracle AQ Demo,Step by Step 我准备用AQ来做一个数据仓库系统,提交分析任务队列.有以下需求: 1.利用通知异步的执行存储过程 2.设定队列大小极限 3.出列即删除 OK,l ...

- 动态属性ExpandoObject

1.动态创建对象及其属性ExpandoObject 查看ExpandoObject的定义: