Python网咯爬虫 — Scrapy框架应用

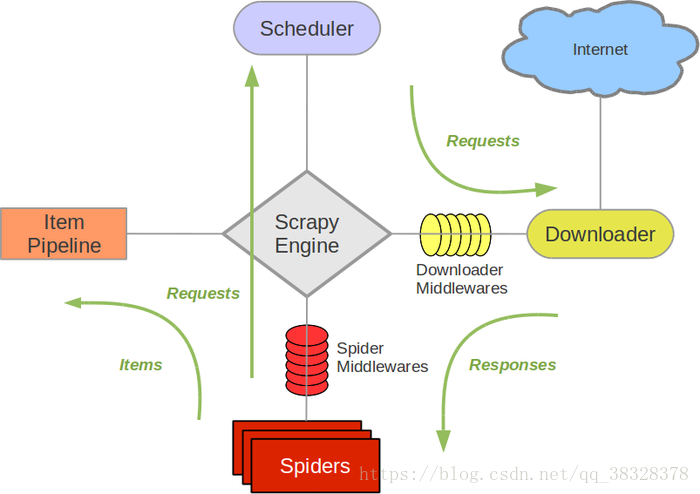

Scrapy框架

- 引擎(Scrapy)

用来处理整个系统的数据流, 触发事务(框架核心) - 调度器(Scheduler)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址 - 下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的) - 爬虫(Spiders)

爬虫是主要干活的, 用于从特定的网页中提取自己需要的信息, 即所谓的实体(Item)。用户也可以从中提取出链接,让Scrapy继续抓取下一个页面 - 项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体,主要的功能是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,将被发送到项目管道,并经过几个特定的次序处理数据。 - 下载器中间件(Downloader Middlewares)

位于Scrapy引擎和下载器之间的框架,主要是处理Scrapy引擎与下载器之间的请求及响应。 - 爬虫中间件(Spider Middlewares)

介于Scrapy引擎和爬虫之间的框架,主要工作是处理蜘蛛的响应输入和请求输出。 - 调度中间件(Scheduler Middewares)

介于Scrapy引擎和调度之间的中间件,从Scrapy引擎发送到调度的请求和响应。

Scrapy运行流程

Scrapy运行流程大概如下:

1)引擎从调度器中取出一个链接(URL)用于接下来的抓取;

2)引擎把URL封装成一个请求(Request)传给下载器;

3)下载器把资源下载下来,并封装成应答包(Response);

4)爬虫解析Response;

5)解析出实体(Item),则交给实体管道进行进一步的处理;

6)解析出的是链接(URL),则把URL交给调度器等待抓取。

Scrapy的安装

首先在cmd命令行中安装Scrapy

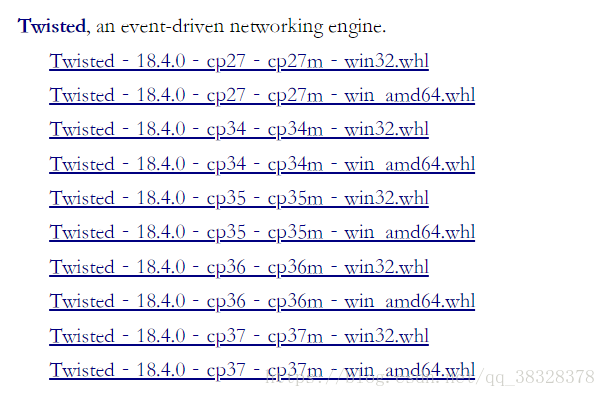

pip install scrapy在Windows安装是可能会出现错误,提示找不到Microsoft Visual C++,需要安装Twisted 。

error: Microsoft Visual C++ 14.0 is required. Get it with "Microsoft Visual C++ Build Tools": http://landinghub.visualstudio.com/visual-cpp-build-tools

Twisted的安装:

pip install E:\Downloads\Twisted-18.4.0-cp36-cp36m-win_amd64.whl最后再安装Scrapy。

Scrapy常用命令

| 命令 | 说明 | 格式 |

| startproject | 创建一个新工程 | Scrapy startproject 项目名 |

| genspider | 创建一个爬虫 | Scrapy genspider 项目名 域名 |

| settings | 获取爬虫配置信息 | Scrapy settings |

| crawl | 运行一个爬虫 | Scrapy crawl 项目名 |

| list | 列出工程所有爬虫 | Scrapy list |

| shell | 启动URL调试命令行 | Scrapy shell [url] |

| edit | 编辑爬虫文件 | Scrapy edit 文件名 |

注意:一般创建爬虫文件时,以网站域名命名

项目创建

项目创建步骤:

E:\PyCodes\scrapy startproject myprojectE:\PyCodes\myproject\scrapy genspider mydome mydome.com步骤3:配置产生的spider爬虫

# -*- coding:utf-8 -*-

import scrapy

class MydemoSpider(scrapy.Spider):

name = "mydemo"

allowd_domains = ["http://mydome.com"]

start_url = ['http://python123.io/ws/dome.html']

def parse(self, response):

passE:\PyCodes\myproject\scrapy crawl mydome生成的项目结构:

myproject/ -------外层目录

scrapy.cfg -------项目的配置文件

myproject/ -------该项目的python模块。之后您将在此加入代码。

__init__.py -------初始化脚本

items.py -------item代码模块(继承类)

middlewares.py -------Middlewares代码模板(继承类)

pipelines.py -------Pipelines代码模板(继承类)

settings.py -------Scrapy爬虫的配置文件

spiders/ -------Spiders代码模板目录(继承类)

__init__.py -------初始文件,无需修改

__init__.py -------缓存目录,无需修改Python网咯爬虫 — Scrapy框架应用的更多相关文章

- python爬虫scrapy框架——人工识别登录知乎倒立文字验证码和数字英文验证码(2)

操作环境:python3 在上一文中python爬虫scrapy框架--人工识别知乎登录知乎倒立文字验证码和数字英文验证码(1)我们已经介绍了用Requests库来登录知乎,本文如果看不懂可以先看之前 ...

- 爬虫scrapy框架之CrawlSpider

爬虫scrapy框架之CrawlSpider 引入 提问:如果想要通过爬虫程序去爬取全站数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模 ...

- 安装爬虫 scrapy 框架前提条件

安装爬虫 scrapy 框架前提条件 (不然 会 报错) pip install pypiwin32

- 爬虫Ⅱ:scrapy框架

爬虫Ⅱ:scrapy框架 step5: Scrapy框架初识 Scrapy框架的使用 pySpider 什么是框架: 就是一个具有很强通用性且集成了很多功能的项目模板(可以被应用在各种需求中) scr ...

- Python爬虫 ---scrapy框架初探及实战

目录 Scrapy框架安装 操作环境介绍 安装scrapy框架(linux系统下) 检测安装是否成功 Scrapy框架爬取原理 Scrapy框架的主体结构分为五个部分: 它还有两个可以自定义下载功能的 ...

- python爬虫scrapy框架

Scrapy 框架 关注公众号"轻松学编程"了解更多. 一.简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量 ...

- Python爬虫Scrapy框架入门(2)

本文是跟着大神博客,尝试从网站上爬一堆东西,一堆你懂得的东西 附上原创链接: http://www.cnblogs.com/qiyeboy/p/5428240.html 基本思路是,查看网页元素,填写 ...

- Python爬虫Scrapy框架入门(1)

也许是很少接触python的原因,我觉得是Scrapy框架和以往Java框架很不一样:它真的是个框架. 从表层来看,与Java框架引入jar包.配置xml或.property文件不同,Scrapy的模 ...

- python学习之-用scrapy框架来创建爬虫(spider)

scrapy简单说明 scrapy 为一个框架 框架和第三方库的区别: 库可以直接拿来就用, 框架是用来运行,自动帮助开发人员做很多的事,我们只需要填写逻辑就好 命令: 创建一个 项目 : cd 到需 ...

随机推荐

- [java基础原理] BigDecimal

1.类 简化示例 属于java.math包,因此包含各种数学运算,abs,pow等等. package java.math; public class BigDecimal { //值的绝对long型 ...

- Vue如何引入jquery实现平滑滚动到指定位置效果

在以往的做法里首选jquery的animate实现,但是Vue里并没有这个方法.如何在Vue项目中实现点击导航平滑滚动到指定位置,为了这效果我是快要崩溃了,上网查阅了很久发现并没有真正意义上解决这个问 ...

- 关于Web服务接口测试的一些问题及答案

本篇主要是像想要了解并且学习接口测试的朋友,做一个入门的简单介绍 1.什么是接口 答:接口就是内部模块对模块,外部系统对其他服务提供的一种可调用或者连接的能力的标准,就好比usb接口,他是系统向外接提 ...

- Linux学习笔记01

1.Linux不靠扩展名区分文件类型2.存储设备必须先挂载才能使用3.Windows下的程序不能直接在Linux中安装和运行 一.服务器的管理预配置Linux的目录的作用:/bin/存放系统命令的目录 ...

- spark streaming 踩过的那些坑

系统背景 spark streaming + Kafka高级API receiver 目前资源分配(现在系统比较稳定的资源分配),独立集群 --driver-memory 50G --exec ...

- [codeforces471D]MUH and Cube Walls

[codeforces471D]MUH and Cube Walls 试题描述 Polar bears Menshykov and Uslada from the zoo of St. Petersb ...

- 食物(bzoj 3280)

Description 明明这次又要出去旅游了,和上次不同的是,他这次要去宇宙探险! 我们暂且不讨论他有多么NC,他又幻想了他应该带一些什么东西.理所当然的,你当然要帮他计算携带N件物品的方案数. 他 ...

- Kafka 生产消费 Avro 序列化数据

https://unmi.cc/kafka-produce-consume-avro-data/ https://unmi.cc/apache-avro-serializing-deserializi ...

- n个点中求任意两点组成斜率的最大值

http://www.51nod.com/onlineJudge/questionCode.html#!problemId=1100 首先按x坐标排序,然后相邻的三个点A,B,C 组成的三条直线必然有 ...

- 【小记事】电脑命令行开WiFi

1.设置WiFi名称和密码 在命令行输入: netsh wlan set hostednetwork mode=allow WiFi名称 key=密码 2.开启WiFi 在命令行输入: netsh w ...