Scrapy-redis分布式爬虫爬取豆瓣电影详情页

平时爬虫一般都使用Scrapy框架,通常都是在一台机器上跑,爬取速度也不能达到预期效果,数据量小,而且很容易就会被封禁IP或者账号,这时候可以使用代理IP或者登录方式爬,然而代理IP很多时候都很鸡肋,除非使用付费版IP,但是和真实IP差别很大。这时候便有了Scrapy-redis分布式爬虫框架,它基于Scrapy改造,把Scrapy的调度器(scheduler)换成了Scrapy-redis的调度器,可以轻松达到目的,利用多台服务器来爬取数据,而且还可以自动去重,效率高。爬取的数据默认保存在redis缓存中,速度很快。

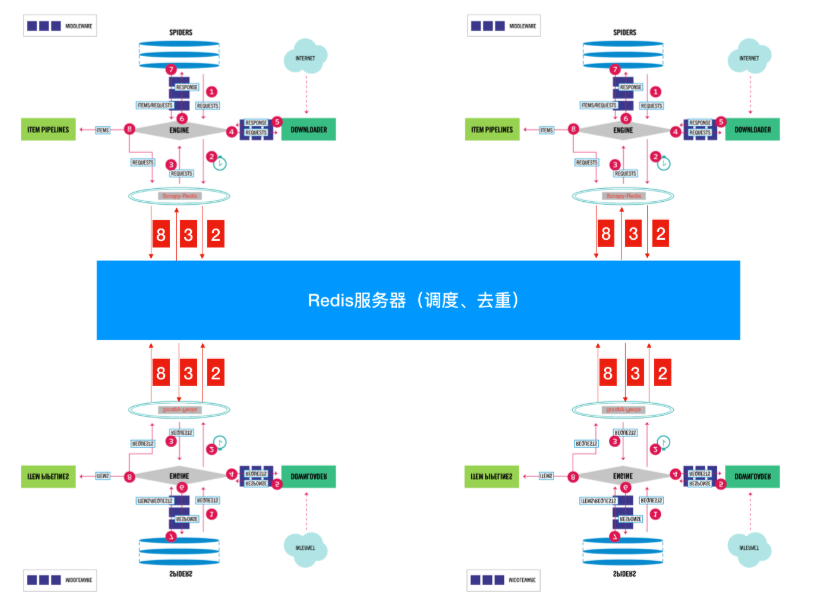

Scrapy工作原理:

Scrapy-redis工作原理:

中间的就是调度器

豆瓣电影简易分布式爬虫

我这里直接使用start_urls的方式,数据存入到Mysql中

class DoubanSpider(RedisSpider):

name = 'douban'

redis_key = 'douban:start_urls'

allowed_domains = ['douban.com']

def start_requests(self):

urls = get_urls()

for url in urls:

yield scrapy.Request(url=url, callback=self.parse)

def parse(self, response):

# item_loader = MovieItemLoader(item=MovieItem, response=response)

#

# item_loader.add_xpath('title', '')

item = MovieItem()

print(response.url)

item['movieId'] = int(response.url.split('subject/')[1].replace('/', ''))

item['title'] = response.xpath('//h1/span/text()').extract()[0]

item['year'] = response.xpath('//h1/span/text()').extract()[1].split('(')[1].split(')')[0] or '2019'

item['url'] = response.url

item['cover'] = response.xpath('//a[@class="nbgnbg"]/img/@src').extract()[0]

try:

item['director'] = response.xpath('//a[@rel="v:directedBy"]/text()').extract()[0] or '无'

except Exception:

item['director'] = '暂无'

item['major'] = '/'.join(response.xpath('//a[@rel="v:starring"]/text()').extract())

item['category'] = ','.join(response.xpath('//span[@property="v:genre"]/text()').extract())

item['time'] = ','.join(response.xpath('//span[@property="v:initialReleaseDate"]/text()').extract())

try:

item['duration'] = response.xpath('//span[@property="v:runtime"]/text()').extract()[0]

except Exception:

item['duration'] = '暂无'

item['score'] = response.xpath('//strong[@property="v:average"]/text()').extract()[0]

item['comment_nums'] = response.xpath('//span[@property="v:votes"]/text()').extract()[0] or 0

item['desc'] = response.xpath('//span[@property="v:summary"]/text()').extract()[0].strip()

actor_list = response.xpath('//ul[@class="celebrities-list from-subject __oneline"]/li/a/@title').extract()

actor_img_list = response.xpath('//ul[@class="celebrities-list from-subject __oneline"]/li/a/div/@style').extract()

actor_img_list = [i.split('url(')[1].replace(')', '') for i in actor_img_list]

item['actor_name_list'] = '----'.join(actor_list)

item['actor_img_list'] = '----'.join(actor_img_list)

yield item

settings.py文件

BOT_NAME = 'MovieSpider'

SPIDER_MODULES = ['MovieSpider.spiders']

NEWSPIDER_MODULE = 'MovieSpider.spiders'

# REDIS_HOST = '127.0.0.1'

# REDIS_PORT = 6379

REDIS_URL = 'redis://username:password@xxx.xxx.xxx.xxx:6379'

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

SCHEDULER = "scrapy_redis.scheduler.Scheduler"

# Ensure all spiders share same duplicates filter through redis.

DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

ITEM_PIPELINES = {

'scrapy_redis.pipelines.RedisPipeline': 300,

'MovieSpider.pipelines.MysqlPipeline': 200,

}

这里只是为了多台服务器一起爬取,没有手动在redis中推入起始的URL

此时将爬虫项目上传到其他服务器上,一起开始

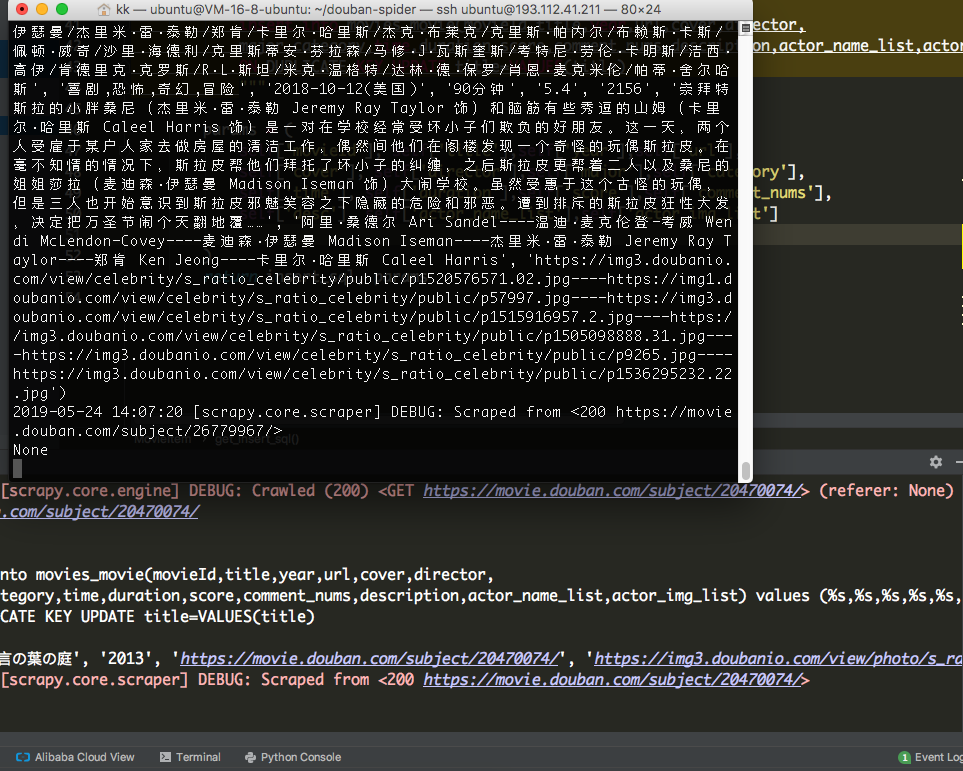

效果如下:

Scrapy-redis分布式爬虫爬取豆瓣电影详情页的更多相关文章

- Scrapy中用xpath/css爬取豆瓣电影Top250:解决403HTTP status code is not handled or not allowed

好吧,我又开始折腾豆瓣电影top250了,只是想试试各种方法,看看哪一种的方法效率是最好的,一直进行到这一步才知道 scrapy的强大,尤其是和selector结合之后,速度飞起.... 下面我就采用 ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块

工具:Python 3.6.5.PyCharm开发工具.Windows 10 操作系统.谷歌浏览器 目的:爬取豆瓣电影排行榜中电影的title.链接地址.图片.评价人数.评分等 网址:https:// ...

- python爬取豆瓣电影第一页数据and使用with open() as读写文件

# _*_ coding : utf-8 _*_ # @Time : 2021/11/2 9:58 # @Author : 秋泊酱 # @File : 获取豆瓣电影第一页 # @Project : 爬 ...

- python3 爬虫---爬取豆瓣电影TOP250

第一次爬取的网站就是豆瓣电影 Top 250,网址是:https://movie.douban.com/top250?start=0&filter= 分析网址'?'符号后的参数,第一个参数's ...

- Python爬虫爬取豆瓣电影名称和链接,分别存入txt,excel和数据库

前提条件是python操作excel和数据库的环境配置是完整的,这个需要在python中安装导入相关依赖包: 实现的具体代码如下: #!/usr/bin/python# -*- coding: utf ...

- python爬虫-爬取豆瓣电影数据

#!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:27# 文件 :spider_05.py# IDE :PyChar ...

- Python爬虫-爬取豆瓣电影Top250

#!usr/bin/env python3 # -*- coding:utf-8-*- import requests from bs4 import BeautifulSoup import re ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

随机推荐

- (转)linux正则表达式详解

linux正则表达式详解 http://blog.csdn.net/wuliowen/article/details/64131815 1:什么是正则表达式: 简单的说,正则表达式就是处理字符串的方法 ...

- Linux上的errno和strerror

部分内容参考:https://www.douban.com/note/165931644/ 在Linux的api中: errno 是记录系统的最后一次错误代码.代码是一个int型的值,在errno.h ...

- ACdream 1431——Sum vs Product——————【dfs+剪枝】

Sum vs Product Time Limit: 2000/1000MS (Java/Others) Memory Limit: 128000/64000KB (Java/Others) S ...

- Ionic 解决gradle下载慢的问题

问题 使用Ioinc添加安卓平台或者编译的时候,提示gradle-XXX-all.zip下载,此进度缓慢. 解决 下载gradle对应的zip文件. 参考资源:http://services.grad ...

- 【练习笔记】spring 配置Schedule

spring项目一些简单的定时任务可以通过@Schedule注解来实现,具体配置如下 在applicationContext.xml文件中增加配置 1.引入task约束 xmlns:task=&quo ...

- uLua学习之读取外部Lua脚本(四)

前言 上节说到了Lua脚本与unity3d中C#脚本的数据交互,但是我感觉上节中的数理方式不太好,因为我们是把Lua脚本以字符串形式粘贴到C#脚本中的,如果读取配置数据都这样做的话,那就太可怕了.想想 ...

- 关于配置httpd2.4.18+php5.6

关于httpd2.4.18下载之前一直很烦php官网上的点半天看不到下载链接,直到看到这么几句话 大意是Apache http server 不提供二进制版本,只提供源代码.....如果你不能自己编译 ...

- hbase查询语法

1.scan '表名',{FILTER=>"PrefixFilter('rowkey值')"} scan 'useractions',{FILTER=>"Pr ...

- 【强力卸载】使用Uninstall Tool卸载各类不易卸载的软件

Uninstall Tool 经测试卸载MySql5.7.18成功. 下载地址: http://files.cnblogs.com/files/xiaohi/%E3%80%90%E8%BD%AF%E4 ...

- javascript:理解DOM事件

首先,此文不讨论繁琐细节,但是考虑到读者的心灵感受,本着以积极向上的心态,在此还是会列举示例说明. 标题为理解DOM事件,那么在此拿一个简单的点击事件为例,希望大家看到这个例子后能触类旁通. DOM ...