特征值分解与奇异值分解(SVD)

1.使用QR分解获取特征值和特征向量

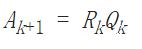

将矩阵A进行QR分解,得到正规正交矩阵Q与上三角形矩阵R。由上可知Ak为相似矩阵,当k增加时,Ak收敛到上三角矩阵,特征值为对角项。

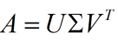

2.奇异值分解(SVD)

其中U是m×m阶酉矩阵;Σ是半正定m×n阶对角矩阵;而V*,即V的共轭转置,是n×n阶酉矩阵。

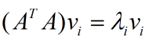

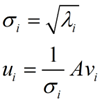

将矩阵A乘它的转置,得到的方阵可用于求特征向量v,进而求出奇异值σ和左奇异向量u。

#coding:utf8

import numpy as np

np.set_printoptions(precision=4, suppress=True) def householder_reflection(A):

"""Householder变换"""

(r, c) = np.shape(A)

Q = np.identity(r)

R = np.copy(A)

for cnt in range(r - 1):

x = R[cnt:, cnt]

e = np.zeros_like(x)

e[0] = np.linalg.norm(x)

u = x - e

v = u / np.linalg.norm(u)

Q_cnt = np.identity(r)

Q_cnt[cnt:, cnt:] -= 2.0 * np.outer(v, v)

R = np.dot(Q_cnt, R) # R=H(n-1)*...*H(2)*H(1)*A

Q = np.dot(Q, Q_cnt) # Q=H(n-1)*...*H(2)*H(1) H为自逆矩阵

return (Q, R) def eig(A, epsilon=1e-10):

'''采用QR分解法计算特征值和特征向量 '''

(q,r_)=householder_reflection(A)

h = np.identity(A.shape[0])

for i in range(50):

B=np.dot(r_,q)

h=h.dot(q)

(q,r)=gram_schmidt(B)

if abs(r.trace()-r_.trace())< epsilon:

print("Converged in {} iterations!".format(i))

break

r_=r

return r,h def svd(A):

'''奇异值分解'''

n, m = A.shape

svd_ = []

k = min(n, m)

v_=eig(np.dot(A.T, A))[1] #np.linalg.eig(np.dot(A.T, A))[1]

for i in range(k):

v=v_.T[i]

u_ = np.dot(A, v)

s = np.linalg.norm(u_)

u = u_ / s

svd_.append((s, u, v))

ss, us, vs = [np.array(x) for x in zip(*svd_)]

return us.T,ss, vs if __name__ == "__main__": mat = np.array([

[2, 5, 3],

[1, 2, 1],

[4, 1, 1],

[3, 5, 2],

[5, 3, 1],

[4, 5, 5],

[2, 4, 2],

[2, 2, 5],

], dtype='float64')

u,s,v = svd(mat)

print u

print s

print v

print np.dot(np.dot(u,np.diag(s)),v)

特征值分解与奇异值分解(SVD)的更多相关文章

- 数学基础系列(六)----特征值分解和奇异值分解(SVD)

一.介绍 特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中.而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景. 奇异值分解是一个有着很明显的物理意义的一种方法,它可 ...

- 特征值分解,奇异值分解(SVD)

特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法.两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征. 1. 特征值: 如果说一个向 ...

- matlab特征值分解和奇异值分解

特征值分解 函数 eig 格式 d = eig(A) %求矩阵A的特征值d,以向量形式存放d. d = eig(A,B) %A.B为方阵,求广义特征值d,以向量形式存放d. ...

- 讲一下numpy的矩阵特征值分解与奇异值分解

1.特征值分解 主要还是调包: from numpy.linalg import eig 特征值分解: A = P*B*PT 当然也可以写成 A = QT*B*Q 其中B为对角元为A的特征值的对 ...

- 强大的矩阵奇异值分解(SVD)及其应用

版权声明: 本文由LeftNotEasy发布于http://leftnoteasy.cnblogs.com, 本文可以被全部的转载或者部分使用,但请注明出处,如果有问题,请联系wheeleast@gm ...

- 机器学习中的数学-矩阵奇异值分解(SVD)及其应用

转自:http://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html 版权声明: 本文由LeftNotE ...

- 机器学习中的数学(5)-强大的矩阵奇异值分解(SVD)及其应用

版权声明: 本文由LeftNotEasy发布于http://leftnoteasy.cnblogs.com, 本文可以被全部的转载或者部分使用,但请注明出处,如果有问题,请联系wheeleast@gm ...

- 【ML】从特征分解,奇异值分解到主成分分析

1.理解特征值,特征向量 一个对角阵\(A\),用它做变换时,自然坐标系的坐标轴不会发生旋转变化,而只会发生伸缩,且伸缩的比例就是\(A\)中对角线对应的数值大小. 对于普通矩阵\(A\)来说,是不是 ...

- [机器学习笔记]奇异值分解SVD简介及其在推荐系统中的简单应用

本文先从几何意义上对奇异值分解SVD进行简单介绍,然后分析了特征值分解与奇异值分解的区别与联系,最后用python实现将SVD应用于推荐系统. 1.SVD详解 SVD(singular value d ...

随机推荐

- JS获取客户端Mac和IP

JS获取硬件信息是通过ActiveX进行获取的,因此只能IE浏览器支持,火狐不支持 而且必须降低浏览器安全级别,因此不到万不得以一般不会采用这种方式 <html> <head> ...

- BZOJ 2393 Cirno的完美算数教室

就是爆搜嘛. 先从大到小排个序能减去dfs树上很大的一部分.这个技巧要掌握. #include<iostream> #include<cstdio> #include<c ...

- PHP中的数组(二)常用数组处理函数

数组的相关处理函数 一.数组键/值操作有关的函数 1.array_values() 无论是关联的还是索引的返回的都是索引数组 <?php $lamp=array(&quo ...

- Unity3D ShaderLab 使用渐变纹理着色

Unity3D ShaderLab 使用渐变纹理着色 在我们编写着色器的过程中,还可以通过渐变纹理来控制漫反射的光照颜色.这种做法同样在VALVE的军团要塞2中及其流行. 前期,请准备一个渐变色的图片 ...

- 第一个Sprint冲刺第二天

讨论成员:邵家文.朱浩龙.陈俊金.李新 讨论地点:宿舍 讨论内容:安卓开发技术,与后续需要加强的内容 计时功能完成度:刚开始讨论实现的技术

- 如何在UIAlertView中显示进度条

今天这个问题是,在一个iPhone程序中,我要在后台做大量的数据处理,希望在界面上显示一个进度条(Progress Bar)使得用户了解处理进度.这个进度条应该是在一个模态的窗口中,使界 今天这个问题 ...

- 使用SCP在命令行传输文件

下载远程服务器上的文件 scp root@10.0.10.10:/home/user/download.txt ./download.txt 上传文件到远程服务器 scp ./upload.t ...

- 帝国cms缩略图:网站不同地方生成不同的缩略图

本文转自:http://blog.sina.com.cn/s/blog_4d49ba58010115sd.html 方便网站多地方调用不同尺寸的缩略图. 根据图片源,在网站任意位置生成不同大小的缩略图 ...

- 多层CCLayer的touch冲突解决

一般通过layer. setTouchPriority()方法来设置 touch优先级,数值越小,优先级越高,但有时多人开发过程中,多层layer叠在一起,无法通过setTouchPrority()来 ...

- 编写postgresql函数执行循环copy命令导入大数据

CREATE OR REPLACE FUNCTION copyData() RETURNS boolean AS $BODY$ DECLARE i int; begin i :=1; FOR i IN ...